-

摘要: 针对黑猩猩优化算法(Chimp optimization algorithm, ChOA)存在收敛速度慢、精度低和易陷入局部最优值问题, 提出一种融合多策略的黄金正弦黑猩猩优化算法(Multi-strategy golden sine chimp optimization algorithm, IChOA). 引入Halton序列初始化种群, 提高初始化种群的多样性, 加快算法收敛, 提高收敛精度; 考虑到收敛因子和权重因子对于平衡算法勘探和开发能力的重要作用, 引入改进的非线性收敛因子和自适应权重因子, 平衡算法的搜索能力; 结合黄金正弦算法相关思想, 更新个体位置, 提高算法对局部极值的处理能力. 通过对23个基准测试函数的寻优对比分析和Wilcoxon秩和统计检验以及部分CEC2014测试函数寻优结果对比可知, 改进的算法具有更好的鲁棒性; 最后, 通过2个实际工程优化问题的实验对比分析, 进一步验证了IChOA在处理现实优化问题上的优越性.Abstract: Chimp optimization algorithm (ChOA) has the problems of slow convergence speed, low accuracy and easy to fall into local optimal value. A multi-strategy golden sine chimp optimization algorithm (IChOA) was proposed. The Halton sequence is introduced into the algorithm to initialize the population, which improves the diversity of the initialized population, accelerates the convergence of the algorithm, and improves the convergence accuracy. Considering the important role of convergence factor and weight factor on the exploration and exploitation of the balance algorithm, the improved nonlinear convergence factor and adaptive weighting factor are introduced to balance the search ability of the algorithm. The golden sine algorithm is used to update the individual position and improve the ability of the algorithm to deal with the local extreme value. Through comparative analysis of the optimization of 23 benchmark test functions, Wilcoxon rank sum statistical test and optimization results of some CEC2014 test functions, it can be seen that the improved algorithm has better robustness. Finally, through comparative analysis of two practical engineering optimization problems, the superiority of IChOA in dealing with realistic optimization problem is further verified.

-

在过去的20年中, 元启发式算法由于其简单性、灵活性和较高的鲁棒性被广泛关注. 常见的元启发式算法有遗传算法(Genetic algorithm, GA)[1]、粒子群优化(Particle swarm optimization, PSO)算法[2]、灰狼优化(Grey wolf optimization, GWO)算法[3]和蝴蝶优化算法[4]等. 随着技术不断发展和更新, 元启发式算法在复杂优化问题上表现卓越, 如路径规划[5]、电力系统控制[6]等工程设计问题.

2020年, Khishe等[7]提出黑猩猩优化算法(Ch-imp optimization algorithm, ChOA), 该算法是一种基于黑猩猩种群社会行为的启发式智能优化算法, ChOA与其他智能优化算法相比, 具有参数少、易实现、稳定性高等优点. 尽管不同的智能优化算法存在不同的搜索方式, 但其目标大多都是探索种群多样性和搜索能力之间的平衡, 在保证收敛精度和速度的同时, 避免早熟现象的发生[8]. 针对上述思想, 众多学者对其研究的智能优化算法做了改进, 例如王坚浩等[9]提出一种基于混沌搜索策略的鲸鱼优化算法, 采用混沌反向学习策略初始化种群, 保证了初始化种群的质量; 宁杰琼等[10]利用混沌映射初始化蝴蝶个体的位置, 以此增加算法初期种群的多样性; 王秋萍等[11]引入基于余弦规律变化的收敛因子和基于欧氏距离的比例权重因子, 平衡算法的探索和开发能力; Ewees等[12]通过将蝗虫优化算法与对立学习策略相结合, 同时引入深度探索搜索域策略, 从而加快了算法的收敛速度; Dinkar等[13]提出一种基于对立的拉普拉斯蚁狮搜索算法, 采用对立的学习模型确保在搜索空间的同时, 探索原始和相反的候选解, 从而在进化过程中评估更好的候选解; 吕鑫等[14]提出一种混沌麻雀搜索算法, 通过产生混沌序列扰动陷入局部最优的解, 促使其跳出局部最优值; Sayed等[15]提出一种二进制克隆花授粉算法, 通过将克隆选择算法和花授粉算法相结合, 构成二元克隆花授粉算法, 以解决原始花粉克隆算法易陷入局部最优解的问题.

综上所述, 智能优化算法和改进机制层出不穷、各具优势, 适用于解决一些优化问题, 但在另外一些问题的求解上, 会显露出不足. 因此, 为了提高ChOA的寻优性能和适用性, 探索更适合解决实际优化问题的方法, 本文提出一种融合多策略的黄金正弦黑猩猩优化算法(Multi-strategy golden sine chimp optimization algorithm, IChOA). 该算法采用Halton序列初始化种群, 生成更加均匀个体, 保证算法初期的多样性, 提高算法收敛速度和精度; 同时, 引入非线性收敛因子和自适应权重因子, 平衡算法的搜索能力, 加快算法收敛速度; 最后, 根据黄金正弦算法的相关思想更新个体位置, 避免算法过早收敛. 仿真实验采用23个标准测试函数以及部分CEC2014测试函数进行寻优测试, 并采用Wilcoxon秩和检验进行统计分析, 验证了算法的优越性. 通过2个工程设计优化问题的实验对比结果表明, IChOA相较于其他算法, 更具优势.

1. 基本黑猩猩搜索算法

ChOA算法是根据黑猩猩种群的捕猎行为提出的一种群智能优化算法, 一般黑猩猩的狩猎过程分为探索和开发两个阶段. 探索阶段即驱动、阻挡和追逐猎物, 开发阶段即攻击猎物. 黑猩猩捕猎行为的仿生学原理描述如下.

为了用数学模型模拟黑猩猩的行为, 假设第1个攻击者(最佳解决方案)、驱赶者、阻碍者和追赶者能发现潜在猎物的位置, 其他黑猩猩被迫根据最佳黑猩猩的位置更新自己的位置. 黑猩猩驱赶和追逐猎物的数学模型为:

$$ d(t) = |c{X_P}(t) - m{X_C}(t)| $$ (1) $$ {X_C}(t + 1) = {X_P}(t) - a \cdot d $$ (2) 式中, $d(t) $为猎物与黑猩猩间的距离, $t $为当前迭代次数, $a $和$c $为系数向量, $m $是由混沌映射产生的混沌向量, $X_P $为猎物的位置向量, $X_C $为黑猩猩的位置向量. a和c向量表示如下:

$$ a = 2 \cdot f \cdot {r_1} - f $$ (3) $$ c = 2 \cdot {r_2} $$ (4) 式中, $f $为线性衰减因子, 随着迭代次数的增加, $f $值由2.5线性衰减到0, $r_1 $和$r_2 $是取值为[0, 1]的随机数.

参数$a $为 $[-2f,\;2f] $的随机变量, 假设$a $的值为[−1, 1]时, 猎物停止移动, 此时黑猩猩必须攻击猎物结束捕猎. 因此, 采取降低f值的方式迫使黑猩猩结束捕猎, 黑猩猩的下一个位置可以在当前位置与猎物位置之间的任意位置.

黑猩猩攻击猎物数学模型为:

$$ \left\{ \begin{aligned} &{d_A} = |{c_1}{X_A} - {m_1}X| \\ &{d_B} = |{c_2}{X_B} - {m_2}X| \\ &{d_C} = |{c_3}{X_C} - {m_3}X| \\ &{d_D} = |{c_4}{X_D} - {m_4}X| \end{aligned} \right. $$ (5) $$ \left\{ \begin{aligned} &{X_1} = {X_A} - {a_1} \cdot {d_A} \\ &{X_2} = {X_B} - {a_2} \cdot {d_B} \\ &{X_3} = {X_C} - {a_3} \cdot {d_C} \\ &{X_4} = {X_D} - {a_4} \cdot {d_D} \end{aligned} \right. $$ (6) $$ X(t + 1) =\frac {{X_1} + {X_{\text{2}}} + {X_{\text{3}}} + {X_{\text{4}}}} {4} $$ (7) 由式(5) ~ (7)可知, 黑猩猩个体最终的位置是随机分布在一个由攻击者、阻碍者、追逐者和驱赶者黑猩猩位置所确定的圆圈中, 即猎物位置是由4个最好的个体来估计的, 而其他黑猩猩则随机更新它们在附近的位置.

种群在捕猎的最后阶段个体获得食物满足, 随后的社会动机会使黑猩猩释放它们的天性, 此时, 黑猩猩个体试图强行混乱地获得食物. 黑猩猩在最后阶段的混乱行为, 有助于进一步缓解解决高维问题时的局部最优陷阱和收敛速度慢这两个问题.

原始黑猩猩算法使用了6种具有随机行为的确定性混沌过程映射, 为了模拟这种社会行为, 假设有50%的概率在正常的位置更新机制或混沌模型中选择其一更新黑猩猩的位置, 社会性刺激行为数学模型为:

$$ {X_C}(t + 1) = \left\{ {\begin{aligned} &{{X_P}(t) - a \cdot d,}&\;\; {\mu < 0.5} \\ &{Chaotic,}&\;\;{\mu \geq 0.5} \end{aligned}} \right. $$ (8) 式中, $\mu $是取值[0, 1]的随机数, Chaotic是混沌映射, 用来更新解的位置.

2. 改进的黑猩猩搜索算法

在基本ChOA中, 种群初始化处理采用随机分布方式, 这种随机方式导致算法多样性降低, 个体寻优存在一定的盲目性; 其次, 算法用来平衡局部搜索和全局搜索能力的收敛因子f采用线性规律下降因子, 并不符合算法迭代过程中的非线性寻优规律; 最后, 对于加强算法跳出局部极值能力的混沌扰动Chaotic, 其只有50%概率随机触发, 具有很大的不稳定性, 虽然有一定的概率带领个体跳出局部最优值点, 但是并没有考虑寻优过程中个体位置信息的变化.

综上所述, 本文针对上述算法原理上的缺陷, 引入相应策略进行改善, 具体策略如下.

2.1 Halton序列初始化种群

原始黑猩猩优化算法采用rand函数随机初始化种群, 所得到的种群随机性高, 但是不一定均匀地分布在整个解空间, 导致种群搜索速度慢, 算法多样性不足. 针对上述问题, 本文引入Halton序列产生伪随机数来初始化种群, 伪随机数的遍历性使个体更加均匀地分布在整个解空间[16], 提高初始化时算法的多样性, 个体能快速发现优质解的位置, 从而加快算法收敛, 提高算法收敛精度.

对于二维Halton序列, 其实现过程为: 选取两个质数作为基础量, 通过对两个基础量不断切分, 从而组合成一系列均匀分布且不重复的点, 其切分过程数学模型为:

$$ n = \sum\limits_{i = 0}^m {{b_i} \cdot {p^i}} = {b_m} \cdot {p^m} + \cdot \cdot \cdot + {b_{\text{1}}} \cdot {p^{\text{1}}} + {b_0} $$ (9) $$ \theta (n) = {b_0}{p^{ - 1}} + {b_1}{p^{ - 2}} + \cdot \cdot \cdot + {b_m}{p^{ - m - 1}} $$ (10) $$ H(n) = [{\theta _1}(n),{\theta _2}(n)] $$ (11) 式中, $n \in [1, \;N]$为任意整数, $p $是大于等于2的质数, $b_i \in \{0,1, \cdots, p-1\}$为常数, $p $表示Halton序列基础量, $\theta(n) $是定义的序列函数, $H(n) $为最后得到的二维均匀Halton序列.

图1为基本黑猩猩算法产生的种群随机初始化个体分布图. 图2为使用Halton序列产生的初始种群分布图, 其中Halton序列基础量为$base1= 2 $, $base2= 3$.

由图1和图2的对比分析可知, Halton序列产生的种群分布虽然随机性并不高, 但是分布更为均匀, 并没有出现个体重叠现象. 由此可知, Halton序列产生的种群质量更高, 算法多样性更好.

2.2 非线性收敛因子和自适应权重因子

2.2.1 非线性收敛因子

评价启发式算法性能好坏的重要环节之一是能否平衡算法的全局搜索能力和局部开发能力. 由前面的分析可知, 随机变量$a=[-2f,\;2f] $, 当$|a| \leq 1$时, 个体攻击猎物收敛; 当$|a| \gt 1 $时, 个体分散搜寻猎物, 因此收敛因子$f $的变化决定了算法局部和全局搜索能力的平衡. 基本ChOA算法的收敛因子$f $由2.5线性下降到0, 这种线性变化并不能适应算法对于复杂多峰函数的寻优, 导致算法寻优速度缓慢, 甚至陷入局部最优值. 因此, 本文引入一种非线性变化的收敛因子, 在算法迭代前期种群大范围搜索时, 缓慢衰减的收敛因子能让种群更好地搜索全局最优解; 在算法迭代后期种群收敛, 此时快速衰减的收敛因子有利于算法局部寻找最优解. 同时, 加入控制因子$k $, 能控制衰减的幅度, 非线性收敛因子的数学模型描述如下:

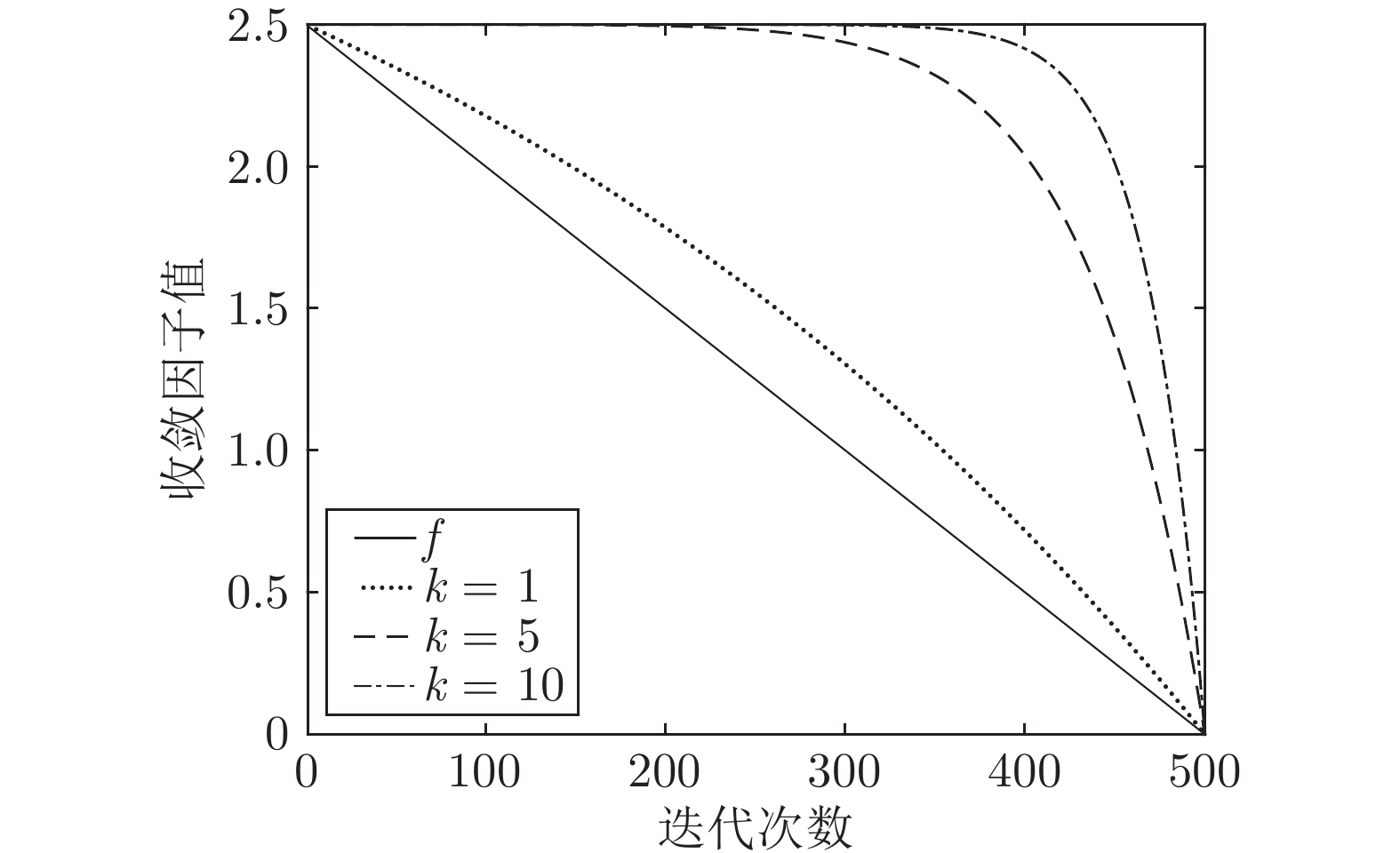

$$ f = {f_m} \cdot \left[ {1 - {{\left( {\frac{{{{\rm{e}}^{\frac {t} {Max_{iter}}}} - 1}}{{{\rm{e}} - 1}}} \right)}^k}} \right] $$ (12) 式中, $t $为当前迭代次数, $Max_{iter}$为最大迭代次数, $f_m $为收敛因子的初始值. $k \in [1, \;10] $为控制因子, $k $能控制$f $衰减幅度, $k $越大时, 收敛因子衰减越慢; 反之, 收敛因子衰减越快. 线性收敛因子$f $和控制因子$k $, 取$k=1 ,5,10$ 的非线性收敛因子, 对比如图3所示.

2.2.2 自适应权重因子

权重因子在目标函数优化中起着重要的作用, 合适的权重能够加快算法收敛, 提高算法收敛精度. 针对ChOA算法寻优过程中收敛速度慢、精度不高问题, 引入一种自适应调整的权重因子$\omega $: 在算法迭代初期, 给予一个较大的权重使种群以大步长遍历整个搜索空间, 有利于算法快速搜寻全局最优位置, 加快算法收敛; 在算法迭代中/后期, 算法逐渐收敛, 个体局部搜寻最优解, 此时给予一个较小的权重, 有利于算法以小步长精细探索最优位置, 提高算法收敛精度; 最后, 在算法迭代末期, 针对ChOA算法易陷入局部最优问题, 给予个体位置一个相对较大的扰动, 有利于算法跳出局部最优解. 自适应权重因子$\omega $数学模型如下:

$$ \omega = \left\{ {\begin{aligned} & {\delta _1} \cdot \left(\cos \left(t \cdot \frac{\pi}{{\delta _2}}\right) + {\delta _3}\right),&t \leq \varepsilon \\ & {\rho _1} \cdot \sin ({\rho _2} \cdot t \cdot \pi ) + {\rho _3},&t > \varepsilon \end{aligned}} \right. $$ (13) 式中, ${\delta _1} $、${\delta _2} $、${\delta _3} $、$\rho _1 $、$\rho _2 $、$\rho _3 $为常数系数, $t $为当前迭代次数, $t=(1,2, \cdots, Max_{iter}) $, $\varepsilon$为指定迭代次数. 自适应权重因子$\omega$曲线见图4.

2.3 黄金正弦策略更新位置

2017年, Tanyildizi等[17]根据正弦函数相关思想, 提出黄金正弦算法, 该新型智能算法具有寻优速度快, 调参简单、鲁棒性好等优点. 黄金正弦算法使用正弦函数与单位圆的特殊关系结合黄金分割系数进行迭代搜索, 通过正弦函数扫描单位圆模拟算法探索搜索空间的过程.

公元前4世纪, 古希腊数学家Eudoxus首次提出黄金分割系数概念, 黄金分割系数不需要梯度信息, 每个步骤仅需要迭代一次, 同时, 黄金分割系数的收缩步骤是固定的. 因此, 将正弦函数与黄金分割率组合, 可以更快地找到函数的最大值或最小值. 同时, 黄金正弦搜索策略的遍历性能有效防止算法陷入局部最优值. 黄金正弦算法数学模型如下:

$$ \begin{split} X_i^{t + 1} =\;& X_i^t \cdot |\sin ({R_1})|\; + \\ &{R_2} \cdot \sin ({R_1}) \cdot|{x_1} \cdot P_i^t - {x_2} \cdot x_i^t| \end{split} $$ (14) 式中, $t $为当前迭代次数; $R_1 $和$R_2 $分别为取值 $[0, 2 \pi] $和$[0, \pi] $的随机数, 表示下一代个体移动的距离和方向; $x_1 $和$x_2 $为黄金分割系数, 用来缩小搜索空间, 引导个体向最优值收敛; $P_i^t $是当前最优个体的位置. 黄金分割系数$x_1 $和$x_2 $数学模型如下:

$$ {x_1} = \alpha \cdot (1 - \tau ) + \beta \cdot \tau $$ (15) $$ {x_2} = \alpha \cdot \tau + \beta \cdot (1 - \tau ) $$ (16) $$ \tau = \frac {\sqrt {\text{5}} -1}{2} $$ (17) 式中, $\alpha$和$\beta$是搜索间隔; $ \tau $是黄金分割比, 取值约为0.618033.

2.4 IChOA实现流程和伪代码

IChOA算法的具体实现步骤如下:

步骤1. 利用Halton序列初始化种群, 包括种群个体数$N $, 最大迭代次数$Max_{iter}$, 维度$d $, 种群搜索边界$ lb$、$ub $等, 并设置相关参数.

步骤2. 计算当前种群的搜索空间, 返回超出搜索空间的个体.

步骤3. 计算种群中每个个体的适应度fit并排序, 记录当前最好个体$P_{best} $和最差个体$P_{worst} $.

步骤4. 更新攻击者、追赶者、追逐者和阻碍者位置.

步骤5. 更新非线性扰动因子$f $和自适应权重因子$\omega $, 以及参数$A $和$C $.

步骤6. 随机选取部分个体根据式(12)更新位置, 其他个体按照式(5) ~ (7)更新位置.

步骤7. 根据式(8)引入混沌算子.

步骤8. 重复步骤3 ~ 7, 直到达到最大迭代次数或者算法收敛.

算法1. IChOA算法伪代码

初始化. Halton序列种群并设置相关参数.

1)计算当前种群的搜索空间, 返回超出搜索空间的个体;

2) While $l \; \lt \; Max_{iter}$;

3)计算个体适应度并排序;

4)记录最优和最差个体位置及适应度;

5)更新4个领导者位置;

6) for $i=1 $: $N $;

7) if $i \;\lt \;10$;

8)按照式(12)更新个体位置;

9) else;

10)按照式(5) ~ (7)更新个体位置;

11) $m = chaos (3, 1, 1) $;

12) end;

13) end;

14) end;

15)算法结束, 返回最优位置及适应度.

2.5 IChOA算法时间复杂度分析

基本ChOA算法的时间复杂度为${\rm{O}}(N \times d\; \times Max_{iter})$, 其中N为种群规模, d为维度, $Max_{iter} $为最大迭代次数. IChOA算法时间复杂度分析如下:

1)引入Halton序列初始化种群的时间复杂度为${\rm{O}}(N \times d )$, 则引入Halton序列初始化种群的ChOA (HChOA)的时间复杂度为${\rm{O}}(N \times d \;\times Max_{iter} + N \;\times d)={\rm{O}}(N \times d \times Max_{iter})$;

2)假设引入自适应权重和非线性收敛因子所需的时间分别为$t_1 $和$t_2 $, 因此引入自适应权重和非线性收敛因子的ChOA算法(WChOA)的时间复杂度为${\rm{O}}(N \times d \times Max_{iter}+t_1+ t_2)= {\rm{O}}(N \times d \;\times Max_{iter})$;

3)引入黄金正弦算法的时间复杂度为${\rm{O}}(N \times d )$, 因此引入黄金正弦算法更新位置的ChOA算法(GChOA)的时间复杂度为${\rm{O}}(N \times d \times Max_{iter}+ N\;\times d)= {\rm{O}}(N \times d \times Max_{iter})$.

综上所述, IChOA算法的时间复杂度为${\rm{O}}(N\; \times d \times Max_{iter})$. 由此可知, 本文提出的IChOA算法时间复杂度与ChOA算法时间复杂度一致.

3. 实验仿真与结果分析

3.1 参数设置

仿真实验使用的计算机配置为Intel Core i5-7500U, 主频为3.40 GHz, 内存32 GB, 操作系统64 bit, 计算环境为Matlab2016(a). 本文选取基本黑猩猩算法(ChOA)、粒子群优化算法(PSO)[18]、灰狼优化算法(GWO)[19]和鲸鱼优化算法(Whale optimization algorithm, WOA)与IChOA算法进行对比, 基本参数统一设置为: 种群规模$N=30 $, 最大迭代次数$Max_{iter}=500 $, 维度分为低维$d=30 $、高维$d=500 $. 各算法参数设置见表1.

表 1 算法参数设置Table 1 Parameter setting of algorithm算法 参数 ChOA $m = {{chaos} } (3, 1, 1)$ PSO c1 = 1.5, c2 = 2.0, $\omega$ = 1, wdamp = 0.99 GWO — WOA $b=1 $ IChOA $m = {chaos} (3, 1, 1)$, $\delta _1=0.3,$$\delta _2=300.0, \delta _3=1.8,$

$\rho _1=0.10,\;\rho _2=0.05, \;\rho _3=0.30, \; \varepsilon=300$3.2 测试函数介绍

为了测试IChOA算法的寻优性能, 采用文献[20]使用的23个基准测试函数进行函数寻优测试, 其中, $f_1 \sim f_{7}$为单峰函数, $f_8\sim f_{13}$为复杂多峰函数, $f_{14} \sim f_{23}$为固定维度多峰函数, 基准测试函数相关信息如表2所示.

表 2 基准测试函数介绍Table 2 Introduction to benchmark functions编号 函数名 定义域 维度 最优值 绝对精度误差$\varepsilon $ $f_1 $ Sphere [−100, 100] 30 0 1.00 × 10−3 $f_2 $ Schwefel'problem 2.22 [−10, 10] 30 0 1.00 × 10−3 $f_3 $ Schwefel'problem 1.2 [−100, 100] 30 0 1.00 × 10−3 $f_4 $ Schwefel'problem 2.21 [−100, 100] 30 0 1.00 × 10−3 $f_5 $ Generalized Rosenbrock's function [−30, 30] 30 0 1.00 × 10−2 $f_6 $ Step function [−100, 100] 30 0 1.00 × 10−2 $f_7 $ Quartic function [−1.28, 1.28] 30 0 1.00 × 10−2 $f_8 $ Generalized Schwefel's problem 2.26 [−500, 500] 30 −12569.5000 1.00 × 102 $f_9 $ Generalized Rastrigin's Function [−5.12, 5.12] 30 0 1.00 × 10−2 $f_{10} $ Ackley's function [−32, 32] 30 0 1.00 × 10−2 $f_{11} $ Generalized Criewank function [−600, 600] 30 0 1.00 × 10−2 $f_{12} $ Generalized penalized function 1 [−50, 50] 30 0 1.00 × 10−2 $f_{13} $ Generalized penalized function 2 [−50, 50] 30 0 1.00 × 10−2 $f_{14} $ Shekell's foxholes function [−65, 65] 2 1.0000 1.00 × 10−2 $f_{15} $ Kowalik's function [−5, 5] 4 0.0003 1.00 × 10−2 $f_{16} $ Six-hump camel-back function [−5, 5] 2 −1.0300 1.00 × 10−2 $f_{17} $ Branin function [−5, 5] 2 0.3980 1.00 × 10−2 $f_{18} $ Gold stein-price function [−2, 2] 2 3.0000 1.00 × 10−2 $f_{19} $ Hatman's function1 [0, 1] 3 −3.8600 1.00 × 10−2 $f_{20} $ Hatman's function 2 [0, 1] 6 −3.3200 1.00 × 10−2 $f_{21} $ Shekel's family 1 [0, 10] 4 −10.0000 1.00 × 10−2 $f_{22}$ Shekel's family 2 [0, 10] 4 −10.0000 1.00 × 10−2 $f_{23} $ Shekel's family 3 [0, 10] 4 −10.0000 1.00 × 10−2 3.3 各改进策略寻优性能对比

3.3.1 Halton序列初始化种群性能分析

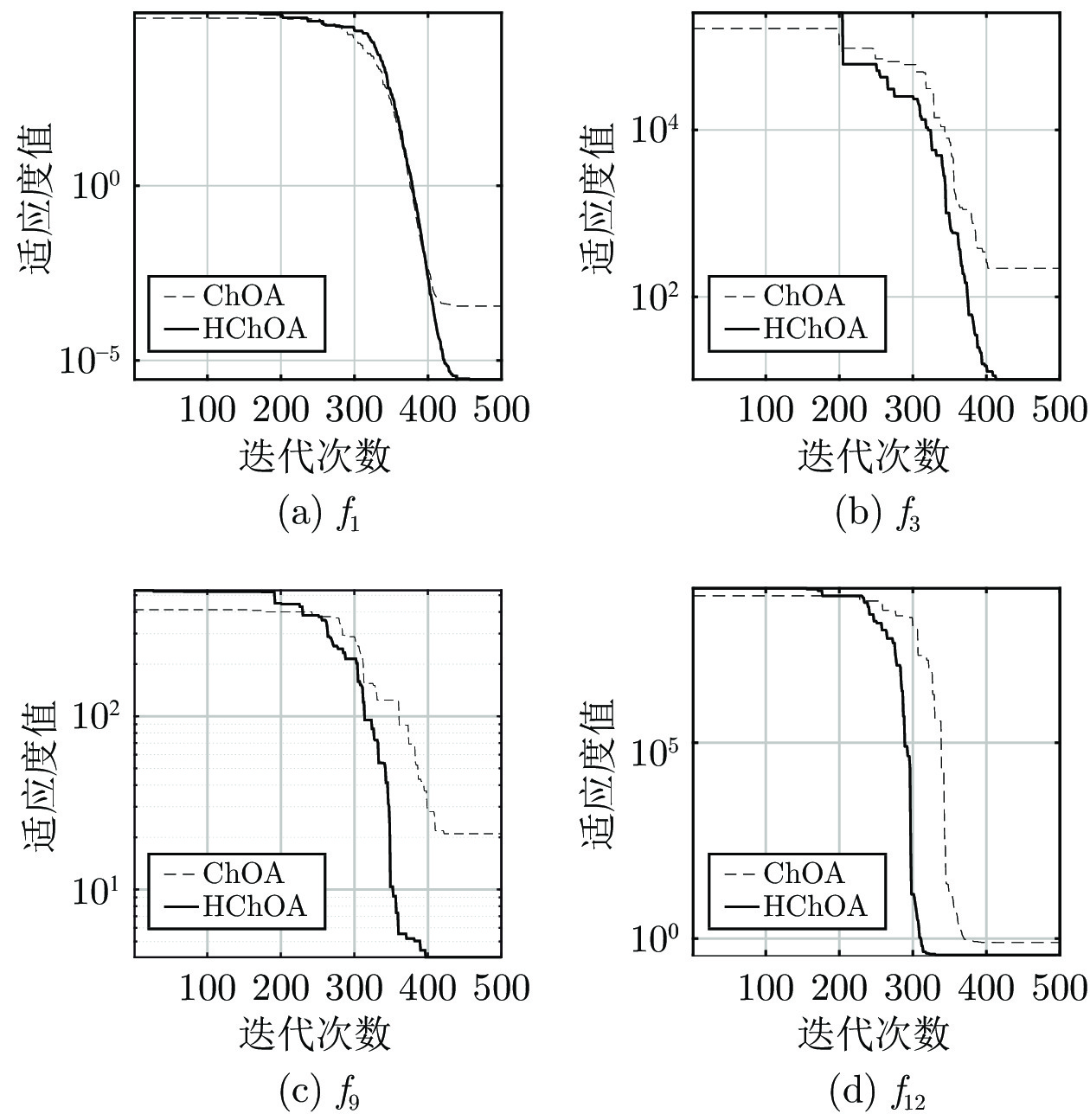

为了提高种群初始化的均匀性, 提高种群多样性, 本文引入Halton序列相关思想初始化种群. 取Halton序列基础量为$base1= 2 $、$base2= 3 $, 种群规模$N=30 $, 最大迭代次数$Max_{iter}=500$, 基本ChOA与加入Halton序列的ChOA (HChOA)在单峰测试函数$f_1 $、$f_3 $和多峰测试函数$f_9 $、$f_{12} $上的寻优对比如图5所示.

由图5可知, 对于单峰测试函数$f_1 $和多峰测试函数$f_9 $, HChOA能收敛到更接近于理论最优值, 说明引入Halton序列的ChOA算法在基本函数寻优精度上有一定的优势; 对于单峰测试函数$f_3 $和多峰测试函数$f_{12} $, HChOA收敛速度比ChOA更快, 说明Halton序列初始化种群提高了种群初期多样性, 对于提高算法收敛速度和精度都有一定帮助, 虽然这种优势并不明显, 但是对于后期引入其他策略寻优有较大帮助.

3.3.2 引入自适应权重因子和非线性收敛因子性能分析

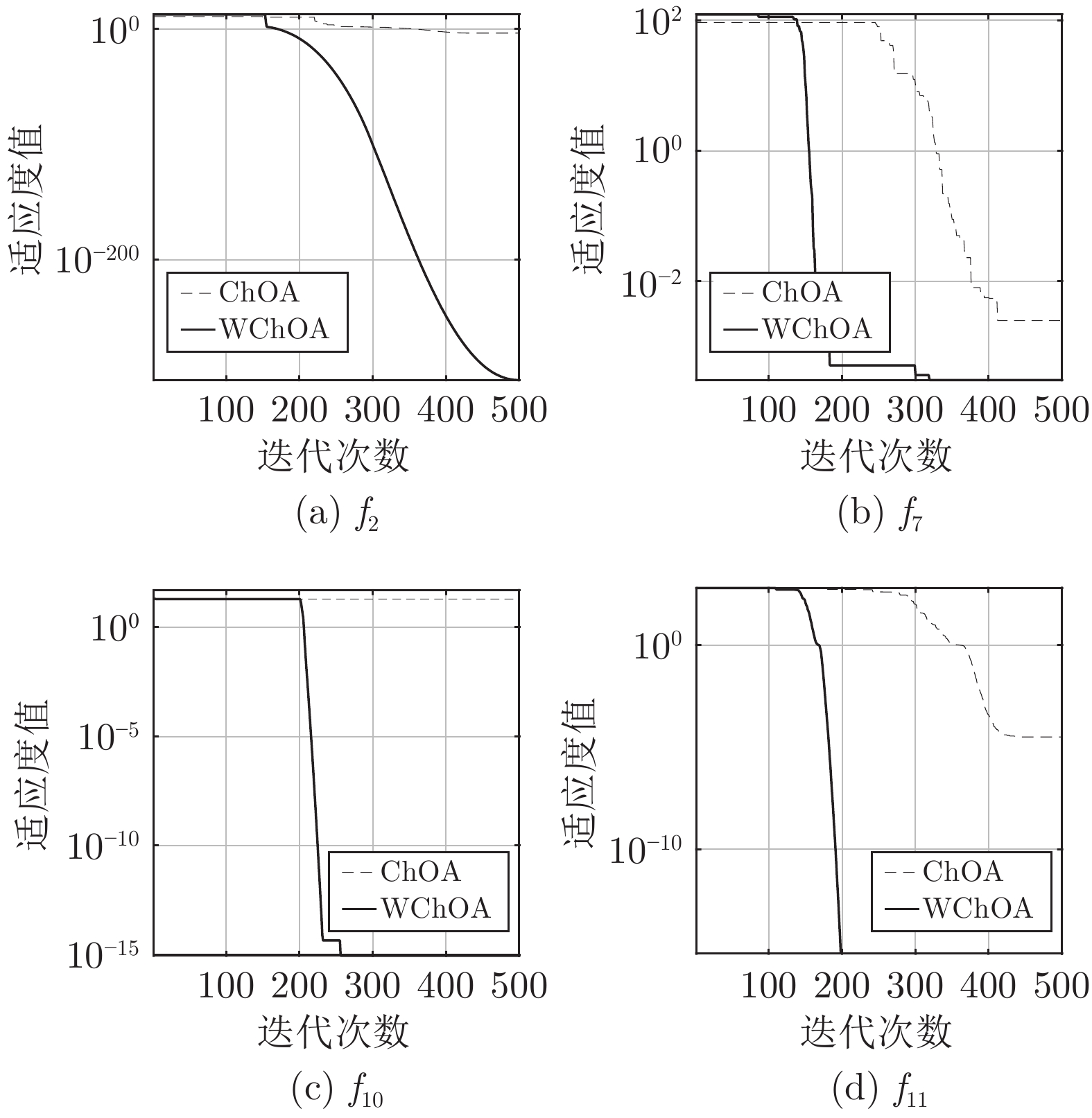

由第2.2节的分析可知, 自适应权重因子和非线性收敛因子对于算法全局搜索和局部开发能力的平衡起着至关重要的作用. 为了平衡算法的勘探和开发能力, 本文引入自适应权重因子$\omega$和改进的非线性收敛因子$f$. 取维度$d=30 $, 最大迭代次数$Max_{iter}= 500$, 种群规模$N=30 $, 其中权重因子$\omega $公式中的相关参数已在第3.1节给出, 基本ChOA与引入自适应权重因子和非线性收敛因子的ChOA (WChOA)对于单峰测试函数$f_2 $、$f_7 $和多峰测试函数$f_{10} $、$f_{11} $寻优结果对比如图6所示.

由图6可以看出, 对于单峰函数$f_2 $和多峰函数$f_{11} $, WChOA能够直接收敛到理论最优值0; 对于单峰函数$f_7 $, WChOA不管是在收敛速度还是在收敛精度上都优于ChOA; 对于多峰函数$f_{10} $, WChOA能收敛到更接近于全局最优解. 综上所述, 引入自适应权重因子和非线性收敛因子对算法寻优速度和精度有一定帮助.

3.3.3 引入黄金正弦策略性能分析

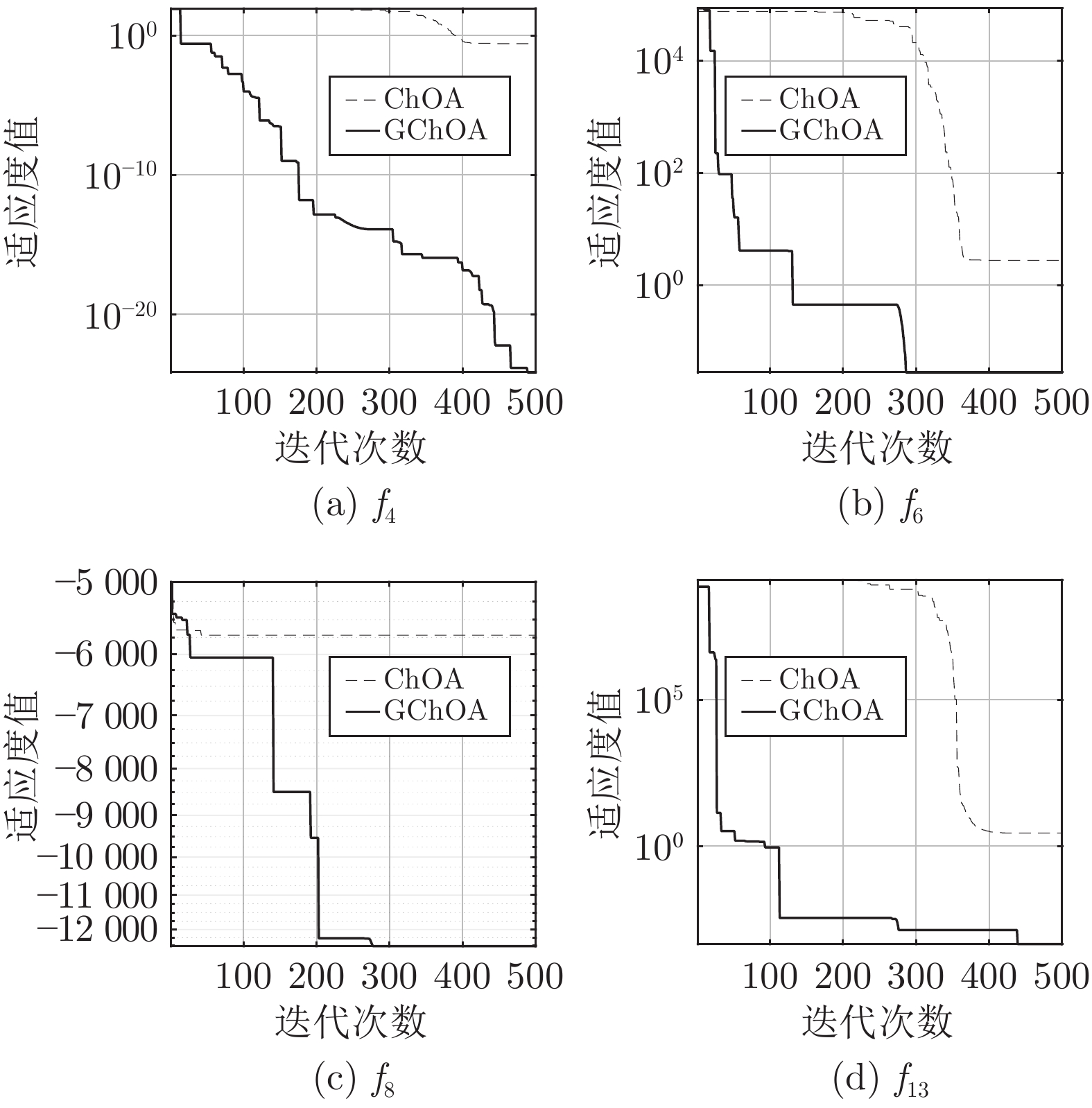

黄金正弦算法以正弦函数为基础, 结合了黄金分割算子进行迭代寻优. 为了加快ChOA收敛, 提高算法跳出局部最优值的能力, 本文引入黄金正弦策略更新种群位置. 取维度$d=30 $, 最大迭代次数$Max_{iter}=500$, 种群规模$N=30 $, 搜索间隔$\alpha=\pi ,$$\beta= - \pi$, 基本ChOA与引入黄金正弦策略算法更新位置的ChOA (GChOA)对单峰测试函数$f_4 $、$f_6 $和多峰测试函数$f_8 $、$f_{13} $寻优结果对比如图7所示.

由图7可知, 对单峰函数$f_4 $、$f_6 $和多峰函数$f_{13} $, GChOA的收敛速度明显快于ChOA, 并且在收敛精度上也有很大提升; 对复杂多峰函数$f_8 $, GChOA能够跳出局部最优值, 收敛到理论最优值 −12569.48附近, 说明引入黄金正弦算法相关思想更新种群位置, 对于算法跳出局部最优解有一定帮助, 同时能加快算法收敛, 提高收敛精度.

3.4 IChOA算法与其他算法性能对比

为了验证IChOA对于基本测试函数的寻优性能, 选取基本黑猩猩算法(ChOA)、粒子群优化算法(PSO)[18]、灰狼优化算法(GWO)[19]和正弦余弦黑猩猩优化算法(Sine cosine ChOA, SChOA)[21]进行寻优对比, 各算法统一取维度$d=30$, 最大迭代次数$Max_{iter}=500 $, 种群规模$N=30 $, 各算法其他相关参数由表1给出, 利用表2给出的23个基本测试函数进行算法寻优对比测试, 各算法分别运行50次, 取平均值, 对比结果如表3所示.

表 3 各算法寻优结果对比(30维)Table 3 Comparison of optimization results of each algorithm (30 dim)函数 ChOA PSO GWO SChOA IChOA 平均值 标准差 平均值 标准差 平均值 标准差 平均值 标准差 平均值 标准差 $f_{1} $ 1.34 × 10−5 1.19 × 10−20 1.40 × 10−4 2.11 × 10−4 5.95 × 10−28 6.85 × 10−28 5.66 × 10−33 5.68 × 103 0 0 $f_{2} $ 1.42 × 10−5 8.55 × 10−21 4.21 × 10−2 4.54 × 10−2 7.95 × 10−17 4.97 × 10−17 1.72 × 10−20 1.91 × 1010 0 0 $f_{3} $ 6.31 × 100 1.40 × 10−17 7.01 × 101 2.21 × 101 2.83 × 10−5 1.12 × 10−4 6.19 × 10−8 2.25 × 104 0 0 $f_{4} $ 2.75 × 10−2 5.95 × 10−28 1.08 × 100 3.17 × 10−1 5.69 × 10−7 5.55 × 10−7 2.75 × 10−10 1.26 × 100 0 0 $f_{5} $ 2.87 × 101 2.51 × 10−14 9.67 × 101 6.01 × 101 2.70 × 101 8.26 × 10−1 2.85 × 102 1.00 × 107 3.13 × 10−4 5.26 × 10−17 $f_{6} $ 3.72 × 100 4.48 × 10−15 1.10 × 10−4 8.28 × 10−5 7.64 × 10−1 3.58 × 10−1 3.01 × 100 5.62 × 103 6.51 × 10−3 3.25 × 10−4 $f_{7} $ 1.72 × 10−3 1.09 × 10−18 1.22 × 10−1 4.49 × 10−2 1.72 × 10−3 7.51 × 10−4 1.00 × 10−3 5.77 × 101 7.81 × 10−7 1.02 × 10−12 $f_{8} $ −5.65 × 103 2.75 × 10−12 −4.84 × 103 1.15 × 103 −6.08 × 103 1.02 × 103 −9.87 × 103 1.80 × 102 −1.26 × 104 1.83 × 10−11 $f_{9} $ 1.41 × 101 0 4.67 × 101 1.16 × 101 3.22 × 100 4.16 × 100 0 7.77 × 101 0 0 $f_{10} $ 1.96 × 101 1.79 × 10−14 2.76 × 10−1 5.09 × 10−1 1.05 × 10−13 2.39 × 10−14 1.50 × 10−14 1.76 × 101 8.88 × 10−16 0 $f_{11} $ 4.79 × 10−2 7.00 × 10−17 9.21 × 10−3 7.74 × 10−3 5.14 × 10−3 9.98 × 10−3 0 8.30 × 101 0 0 $f_{12} $ 3.98 × 10−1 5.60 × 10−17 6.92 × 10−3 1.19 × 10−2 5.99 × 10−2 9.78 × 10−2 1.62 × 10−1 3.31 × 107 6.46 × 10−4 4.39 × 10−18 $f_{13} $ 2.82 × 100 1.76 × 10−15 6.68 × 10−3 8.91 × 10−3 6.27 × 10−1 3.06 × 10−1 6.76 × 10−1 5.16 × 107 2.97 × 10−5 4.56 × 10−16 $f_{14} $ 1.00 × 100 1.12 × 10−15 3.63 × 100 2.50 × 100 5.09 × 100 4.34 × 100 1.00 × 100 1.04 × 101 0.99 × 100 4.48 × 10−16 $f_{15} $ 1.36 × 10−3 4.39 × 10−19 5.80 × 10−4 2.21 × 10−4 5.73 × 10−3 8.98 × 10−3 6.80 × 10−4 1.70 × 10−3 2.30 × 10−4 5.46 × 10−19 $f_{16} $ −1.03 × 100 6.72 × 10−15 −1.03 × 100 6.25 × 10−16 −1.03 × 100 2.42 × 10−8 −1.03 × 100 2.21 × 10−1 −1.03 × 100 5.60 × 10−16 $f_{17} $ 3.98 × 10−1 3.36 × 10−16 3.98 × 10−1 0 3.98 × 10−1 0 3.99 × 10−1 4.90 × 10−3 3.99 × 10−1 8.98 × 10−16 $f_{18} $ 3.00 × 100 0 3.18 × 100 1.33 × 10−15 5.70 × 100 1.47 × 101 3.00 × 100 1.92 × 10−1 3.00 × 100 0 $f_{19} $ −3.85 × 100 2.69 × 10−15 −3.86 × 100 2.58 × 10−15 −3.86 × 100 2.17 × 10−3 −3.86 × 100 9.16 × 10−2 −3.72 × 100 1.34 × 10−18 $f_{20} $ −1.92 × 100 1.12 × 10−15 −3.26 × 100 6.05 × 10−2 −3.23 × 100 8.43 × 10−2 −3.32 × 100 1.24 × 10−1 −2.90 × 100 5.23 × 10−15 $f_{21} $ −4.92 × 100 2.69 × 10−15 −6.87 × 100 3.01 × 100 −8.80 × 100 2.20 × 100 −1.01 × 101 3.34 × 10−1 −1.01 × 101 2.38 × 10−15 $f_{22} $ −4.99 × 100 2.69 × 10−15 −8.46 × 100 3.08 × 100 −10.22 × 100 9.70 × 10−1 −5.18 × 100 5.74 × 10−2 −9.78 × 100 8.79 × 10−15 $f_{23} $ −5.02 × 100 4.48 × 10−16 −8.95 × 100 1.78 × 100 −9.90 × 100 1.96 × 100 −1.05 × 101 4.95 × 10−2 −9.93 × 100 8.97 × 10−16 由表3对比结果可知, 对于单峰函数, 除了$f_6 $函数效果比PSO算法差外, IChOA在其他函数上的寻优结果都优于其他智能算法, 其中$f_1$~$f_6 $能找到理论最优值. 对于复杂多峰函数, IChOA表现同样出色, 其中$f_9 $和$f_{11}$能找到最优值. 对于$f_8 $函数, IChOA能跳出局部最优解, 更接近于理论最优值−12369.49. 对于固定维度测试函数, IChOA基本上都能收敛到最优值附近, 其中$f_{14} $、$f_{16} $、$f_{18} $和$f_{21} $函数能直接收敛到理论最优值, 说明IChOA相比于其他算法, 在基础函数寻优上, 有明显优势.

3.5 IChOA算法与其他算法高维性能对比

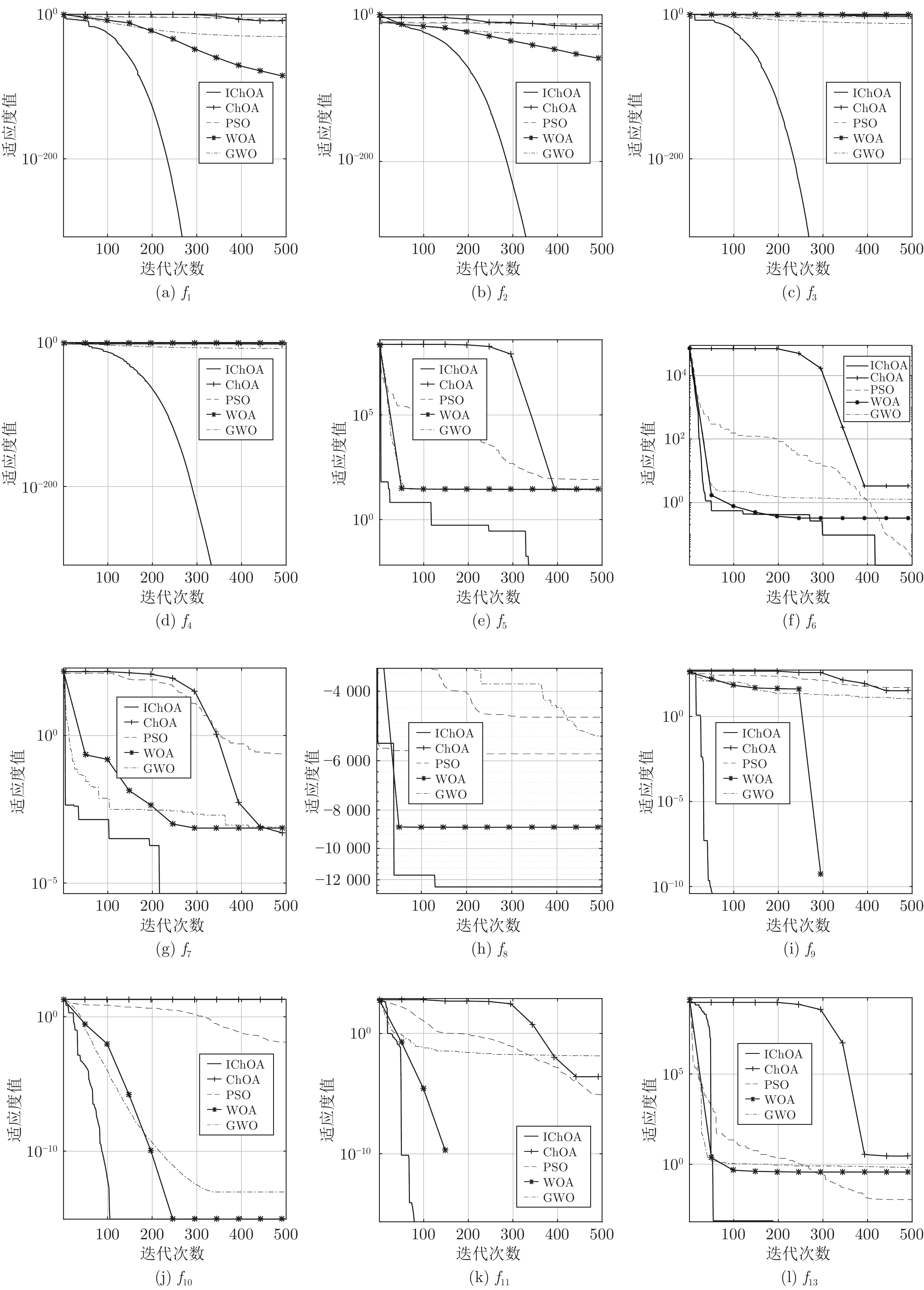

为了测试IChOA对于高维函数的寻优能力, 选取基本黑猩猩算法(ChOA)、粒子群优化算法(PSO)、灰狼优化算法(GWO)和鲸鱼优化算法(WOA)与IChOA进行高维函数寻优对比, 取维度$d=500 $, 最大迭代次数$Max_{iter}=500 $, 各算法其他相关参数由表1给出, 寻优对比结果如图8所示.

由图8可知, 对于单峰函数$f_1 $、$f_2 $、$f_3 $、$f_4 $和多峰函数$f_9 $、$f_{11}$, IChOA在500维时, 仍然能找到最优值0; 对于单峰函数$f_6 $, 虽然IChOA寻优效果并不是最好的, 但是其收敛速度是最快的; 对于500维复杂多峰函数$f_8 $, IChOA仍然能跳出局部最优值, 收敛到最优值 −12569.49. 由图8可以看出, 对于高维测试函数, IChOA同样具有很大的优势.

3.6 Wilcoxon秩和检测

Wilcoxon秩和检验是一种非参数统计检验方法, 能够检测更为复杂的数据分布, 一般的数据分析只是针对当前数据的平均值和标准差, 并没有与算法多次运行的数据进行对比, 因此这种数据对比分析是不科学的. 为了全面体现IChOA的优越性, 采用统计分析方法对每一次仿真结果进行分析, 从统计学角度分析IChOA与其他算法的性能差异. 选取IChOA在12个测试函数的运行结果与PSO、GWO、WOA、ChOA和GChOA运行结果进行Wilcoxon秩和检验并计算$p $值, 当$p$小于5%时, 可以被认为是拒绝零假设的有力验证[22]. NaN表示没有数据与算法对比, “+”、“=” 和 “−”分别表示IChOA寻优性能好于、等于和差于其他算法, Wilcoxon秩和检验结果如表4所示.

表 4 Wilcoxon秩和检验结果Table 4 Wilcoxon rank sum test results编号 PSO ($p_{1} $) GWO ($p_{2} $) WOA ($p_{3} $) ChOA ($p_{4} $) GChOA ($p_{5} $) $f_{1} $ 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 $f_{2} $ 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 3.25 × 10−20 $f_{3} $ 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 $f_{4} $ 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 $f_{5} $ 1.01 × 10−17 2.47 × 10−17 1.04 × 10−15 2.29 × 10−15 7.96 × 10−18 $f_{6} $ 7.06 × 10−18 1.28 × 10−17 1.38 × 10−15 2.13 × 10−16 7.06 × 10−18 $f_{7} $ 4.20 × 10−17 7.06 × 10−18 6.88 × 10−14 1.36 × 10−17 1.27 × 10−16 $f_{8} $ 7.06 × 10−18 7.06 × 10−18 2.21 × 10−10 7.06 × 10−18 7.06 × 10−18 $f_{9} $ 3.31 × 10−20 3.31 × 10−20 NaN 1.17 × 10−19 3.31 × 10−20 $f_{10} $ 3.31 × 10−20 3.31 × 10−20 2.39 × 10−16 2.91 × 10−20 2.62 × 10−23 $f_{11} $ 3.31 × 10−20 3.31 × 10−20 3.27 × 10−1 2.50 × 10−4 3.31 × 10−20 $f_{12} $ 7.06 × 10−18 9.37 × 10−11 1.83 × 10−17 7.96 × 10−18 7.06 × 10−18 +/=/− 12/0/0 12/0/0 10/1/1 12/0/0 12/0/0 由表4可知, IChOA的Wilcoxon秩和检验结果p值基本上都小于5%, 从统计学上说明, IChOA对于基本函数的寻优性能优势明显, 从而进一步体现了IChOA的鲁棒性.

3.7 CEC2014测试函数实验分析

CEC2014测试函数[23]是由多个基本优化测试函数的权值组合而成, 这种基函数的权值组合使测试函数的特征更为复杂, 利用这些特征复杂的测试函数对本文IChOA方法进行测试, 一方面体现IChOA对于复杂函数优化的优越性能; 另一方面, 多测试函数的组合优化可以体现IChOA对于不同复杂优化问题的适用性. 因此, 为了进一步测试IChOA的鲁棒性, 本文选取部分CEC2014单目标优化函数进行求解分析, 其中包括单峰、多峰、混合和复合类型函数, 函数相关信息如表5所示. 本文将IChOA与标准PSO算法[24]、标准正弦余弦算法(Sine cosine algorithm, SCA)[25]、线性自适应差分进化算法 (Linear success-history based adaptive differential evolution, L-SHADE)[26]、引入Halton序列初始化种群的黑猩猩优化算法(HChOA)和引入黄金正弦优化算法更新个体位置的黑猩猩优化算法(GChOA)进行对比. 其中, L-SHADE算法在CEC2014测试函数中表现卓越, 常用来作为对比. 实验参数取种群规模为$N=50 $, 维度$d=30 $, 最大迭代次数$Max_{iter}= $2000, 每个函数独立运行50次, 取平均值和标准差. 优化对比结果见表6.

表 5 部分CEC2014函数介绍Table 5 Introduction of part CEC2014 function函数 维度 特征 定义域 最佳值 CEC03 30 单峰 [−100, 100] 300 CEC05 30 多峰 [−100, 100] 500 CEC06 30 多峰 [−100, 100] 600 CEC16 30 多峰 [−100, 100] 1600 CEC19 30 混合 [−100, 100] 1900 CEC22 30 混合 [−100, 100] 2200 CEC25 30 复合 [−100, 100] 2500 CEC27 30 复合 [−100, 100] 2700 表 6 CEC2014函数优化对比Table 6 CEC2014 function optimization comparison函数 PSO SCA L-SHADE HChOA GChOA IChOA 平均值 标准差 平均值 标准差 平均值 标准差 平均值 标准差 平均值 标准差 平均值 标准差 CEC03 4.87 × 101 6.61 × 101 8.83 × 100 1.36 × 100 0 0 7.78 × 104 7.44 × 103 7.54 × 104 6.58 × 103 7.35 × 104 6.23 × 103 CEC05 2.09 × 101 8.52 × 10−2 2.21 × 100 2.72 × 100 2.01 × 101 1.70 × 10−2 5.22 × 102 6.67 × 10−2 5.26 × 102 4.21 × 10−2 5.20 × 102 1.02 × 10−2 CEC06 1.08 × 101 2.53 × 100 6.63 × 101 3.74 × 101 1.67 × 10−2 9.17 × 10−2 6.33 × 102 2.42 × 100 6.33 × 10−5 2.42 × 100 6.31 × 102 2.39 × 100 CEC16 1.13 × 101 7.05 × 10−1 2.27 × 101 1.66 × 10−1 8.48 × 100 2.97 × 10−1 1.62 × 103 2.81 × 10−1 1.61 × 103 1.88 × 10−1 1.61 × 103 1.24 × 10−1 CEC19 7.76 × 100 1.87 × 100 2.88 × 102 2.99 × 101 3.59 × 100 7.22 × 10−1 2.56 × 103 2.46 × 100 1.76 × 103 2.39 × 100 2.32 × 103 1.96 × 100 CEC22 2.31 × 102 1.04 × 102 2.43 × 101 3.03 × 101 3.69 × 101 3.36 × 101 3.57 × 103 9.65 × 101 4.21 × 103 1.48 × 102 3.56 × 103 7.48 × 101 CEC25 2.09 × 102 1.65 × 100 2.69 × 102 2.71 × 101 2.03 × 102 4.97 × 10−2 2.71 × 103 9.49 × 100 2.71 × 103 3.21 × 100 2.70 × 103 0 CEC27 5.36 × 102 8.15 × 103 2.08 × 102 1.89 × 101 3.00 × 102 1.34 × 10−13 2.93 × 103 5.36 × 100 2.91 × 103 8.12 × 100 2.90 × 103 0 由表6可知, L-SHADE算法在单峰函数上表现良好, 但是对于多峰、混合和复合函数, IChOA具有明显优势, 例如对于多峰测试函数CEC05, IChOA能够收敛到理论值500附近, 而PSO算法等其他算法性能相对表现较差; 对于混合和复合测试函数, IChOA以及其变体优势也比较明显, 在CEC19和CEC22测试函数上, IChOA寻优结果更接近理论最优值, 比PSO算法、L-SHADE算法和SCA算法更具优势. 此外, 除了CEC27函数以外, IChOA稳定性普遍更高, 验证了IChOA的稳定性.

3.8 IChOA平均运行时间和成功率分析

为了验证IChOA处理优化问题的速度和成功率, 选取基本ChOA、HChOA、WChOA和GChOA,与IChOA进行基准测试函数平均寻优时间和寻优成功率对比, 实验数据统一设置为: 维度$d=30 $, 种群规模$N=30 $, 最大迭代次数$Max_{iter}=500 $, 各算法运行30次, 取运行时间平均值和标准差, 定义算法寻优成功率如下[27].

设适应度误差为$F(u) $:

$$ F(u) = f(X(u)) - f(X') $$ (18) 式中, u为算法运行次数, X(u)为算法运行第u次的实际寻优结果, $X' $为理论最优值, 定义变量$\delta (u) $:

$$ \delta (u) = \left\{ {\begin{aligned} & 1,&\;\; {|F(u)| < \varepsilon } \\ &0 ,& \;\;|F(u)| \geq \varepsilon \end{aligned}} \right. $$ (19) 式中, $\varepsilon $为适应度误差精度, 具体取值见表2. 算法寻优成功率$P $为:

$$ P = \frac{1}{{30}}\sum\limits_{u = 1}^{30} {\delta (u)} $$ (20) 各算法对于23个基准测试函数的平均寻优时间以及寻优成功率对比结果见表7.

表 7 基准函数寻优平均时间及成功率对比Table 7 Comparison of average time and success rate for optimization of benchmark function函数 ChOA HChOA WChOA GChOA IChOA 平均值 标准差 成功率

(%)平均值 标准差 成功率

(%)平均值 标准差 成功率

(%)平均值 标准差 成功率

(%)平均值 标准差 成功率

(%)f1 1.9732 0.0136 100 1.9824 0.0088 100 1.9302 0.0155 100 1.4113 0.0181 100 1.3916 0.0101 100 f2 1.9546 0.0101 100 1.9841 0.0181 100 1.7962 0.0063 100 1.4176 0.0101 100 1.4086 0.0081 100 f3 2.2999 0.0083 0 2.2988 0.0077 100 2.0616 0.0906 100 2.1272 0.0128 100 2.1150 0.0275 100 f4 2.0456 0.0107 0 1.9884 0.0309 100 1.9955 0.0676 100 1.4381 0.0330 100 1.4208 0.0446 100 f5 2.0696 0.0663 0 2.0691 0.0649 0 1.9966 0.0326 33.3 1.4670 0.0530 96.6 1.4574 0.0244 100 f6 2.0127 0.0435 0 1.9617 0.0107 36.6 1.9604 0.0138 16.6 1.4122 0.0111 43.3 1.4006 0.0121 90.0 f7 2.0567 0.0089 100 2.0364 0.0190 100 2.0520 0.0147 100 1.5407 0.0070 100 1.5356 0.0098 100 f8 2.0246 0.0127 0 2.0195 0.0310 0 1.9784 0.0294 0 1.4638 0.0086 73.3 1.4625 0.0132 83.3 f9 2.0138 0.0343 0 2.0203 0.0112 96.6 1.9855 0.0096 100 1.4316 0.0184 100 1.4169 0.0141 100 f10 2.0011 0.0113 0 2.0045 0.0143 73.3 1.9999 0.0086 100 1.4521 0.0113 100 1.4395 0.0089 100 f11 2.0293 0.0081 63.3 2.0301 0.0144 100 2.0155 0.0095 100 1.4776 0.0119 100 1.4735 0.0116 100 f12 2.2040 0.0114 0 2.1930 0.0142 33.3 2.1697 0.0169 86.6 1.8354 0.0110 43.3 1.8422 0.0530 100 f13 2.1873 0.0112 0 2.1792 0.0115 36.6 2.1811 0.0184 56.6 1.8180 0.0140 66.6 1.8140 0.0084 100 f14 0.7893 0.0090 100 0.7916 0.0068 100 0.7898 0.0073 100 1.3830 0.0100 100 1.3571 0.0064 100 f15 0.3131 0.0039 0 0.3141 0.0034 50.0 0.3174 0.0024 63.3 0.2792 0.0027 90.0 0.2788 0.0024 96.6 f16 0.1730 0.0038 100 0.1743 0.0034 100 0.1728 0.0037 100 0.1647 0.0037 100 0.1647 0.0013 100 f17 0.1690 0.0012 100 0.1709 0.0043 100 0.1689 0.0013 100 0.1556 0.0061 100 0.1524 0.0022 100 f18 0.1673 0.0025 100 0.1699 0.0035 100 0.1689 0.0021 100 0.1516 0.0012 100 0.1510 0.0020 100 f19 0.2804 0.0045 100 0.2847 0.0031 100 0.2849 0.0019 100 0.3021 0.0064 100 0.2580 0.0017 100 f20 0.4751 0.0042 46.6 0.4737 0.0024 70.0 0.4724 0.0028 63.3 0.4304 0.0053 63.3 0.4278 0.0033 76.6 f21 0.4046 0.0251 16.6 0.4068 0.0035 20.0 0.4012 0.0028 70.0 0.4581 0.0029 76.6 0.4035 0.0055 83.3 f22 0.4447 0.0043 0 0.4458 0.0030 36.6 0.4403 0.0050 53.3 0.5391 0.0048 73.3 0.4349 0.0051 80.0 f23 0.5087 0.0029 0 0.5089 0.0036 43.3 0.5080 0.0021 36.6 0.6610 0.0034 76.6 0.6347 0.0039 86.6 由表7可知, HChOA、WChOA、GChOA和IChOA在优化问题的处理速度上, 相比于ChOA都具有一定优势, 除了$f_9 $和$f_{14} $函数外, IChOA的寻优速度都是最快的, 说明本文提出的改进策略在一定程度上加快了算法收敛速度, 而本文将3个策略融合后得到的IChOA寻优速度最快; 其次, IChOA在16个基准函数上寻优成功率达到100%且在23个函数上的寻优成功率相比其他对比算法都是最高的, 说明IChOA对于优化问题的处理稳定性较高. 综上所述, 本文提出的IChOA在优化问题处理上兼顾速度和稳定性, 具有较高的鲁棒性.

4. IChOA算法工程算例应用分析

近年来, 工程算例应用作为优化问题中的一个热门领域, 受到广泛关注. 为了进一步验证IChOA在处理实际工程应用案例的优越性, 选取文献[21]中的罚函数作为非线性约束条件, 对焊接梁设计问题与拉力/压力弹簧优化设计问题进行优化处理, 并将IChOA优化结果与基本遗传算法(GA)、粒子群优化算法(PSO)、鲸鱼优化算法(WOA)、灰狼优化算法(GWO)、黑猩猩优化算法(ChOA)和文献[21]中其他算法进行对比.

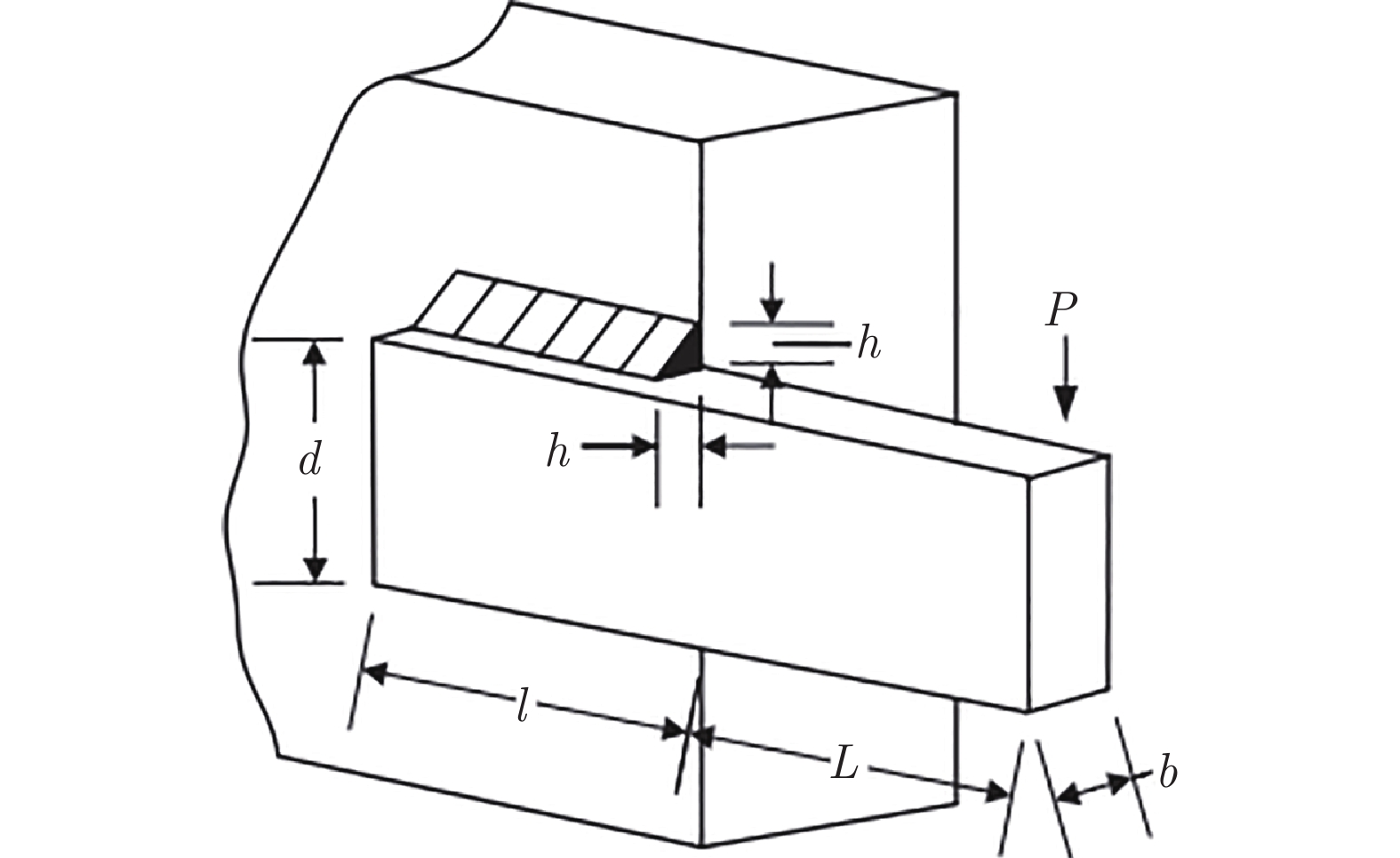

4.1 焊接梁设计问题

焊接梁设计问题目的在于降低焊接梁制造成本, 数学模型如式(21)、式(22)所示:

$$\left\{ \begin{aligned} &\tau ' = \frac{P}{{2{x_1}{x_2}}}\\ &\tau '' = MRJ,M = P\left(L + \frac{{{x_2}}}{2}\right)\\ &J = 2\left\{ {\sqrt 2 {x_1}{x_2}\left[ {\frac{{x_2^2}}{{12}} + {{\left( {\frac{{{x_1} + {x_3}}}{2}} \right)}^2}} \right]} \right\}\\ &R = \sqrt {\frac{{x_2^2}}{4} + {{\left( {\frac{{{x_1} + {x_3}}}{2}} \right)}^2}} \\ &P = 6\,000\;{}\\ &L = 14\;{}\\ &E = 3 \times {10^7}\;{}\\ &G = 1.2 \times {10^7}\;{}\\ &{\tau _{\max }} = 13\,600\; {}\\ &{\sigma _{\max }} = 30\,000 \;{}\\ &{\delta _{\max }} = 0.25 \;{} \end{aligned}\right. $$ (21) $$ \begin{split} &\min f(X) = 1.10471x_1^2{x_2} + 0.04811{x_3}{x_4}(14 + {x_2})\\ &{\rm{s}}.{\rm{t}}. \;\;{{{g}}_1}(X) = \sqrt {{{(\tau ')}^2} + 2\tau '\tau ''\frac{{{x_2}}}{{2R}} + (\tau '')^2} - {\tau _{\max }} \le 0\\ &{g_2}(X) = \frac{{6PL}}{{x_3^2{x_4}}} - {\sigma _{\max }} \le 0\\ &{g_3}(X) = {x_1} - {x_4} \le 0\\ &{g_4}(X) = 0.10471x_1^2 + 0.04811{x_3}{x_4}(14 + {x_2}) - 5 \le 0\\ &{g_5}(X) = 0.125 - {x_1} \le 0\\ &{g_6}(X) = \frac{{4P{L^3}}}{{Ex_3^3{x_4}}} - {\delta _{\max }} \le 0\\ &{g_7}(X) = P - \frac{{4.013E{x_3}x_4^3 }}{{6{L^2}}}\left( {1 - \frac{{{x_3} }}{{2L}}\sqrt {\frac{E}{{4G}}} \le 0} \right)\\ &0.1 \le {x_i} \le 2,i = 1,4\\ &0.1 \le {x_i} \le 10,i = 2,3\\[-10pt] \end{split} $$ (22) 式中, $x_1 $、$x_2 $、$x_3 $和$x_4 $分别表示焊接梁的焊缝宽度$h $、横梁宽度$d $、长度$l $和厚度$b $四个基本属性. 约束条件包括剪切应力$\tau $、横梁弯曲应力$\delta $、屈曲载荷$J$、横梁挠度$\delta $和其他内部参数约束. 图9为焊接梁模型的基本构造.

表8为各算法求解焊接梁设计问题的寻优结果的平均值, 包括射线优化算法(Ray optimization, RO)[21]、多元宇宙算法(Multi-verse optimizer, MVO)[21]、正余弦哈里斯鹰算法(An efficient hybrid sine-cosine Harris hawks optimization, HSSAHHO)[21]和SChOA算法[21]. 各算法独立运行50次, 取平均值.

表 8 焊接梁设计问题结果对比Table 8 Comparative results of welding beam design problems算法 h l t b 平均值 GA 0.2455 6.1986 8.1264 0.2247 2.4412 PSO 0.2027 3.4705 9.0366 0.2057 1.7249 WOA 0.2024 3.4772 9.0435 0.2189 1.7299 GWO 0.2022 3.4893 9.0541 0.2155 1.7265 RO 0.2036 3.5284 9.0042 0.2072 1.7353 MVO 0.2054 3.4731 9.0445 0.2056 1.7246 HSSAHHO 0.2057 3.4705 9.0367 0.2057 1.7248 ChOA 0.2214 3.5358 8.9115 0.2127 1.7737 SChOA 0.2057 3.4705 9.0306 0.2056 1.7229 IChOA 0.2038 3.4713 9.0300 0.2060 1.7228 由表8可以看出, IChOA对于焊接梁设计问题的优化效果明显高于其他算法, 虽然IChOA对于单个焊接梁属性的优化结果不都是最优的, 但其总体造价相比于其他算法优化效果最佳.

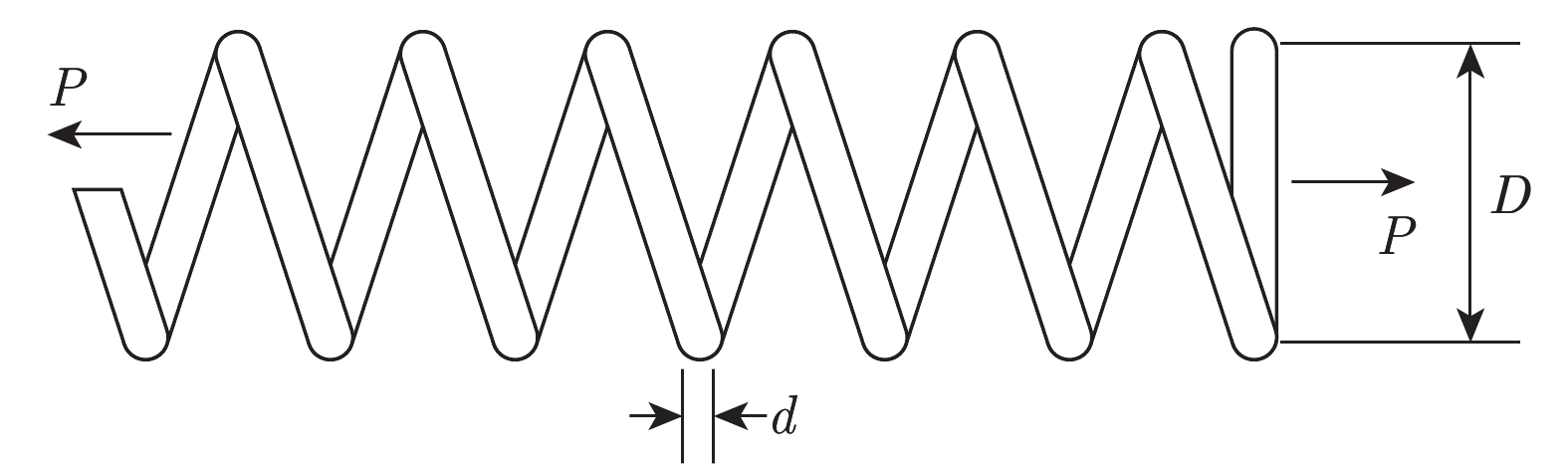

4.2 拉力/压力弹簧优化设计问题

拉力/压力弹簧优化设计问题的目的是减小弹簧压力/拉力的质量, 该优化设计包含的约束条件有剪应力、振动频率和最小振动挠度, 变量分别用$x_1 $、$x_2 $和$x_3 $表示, 分别代表弹簧线圈直径$d $、弹簧圈直径$D $和绕圈数量$P $. 弹簧优化设计问题模型如图10所示.

拉力/压力弹簧优化设计问题表示如下:

$$ \begin{split} &\min f(x) = ({x_3} + 2)x_1^2{x_2} \\ & {\rm{s.t.}}\\ &{{g_1}(x) = 1 - \frac{{x_2^3{x_3}}}{{71\,785x_1^4}} \leq 0} \\ &{{g_2}(x) = \frac{{4x_2^2 - {x_1}{x_2}}}{{12\,566({x_2}x_1^3 + x_1^4)}} + \frac{1}{{5\,108x_1^2}} \leq 0} \\ & {{g_3}(x) = 1 - \frac{{140.45{x_1}}}{{x_2^2{x_3}}} \leq 0} \\ & {{g_4}(x) = \frac{{{x_1} + {x_2}}}{{1.5}} \leq 0} \\ & 0.05 \leq {x_1} \leq 2.0, 0.25 \leq {x_2} \leq 1.3, 2.0 \leq {x_3} \leq 15.0 \end{split} $$ (23) 表9为各算法求解焊接梁设计问题的寻优结果的平均值, 包括RO算法[21]、飞蛾火焰优化(Moth-flame optimization, MFO)算法[21]、HSSAHHO算法[21]和SChOA算法[21]. 各算法独立运行50次, 取平均值.

表 9 拉力/压力弹簧优化设计问题结果对比Table 9 Comparison of tension/compression spring design算法 d D P 平均值 GA 0.0528 0.3523 11.5980 0.01250 PSO 0.0500 0.3174 14.0278 0.01270 WOA 0.5119 0.3452 12.0052 0.01260 GWO 0.5156 0.3562 11.5560 0.01250 RO 0.0413 0.3490 11.7620 0.01260 MFO 0.0510 0.3641 10.8684 0.01260 HSSAHHO 0.0514 0.3535 11.3546 0.01240 ChOA 0.0500 0.3159 14.2629 0.01280 SChOA 0.0524 0.3489 10.6543 0.01187 IChOA 0.0510 0.3374 11.5068 0.01185 由表9可知, 虽然IChOA对于弹簧的绕圈数量要求略高于SChOA, 但是对于弹簧线圈直径和弹簧圈直径优化结果都低于SChOA, 并且总体优化结果略低于SChOA, 说明IChOA对于工程设计问题的优化效果具有优势.

综上所述, 通过以上两个工程设计优化问题实验对比结果可以看出, 本文提出的IChOA对于实际工程设计问题的优化, 同样具有一定的优越性, 进一步体现了IChOA的鲁棒性.

5. 结束语

本文在原始ChOA基础上, 提出一种融合多策略的黄金正弦黑猩猩优化算法, 通过分析种群初始化分布, 引入Halton序列, 提高了算法初期的种群多样性, 引入改进的非线性收敛因子和自适应权重因子, 提高了算法的搜索能力, 结合黄金正弦算法思想更新个体位置, 防止算法过早收敛. 通过对23个基本测试函数和部分CEC2014测试函数进行寻优测试以及Wilcoxon秩和统计检验, 验证了该算法的优越性. 最后通过两个实际工程设计优化问题, 进一步验证了IChOA在实际工程应用中的有效性. 通过对本文改进策略的分析可以看出, 改进算法所需参数量较多且算法的寻优性能受非线性收敛因子影响较大, 对于收敛因子的选取依然存在改进的空间. 因此, 今后工作将继续研究改进的优化策略, 以提高ChOA的可操作性和适用性, 并将其应用到更为复杂的优化问题中.

-

表 1 算法参数设置

Table 1 Parameter setting of algorithm

算法 参数 ChOA $m = {{chaos} } (3, 1, 1)$ PSO c1 = 1.5, c2 = 2.0, $\omega$ = 1, wdamp = 0.99 GWO — WOA $b=1 $ IChOA $m = {chaos} (3, 1, 1)$, $\delta _1=0.3,$$\delta _2=300.0, \delta _3=1.8,$

$\rho _1=0.10,\;\rho _2=0.05, \;\rho _3=0.30, \; \varepsilon=300$表 2 基准测试函数介绍

Table 2 Introduction to benchmark functions

编号 函数名 定义域 维度 最优值 绝对精度误差$\varepsilon $ $f_1 $ Sphere [−100, 100] 30 0 1.00 × 10−3 $f_2 $ Schwefel'problem 2.22 [−10, 10] 30 0 1.00 × 10−3 $f_3 $ Schwefel'problem 1.2 [−100, 100] 30 0 1.00 × 10−3 $f_4 $ Schwefel'problem 2.21 [−100, 100] 30 0 1.00 × 10−3 $f_5 $ Generalized Rosenbrock's function [−30, 30] 30 0 1.00 × 10−2 $f_6 $ Step function [−100, 100] 30 0 1.00 × 10−2 $f_7 $ Quartic function [−1.28, 1.28] 30 0 1.00 × 10−2 $f_8 $ Generalized Schwefel's problem 2.26 [−500, 500] 30 −12569.5000 1.00 × 102 $f_9 $ Generalized Rastrigin's Function [−5.12, 5.12] 30 0 1.00 × 10−2 $f_{10} $ Ackley's function [−32, 32] 30 0 1.00 × 10−2 $f_{11} $ Generalized Criewank function [−600, 600] 30 0 1.00 × 10−2 $f_{12} $ Generalized penalized function 1 [−50, 50] 30 0 1.00 × 10−2 $f_{13} $ Generalized penalized function 2 [−50, 50] 30 0 1.00 × 10−2 $f_{14} $ Shekell's foxholes function [−65, 65] 2 1.0000 1.00 × 10−2 $f_{15} $ Kowalik's function [−5, 5] 4 0.0003 1.00 × 10−2 $f_{16} $ Six-hump camel-back function [−5, 5] 2 −1.0300 1.00 × 10−2 $f_{17} $ Branin function [−5, 5] 2 0.3980 1.00 × 10−2 $f_{18} $ Gold stein-price function [−2, 2] 2 3.0000 1.00 × 10−2 $f_{19} $ Hatman's function1 [0, 1] 3 −3.8600 1.00 × 10−2 $f_{20} $ Hatman's function 2 [0, 1] 6 −3.3200 1.00 × 10−2 $f_{21} $ Shekel's family 1 [0, 10] 4 −10.0000 1.00 × 10−2 $f_{22}$ Shekel's family 2 [0, 10] 4 −10.0000 1.00 × 10−2 $f_{23} $ Shekel's family 3 [0, 10] 4 −10.0000 1.00 × 10−2 表 3 各算法寻优结果对比(30维)

Table 3 Comparison of optimization results of each algorithm (30 dim)

函数 ChOA PSO GWO SChOA IChOA 平均值 标准差 平均值 标准差 平均值 标准差 平均值 标准差 平均值 标准差 $f_{1} $ 1.34 × 10−5 1.19 × 10−20 1.40 × 10−4 2.11 × 10−4 5.95 × 10−28 6.85 × 10−28 5.66 × 10−33 5.68 × 103 0 0 $f_{2} $ 1.42 × 10−5 8.55 × 10−21 4.21 × 10−2 4.54 × 10−2 7.95 × 10−17 4.97 × 10−17 1.72 × 10−20 1.91 × 1010 0 0 $f_{3} $ 6.31 × 100 1.40 × 10−17 7.01 × 101 2.21 × 101 2.83 × 10−5 1.12 × 10−4 6.19 × 10−8 2.25 × 104 0 0 $f_{4} $ 2.75 × 10−2 5.95 × 10−28 1.08 × 100 3.17 × 10−1 5.69 × 10−7 5.55 × 10−7 2.75 × 10−10 1.26 × 100 0 0 $f_{5} $ 2.87 × 101 2.51 × 10−14 9.67 × 101 6.01 × 101 2.70 × 101 8.26 × 10−1 2.85 × 102 1.00 × 107 3.13 × 10−4 5.26 × 10−17 $f_{6} $ 3.72 × 100 4.48 × 10−15 1.10 × 10−4 8.28 × 10−5 7.64 × 10−1 3.58 × 10−1 3.01 × 100 5.62 × 103 6.51 × 10−3 3.25 × 10−4 $f_{7} $ 1.72 × 10−3 1.09 × 10−18 1.22 × 10−1 4.49 × 10−2 1.72 × 10−3 7.51 × 10−4 1.00 × 10−3 5.77 × 101 7.81 × 10−7 1.02 × 10−12 $f_{8} $ −5.65 × 103 2.75 × 10−12 −4.84 × 103 1.15 × 103 −6.08 × 103 1.02 × 103 −9.87 × 103 1.80 × 102 −1.26 × 104 1.83 × 10−11 $f_{9} $ 1.41 × 101 0 4.67 × 101 1.16 × 101 3.22 × 100 4.16 × 100 0 7.77 × 101 0 0 $f_{10} $ 1.96 × 101 1.79 × 10−14 2.76 × 10−1 5.09 × 10−1 1.05 × 10−13 2.39 × 10−14 1.50 × 10−14 1.76 × 101 8.88 × 10−16 0 $f_{11} $ 4.79 × 10−2 7.00 × 10−17 9.21 × 10−3 7.74 × 10−3 5.14 × 10−3 9.98 × 10−3 0 8.30 × 101 0 0 $f_{12} $ 3.98 × 10−1 5.60 × 10−17 6.92 × 10−3 1.19 × 10−2 5.99 × 10−2 9.78 × 10−2 1.62 × 10−1 3.31 × 107 6.46 × 10−4 4.39 × 10−18 $f_{13} $ 2.82 × 100 1.76 × 10−15 6.68 × 10−3 8.91 × 10−3 6.27 × 10−1 3.06 × 10−1 6.76 × 10−1 5.16 × 107 2.97 × 10−5 4.56 × 10−16 $f_{14} $ 1.00 × 100 1.12 × 10−15 3.63 × 100 2.50 × 100 5.09 × 100 4.34 × 100 1.00 × 100 1.04 × 101 0.99 × 100 4.48 × 10−16 $f_{15} $ 1.36 × 10−3 4.39 × 10−19 5.80 × 10−4 2.21 × 10−4 5.73 × 10−3 8.98 × 10−3 6.80 × 10−4 1.70 × 10−3 2.30 × 10−4 5.46 × 10−19 $f_{16} $ −1.03 × 100 6.72 × 10−15 −1.03 × 100 6.25 × 10−16 −1.03 × 100 2.42 × 10−8 −1.03 × 100 2.21 × 10−1 −1.03 × 100 5.60 × 10−16 $f_{17} $ 3.98 × 10−1 3.36 × 10−16 3.98 × 10−1 0 3.98 × 10−1 0 3.99 × 10−1 4.90 × 10−3 3.99 × 10−1 8.98 × 10−16 $f_{18} $ 3.00 × 100 0 3.18 × 100 1.33 × 10−15 5.70 × 100 1.47 × 101 3.00 × 100 1.92 × 10−1 3.00 × 100 0 $f_{19} $ −3.85 × 100 2.69 × 10−15 −3.86 × 100 2.58 × 10−15 −3.86 × 100 2.17 × 10−3 −3.86 × 100 9.16 × 10−2 −3.72 × 100 1.34 × 10−18 $f_{20} $ −1.92 × 100 1.12 × 10−15 −3.26 × 100 6.05 × 10−2 −3.23 × 100 8.43 × 10−2 −3.32 × 100 1.24 × 10−1 −2.90 × 100 5.23 × 10−15 $f_{21} $ −4.92 × 100 2.69 × 10−15 −6.87 × 100 3.01 × 100 −8.80 × 100 2.20 × 100 −1.01 × 101 3.34 × 10−1 −1.01 × 101 2.38 × 10−15 $f_{22} $ −4.99 × 100 2.69 × 10−15 −8.46 × 100 3.08 × 100 −10.22 × 100 9.70 × 10−1 −5.18 × 100 5.74 × 10−2 −9.78 × 100 8.79 × 10−15 $f_{23} $ −5.02 × 100 4.48 × 10−16 −8.95 × 100 1.78 × 100 −9.90 × 100 1.96 × 100 −1.05 × 101 4.95 × 10−2 −9.93 × 100 8.97 × 10−16 表 4 Wilcoxon秩和检验结果

Table 4 Wilcoxon rank sum test results

编号 PSO ($p_{1} $) GWO ($p_{2} $) WOA ($p_{3} $) ChOA ($p_{4} $) GChOA ($p_{5} $) $f_{1} $ 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 $f_{2} $ 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 3.25 × 10−20 $f_{3} $ 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 $f_{4} $ 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 3.31 × 10−20 $f_{5} $ 1.01 × 10−17 2.47 × 10−17 1.04 × 10−15 2.29 × 10−15 7.96 × 10−18 $f_{6} $ 7.06 × 10−18 1.28 × 10−17 1.38 × 10−15 2.13 × 10−16 7.06 × 10−18 $f_{7} $ 4.20 × 10−17 7.06 × 10−18 6.88 × 10−14 1.36 × 10−17 1.27 × 10−16 $f_{8} $ 7.06 × 10−18 7.06 × 10−18 2.21 × 10−10 7.06 × 10−18 7.06 × 10−18 $f_{9} $ 3.31 × 10−20 3.31 × 10−20 NaN 1.17 × 10−19 3.31 × 10−20 $f_{10} $ 3.31 × 10−20 3.31 × 10−20 2.39 × 10−16 2.91 × 10−20 2.62 × 10−23 $f_{11} $ 3.31 × 10−20 3.31 × 10−20 3.27 × 10−1 2.50 × 10−4 3.31 × 10−20 $f_{12} $ 7.06 × 10−18 9.37 × 10−11 1.83 × 10−17 7.96 × 10−18 7.06 × 10−18 +/=/− 12/0/0 12/0/0 10/1/1 12/0/0 12/0/0 表 5 部分CEC2014函数介绍

Table 5 Introduction of part CEC2014 function

函数 维度 特征 定义域 最佳值 CEC03 30 单峰 [−100, 100] 300 CEC05 30 多峰 [−100, 100] 500 CEC06 30 多峰 [−100, 100] 600 CEC16 30 多峰 [−100, 100] 1600 CEC19 30 混合 [−100, 100] 1900 CEC22 30 混合 [−100, 100] 2200 CEC25 30 复合 [−100, 100] 2500 CEC27 30 复合 [−100, 100] 2700 表 6 CEC2014函数优化对比

Table 6 CEC2014 function optimization comparison

函数 PSO SCA L-SHADE HChOA GChOA IChOA 平均值 标准差 平均值 标准差 平均值 标准差 平均值 标准差 平均值 标准差 平均值 标准差 CEC03 4.87 × 101 6.61 × 101 8.83 × 100 1.36 × 100 0 0 7.78 × 104 7.44 × 103 7.54 × 104 6.58 × 103 7.35 × 104 6.23 × 103 CEC05 2.09 × 101 8.52 × 10−2 2.21 × 100 2.72 × 100 2.01 × 101 1.70 × 10−2 5.22 × 102 6.67 × 10−2 5.26 × 102 4.21 × 10−2 5.20 × 102 1.02 × 10−2 CEC06 1.08 × 101 2.53 × 100 6.63 × 101 3.74 × 101 1.67 × 10−2 9.17 × 10−2 6.33 × 102 2.42 × 100 6.33 × 10−5 2.42 × 100 6.31 × 102 2.39 × 100 CEC16 1.13 × 101 7.05 × 10−1 2.27 × 101 1.66 × 10−1 8.48 × 100 2.97 × 10−1 1.62 × 103 2.81 × 10−1 1.61 × 103 1.88 × 10−1 1.61 × 103 1.24 × 10−1 CEC19 7.76 × 100 1.87 × 100 2.88 × 102 2.99 × 101 3.59 × 100 7.22 × 10−1 2.56 × 103 2.46 × 100 1.76 × 103 2.39 × 100 2.32 × 103 1.96 × 100 CEC22 2.31 × 102 1.04 × 102 2.43 × 101 3.03 × 101 3.69 × 101 3.36 × 101 3.57 × 103 9.65 × 101 4.21 × 103 1.48 × 102 3.56 × 103 7.48 × 101 CEC25 2.09 × 102 1.65 × 100 2.69 × 102 2.71 × 101 2.03 × 102 4.97 × 10−2 2.71 × 103 9.49 × 100 2.71 × 103 3.21 × 100 2.70 × 103 0 CEC27 5.36 × 102 8.15 × 103 2.08 × 102 1.89 × 101 3.00 × 102 1.34 × 10−13 2.93 × 103 5.36 × 100 2.91 × 103 8.12 × 100 2.90 × 103 0 表 7 基准函数寻优平均时间及成功率对比

Table 7 Comparison of average time and success rate for optimization of benchmark function

函数 ChOA HChOA WChOA GChOA IChOA 平均值 标准差 成功率

(%)平均值 标准差 成功率

(%)平均值 标准差 成功率

(%)平均值 标准差 成功率

(%)平均值 标准差 成功率

(%)f1 1.9732 0.0136 100 1.9824 0.0088 100 1.9302 0.0155 100 1.4113 0.0181 100 1.3916 0.0101 100 f2 1.9546 0.0101 100 1.9841 0.0181 100 1.7962 0.0063 100 1.4176 0.0101 100 1.4086 0.0081 100 f3 2.2999 0.0083 0 2.2988 0.0077 100 2.0616 0.0906 100 2.1272 0.0128 100 2.1150 0.0275 100 f4 2.0456 0.0107 0 1.9884 0.0309 100 1.9955 0.0676 100 1.4381 0.0330 100 1.4208 0.0446 100 f5 2.0696 0.0663 0 2.0691 0.0649 0 1.9966 0.0326 33.3 1.4670 0.0530 96.6 1.4574 0.0244 100 f6 2.0127 0.0435 0 1.9617 0.0107 36.6 1.9604 0.0138 16.6 1.4122 0.0111 43.3 1.4006 0.0121 90.0 f7 2.0567 0.0089 100 2.0364 0.0190 100 2.0520 0.0147 100 1.5407 0.0070 100 1.5356 0.0098 100 f8 2.0246 0.0127 0 2.0195 0.0310 0 1.9784 0.0294 0 1.4638 0.0086 73.3 1.4625 0.0132 83.3 f9 2.0138 0.0343 0 2.0203 0.0112 96.6 1.9855 0.0096 100 1.4316 0.0184 100 1.4169 0.0141 100 f10 2.0011 0.0113 0 2.0045 0.0143 73.3 1.9999 0.0086 100 1.4521 0.0113 100 1.4395 0.0089 100 f11 2.0293 0.0081 63.3 2.0301 0.0144 100 2.0155 0.0095 100 1.4776 0.0119 100 1.4735 0.0116 100 f12 2.2040 0.0114 0 2.1930 0.0142 33.3 2.1697 0.0169 86.6 1.8354 0.0110 43.3 1.8422 0.0530 100 f13 2.1873 0.0112 0 2.1792 0.0115 36.6 2.1811 0.0184 56.6 1.8180 0.0140 66.6 1.8140 0.0084 100 f14 0.7893 0.0090 100 0.7916 0.0068 100 0.7898 0.0073 100 1.3830 0.0100 100 1.3571 0.0064 100 f15 0.3131 0.0039 0 0.3141 0.0034 50.0 0.3174 0.0024 63.3 0.2792 0.0027 90.0 0.2788 0.0024 96.6 f16 0.1730 0.0038 100 0.1743 0.0034 100 0.1728 0.0037 100 0.1647 0.0037 100 0.1647 0.0013 100 f17 0.1690 0.0012 100 0.1709 0.0043 100 0.1689 0.0013 100 0.1556 0.0061 100 0.1524 0.0022 100 f18 0.1673 0.0025 100 0.1699 0.0035 100 0.1689 0.0021 100 0.1516 0.0012 100 0.1510 0.0020 100 f19 0.2804 0.0045 100 0.2847 0.0031 100 0.2849 0.0019 100 0.3021 0.0064 100 0.2580 0.0017 100 f20 0.4751 0.0042 46.6 0.4737 0.0024 70.0 0.4724 0.0028 63.3 0.4304 0.0053 63.3 0.4278 0.0033 76.6 f21 0.4046 0.0251 16.6 0.4068 0.0035 20.0 0.4012 0.0028 70.0 0.4581 0.0029 76.6 0.4035 0.0055 83.3 f22 0.4447 0.0043 0 0.4458 0.0030 36.6 0.4403 0.0050 53.3 0.5391 0.0048 73.3 0.4349 0.0051 80.0 f23 0.5087 0.0029 0 0.5089 0.0036 43.3 0.5080 0.0021 36.6 0.6610 0.0034 76.6 0.6347 0.0039 86.6 表 8 焊接梁设计问题结果对比

Table 8 Comparative results of welding beam design problems

算法 h l t b 平均值 GA 0.2455 6.1986 8.1264 0.2247 2.4412 PSO 0.2027 3.4705 9.0366 0.2057 1.7249 WOA 0.2024 3.4772 9.0435 0.2189 1.7299 GWO 0.2022 3.4893 9.0541 0.2155 1.7265 RO 0.2036 3.5284 9.0042 0.2072 1.7353 MVO 0.2054 3.4731 9.0445 0.2056 1.7246 HSSAHHO 0.2057 3.4705 9.0367 0.2057 1.7248 ChOA 0.2214 3.5358 8.9115 0.2127 1.7737 SChOA 0.2057 3.4705 9.0306 0.2056 1.7229 IChOA 0.2038 3.4713 9.0300 0.2060 1.7228 表 9 拉力/压力弹簧优化设计问题结果对比

Table 9 Comparison of tension/compression spring design

算法 d D P 平均值 GA 0.0528 0.3523 11.5980 0.01250 PSO 0.0500 0.3174 14.0278 0.01270 WOA 0.5119 0.3452 12.0052 0.01260 GWO 0.5156 0.3562 11.5560 0.01250 RO 0.0413 0.3490 11.7620 0.01260 MFO 0.0510 0.3641 10.8684 0.01260 HSSAHHO 0.0514 0.3535 11.3546 0.01240 ChOA 0.0500 0.3159 14.2629 0.01280 SChOA 0.0524 0.3489 10.6543 0.01187 IChOA 0.0510 0.3374 11.5068 0.01185 -

[1] 何东晓, 周栩, 王佐, 等. 复杂网络社区挖掘—基于聚类融合的遗传算法. 自动化学报, 2010, 36(8): 1160--1170. doi: 10.3724/SP.J.1004.2010.01160He D X, Zhou X, Wang Z, et al. Complex Network Community Mining: Genetic Algorithm Based on Clustering Fusion. Acta Automatica Sinica, 2010, 36(8): 1160--1170. doi: 10.3724/SP.J.1004.2010.01160 [2] Parsopoulos K E, Vrahatis M N. Particle swarm optimization method for constrained optimization problems. Intelligent Technologies —— Theory and Application: New Trends in Intelligent Technologies, 2002, 76(1): 214−220. [3] 龙文, 伍铁斌, 唐明珠, 徐明, 蔡绍洪. 基于透镜成像学习策略的灰狼优化算法. 自动化学报, 2020, 46(10): 2148--2164.Long W, Wu T B, Tang M Z, et al. A Grey Wolf Optimization Algorithm Based on Lens Imaging Learning Strategy. Acta Automatica Sinica, 2020, 46(10): 2148-2164. [4] Arora S, Singh S. Butterfly optimization algorithm: a novel approach for global optimization. Soft Computing, 2019, 23(3): 715--734. doi: 10.1007/s00500-018-3102-4 [5] Tharwat A, Elhoseny M, Hassanien A E, et al. Intelligent Bézier curve-based path planning model using Chaotic Particle Swarm Optimization algorithm. Cluster Computing, 2019, 22(2): 4745--4766.. [6] Guha D, Roy P K, Banerjee S. Load frequency control of interconnected power system using grey wolf optimization. Swarm and Evolutionary Computation, 2016, 27: 97--115. doi: 10.1016/j.swevo.2015.10.004 [7] Khishe M, Mosavi M R. Chimp optimization algorithm. Expert systems with applications, 2020, 149: 113338. doi: 10.1016/j.eswa.2020.113338 [8] Lu C, Liang G, Jin Y. Grey wolf optimizer with cellular topological structure. Expert Systems with Applications, 2018, 107: 89--114. doi: 10.1016/j.eswa.2018.04.012 [9] 王坚浩, 张亮, 史超. 基于混沌搜索策略的鲸鱼优化算法[J]. 控制与决策, 2019, 34(9): 1893--1900.Wang J H, Zhang L, Shi C. Whale optimization algorithm based on chaotic search strategy. Control and Decision, 2019, 34(9): 1893--1900. [10] 宁杰琼, 何庆. 混合策略改进的蝴蝶优化算法. 计算机应用研究, 2021, 38(06): 1718-1723+1738.Ning J Q, He Q. Butterfly optimization algorithm improved by hybrid strategy. Application Research of Computers, 2021, 38(06): 1718--1723+1738. [11] 王秋萍, 王梦娜, 王晓峰. 改进收敛因子和比例权重的灰狼优化算法. 计算机工程与应用, 2019, 55(21): 60--65. doi: 10.3778/j.issn.1002-8331.1808-0117Wang Q P, Wang M N, Wang X F. Grey wolf optimization algorithm with improved convergence factor and proportional weight. Computer Engineering and Applications, 2019, 55(21): 60--65. doi: 10.3778/j.issn.1002-8331.1808-0117 [12] Ewees A A, Abd Elaziz M, Houssein E H. Improved grasshopper optimization algorithm using opposition-based learning. Expert Systems with Applications, 201 8, 112: 156--172. doi: 10.1016/j.eswa.2018.06.023 [13] Dinkar S K, Deep K. Opposition based Laplacian ant lion optimizer. Journal of computational science, 2017, 23: 71--90. doi: 10.1016/j.jocs.2017.10.007 [14] 吕鑫, 慕晓冬, 张钧, 王震. 混沌麻雀搜索优化算法. 北京航空航天大学学报. 2020, 16(05): 1-10.Lu X, Mu X D, Zhang J, Wang Z. Chaos Sparrow Search Optimization Algorithm. Journal of Beijing University of Aeronautics and Astronautics. 2020, 16(05): 1--10. [15] Sayed S A E F, Nabil E, Badr A. A binary clonal flower pollination algorithm for feature selection. Pattern Recognition Letters, 2016, 77: 21--27. doi: 10.1016/j.patrec.2016.03.014 [16] Bangyal W H, Batool H, Ahmed J, et al. An improved particle swarm optimization algorithm with chi-square mutation strategy. International Journal of Advanced Computer Science and Applications, 2019, 10(3): 481-491. [17] Tanyildizi E, Demir G. Golden sine algorithm: A novel math-inspired algorithm. Advances in Electrical and Computer Engineering, 2017, 17(2): 71--78. doi: 10.4316/AECE.2017.02010 [18] 邢燕祯, 王东辉. 基于模糊控制的权重决策灰狼优化算法. 计算机系统应用, 2018, 27(10): 202--208.Xing Y Z, Wang D H. Weight decision gray wolf optimization algorithm based on fuzzy control. Computer Systems & Applications, 2018, 27(10): 202--208. [19] 郭文艳, 王远, 戴芳, 等. 基于精英混沌搜索策略的交替正余弦算法. 控制与决策, 2019, 34(8): 1654--1662.Guo W Y, Wang Y, Dai F, et al. Alternating Sine and Cosine Algorithm Based on Elite Chaotic Search Strategy. Control and Decision, 2019, 34(8): 1654--1662. [20] 汪超, 王丙柱, 岑豫皖, 谢能刚. 基于多样性全局最优引导和反向学习的离子运动算法. 控制与决策, 2020, 35(7): 1584−1596.Wang Chao, Wang Bing-Zhu, Cen Yu-Wan, Xie Neng-Gang. Ion motion algorithm based on diversity global optimal guidance and reverse learning Control and Decision, 2020, 35(7): 1584−1596. [21] Kaur M, Kaur R, Singh N, et al. SChoA: an newly fusion of sine and cosine with chimp optimization algorithm for HLS of datapaths in digital filters and engineering applications. Engineering with Computers, 2021, 42, 1--29. [22] Zhang X M, Wang X, Kang Q. Improved grey wolf optimizer and its application to high dimension alfunction and FCM optimization. Control and Decision, 2019, 10(8): 1--10. [23] Liang J J, Qu B Y, Suganthan P N. Problem Definitions and Evaluation Criteria for the CEC 2014 Special Session and Competition on Single Objective Real-parameter Numerical Optimization, Technical Report, Computational Intelligence Laboratory, Zhengzhou University, China, 2013. [24] Xu G P, Cui Q L, Shi X H, et al. Particle swarm optimization based on dimensional learning strategy. Swarm and Evolutionary Computation, 2019, 45: 33--51. doi: 10.1016/j.swevo.2018.12.009 [25] Chen H L, Wang M J, Zhao X H. A multi-strategy enhanced sine cosine algorithm for global optimization and constrained practical engineering problems. Applied Mathematics and Computation, 2020, 369: 124872. doi: 10.1016/j.amc.2019.124872 [26] Tanabe R, Fukunaga A S. Improving the search performance of SHADE using linear population size reduction. In: Proceedings of the IEEE Congress on Evolutionary Computation. Beijing, China: IEEE, 2014. 1658−1665 [27] 傅文渊. 具有万有引力加速机理的布谷鸟搜索算法. 软件学报, 2021, 32(05): 1480--1494.Fu W Y. Cuckoo Search Algorithm with Gravity Acceleration Mechanism. Journal of Software, 2021, 32(05): 1480--1494. 期刊类型引用(17)

1. 张福兴,高腾,吴泓达. 多策略融合的改进黑猩猩优化算法. 北京航空航天大学学报. 2025(01): 235-247 .  百度学术

百度学术2. 刘威,牛英杰,王东,刘光伟,马灵潇. 引入人工偏好权重的混合型黑猩猩优化算法及应用. 控制与决策. 2024(02): 411-419 .  百度学术

百度学术3. 史洪岩,蔡志豪. 基于自适应权重与透镜成像学习的麻雀算法. 电子设计工程. 2024(05): 13-18+24 .  百度学术

百度学术4. 姚光磊,熊菊霞,杨国武,郑宏宇. 多策略混合的花朵授粉算法. 小型微型计算机系统. 2024(03): 613-620 .  百度学术

百度学术5. 吴晓阳,邹尧,付强,贺威. 生物集群能量高效利用机制研究综述. 自动化学报. 2024(03): 431-449 .  本站查看

本站查看6. 潘悦悦,吴立飞,杨晓忠. 一种多策略改进鲸鱼优化算法的混沌系统参数辨识. 智能系统学报. 2024(01): 176-189 .  百度学术

百度学术7. 李若晨,肖人彬. 基于改进狼群算法优化LSTM网络的舆情演化预测. 复杂系统与复杂性科学. 2024(01): 1-11 .  百度学术

百度学术8. 张庭溢,汪弘健. 路灯人影和离家出走改进的黑猩猩优化算法. 计算机科学与探索. 2024(06): 1491-1512 .  百度学术

百度学术9. 丁鑫,郭云川,张长胜,钱斌,张家洪,胡蓉. 递进式融合多策略的改进哈里斯鹰优化算法. 小型微型计算机系统. 2024(09): 2126-2136 .  百度学术

百度学术10. 姚光磊,熊菊霞,杨国武. 基于神经网络优化的花朵授粉算法. 计算机应用. 2024(09): 2829-2837 .  百度学术

百度学术11. 孙仟硕,王英博. 融合多策略的改进蜣螂优化算法及其应用. 信息与控制. 2024(05): 631-641+651 .  百度学术

百度学术12. 王毅,郑宏志,黄欣,洪国栋,闫小婕. 基于多阶段调度框架的麻雀搜索优化算法. 电子学报. 2024(09): 3086-3096 .  百度学术

百度学术13. 李奕轩,田云娜. 多策略改进的鱼鹰优化算法及其应用. 延安大学学报(自然科学版). 2024(04): 99-108 .  百度学术

百度学术14. 鲁小桐,陈丽敏,王东岩,王一荻,沈越. 融入Cat映射与高斯变异的黑猩猩优化算法及其应用. 现代计算机. 2024(22): 22-28 .  百度学术

百度学术15. 董跃华,李俊,朱东林. 基于Halton序列改进蝠鲼算法的K-means图像分割. 电光与控制. 2023(02): 91-98 .  百度学术

百度学术16. 刘海龙,雷斌,王菀莹,云雁,柴获. 基于改进黑猩猩优化算法的仓储移动机器人路径规划. 信息与控制. 2023(06): 689-700 .  百度学术

百度学术17. 高大唤,梁宏涛,杜军威,于旭,胡强. 改进黑猩猩优化算法的测试数据生成研究. 计算机工程与应用. 2022(23): 83-93 .  百度学术

百度学术其他类型引用(15)

-

下载:

下载:

下载:

下载: