-

摘要:

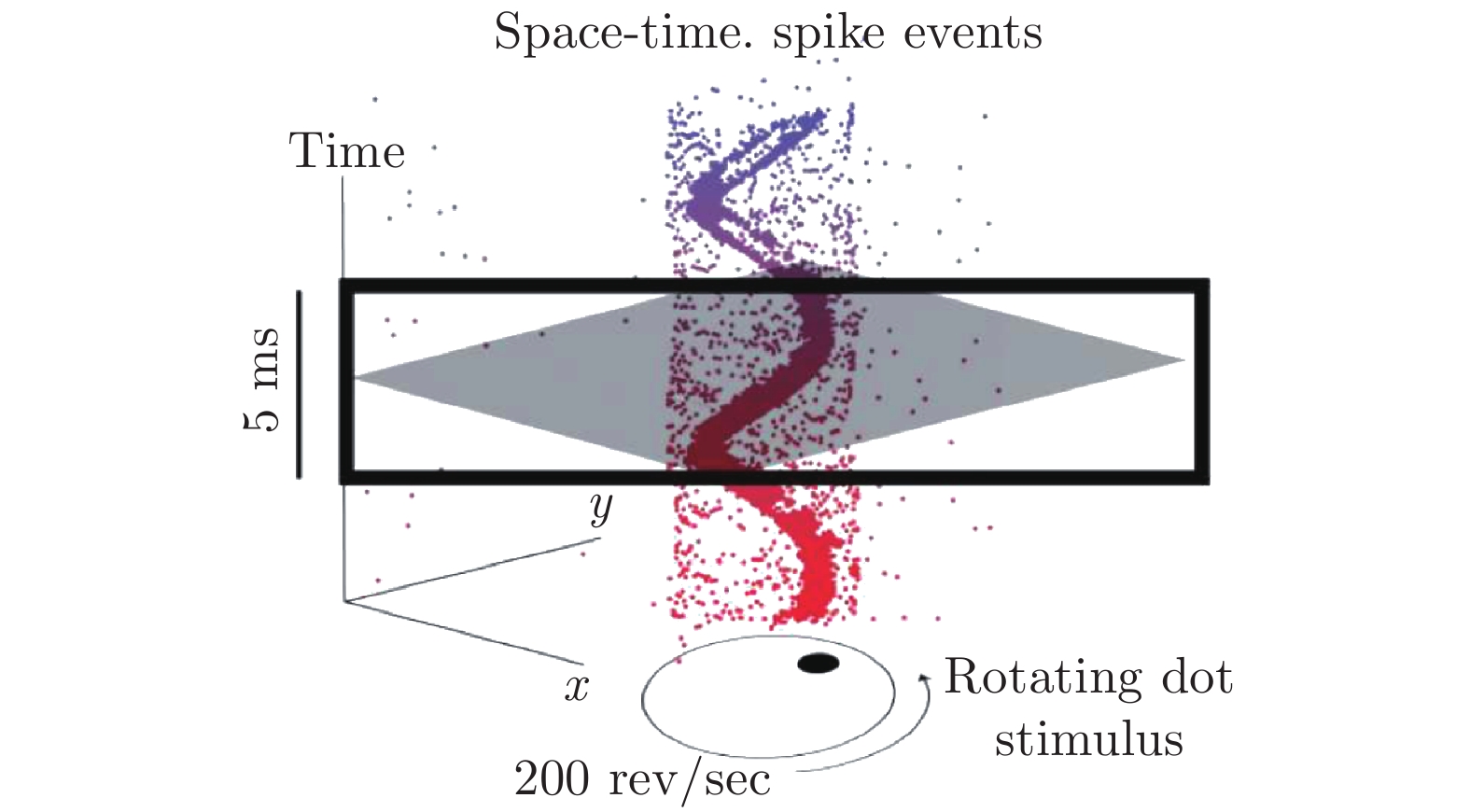

事件相机是一种新兴的视觉传感器, 通过检测单个像素点光照强度的变化来产生“事件”. 基于其工作原理, 事件相机拥有传统相机所不具备的低延迟、高动态范围等优良特性. 而如何应用事件相机来完成机器人的定位与建图则是目前视觉定位与建图领域新的研究方向. 本文从事件相机本身出发, 介绍事件相机的工作原理、现有的定位与建图算法以及事件相机相关的开源数据集. 其中, 本文着重对现有的、基于事件相机的定位与建图算法进行详细的介绍和优缺点分析.

Abstract:Event-based camera is a new type of visual sensor, which activates “events” by monitoring the changes of lighting intensity. Event camera offers low-latency output and tolerates high dynamic range, therefore, it is a new topic in the SLAM area applying event-based camera to robot localization and mapping. This work introduces the working principle of event-based camera and reviews present algorithms and dataset of event-based localization and mapping. Emphasis of this work is introducing and analysing event-based localization and mapping algorithms.

-

Key words:

- Event camera /

- low latency /

- pose estimation /

- localization and mapping

-

近年来, 随着机器人产业的快速发展, 多种类的移动机器人正逐步从实验室走进人类的生活[1].这意味着移动机器人的工作环境发生了由单一的实验测试场景到复杂的真实人类世界的巨大转变, 同时其工作时间也由有限的周期性测试转变为连续的长期运行.相比相对稳定的测试场景, 真实世界会存在动态干扰、光照条件变化、天气季节转变、环境改造等诸多不确定性因素.真实世界中这些渐进或剧烈的环境变化给机器人环境感知与行为决策带来巨大的挑战.如何使移动机器人适应真实世界中复杂多样的变化, 保证其长期自主环境适应能力是长久以来国内外学者密切关注的挑战性研究问题[2-3].

在移动机器人领域, 对一个机器人系统进行长期自主环境适应性的测试与验证, 其必要条件是测试周期必须要完整覆盖其工作环境的周期性变化[4-7].对于工作在室内环境的移动机器人系统, 其工作周期通常以天为单位, 因此通常通过连续多周期的测试来验证系统的稳定性.而对于工作在室外开放环境下的移动机器人系统, 因为光照、季节以及人为干扰等环境条件的改变, 环境的表象、场景结构乃至于景物的分布均会发生不同程度的变化, 因此与之对应的测试周期要以年为单位, 也就是要历经不同天气、季节等诸多环境条件的检验.

真实世界中复杂的环境条件变化对地图构建与维护、重定位及场景理解等移动机器人基础的自主行为能力带来巨大的挑战.例如, 环境的表象及结构变化导致移动机器人对环境当前的观测与先前构建的地图发生矛盾, 致使先验地图失效; 移动机器人在不同时间重复访问同一场景时, 光照、季节等环境条件的变化或城市设施改建等人为因素会导致其两次对场景的观测不一致, 进而导致其重定位的失败; 真实世界环境中存在大量的行人及车辆, 且其行为存在偶然性与不确定性, 这给移动机器人尤其是高速移动机器人的自主导航造成巨大的挑战; 移动机器人的场景理解主要是对其所处环境进行目标检测、语义分割及语义关联等任务, 光照、季节等环境条件及对环境观测视角等的改变都会降低场景理解相关任务的准确性.

要保证移动机器人在长期运行中具有良好的环境适应能力, 则主要需要其在地图构建与动态维护[8]、重定位[9]和自主场景理解[10]这三方面行为任务均能够长期有效应对环境条件变化.因此本文主要从这三方面分析论述移动机器人长期自主环境适应的研究进展与前沿动态.

1. 移动机器人地图构建与动态维护

移动机器人在人工设计的实验室测试场景中的地图构建方法[11-16]已被广泛研究, 也已趋于成熟.但这些传统方法大都默认环境的外观和结构是基本不变的, 因此移动机器人基于先验地图来完成定位及导航等相关任务.此外, 早期针对动态环境的地图构建方法[17-20]将移动物体看作环境中离群数据, 进而从观测数据中过滤或跟踪移动的物体.但它们还是基于机器人所处环境的外观与结构是静态不变的假设, 这种假设使得这类方法在环境表象或结构会发生巨大变化的真实世界中不再适用.

由于目前尚无统一的地图构建框架可以在多种类场景中均具有通用性, 基于近年来相关文献查阅结果[21-22], 我们将移动机器人的工作场景大致分为功能单一的封闭环境、高度动态的室内环境和大范围室外开放环境.

1.1 功能单一的封闭环境

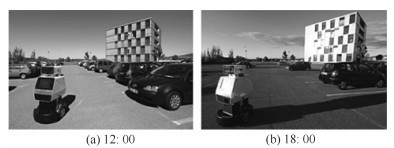

诸如仓库、停车场等小范围功能性场所是现阶段移动机器人有较多成功应用案例的环境.这类场景最大的特点就是环境模型发生着频繁的变化, 如货物装卸及车辆流动所导致的环境改变. 图 1摘自文献[23], 其显示了不同时刻车辆流动给停车环境带来的明显变化.研究学者将该环境中的物体定义为三类:静态物体、半静态物体和动态物体, 其中半静态物体(Semi-static)是指货物、车等可能被移动的静态物体.功能单一的封闭环境中半静态物体位置的改变可能导致机器人先前构建的地图过时失效, 进而致使机器人定位的失败甚至造成严重的后果.如何应对半静态物体位置变化对构建环境模型的冲击及动态障碍的干扰, 是实现移动机器人在该类环境下长期稳定自主运行的关键.

Meyer-Delius等[24]利用临时的局部地图(Temporary local maps)表述来跟踪因半静态物体位置改变而造成的异常观测.虽然该方法仍是基于环境静态不变性假设的, 但其当环境改变时便建立临时的局部地图对环境变化进行表述并对原始先验地图进行临时扩展, 然后依赖扩展后的地图利用粒子滤波算法估计机器人位姿.实验显示通过检测由半静态物体引起的异常观测, 可有效提高机器人定位的鲁棒性.

针对此类功能相对单一的结构化封闭场景, 基于概率估计模型的构图和定位方法体现出良好的优越性. Saarinen等[25]提出一种基于栅格模型的动态环境构图方法.该方法将每个栅格定义为拥有两个状态的独立马尔科夫链, 并利用基于近因权重(Recency weighting)的策略在线学习状态转换模型参数.这种基于概率的栅格地图不仅可以表述栅格是否被占用, 同时还可以对栅格动态进行建模.同样基于概率估计模型, Tipaldi等[23]利用二维栅格的隐式马尔科夫模型来表述被占有栅格的动态属性.通过利用观测数据对表述模型参数的训练学习, 该方法可有效辨别动态、半静态和静态等不同物体的动态属性.作者利用该方法有效对停车场环境进行地图构建和动态维护.

Biswas等[26]提出基于插曲(Episodic)的非马尔科夫过程定位方法, 该方法在整个机器人的运动轨迹中估计观测数据的置信度以及观测数据置信度与地图中未存储的静态物体、动态物体和存储的静态物体之间的关联.机器人在长期运行过程中从观测数据中提取长期特征来匹配静态地图, 提取短期特征用于匹配历史观测中的短期特征.与文献[15]和[16]两种方法相比, 该方法在停车场等数据集上取得了更好的表现效果.

Saarinen等[7]提出了一种新颖的在线地图构建方法.作者结合了NDT (Normal distributions transform)和占用栅格(Occupancy grid)两种常用的地图表述模型的优势: NDT地图模型表述简洁高效, 能实现在线的地图构建, 但是不具备占用栅格地图可被递归更新的特性; 占用栅格可被递归更新, 并根据重复的观测释放或占用栅格空间, 这种特性可有效表述环境的变化.该方法在某牛奶生产车间持续17个小时的测试中显示出其良好的表现.

1.2 高度动态的室内环境

近年来, 家庭服务、银行导引、餐厅送餐等多种类服务机器人产品陆续推向市场.与仓库、停车场等功能单一的场所相比, 家庭、办公室及餐饮场所等生活场景的组成元素更加多样化, 同时还存在诸如门窗开闭、家具移动及行人无规则运动等复杂因素.为了应对室内环境的复杂变化, 许多地图构建与动态维护方法被提出以提升机器人的自主环境适应能力.

Biber等[27]提出一种基于采样的环境表述方法对环境变化进行建模.基本的思想是用不同时间段对同一场景的环境建模组合描述当前场景, 随着机器人的运行会不断加入最新的观测模型, 剔除时间最久远的环境表述.这种思想被称为"记忆消退" (Memory decay).当机器人自主定位时, 将当前传感器数据与地图中不同时间段的环境模型比对, 选出与当前传感器数据最匹配的环境表述.这使得定位更加鲁棒, 地图不断更新永不过时.为了验证方法的有效性, 在包含若干实验室、办公室、走廊和大厅的整个楼层中, 作者每天进行三次(早上、午后、傍晚)测试, 并坚持了长达5周共计75次测试的周期.

受人类记忆的多重存储模型启发, Dayoub等[28]利用移动机器人对环境的"短时记忆" (Short-term memory)和"长期记忆" (Long-term memory)来构建地图.作者利用注意力机制将感知信息中感兴趣的特征转移到短时记忆地图中, 同时利用训练机制去选择稳定的特征更新到长期记忆地图表述中.为了更好地适应变化环境及节省存储空间, 他们提出罢免机制从拓扑节点中移除过时无效的信息.类似地, Morris等[29]同时构建短时记忆和长期记忆两个三维八叉树地图(OctoMap)来表述移动机器人周围环境.短时记忆地图存储移动机器人当前状态下的观测信息, 长期记忆地图是对短时记忆地图的累积更新, 但只有短时记忆地图中永久的环境信息才被更新转移到长期记忆地图中.实验证实, 利用多种地图表述能更好地实现移动机器人在复杂多变的环境中自主定位及导航.

Krajnik等[30]认为人类的许多日常活动都是周期性明显, 有规律可循的.因此作者将未知的环境变化过程定义为周期性函数, 进而以栅格地图为基础, 利用频谱对环境的时空变化进行建模表述.将环境变化过程定义为周期性函数, 可利用傅里叶变换有效识别.同时将时域转换为频域, 可高效地辨认分析并保存规律性的环境变化过程.对环境变化过程的周期性假设, 能减轻机器人地图构建及维护的复杂度, 同时可使长航时机器人具有对环境变化的预测能力, 有助于更好地长时间自主运行.在实验过程中, 作者利用移动机器人在室内环境中以巡逻的模式采集一周的数据验证方法的准确性和效率.结果显示, 该方法在任意时间长度数据中测试, 只需要恒定且少量的存储空间, 这一特性正是长航时机器人长期运行所需要的.

1.3 大范围室外开放环境

随着室外移动机器人技术的不断发展, 如何对室外准结构化或完全非结构化开放环境进行建模及动态维护成为当前研究的热点.室外开放环境中移动机器人地图构建所面临的主要挑战是如何有效地检测行人、车辆等高危动态目标, 以及如何有效地应对光照、季节等环境条件的转变.激光雷达传感器因为利用主动光源感知环境, 不受光照条件影响, 可很好地解决光照条件变化造成的环境外貌变化, 且测距精度高, 有利于构建长期有效的高精度地图模型.谷歌、百度等无人车均采用三维激光雷达感知环境, 取得了非常显著的研究成果.值得一提的是, Zhang等[31]提出的基于三维激光的实时定位与构图方法, 取得了非常有竞争力的构图效果.

在室外开放环境中, 在地图中精确定位、预测和跟踪人车等高动态障碍是室外移动机器人安全的基础和必要保障.传统的动态障碍物检测方法大都是基于人为设计特征的分类方法.但机器人长期的运行过程中, 因为观测视角的变化, 环境中互相遮挡等问题, 使得利用基于人为设计特征分类的方法稳定性降低. Wang等[32]提出一种端到端的三维激光点云分割方法:输入是原始三维点云, 输出是可直接被分类的点云簇.作者利用欧氏最小生成树(Euclidean minimum spanning tree)实现基于图的点云聚类算法对点云进行分割, 并设计了基于RANSAC的边界选择规则.他们指出并证实, 针对车辆、行人等文中提及的特定物体类别, 解决二分类问题要比直接解决多分类问题高效的多.这主要是因为鲁棒的多目标物体分类需要足够的形状信息, 而通过预分割获得的目标点云簇中, 部分点云簇缺乏足够的满足多分类要求的形状信息.正因为如此, 在观测视角受限或其他限制条件下, 局部被观测的动态物体也能被很好地检测与定位.

Tanzmeister等[33]提出一种新颖的基于栅格的环境描述模型, 可有效检测动静态物体, 同时评估其速度及不确定性.该方法利用粒子滤波算法直接对观测数据的速度概率分布进行评估, 并不依赖现有的目标跟踪算法来过滤与创建和更新地图无关的数据点, 也不依赖动静态物体分类算法对观测数据预分类.由于没有特定的特征提取和形状假设, 任意的移动物体都能被有效定位及跟踪.

机器人在长期自主运行过程中, 应充分利用先前积累的经验教训, 不断提升其开放环境中的构图能力. Ott等[34]提出一种实时的无监督增量式的学习方法, 利用AP (Affinity propagation)聚类算法对三维激光点云构建基于物体类别层面的环境模型, 并通过聚类物体与机器人的交互来判断该物体是否为障碍物, 并预测发生冲突的可能性.这种机器人与环境增量式交互学习的构图方法, 满足长航时机器人长期运行的需求, 同时通过长期交互学习, 机器人会更加稳定地适应复杂多变的开放环境.

为了构建长期有效的地图, Pomerleau等[35]在苏黎世联邦理工学院校园中坚持了长达七个月的测试.他们认为终生地图应该根据环境变化维护更新, 同时应包含语义层信息指导机器人的运动规划.他们的长期定位与构图系统包含位姿估计、全局地图维护和速度估计三个模块, 通过对环境的重复观测推断每个三维点的动静态属性, 并评估动态点的速度.该方法的优点是不依赖离线训练的目标检测模型及点云聚类过程, 直接对每个三维点进行估计, 节省计算成本.

移动机器人长期的自主运行不仅要考虑环境的条件变化, 还需要考虑计算效率与存储空间.当机器人不断重复地访问场景时, 传统的方法会受到计算效率和存储空间的制约而降低算法的性能.为了利用有限的存储空间对地图进行最有效的表述, Dymczyk等[36]将场景识别与地图维护独立, 实现在线场景识别和离线地图维护的交替作业.作者提出一种简化的地图表述模型(Summary map), 该地图只保存对场景识别有用的路标特征, 并裁剪机器人重叠的位姿轨迹.他们认为经常被观测到的路标特征是需要被保存的, 因为他们更容易被重复检测与匹配, 且随着时间的推移更加稳定.

研究表明, 对环境进行目标检测[37]和场景理解[38-39], 构建带有更高层次语义信息的地图模型[40-41], 有助于在物体类别层面对机器人定位与导航进行指导.语义地图的构建使机器人感知利用环境中更为稳定的语义信息, 同时有助于实现移动机器人的类人决策, 更好地融入人类生活. Drouilly等[42]利用场景理解算法对全景相机图像进行物体分类, 构建局部语义子地图; 进而通过位姿估计算法将各子地图连接构建全局拓扑语义地图.他们提出一种基于语义内容的定位算法, 在用语义信息描述路径的同时, 也可利用语义内容检索完成定位与导航.此外, 构建语义地图可实现移动机器人与人更方便直接地人机交互, 进而更高效地完成指定任务.

1.4 小结

真实世界中复杂的环境条件变化给移动机器人地图构建及动态维护带来巨大挑战.为了应对这一挑战, 国内外专家学者提出的移动机器人地图构建及动态维护方法主要分为三类.第一类是基于概率的地图构建与维护方法[7, 23, 25-26], 此类方法通常依赖栅格地图模型, 利用移动机器人对环境重复的观测不断更新维护地图模型; 但此类方法通常要求移动机器人具有较准确的位姿跟踪或全局定位能力.在不依赖全局定位系统的前提下, 移动机器人基于轮式/视觉/激光里程计[43]进行位姿跟踪时, 其累积误差会随着机器人的长期运行而不断增长.因此, 此类基于概率的方法通常只适用于较小范围的应用场景.第二类是基于采样或``记忆''的方法[27-29], 此类方法通常同时利用对环境的多次观测来构建环境地图.同时, 将多次观测数据中相对稳定的环境信息更新到地图中.但此类方法需要尽可能多地访问同一场景以覆盖环境的条件变化, 且大范围场景下易产生信息爆炸.第三类是基于学习的方法[32, 34-35], 此类方法利用移动机器人与环境长期的交互与学习, 从而提升移动机器人自主环境适应能力.随着深度学习和强化学习的不断发展, 基于学习的方法具有广阔的研究前景.

表 1对文献[7-34]中提出的方法进行了归纳和总结:针对不同类型的应用场景和其相应的环境条件变化, 国内外学者提出了相应的解决方案.尽管不同的方法存在其不足之处, 但均在相应的应用场景中取得不错的实验效果.

表 1 动态环境下长航时机器人地图构建与长期维护方法Table 1 Methods of mapping and long-term maintenance for mobile robots in dynamic environment测试场景 关键词 主要思想 局限性 文献 停车场 临时地图 用临时地图跟踪由环境中半静态物体引起的矛盾观测, 并临时地扩展环境的静态地图, 进而利用粒子滤波算法实现机器人的定位 该算法默认动态物体被成功地检测并滤除 [24] 动态栅格地图 将每个栅格定义为隐式马尔科夫模型, 利用初始状态分布和观测模型预测状态转换概率 模型假设与真实环境中的动态变化的一致性问题; 栅格与栅格之间的独立假设不合理 [23] 非马尔科夫过程; 插曲片段 释放了马尔科夫过程的独立性假设, 分析观测数据与地图中未标记的物体之间的关联; 利用关联分析将对环境的观测分为长期、短期和动态特征 依赖提前构建的地图先验信息 [26] 生产车间 独立马尔科夫链; 栅格地图 将每个栅格定义为有两个状态的独立马尔科夫链; 栅格状态转换被定义为两个泊松过程, 且转换模型参数通过在线学习获得 算法模型假设环境中的动态变化属于齐次过程, 而事实上动态变化是有时间依赖性的 [25] 正态分布变换栅格地图 结合正态分布变换地图的简洁和栅格地图的稳定来表述动态环境, 并定义了精确的栅格状态递归更新模型; 该方法可用于多分辨率地图 该方法依赖一个外部准确的定位系统 [7] 室内环境 记忆消退 利用多重时间尺度下的环境模型表述环境; 随时间推移, 新的环境模型不断更新, 旧的不断消退 需要不断地对环境进行访问和建模; 只适应渐进的环境变化 [27] 多重记忆存储模型 模仿人类多重记忆模型, 用选择机制将环境观测分为传感器记忆、临时记忆和永久记忆; 并利用永久记忆对地图进行更新维护 地图中缺少尺度度量信息, 且只考虑了环境中有限的环境变化 [28] 多重记忆存储模型/3D构图 该方法利用短期记忆和永久记忆机制, 保证只利用永久的环境信息构建地图 环境中稳定的元素需要经常被观测和识别才能加入到永久记忆中 [29] 频谱分析 利用频谱对环境中的时空动态变化进行建模; 较小的存储需求适用于大范围环境 假设人类的行为是有规律可循的, 只适用于部分情形 [30] 摘要地图 摘要地图中只保存被认为有用的路标信息 地图中有限的环境信息, 只适用于解决特定的任务 [36] 城市环境 端到端分割聚类 搭建了输入是原始点云数据、输出是分割聚类结果的端到端架构; 利用二分类解决多分类问题 只考虑了车辆、行人和自行车三类动态目标 [32] 统一的栅格环境模型 构建了新颖的基于栅格的环境模型, 其中对动静态物体及其不确定性、速度等特征进行统一建模 利用栅格地图表述城市环境, 存在栅格分辨率选择和边缘混淆问题 [33] 校园环境 无监督增量学习 利用AP聚类算法对三维点云进行聚类; 并通过机器人与环境的交互得到聚类目标是障碍的概率 该方法只判断聚类目标是否为障碍, 没有进一步估计其速度等特性 [34] 地图长期维护 构建了包含位姿估计、全局地图维护和速度估计三个模块长期定位与构图系统, 通过对环境的重复观测, 直接对三维点进行状态预测与更新 该方法假设动态目标运动平滑 [35] 2. 移动机器人长期运行中的重定位

移动机器人在长期运行中不可避免地要重复访问同一场景, 因此准确地识别历史访问场景并估计机器人在该场景中的位姿(即重定位), 是移动机器人必不可少的基本能力[44].在不依赖全局定位系统的前提下, 场景识别[45-46] (Place recognition)技术可检索出与机器人当前所处场景相同的历史访问场景, 然后利用场景配准技术可直接计算出机器人在该场景中的精确位姿, 这是实现机器人重定位的前提.但移动机器人长期运行中的鲁棒重定位对场景识别的精度提出了很高要求.

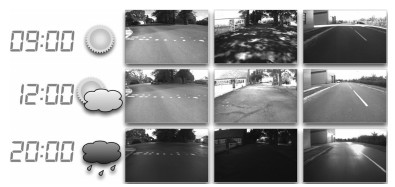

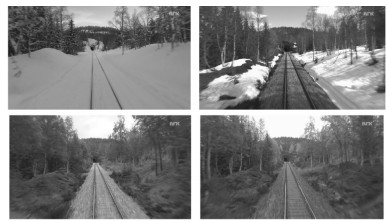

现阶段, 在条件稳定环境中的重定位研究已取得巨大的成功.令人印象最深刻的当属基于环境表象(Appearance-based)的重定位方法, 如FAB-MAP[47]和DBOW[48], 这类方法都是通过度量从环境的表象中提取的人工设计特征来实现场景匹配, 进而实现移动机器人的重定位.但开放环境中光照、天气和季节等环境条件变化会导致场景表象差异显著. 图 2摘自文献[49], 展现了不同天气条件下同一场景的表象差异; 图 3所展现的是Nordland数据集[50]中不同季节中同一场景的表象差异.这些表象差异会导致从同一场景提取的特征差异显著, 进而导致移动机器人重定位的失败.因此如何从复杂多变的场景中提取对环境条件变化鲁棒的特征[51]是实现鲁棒重定位的关键.

描述场景的特征类型多样, 按获取方式可分为人工设计特征[52] (Handcrafted features)和基于学习获得特征[53] (Learnt features); 按特征维度可分为二维图像特征和三维点云特征.考虑到点云特征种类远少于图像特征, 为了便于讨论, 本章分别从人工设计的图像特征、基于学习得到的图像特征和从三维点云中提取的三维特征这三类来综述机器人重定位自主环境适应的发展现状.

2.1 人工图像特征

尽管人工图像特征在变化的环境中不够稳定, 但考虑到其模型简洁且计算效率高, 许多学者对基于人工设计特征的方法进行改进以适应真实世界中复杂的环境条件变化.

为了应对光照条件变化, McManus等[54]将RGB图像转换为光照不变性图像(Illumination-invariant images), 并利用FAST特征检测器和BRIEF特征描述符实现场景匹配.如图 4所示[55], 该图像模型对不同的光照条件具有良好的适应性.同样, Arroyo等[56]利用光照不变性图像模型和多种人工设计的图像特征实现不同版本的基于视觉的拓扑定位方法.该方法同时利用图像序列取代单幅图像并提取全局二进制描述符来实现高效匹配. SeqSLAM[50]的作者坚信, 利用足够长的图像序列(文中在不同的数据集中图像序列长度为20或30张)来代替单幅图片可有效提升场景匹配的准确度, 提升场景识别算法对条件变化环境的适应能力, 进而提高机器人场景识别的鲁棒性.

为了应对周期性季节转换, Neubert等[57]提出一种基于学习的环境外观预测方法.自然条件下环境外观的变化呈现一定的周期性, 因此是可预测的.该方法通过学习环境外观随着时间的变化, 来预测不同条件下的环境外观.作者利用该预测方法对FAB-MAP[58]、BRIEF-Gist[59]、SeqSLAM等传统的基于人工设计图像特征的重定位算法进行了改进, 取得了显著的效果提升.实验结果表明基于环境外观预测的方法很好地适应自然条件的转变.以基于人工设计图像特征(FAST detector and BRIEF descriptor)的场景匹配算法为基础, Churchill等[49]提出了一种基于经验的定位方法.该方法将访问过的场景看作一条经验, 并利用视觉里程计将观测经验串联在一起.如果同一场景中新的外观表述没有与历史外观表述匹配成功, 则该新外观表述将被视为新的场景.通过机器人足够长时间的运行和积累, 能对同一场景不同条件下的环境模型进行有效的表述, 同时实现长航时机器人精确的重定位.但这种贪婪的方法需要尽可能多地访问同一个场景, 才能完全适应同一场景不同条件下的变化, 且在大范围开放环境中可能出现信息爆炸.

Johns等[60]对场景中的动态元素对局部特征的产生与消失的影响和特征所对应的潜在的外观进行了丰富的理论分析.作者将场景中的动态元素分为三种类别:行人、车辆等短期动态元素; 建筑物重建或季节转换对树木的影响等长期动态元素; 光照条件等重复出现和消失的周期性动态元素.分析各种动态元素对场景中局部特征的影响, 能更好地学习动态场景中的静态特性, 提升动态环境中的场景识别算法.

表 2对基于人工设计图像特征的重定位方法进行了深入的总结和分析.因为摄像头被动感知的特性, 光照条件变化和季节转换是基于视觉的重定位方法所面临的主要挑战.基于光照不变性图像的方法只能解决光照变化引起的场景差异, 而基于经验的重定位方法和基于图像序列[61]的重定位方法对光照条件和季节转换都有良好的适应性.

表 2 移动机器人基于人工设计图像特征的重定位方法Table 2 Visual methods of relocalization based on hand-crafted features for mobile robots in term of long-term autonomy目标环境 关键词 主要思想 发表年份 文献 光照/季节/环境结构变化 基于经验描述的重定位 将环境的模型表述定义为一条"经验", 利用视觉相对定位将场景的多种经验串联起来 2013 [49] 光照/季节变化 基于图像序列的重定位 利用较长的图像序列代替单幅图像实现场景匹配, 完成重定位 2012 [50] 光照条件变化 光照不变性图像 将RGB图像转换为具有光照不变性的图像, 进而利用FAST特征检测器和BRIEF特征描述符实现场景匹配 2014 [54] 光照/季节变化 光照不变性图像; 图像序列 利用光照不变性图像和图像序列等技术手段实现重定位; 同时提取全局二进制描述符来提高效率 2018 [56] 光照/季节变化 外观变化预测 鉴于自然条件下环境外观呈现周期性变化, 该方法通过预测不同条件下的环境外观来实现长期重定位 2013 [57] 光照/季节/动态因素 场景动态模型 通过分析场景中各种动态元素对局部特征的影响, 学习并利用场景中稳定的静态特征, 实现鲁棒的重定位 2013 [60] 2.2 基于学习获取图像特征

传统的场景识别方法利用基于关键点的特征盲目地对所有的存储图片进行匹配. McManus等[62]反其道而行之, 对每一个场景无监督地学习特定的特征检测器, 这使得场景识别任务变成组织一大批附有空间索引的特征检测器.传统的特征表述的是边、角点等低层面的结构, 而场景独立的(Place-dependent)的特征检测表述的是场景中像窗户、建筑物、轮廓等中等层面易识别的视觉元素, 对条件变化更加鲁棒.实验证明, 这种方法可有效提高场景识别定位算法的鲁棒性, 虽然在定位尺度度量精度上有所降低, 但是可以接受的.类似地, Linegar等[63]训练针对特定场景的线性SVM分类器来识别环境中非常有辨识度的部分.他们在牛津数据集(Oxford robotcar)近10 km的路线中做了测试, 利用定做的地标(Bespoke landmarks)来实现机器人的自主定位可在变化的环境中大大减少定位失败的几率.这种方法利用提取场景中长期稳定的特征来实现条件变化场景中的场景识别, 在缓慢变化的场景取得了很好的表现效果.

近年来, 深度学习[64-66]在图像分类和目标检测等领域取得了突破性进展, 成为目前最有效的自动特征学习方法.深度学习模型具有强大的表征和建模能力, 逐层自动学习目标的特征表示, 将原始数据经过一系列非线性变换, 生成高层次的抽象表示, 避免了手工设计特征的繁琐低效.鉴于深度学习在计算机视觉领域不可思议的成功, 将卷积网络特征应用在视觉导航或场景识别等机器人领域引起了极大的兴趣.

如图 5所示, Arroyo等[67]利用卷积神经网络(CNN)获得的卷积特征代替人工设计图像特征, 该特征融合了不同卷积层的图像信息.为了更快速地实现场景识别, 卷积特征被压缩为二进制描述符并利用汉明距离实现场景匹配.尽管卷积特征被用来提高在表象变化场景中的场景识别精度, 但是如何利用高维的卷积网络特征实现高效的场景匹配仍然是个挑战. Hou等[68]利用视觉词典算法将卷积网络特征转换为数值词典向量来实现场景的高效匹配; 同时为了解决利用词典向量实现场景匹配的感知混淆现象, 作者首先选取$ k $个候选对象, 然后利用基于哈希的投票策略来确认最优的匹配场景.

文献[69]综合评估比较了三种先进的卷积网络在场景识别中的应用.得出以下结论: 1)从卷积网络较高的卷积层获取的特征暗含场景中的语义信息, 可以通过分割搜索空间来提升场景识别的效率; 2)利用局部敏感哈希算法将卷积网络特征简化为二进制特征, 并利用二进制描述符的汉明距离来近似特征间的余弦距离, 这样可在很小的精度损失的情况下显著地提升匹配效率; 3)在解决场景识别问题时, 针对场景理解训练的卷积网络比针对目标识别训练的表现优异; 4)从卷积网络中间层提取的特征可有效应对因光照、天气或季节引起的场景外观变化, 而从最高层提取的特征对观测视角的变化具有更高的鲁棒性.

2.3 三维点云特征

虽然摄像机成本低廉且具有丰富的色彩纹理等感知信息, 但其易受到光照条件影响, 甚至在黑暗环境中失去感知能力.鉴于摄像机对光照条件敏感的特性, 许多学者利用激光雷达替代摄像机, 从数据源头解决光照条件变化对重定位算法的影响.

直接从三维点云尤其是稠密点云中提取特征并用于场景匹配, 需要很大的时间开销, 这严重影响机器人重定位的实时性.为了降低搜索时间, 文献[70]中对原始三维点云进行降采样, 利用关键点投票的方法实现亚线性时间增长的场景识别算法. Magnusson等[71]从三维点云中提取线性特征、面性特征以及球性特征, 并利用对不同类型特征的分布统计来实现场景间的高效匹配.但直接在三维空间中对点云进行处理, 时间复杂度远远超过图像的二维空间.受基于视觉的场景识别算法的启发, 文献[72-74]中将三维点云转换为二维的图像模型, 并利用基于视觉的方法来提升场景识别效率.

基于局部特征的场景识别算法易遭受环境变化的影响, 而基于全局特征的场景识别算法又易遭受观测视点的干扰. Dubé等[75]提出一种基于点云分割的场景识别算法.基于点云分割的方法在基于局部特征和基于全局特征的方法之间取得了很好的平衡, 能够做到扬二者之长避二者之短.但基于点云分割的方法依赖在大范围场景中鲁棒的分割方法, 且在停车场等环境结构频繁变化的环境中不再适用. He等[76]提出一种新颖的三维点云全局描述符用于场景识别.作者通过将点云向球体坐标内多个平面进行投影, 利用点云在各平面中的分布构造描述符.因为采用PCA技术寻找点云的主方向, 该描述符具有一定的观测位置和视角不变性.此外, 该方法只关注点云的整体分布, 并不关注细节特征, 因此可有效适应因季节变换引起的环境变化.

对移动机器人来讲, 应对环境中的人车甚至建筑物改建等结构变化是至关重要的能力.受文献[49]的启发, Maddern等[77]将基于历史经验思想扩展到基于激光的构图和定位方法.该方法通过重复访问, 收集环境中不同条件下的模型表述.同时作者提出一种基于概率的定位方法, 利用多种不同的环境模型表述实现精确定位.本文利用廉价的二维激光在牛津大学校园中长达一年的测试中实现了实时的持续改进的高精度地图构建和定位.

尽管国内外研究学者针对复杂多变的环境提出很多表现优异的场景识别算法, 但在机器人长期运行的过程中仍很难完全避免出现错误的重定位, 尤其是假阳性的误定位. Latif等[78]提出一种增量式基于一致性分析的闭环验证方法RRR (Realizing, reversing, and recovering), 利用视觉里程计的连续位姿约束与检测闭环约束之间的一致性分析来验证闭环准确性.通过移除误匹配的假阳性闭环检测结果, 可保证机器人位姿地图的准确性.

表 3对移动机器人基于三维点云的重定位方法进行了总结与对比.尽管基于三维点云的方法普遍具有光照条件不变性, 但其针对环境结构、季节转换等条件变化的方法并不成熟.复杂多变的环境中鲁棒高效的重定位方法亟待研究完善.

表 3 移动机器人基于三维点云的重定位方法Table 3 Methods of relocalization based on point clouds for mobile robots in term of long-term autonomy算法类型 主要思想 局限性 发表年份 文献 直接法 对三维点云进行降采样, 利用关键点投票的方法实现高效的场景配准 不能解决环境的结构变化 2013 [70] 特征法 从三维点云中提取线性特征、面性特征以及球性特征, 并利用对不同类型特征的分布统计来实现场景间的高效匹配 众多的参数调节, 时间成本高 2009 [71] 将三维点云转换为二维图像, 利用视觉的方法实现机器人的重定位 生成二维图像不具有视点不变性 2018 [73] 将三维点云向若干个平面投影, 统计每个平面上点的投影分布生成全局特征, 进而实现场景匹配 对季节变化敏感 2016 [76] 分割聚类 对三维点云进行分割聚类, 利用聚类目标替代特征点实现场景匹配 对车辆等可能被移动的半静态物体敏感 2017 [75] 基于经验的方法 通过对同一场景的重复观测, 捕获其在结构或外观上的变化, 进而利用基于经验的方法实现机器人的长期稳定重定位 为了捕获某一场景的所有变化, 需要不断对该场景重复访问, 代价昂贵, 在大范围场景中易造成信息爆炸 2015 [77] 2.4 小结

为提高移动机器人对环境的长期自主适应能力, 基于视觉的移动机器人重定位方法主要利用以下技术手段: 1)将视觉图像转换为具有光照不变性图像[54-56], 降低光照、天气等条件变化对场景感知的影响; 2)利用图像序列[50-56]替代单一图像来描述场景, 通过对连续图像的建模描述, 可充分利用各场景中稳定的环境特征来提高移动机器人场景描述的鲁棒性; 3)利用深度学习等机器学习方法[62-63, 67-69], 并依赖大量的人工标注数据进行训练, 从而提取对环境条件变化稳定的特征来描述场景, 进而实现移动机器人重定位对环境条件变化的自主适应能力.近年来, 随着大量图像数据集的涌现和深度学习、迁移学习等机器学习方法的不断发展, 移动机器人基于机器学习的重定位方法展现了良好的前景.

基于激光雷达的移动机器人长期运行中重定位方法主要是基于特征的方法[70-71, 75], 此类方法在三维空间对点云提取局部特征或全局特征.但特征提取过程通常需要大量的时间成本, 且不能有效应对视点和季节的转换.受深度学习在视觉领域的启发, 基于激光的端到端的移动机器人重定位方法[79]具有很大的发掘潜力.此外, 基于多元感知数据融合的移动机器人重定位方法也是今后发展的趋势.

3. 移动机器人长期自主场景理解

如何使移动机器人场景理解具有对开放环境的长期自主适应能力, 是移动机器人领域另一个极具挑战性的研究课题[80].移动机器人在长期运行中, 对环境观测的时间、视点、距离和角度的不同, 会导致同一场景或同一物体的观测表象差异显著, 这对传统场景理解方法[81-83]造成巨大的困扰.此外, 室外开放环境中存在未知性和不确定性, 环境类型、条件的多样性和不均衡还会给移动机器人场景理解带来小样本、样本类别不均衡等严峻挑战.

3.1 室内环境自主场景理解

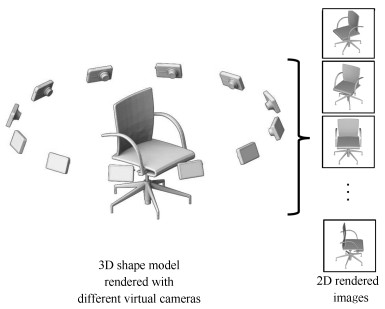

当室内服务机器人重复访问同一个房间、办公室或其他场所时, 机器人对同一环境的观测视点差异性、室内多目标间的相互遮挡等问题都对机器人进行目标检测和语义分割造成了较大影响.从图 6可以看出[84], 对同一物体不同视角的观测结果存在显著差异. Zhuang等[85]提出一种基于二维方位角(Bearing angle)图模型的室内场景三维目标检测方法, 该方法利用Gentle-AdaBoost算法训练多元分类器并提出了一种基于三维点云空间分割的尺度协调(Scale coordinate)技术进行多尺度的目标检测.为了保证检测结果的准确性, 利用语义信息剔除错误的检测结果, 进一步提高了目标检测的准确率.基于深度学习的方法[86-87]利用海量数据预训练神经网络模型, 也可有效解决视角、尺度的多样性问题, 在多目标识别和语义分割领域取得了很大成功.

在复杂的室内环境中, 移动机器人需要在不同类型的室内场景间不断切换, 因此其自主场景理解还要应对由多样化场景切换所带来的跨领域场景理解问题.为了应对跨领域特征分布差异对目标识别带来的挑战, 文献[88]提出两种在线的特征变换算法通过在线方式来学习跨领域相似性度量函数, 并结合$ k $-NN分类器实现了跨领域的多类物体识别.

移动机器人长期运行中不可避免地会引入少量新类别, 因此如何提升机器人场景理解对类不平衡问题和小样本问题的适应性成为长航时机器人自主场景理解领域的一个极具挑战性的研究课题. Zhang等[89]提出了一种跨领域的人工合成加权实例的WSMOTE-TrAdaboost算法, 通过跨领域动态合成实例和"有选择性"地进行实例迁移来再平衡目标领域中训练数据的类分布.由于基于小规模训练样本训练的分类器易于过拟合, 文献[90]通过共享方位角图碎片特征的方式联合训练多个目标检测器, 并且提出了一个基于数据采样技术的类不平衡算法, 对低置信率检测输出矩形框的再分类进一步提高了多类目标检测的准确率.

3.2 室外开放环境自主场景理解

在室外开放环境中, 移动机器人自主场景理解不仅要应对观测视角和尺度变化, 还要应对光照条件的变化甚至季节的转换.在基于深度学习的场景理解算法[64-66]成熟之前, 学者一般利用条件随机场(Conditional random field)[91]和随机森林(Random forest)等分类方法进行场景理解.传统的分类方法需要人为设计特征训练分类器, 而人为设计的特征在条件变化的环境中稳定性差, 因而导致机器人场景理解在复杂多变的真实世界中可靠性降低.

前向摄像机采集图像存在显著的尺度多样性, 如图 7所示, 近处的汽车相较远处的汽车占用图像中更多像素, 这对目标识别和语义场景理解造成巨大的挑战.为了应对图像中显著的尺度多样性, 文献[92]结合深度学习和立体视觉重构算法实现了具有尺度不变性的语义分割方法.该方法的核心在于在网络结构中添加了尺度选择层(Scale selection layer), 该层网络在与相应的立体重构深度信息相匹配的尺度上提取卷积特征.具有尺度不变性的特征表述能有效应对图像中尺度变化, 使得像素级(Pixel-level)的分类器不需要学习透视的相关规则.针对同样问题, Ansari等[93]利用量化的深度信息学习网络估计充足的深度信息, 进而利用深度信息调整分割网络中池化域的尺寸, 进而实现了具有尺度不变性的语义场景分割网络.

现阶段主流的语义场景分割方法大都利用摄像机作为主要的传感器.但因为光照、天气甚至季节的转变可能导致训练数据集和测试数据集存在巨大差异, 进而影响语义分割的精度.而作为主动感知传感器(Active sensors), 激光雷达可有效应对此类变化. Kim等[94]利用图像和三维点云联合训练语义分割网络结构, 最终输出图像的语义分割结果.作者设计了投影模块(Projection module)使得多线程(Multi-modal)网络学习2D和3D特征, 并在不同的领域将特征有效结合, 实现具有季节不变性的语义场景分割方法.

3.3 小结

移动机器人长期自主场景理解方法主要基于机器学习理论和技术.基于传统机器学习的目标分类和场景认知方法, 需要根据训练样本人为设计特征和训练分类器; 为了适应环境变化, 只有增加不同环境条件下的训练样本来训练多视角、多尺度分类器等[95].但人工设计的特征存在局限性和片面性, 并不能全面地描述目标物体, 因此基于深度学习的目标分类和场景认知方法得到了广泛的关注并取得了优越的成果.此类方法通过利用大量的标注数据, 训练端到端的深度神经网络, 跳过了特征设计环节, 充分利用了大数据的优越性.

虽然研究学者公开了许多视觉数据集, 但相对于不同的科学问题, 数据集的数量和种类仍是有限的.基于迁移学习的方法, 将现有利用大规模数据集训练的网络架构迁移应用到小规模目标数据集中, 实现对目标问题的有效解决.在未来一段时间内, 基于深度学习和迁移学习的移动机器人长期自主场景理解方法仍会占据主导地位.

表 4对文献[85-94]所列举的研究工作进行了总结与对比.随着深度学习的不断发展, 利用丰富的训练数据训练深度网络解决环境多样性的问题已日趋成熟; 同时, 迁移学习利用已有的模型映射到小样本甚至无法标注的领域, 为解决跨领域、类不平衡和小样本等问题提供了便利.

表 4 动态环境下长航时机器人自主场景理解方法Table 4 Methods of scene understanding for mobile robots in term of long-term autonomy in dynamic environment关键词 主要思想 目标问题 发表年份 文献 经典学习方法 将三维点云转换为二维图模型, 利用图像纹理和尺度协调技术解决多尺度分类问题 尺度不变性 2015 [85] 深度学习方法 利用大量训练数据训练目标识别模型, 利用训练数据的多样性解决多视角/多尺度目标识别 视角/尺度不变性 2015 [87] 结合深度学习和立体视觉重构算法实现了具有尺度不变性的语义分割方法 尺度不变性 2016 [92] 利用深度信息学习网络估计充足的深度, 进而利用深度信息调整分割网络中池化域的尺寸, 进而实现了具有尺度不变性的语义场景分割网络 尺度不变性 2018 [93] 利用图像和三维点云联合训练语义分割网络结构, 学习并结合2D和3D特征, 实现鲁棒的语义场景分割方法 光照/季节不变性 2018 [94] 迁移学习方法 提出基于在线学习的跨领域特征变换算法, 并结合$k$-NN分类器实现了跨领域的多类物体识别 跨领域多分类 2018 [88] 通过跨领域动态合成实例和"有选择性"地进行实例迁移来再平衡目标领域中训练数据的类分布 类不平衡问题 2017 [89] 通过共享碎片特征的方式联合训练多个目标检测器, 并且提出了一个基于数据采样技术的类不平衡算法, 对低置信率检测输出矩形框的再分类进一步提高了多类目标检测的准确率 类不平衡/小样本问题 2018 [90] 4. 研究重点和技术发展趋势

近年来, 得益于传感器技术、模式识别及机器学习等领域的突飞猛进, 国内外学者对移动机器人长期自主环境适应的研究展开了探索性研究工作, 并取得一些阶段性成果.尽管如此, 但仍有相当数量的基础理论和关键技术问题亟待解决.如何保证移动机器人地图构建与动态维护、重定位及场景理解等基础任务能力对复杂多变环境的长期适应性, 仍然是一个开放的问题.基于对国内外移动机器人长期自主环境适应研究现状及发展趋势的分析, 要提高移动机器人对开放环境的长期自主适应性, 需要特别考虑以下几方面问题.

4.1 传感器数据融合与信息增强

对于移动机器人来说, 单一类型的传感器难以满足其长期自主环境适应的需求.数据融合与信息增强可发挥多传感器协作环境感知的优势.现阶段激光与视觉原始数据级的融合方法已比较成熟, 但其特征级和语义级等高层次的融合方法仍处于探索阶段.近年来, 深度学习被广泛用于对图像或激光点云数据进行逐层目标特征的自动学习.但如何利用图像和激光点云数据联合训练深度学习网络, 发挥多传感器的优越性仍有待研究.通过多层次传感器数据融合得到的环境信息拥有更强大的环境表征能力, 能为机器人提供更可靠的决策依据.

4.2 迁移学习与环境适应

移动机器人需要应对外部工作环境中光照、天气、季节和观测视角等因素的干扰和影响.不同条件环境下, 同一场景或同一物体的特征分布存在明显差异.近年来, 用于移动机器人长期验证的数据集较少, 目前只有Nordland[50]、CMU[96]、Oxford[97]和NCLT[98]等几个数据集能提供不同季节的环境感知数据.此外, 这些数据集涵盖的环境类型很有限, 如Nordland只记录了火车轨道附近的野外环境, 而CMU、Oxford和NCLT数据集记录的只是校园准结构化环境数据.基于这些有限的数据集进行深度网络训练, 不足以保证移动机器人具有对开放环境适应能力的鲁棒性.因此, 利用迁移学习将从有限数据集训练获得的知识迁移到开放环境的不同场景和不同任务中, 能有效增强移动机器人的长期自主环境适应能力.

激光雷达测距和视觉感知是长航时移动机器人常用的两种外部环境感知手段.相比视觉传感器被动的环境感知方式, 激光雷达可实现主动的高精度测距, 且不受光照变化影响.此外, 激光雷达还可以降低因季节改变导致的植被颜色变化对环境特征的影响.但受硬件成本及采集难度的影响, 激光点云数据集的规模远低于图像数据集, 可用于移动机器人长期自主环境适应测试的数据集更是寥寥无几.虽然现有的深度图、强度图、方位角图等[99]模型可将三维点云转换为二维图像化的表述方式, 但由于上述模型与传统视觉图像的生成方式不同, 从而造成各自的特征空间分布存在很大差异.若能将基于传统视觉图像训练所得知识迁移到基于三维点云的物体检测、场景语义分割或场景识别等任务中, 则可解决因训练样本不足而导致的模型性能退化问题, 将极大提高机器人对开放环境的适应性.

4.3 深层次语义信息挖掘与关联

现实世界中的物体都拥有独特的属性, 且不同物体间存在着一定的联系.随着深度学习技术的发展, 移动机器人的场景认知能力得到了很大的提升, 但现阶段大部分开放环境中的场景认知研究工作仍停留在物体检测与场景语义分割的层面.场景中物体间基于属性的关联(如桌椅间的功能性关联、电脑主机与显示器间的依赖性关联), 以及人与人之间社交性的关联, 均有待进一步挖掘.此外, 场景类别与场景中物体种类及布局间的关联存在一定的规律性, 如卧室中通常有床和衣柜, 厨房中通常有烟机灶具和厨具, 花园环境中通常有大量的树木和花草, 停车场环境中通常停有大量的汽车等.

在对场景中的物体进行精确识别的基础上, 通过对物体与物体间、物体与场景间的关联进行挖掘与分析, 可使机器人获得场景类别层面的认知, 进而有针对性地选取与场景认知结果相对应的模型与参数, 用于重定位与场景理解等任务.以厂区、社区中的长航时安防巡逻机器人为例, 通过分析环境中车辆、建筑和植被等不同种类景物的数量和分布, 可有效识别停车场、花园、居民区、厂房等具有特殊意义的场景类别, 进而有针对性地完成指定任务.

4.4 高仿真测试环境与长航时训练

要使移动机器人具备稳定的长期自主环境适应能力, 必须进行长时间的测试. Google、Uber等公司的无人车进行不间断的路测, 就是要提高其对环境的长期自主适应能力.但移动机器人在真实环境中进行长时间的实测需要大量的人力物力, 同时可能会承担昂贵的实测风险与代价.现阶段, 许多功能强大的实景仿真软件, 如Carla[100]、Deepdrive[101]、AirSim和AutoSim, 为移动机器人自主行为模型的训练与测试提供了便利.

以Carla为例, 该仿真软件主要用于城市环境中移动机器人系统的构建、训练以及验证.该平台可模仿真实城市环境中的建筑、植被、行驶车辆和行人等主要组成元素, 并支持环境中不同光照和天气条件的设置. 图 8展示了Carla平台中不同天气条件下的城市仿真场景, 可以看出其具有很高的仿真效果.此外, 平台中搭建的机器人系统支持视觉、激光传感器的灵活配置, 并能实现传感器数据的实时获取, 同时可获取场景中真实的深度信息及像素级语义标注.如图 9所示, Carla平台中虚拟机器人实时获取的视觉图像、深度图像及像素级语义标注等数据具有非常高的质量.基于Carla平台, 移动机器人可充分利用其城市高仿环境进行长期的自主环境适应训练与测试. Carla的更详细的信息参见http://carla.org/.

4.5 增量式终生学习

仿真软件虽具有很高的仿真效果, 但仿真环境并不能完全反映真实开放环境的复杂变化.移动机器人长期自主环境适应能力要接受真实环境的终生考验.在验证过程中, 机器人应充分利用在线获取的真实环境数据及其与环境的交互学习, 不断优化其自主行为模型以提高对开放环境的适应能力.此外, 学习过程应该是终生的(Life-long), 要覆盖移动机器人所有的工作时间.机器人在长期运行中会积累大量在线获取数据, 这些数据具有非常好的时效性, 但机器人只能获取如可行区域、不可行区域等简单粗略的标注信息, 如何充分利用机器人弱标注的在线获取数据进行有效的学习是机器人终生学习的难点, 也是使机器人具有长期自主环境适应能力的关键.

5. 结束语

本文重点从地图构建与动态维护、重定位及场景理解等移动机器人基本的任务能力综述入手, 对国内外移动机器人长期自主环境适应的研究现状进行了详细的梳理和评述, 并对其未来的发展趋势进行了展望.

-

表 1 文中叙述的部分基于事件相机的SLAM算法及应用

Table 1 Event-based SLAM algorithms and applications

相关文献 所使用传感器 维度 算法类型 是否需要输入地图 发表时间 (年) [44] DVS 2D 定位 是 2012 [45] DVS 2D 定位与建图 否 2013 [47] DVS 3D 定位 是 2014 [48] DVS 3D 定位与建图 否 2016 [49] DVS 3D 定位与建图 否 2016 [51] DVS 3D 定位 是 2019 [52] DVS, 灰度相机 3D 定位 否 2014 [53] DVS, RGB-D相机 3D 定位与建图 否 2014 [55] DAVIS 3D 定位 否 2016 [56] DAVIS (内置IMU) 3D 定位 否 2017 [59] DAVIS (内置IMU) 3D 定位与建图 否 2017 [64] DAVIS (内置IMU), RGB相机 3D 定位与建图 否 2018 [65] DAVIS (内置IMU) 3D 定位 否 2018 表 2 DVS公开数据集

Table 2 Dataset provided by event cammera

相关文献 所使用传感器 相机运动自由度 数据采集场景 载具 是否提供真值 发表时间(年) [53] eDVS相机, RGB-D相机 6DOF 室内 手持 是 2014 [28] DAVIS (内置IMU) 3DOF(纯旋转) 室内, 仿真 旋转基座 是 2016 [68] DAVIS, RGB-D相机 4DOF 室内, 仿真 地面机器人和云台 是 2016 [69] DAVIS (内置IMU) 6DOF 室内 室外 仿真 手持 室内: 是 室外: 否 仿真: 是 2016 [70] DAVIS 6DOF 室外 汽车 是 2017 [71] 2×DAVIS (内置IMU) 2×RGB相机 (内置IMU) 16线激光雷达 6DOF 室内 室外 室内

到室外四轴飞行器 摩托车 汽车 手持 是 2018 [72] 2×DAVIS (内置IMU) RGB-D相机 3DOF 室内 3×地面机器人 是 2018 [73] DAVIS 6DOF 室内 手持 是 2019 [51] DAVIS, IMU 6DOF 室内, 仿真 手持 是 2019 -

[1] Burri M, Oleynikova H, Achtelik M W, Siegwart R. Realtime visual-inertial mapping, re-localization and planning onboard MAVs in unknown environments. In: Proceedings of the 2015 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Hamburg, Germany: IEEE, 2015. 1872−1878 [2] Chatila R, Laumond J P. Position referencing and consistent world modeling for mobile robots. In: Proceedings of the 1985 IEEE International Conference on Robotics and Automation. Louis, Missouri, USA: IEEE, 1985. Vol. 2: 138−145 [3] Chatzopoulos D, Bermejo C, Huang Z, P Hui. Mobile augmented reality survey: From where we are to where we go. IEEE Access, 2017, 5: 6917−6950 doi: 10.1109/ACCESS.2017.2698164 [4] Taketomi T, Uchiyama H, Ikeda S. Visual SLAM algorithms: a survey from 2010 to 2016. Transactions on Computer Vision and Applications, 2017, 9(1): 16 doi: 10.1186/s41074-017-0027-2 [5] Strasdat H, Montiel J M M, Davison A J. Visual SLAM: Why filter? Image and Vision Computing, 2012, 30(2): 65−77 doi: 10.1016/j.imavis.2012.02.009 [6] Younes G, Asmar D, Shammas E, J Zelek. Keyframe-based monocular SLAM: Design, survey, and future directions. Robotics and Autonomous Systems, 2017, 98: 67−88 doi: 10.1016/j.robot.2017.09.010 [7] Olson C F, Matthies L H, Schoppers M, Maimore M W. Rover navigation using stereo ego-motion. Robotics and Autonomous Systems, 2003, 43(4): 215−229 doi: 10.1016/S0921-8890(03)00004-6 [8] Zhang Z. Microsoft kinect sensor and its effect. IEEE Multimedia, 2012, 19(2): 4−10 doi: 10.1109/MMUL.2012.24 [9] Huang A S, Bachrach A, Henry P, et al. Visual odometry and mapping for autonomous flight using an RGB-D camera. Robotics Research. Springer, Cham, 2017: 235−252 [10] Jones E S, Soatto S. Visual-inertial navigation, mapping and localization: A scalable real-time causal approach. The International Journal of Robotics Research, 2011, 30(4): 407−430 doi: 10.1177/0278364910388963 [11] Martinelli A. Vision and IMU data fusion: Closed-form solutions for attitude, speed, absolute scale, and bias determination. IEEE Transactions on Robotics, 2011, 28(1): 44−60 [12] Klein G, Murray D. Parallel tracking and mapping for small AR workspaces. In: Proceedings of the 6th IEEE and ACM International Symposium on Mixed and Augmented Reality. Nara, Japan: IEEE, 2007. 1−10 [13] Mur-Artal R, Montiel J M M, Tardos J D. ORB-SLAM: A versatile and accurate monocular SLAM system. IEEE Transactions on Robotics, 2015, 31(5): 1147−1163 doi: 10.1109/TRO.2015.2463671 [14] Mur-Artal R, Tardós J D. Orb-slam2: An open-source slam system for monocular, stereo, and rgb-d cameras. IEEE Transactions on Robotics, 2017, 33(5): 1255−1262 doi: 10.1109/TRO.2017.2705103 [15] Forster C, PizzoliM, Scaramuzza D. SVO: Fast semi-direct monocular visual odometry. In: Proceedings of the 2014 IEEE international conference on robotics and automation (ICRA). Hong Kong, China: IEEE, 2014. 15−22 [16] Engel J, Schops T, Cremers D. LSD-SLAM: Large-scale direct monocular SLAM. In: Proceedings of the 2014 European conference on computer vision. Zurich, Switzerland: Springer, 2014. 834−849 [17] Engel J, Stückler J, Cremers D. Large-scale direct SLAM with stereo cameras. In: Proceedings of the 2015 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Hamburg, Germany: IEEE, 2015. 1935−1942 [18] Li M, Mourikis A I. High-precision, consistent EKFbased visual-inertial odometry. The International Journal of Robotics Research, 2013, 32(6): 690−711 doi: 10.1177/0278364913481251 [19] Leutenegger S, Lynen S, Bosse M, Siegwart R, Furgale P. Keyframe-based visual inertial odometry using nonlinear optimization. The International Journal of Robotics Research, 2015, 34(3): 314−334 doi: 10.1177/0278364914554813 [20] Qin T, Li P, Shen S. Vins-mono: A robust and versatile monocular visual-inertial state estimator. IEEE Transactions on Robotics, 2018, 34(4): 1004−1020 doi: 10.1109/TRO.2018.2853729 [21] Fossum E R. CMOS image sensors: Electronic camera-ona-chip. IEEE Transactions on Electron Devices, 1997, 44(10): 1689−1698 doi: 10.1109/16.628824 [22] Delbruck T. Neuromorophic vision sensing and processing. In: Proceedings of the 46th European SolidState Device Research Conference (ESSDERC). Lansanne, Switzerland: IEEE, 2016. 7−14 [23] Delbruck T, Lichtsteiner P. Fast sensory motor control based on event-based hybrid neuromorphic-procedural system. In: Proceedings of the IEEE International Symposium on Circuits and Systems. New Orleans, USA: IEEE, 2007. 845−848 [24] Delbruck T, Lang M. Robotic goalie with 3 ms reaction time at 4% CPU load using event-based dynamic vision sensor. Frontiers in Neuroscience, 2013, 7: 223 [25] Glover A, Bartolozzi C. Event-driven ball detection and gaze fixation in clutter. In: Proceedings of the 2016 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Daejeon, Korea: IEEE, 2016. 2203−2208 [26] Benosman R, Ieng S H, Clercq C, Bartolozzi C, Srinivasan M. Asynchronous frameless event-based optical flow. Neural Networks, 2012, 27: 32−37 doi: 10.1016/j.neunet.2011.11.001 [27] Benosman R, Clercq C, Lagorce X, leng S H, Bartolozzi C. Event-based visual flow. IEEE Transactions on Neural Networks and Learning Systems, 2013, 25(2): 407−417 [28] Rueckauer B, Delbruck T. Evaluation of event-based algorithms for optical flow with ground-truth from inertial measurement sensor. Frontiers in Neuroscience, 2016, 10: 176 [29] Bardow P, Davison A J, Leutenegger S. Simultaneous optical flow and intensity estimation from an event camera. In: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. LAS VEGAS, USA: IEEE, 2016. 884−892 [30] Reinbacher C, Graber G, Pock T. Real-time intensityimage reconstruction for event cameras using manifold regularisation. International Journal of Computer Vision, 2018, 126(12): 1381−1393 doi: 10.1007/s11263-018-1106-2 [31] Mahowald M. VLSI analogs of neuronal visual processing: A synthesis of form and function. California Institute of Technology, 1992. [32] Posch C, Serrano-Gotarredona T, Linares-Barranco B, Delbruck T. Retinomorphic event-based vision sensors: Bioinspired cameras with spiking output. Proceedings of the IEEE, 2014, 102(10): 1470−1484 doi: 10.1109/JPROC.2014.2346153 [33] Lichtsteiner P, Posch C, Delbruck T. A 128×128 120 db 30 mw asynchronous vision sensor that responds to relative intensity change. In: Proceedings of the 2006 IEEE International Solid State Circuits Conference-Digest of Technical Papers. San Francisco, CA, USA: IEEE, 2006. 2060−2069 [34] Lichtsteiner P, Posch C, Delbruck T. A 128×128 120 dB 15 μs Latency Asynchronous Temporal Contrast Vision Sensor. IEEE Journal of Solid-State Circuits, 2008, 43(2): 566−576 doi: 10.1109/JSSC.2007.914337 [35] Son B, Suh Y, Kim S, et al. 4. 1 A 640×480 dynamic vision sensor with a 9 μm pixel and 300 Meps address-event representation. In: Proceedings of the 2017 IEEE International Solid-State Circuits Conference (ISSCC). San Francisco, CA, USA: IEEE, 2017. 66−67 [36] Posch C, Matolin D, Wohlgenannt R. A QVGA 143 dB Dynamic Range Frame-Free PWM Image Sensor With Lossless Pixel-Level Video Compression and Time-Domain CDS. IEEE Journal of Solid-State Circuits, 2010, 46(1): 259−275 [37] Posch C, Matolin D, Wohlgenannt R. A QVGA 143 dB dynamic range asynchronous address-event PWM dynamic image sensor with lossless pixel-level video compression. In: Proceedings of the 2010 IEEE International Solid-State Circuits Conference-(ISSCC). San Francisco, CA, USA: IEEE, 2010. 400−401 [38] Berner R, Brandli C, Yang M, Liu S C, Delbruck T. A 240×180 120 db 10 mw 12 us-latency sparse output vision sensor for mobile applications. In: Proceedings of the International Image Sensors Workshop. Snowbird, Utah, USA: IEEE, 2013. 41−44 [39] Brandli C, Berner R, Yang M, Liu S C, Delbruck T. A 240×180 130 db 3 μs latency global shutter spatiotemporal vision sensor. IEEE Journal of Solid-State Circuits, 2014, 49(10): 2333−2341 doi: 10.1109/JSSC.2014.2342715 [40] Guo M, Huang J, Chen S. Live demonstration: A 768×640 pixels 200 Meps dynamic vision sensor. In: Proceedings of the 2017 IEEE International Symposium on Circuits and Systems (ISCAS). Baltimore, Maryland, USA: IEEE, 2017. 1−1 [41] Li C, Brandli C, Berner R, et al. Design of an RGBW color VGA rolling and global shutter dynamic and active-pixel vision sensor. In: Proceedings of the 2015 IEEE International Symposium on Circuits and Systems (ISCAS). Liston, Portulgal: IEEE, 2015. 718−721 [42] Moeys D P, Li C, Martel J N P, et al. Color temporal contrast sensitivity in dynamic vision sensors. In: Proceedings of the 2017 IEEE International Symposium on Circuits and Systems (ISCAS). Baltimore, Maryland, USA: IEEE, 2017. 1−4 [43] Marcireau A, Ieng S H, Simon-Chane C, Benosman R B. Event-based color segmentation with a high dynamic range sensor. Frontiers in Neuroscience, 2018, 12: 135 doi: 10.3389/fnins.2018.00135 [44] Weikersdorfer D, Conradt J. Event-based particle filtering for robot self-localization. In: Proceedings of the 2012 IEEE International Conference on Robotics and Biomimetics (ROBIO). Guangzhou, China: IEEE, 2012. 866−870 [45] Weikersdorfer D, Hoffmann R, Conradt J. Simultaneous localization and mapping for event-based vision systems. In: Proceedings of the 2013 International Conference on Computer Vision Systems. St. Petersburg, Russia: Springer, 2013. 133−142 [46] Hoffmann R, Weikersdorfer D, Conradt J. Autonomous indoor exploration with an event-based visual SLAM system. In: Proceedings of the 2013 European Conference on Mobile Robots. Barcelona, Catalonia, Spain: IEEE, 2013. 38−43 [47] Mueggler E, Huber B, Scaramuzza D. Event-based, 6-DOF pose tracking for high-speed maneuvers. In: Proceedings of the 2014 IEEE/RSJ International Conference on Intelligent Robots and Systems. Chicago, USA: IEEE, 2014. 2761−2768 [48] Kim H, Leutenegger S, Davison A J. Real-time 3D reconstruction and 6-DoF tracking with an event camera. In: Proceedings of the 2016 European Conference on Computer Vision. Amsterdam, The Netherlands: Springer, 2016. 349−364 [49] Rebecq H, Horstschafer T, Gallego G, Scaramuzza D. EVO: A geometric approach to event-based 6-DOF parallel tracking and mapping in real time. IEEE Robotics and Automation Letters, 2016, 2(2): 593−600 [50] Rebecq H, Gallego G, Scaramuzza D. EMVS: Event-based multi-view stereo. In: Proceedings of the 2016 British Machine Vision Conference (BMVC). York, UK: Springer, 2016(CONF). [51] Bryner S, Gallego G, Rebecq H, Scaramuzza D. Eventbased, direct camera tracking from a photometric 3D map using nonlinear optimization. In: the 2019 International Conference on Robotics and Automation. Montreal, Canada: IEEE, 2019. 2 [52] Censi A, Scaramuzza D. Low-latency event-based visual odometry. In: Proceedings of the 2014 IEEE International Conference on Robotics and Automation (ICRA). Hong Kong, China: IEEE, 2014. 703−710 [53] Weikersdorfer D, Adrian D B, Cremers D, Conradt J. Eventbased 3D SLAM with a depth-augmented dynamic vision sensor. In: Proceedings of the 2014 IEEE International Conference on Robotics and Automation (ICRA). Hong Kong, China: IEEE, 2014. 359−364 [54] Tedaldi D, Gallego G, Mueggler E, Scaramuzza D. Feature detection and tracking with the dynamic and active-pixel vision sensor (DAVIS). In: Proceedings of the 2016 Second International Conference on Event-based Control, Communication, and Signal Processing (EBCCSP). Krakow, Poland: IEEE, 2016. 1−7 [55] Kueng B, Mueggler E, Gallego G, Scaramuzza D. Lowlatency visual odometry using event-based feature tracks. In: Proceedings of the 2016 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Daejeon, Korea: IEEE, 2016. 16−23 [56] Zhu A Z, Atanasov N, Daniilidis K. Event-based visual inertial odometry. In: Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, Hawaii, USA: IEEE, 2017. 5816−5824 [57] Zhu A Z, Atanasov N, Daniilidis K. Event-based feature tracking with probabilistic data association. In: Proceedings of the 2017 IEEE International Conference on Robotics and Automation (ICRA). Marina Bay, Singapore: IEEE, 2017. 4465−4470 [58] Mourikis A I, Roumeliotis S I. A multi-state constraint Kalman filter for vision-aided inertial navigation. In: Proceedings of the 2007 IEEE International Conference on Robotics and Automation (ICRA). Roma, Italy: IEEE, 2007. 3565−3572 [59] Rebecq H, Horstschaefer T, Scaramuzza D. Real-time Visual-Inertial Odometry for Event Cameras using Keyframe-based Nonlinear Optimization. In: Proceedings of the 2017 British Machine Vision Conference (BMVC). London, UK: Springer, 2017(CONF). [60] Gallego G, Scaramuzza D. Accurate angular velocity estimation with an event cameras. IEEE Robotics and Automation Letters, 2017, 2(2): 632−639 doi: 10.1109/LRA.2016.2647639 [61] Rosten E, Drummond T. Machine learning for high-speed corner detection. In: Proceedings of the 2006 European Conference on Computer Vision. Graz, Austria: Springer, 2006. 430−443 [62] Lucas B D, Kanade T. An Iterative Image Registration Technique with An Application to Stereo Vision. 1981. 121−130 [63] Leutenegger S, Furgale P, Rabaud V, et al. Keyframe-based visual-inertial slam using nonlinear optimization. In: Proceedings of the 2013 Robotis Science and Systems (RSS). Berlin, German, 2013. [64] Vidal A R, Rebecq H, Horstschaefer T, Scaramuzza D. Ultimate SLAM? Combining events, images, and IMU for robust visual SLAM in HDR and high-speed scenarios. IEEE Robotics and Automation Letters, 2018, 3(2): 994−1001 doi: 10.1109/LRA.2018.2793357 [65] Mueggler E, Gallego G, Rebecq H, Scaramuzza D. Continuous-time visual-inertial odometry for event cameras. IEEE Transactions on Robotics, 2018, 34(6): 1425−1440 doi: 10.1109/TRO.2018.2858287 [66] Mueggler E, Gallego G, Scaramuzza D. Continuous-time trajectory estimation for event-based vision sensors. In: Proceedings of Robotics: Science and Systems XI (RSS). Rome, Italy: 2015. DOI: 10.15607/RSS.2015.XI.036 [67] Patron-Perez A, Lovegrove S, Sibley G. A spline-based trajectory representation for sensor fusion and rolling shutter cameras. International Journal of Computer Vision, 2015, 113(3): 208−219 doi: 10.1007/s11263-015-0811-3 [68] Barranco F, Fermuller C, Aloimonos Y, Delbruck T. A dataset for visual navigation with neuromorphic methods. Frontiers in Neuroscience, 2016, 10: 49 [69] Mueggler E, Rebecq H, Gallego G, Delbruck T, Scaramuzza D. The event-camera dataset and simulator: Event-based data for pose estimation, visual odometry, and SLAM. The International Journal of Robotics Research, 2017, 36(2): 142−149 doi: 10.1177/0278364917691115 [70] Binas J, Neil D, Liu S C, Delbruck T. DDD17: End-to-end DAVIS driving dataset. arXiv: 1711. 01458, 2017 [71] Zhu A Z, Thakur D, Ozaslan T, Pfrommer B, Kumar V, Daniilidis K. The multivehicle stereo event camera dataset: An event camera dataset for 3D perception. IEEE Robotics and Automation Letters, 2018, 3(3): 2032−2039 doi: 10.1109/LRA.2018.2800793 [72] Leung S, Shamwell E J, Maxey C, Nothwang W D. Toward a large-scale multimodal event-based dataset for neuromorphic deep learning applications. In: Proceedings of the 2018 Micro-and Nanotechnology Sensors, Systems, and Applications X. International Society for Optics and Photonics. Orlando, Florida, USA: SPIE, 2018. 10639: 106391T [73] Mitrokhin A, Ye C, Fermuller C, Aloimonos Y, Delbruck T. EV-IMO: Motion segmentation dataset and learning pipeline for event cameras. arXiv: 1903. 07520, 2019 期刊类型引用(37)

1. 张胜男. 基于SLAM下温室自主导航系统的设计与试验. 农机化研究. 2025(03): 82-88 .  百度学术

百度学术2. 蒋华扬,吴涛,李明烁,孙家辉,任建鑫. 基于LADRC的四轮全向Mecanum轮机器人运动控制研究. 现代电子技术. 2024(06): 165-170 .  百度学术

百度学术3. 代君,王敬宇,闵君,陈旭,赵黎龙,张春凤. 未知环境下GNSS辅助视觉自主定位方法. 郑州航空工业管理学院学报. 2024(02): 65-71 .  百度学术

百度学术4. 周霆威,乔贵方,刘娣,付冬梅,张颖. 基于IMU在线校准的SLAM精度提升方法研究. 仪表技术与传感器. 2024(03): 1-5 .  百度学术

百度学术5. 卓越,赖志芳,张铭,王悦新. 基于机器视觉的智能搬运小车. 电子产品世界. 2024(03): 14-18 .  百度学术

百度学术6. 冯婧,魏航信,岳高峰,王煜坤,秦乐,席文奎,孙文. 移动机器人多传感器数据融合方法研究. 现代制造工程. 2024(07): 69-76 .  百度学术

百度学术7. 刘小松,魏昌斌,单泽涛,单泽彪,刘云清. 基于扩张状态观测器的里程计定位补偿无人车轨迹跟踪控制. 仪器仪表学报. 2024(07): 313-320 .  百度学术

百度学术8. 邓超,龙腾,袁希文,李程. 矿卡自动驾驶场景全局栅格地图构建与更新方法研究. 控制与信息技术. 2024(06): 12-18 .  百度学术

百度学术9. 周琪,张谦述,张耀进. 改进蚁群算法在多目标下路径长度的研究. 邵阳学院学报(自然科学版). 2023(01): 32-38 .  百度学术

百度学术10. 代君,郝向阳,刘松林,肖鹏,任宗彬. 复杂环境下无人车双重自适应定位算法. 中国惯性技术学报. 2023(03): 254-260 .  百度学术

百度学术11. 韩哲,徐元强,张德生,赵全文,杜明,李慧,周杰,张帅,刘杰,高健勋,温存宝,周翔,赵凯. 无反复支撑超前支护智能控制系统. 工矿自动化. 2023(04): 141-146+152 .  百度学术

百度学术12. 沈智鹏,丁文娜,刘雨宸,于浩淼. 基于改进自适应蚁群算法的无人帆船路径规划. 哈尔滨工程大学学报. 2023(06): 969-976 .  百度学术

百度学术13. 万琴,李智,李伊康,葛柱,王耀南,吴迪. 基于改进YOLOX的移动机器人目标跟随方法. 自动化学报. 2023(07): 1558-1572 .  本站查看

本站查看14. 朱东莹,钟勇,杨观赐,李杨. 动态环境下视觉定位与建图的运动分割研究进展. 计算机应用. 2023(08): 2537-2545 .  百度学术

百度学术15. 白玉静. 移动机器人控制系统的设计. 机械管理开发. 2023(08): 184-185+188 .  百度学术

百度学术16. 阮晓钢,陈晓,朱晓庆. 基于多重信息增益的移动机器人探索策略. 北京工业大学学报. 2023(09): 990-998 .  百度学术

百度学术17. 金龙,李嘉昌,常振强,卢经纬,程龙. 基于ACP理论的微型扑翼飞行器的姿态控制. 自动化学报. 2023(12): 2532-2543 .  本站查看

本站查看18. 徐翔斌,马中强. 基于移动机器人的拣货系统研究进展. 自动化学报. 2022(01): 1-20 .  本站查看

本站查看19. 李东,洪涛,张波涛. 一种机器人的栅格-语义地图构建方法. 杭州电子科技大学学报(自然科学版). 2022(02): 21-26+63 .  百度学术

百度学术20. 马龙,孙汉旭,李明刚,孙萍,张维振,龙秉政,史慧文. 质心径向可变球形机器人的设计与运动分析. 机械工程学报. 2022(05): 44-56 .  百度学术

百度学术21. 刘加奇,王泰华,董征. 基于改进蚁群算法的移动机器人路径规划. 传感器与微系统. 2022(05): 140-143 .  百度学术

百度学术22. 陈远浩,吴明晖. 基于回波强度的AGV重定位方法研究. 智能计算机与应用. 2022(08): 179-182+186 .  百度学术

百度学术23. 钟宏伟,于亮,张耀匀,苏保强,袁珊珊. 基于人工智能技术的流程机器人自动控制系统. 机械制造与自动化. 2022(04): 211-214+228 .  百度学术

百度学术24. 万泽宇,丁朝阳,王怡阳,郭与时,牛丽婷,张惟宜,张春. 同步定位与建图技术的发展现状. 微纳电子与智能制造. 2022(02): 22-45 .  百度学术

百度学术25. 秦瑞琳,周昌乐,晁飞. 机器意识研究综述. 自动化学报. 2021(01): 18-34 .  本站查看

本站查看26. 王昕煜,平雪良. 基于多传感器融合信息的移动机器人速度控制方法. 工程设计学报. 2021(01): 63-71 .  百度学术

百度学术27. 焦传佳,江明. 基于AprilTag图像识别的移动机器人定位研究. 电子测量与仪器学报. 2021(01): 110-119 .  百度学术

百度学术28. 杨梓桐,王书亭,孟杰,蒋立泉,谢远龙. 基于特征热力图的移动机器人高效全局定位方法. 机器人. 2021(02): 156-166 .  百度学术

百度学术29. 丁坤,王立,张经炜,李辰阳,翁帅. 基于改进导航圆算法的光伏阵列清扫机器人路径跟踪控制. 河海大学学报(自然科学版). 2021(02): 190-196 .  百度学术

百度学术30. 阮晓钢,柴洁,武悦,张晓平,黄静. 基于海马体位置细胞的认知地图构建与导航. 自动化学报. 2021(03): 666-677 .  本站查看

本站查看31. 孙辉辉,胡春鹤,张军国. 移动机器人运动规划中的深度强化学习方法. 控制与决策. 2021(06): 1281-1292 .  百度学术

百度学术32. 杨蕴秀,韩宝玲,罗霄. 移动机器人同时定位与建图室内导航地图研究. 科学技术与工程. 2021(18): 7597-7603 .  百度学术

百度学术33. 杨傲雷,金宏宙,陈灵,费敏锐. 融合深度学习与粒子滤波的移动机器人重定位方法. 仪器仪表学报. 2021(07): 226-233 .  百度学术

百度学术34. 吴建清,宋修广. 同步定位与建图技术发展综述. 山东大学学报(工学版). 2021(05): 16-31 .  百度学术

百度学术35. 邓绘梅. DSC-SSD在政务服务机器人场景理解中的应用. 佳木斯大学学报(自然科学版). 2021(05): 144-147 .  百度学术

百度学术36. 包加桐,杨圣奥,朱润辰,唐鸿儒,宋爱国. 视觉与激光结合的室内移动机器人重定位方法. 中国测试. 2021(11): 1-7+20 .  百度学术

百度学术37. 张辉,王耀南,易俊飞,钟杭,刘理,缪志强,江一鸣. 面向重大疫情应急防控的智能机器人系统研究. 中国科学:信息科学. 2020(07): 1069-1090 .  百度学术

百度学术其他类型引用(81)

-

下载:

下载:

下载:

下载: