-

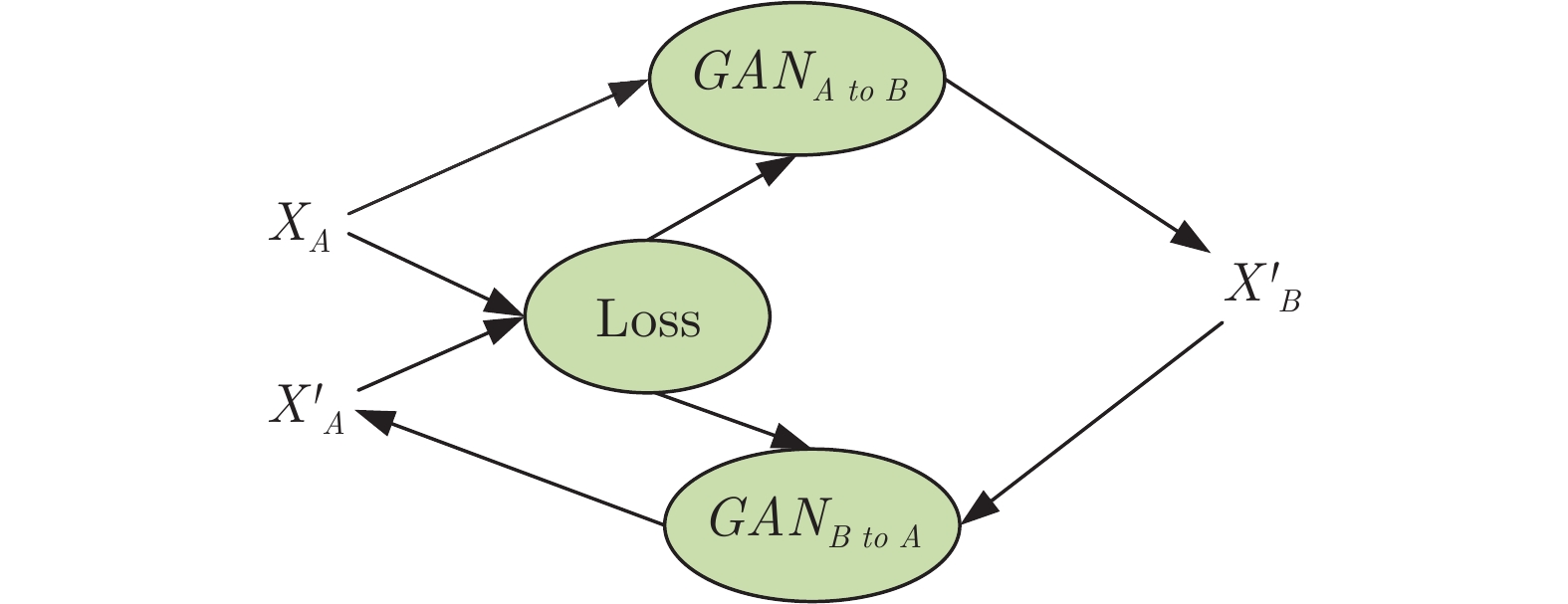

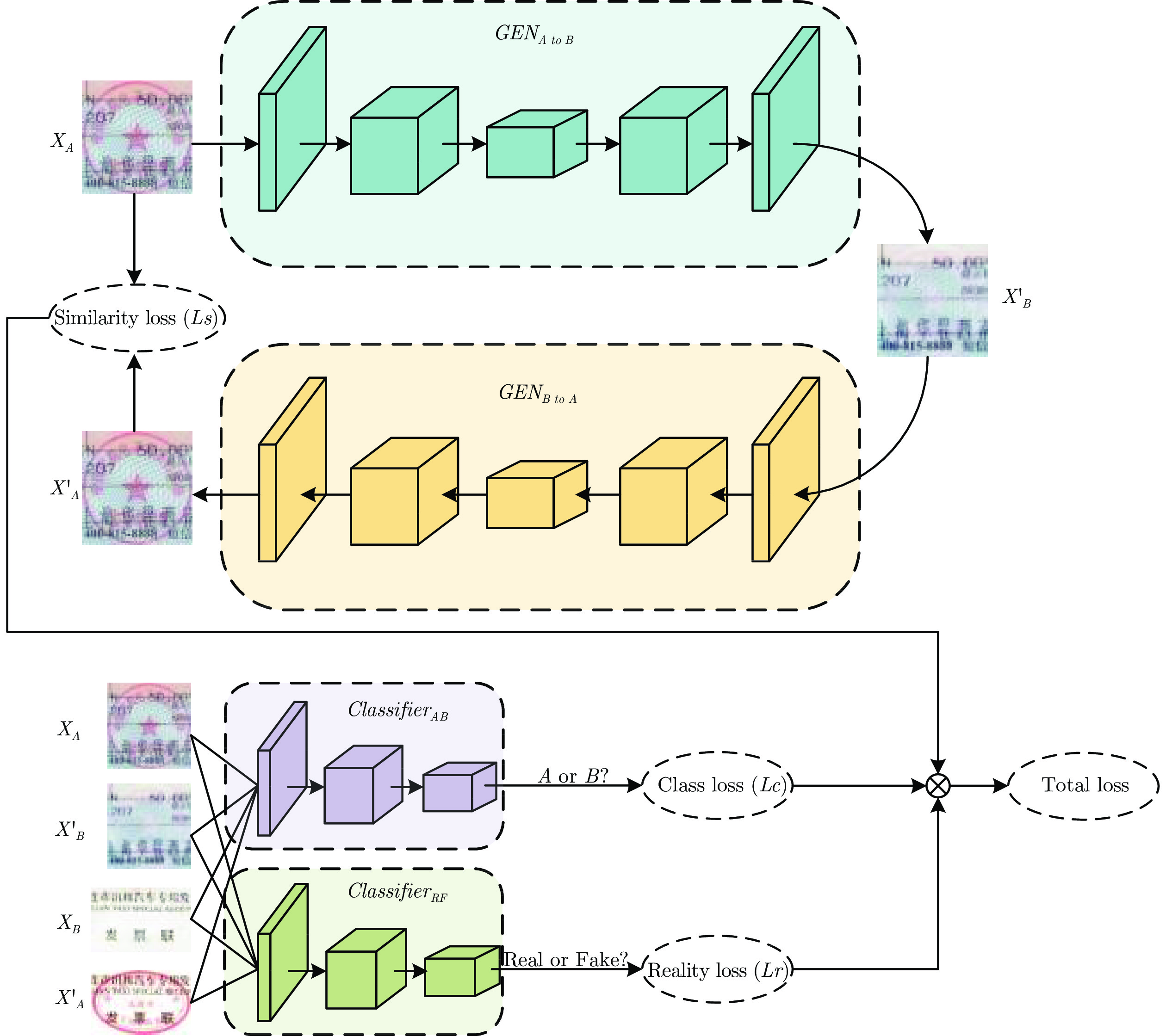

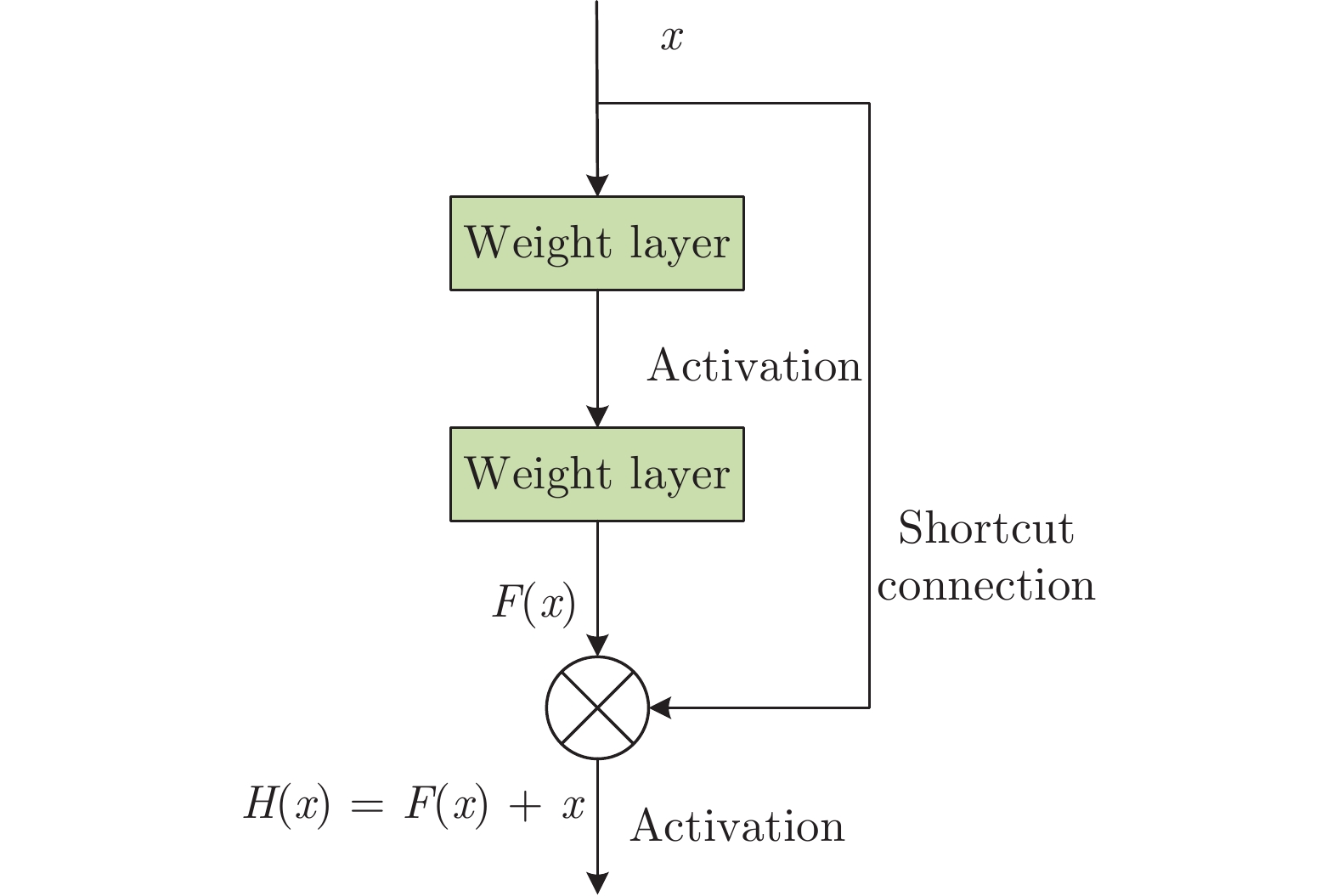

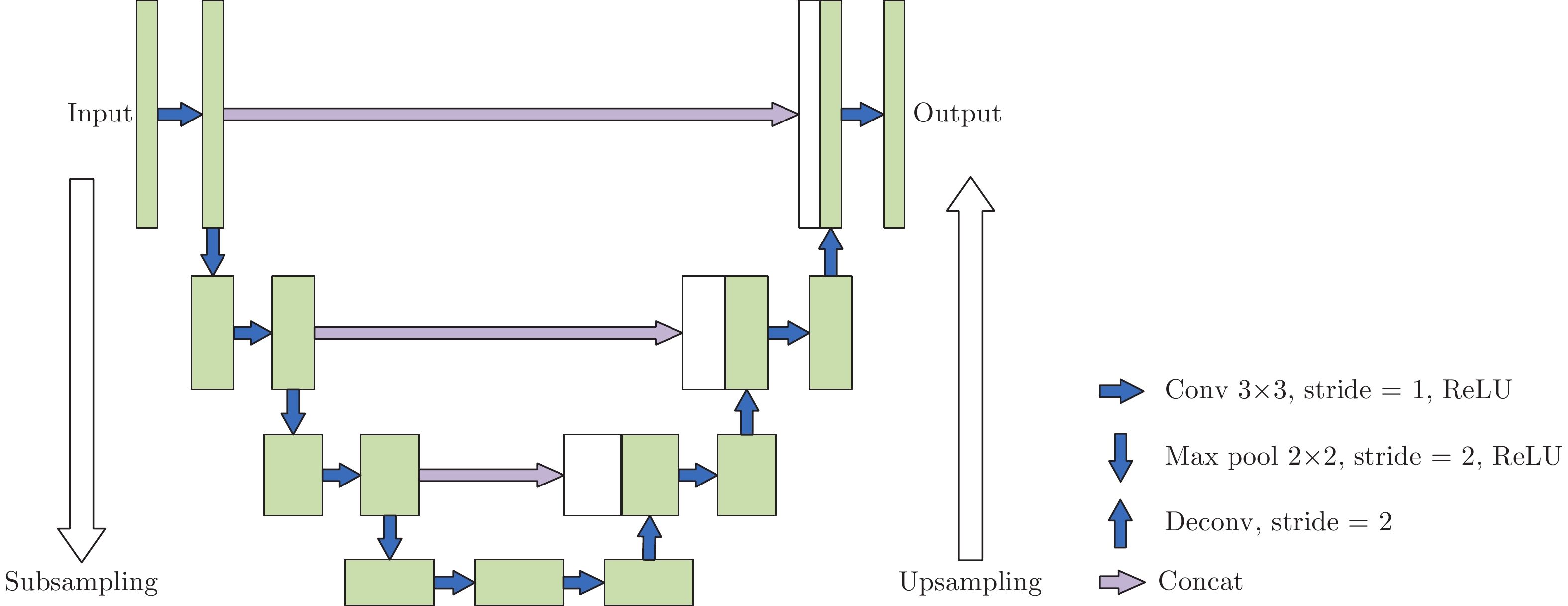

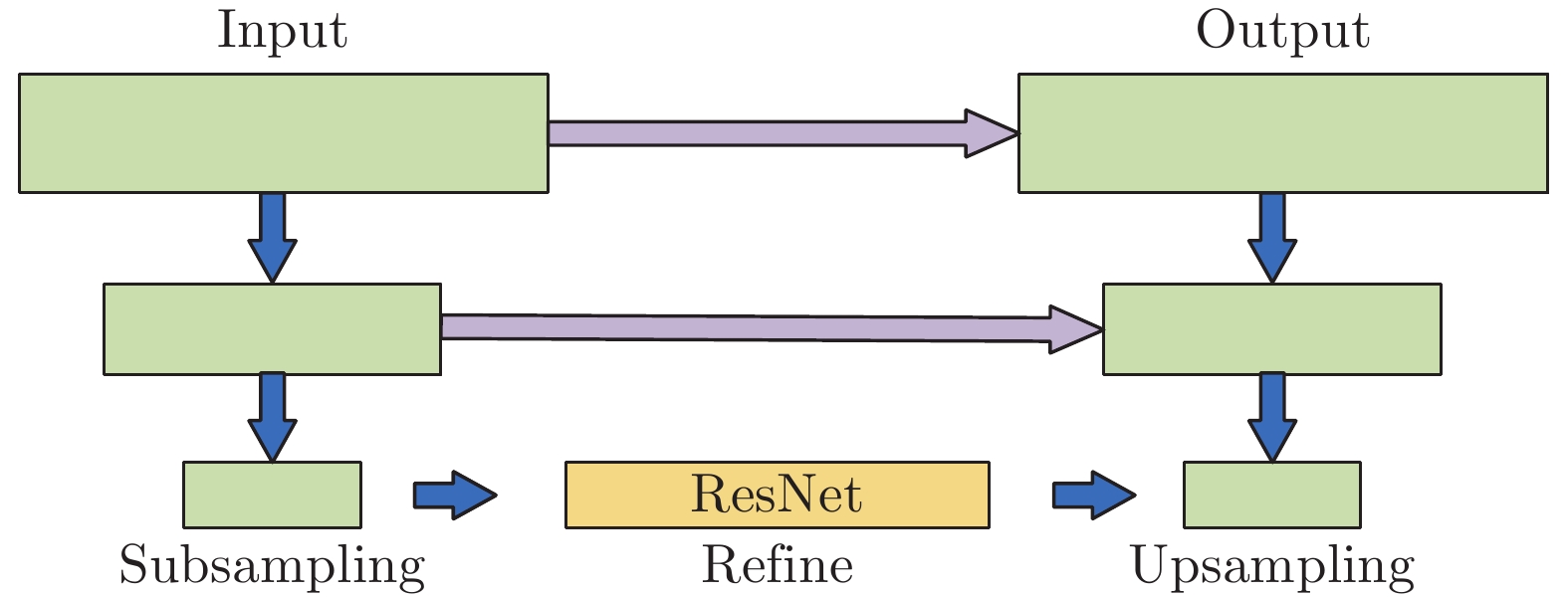

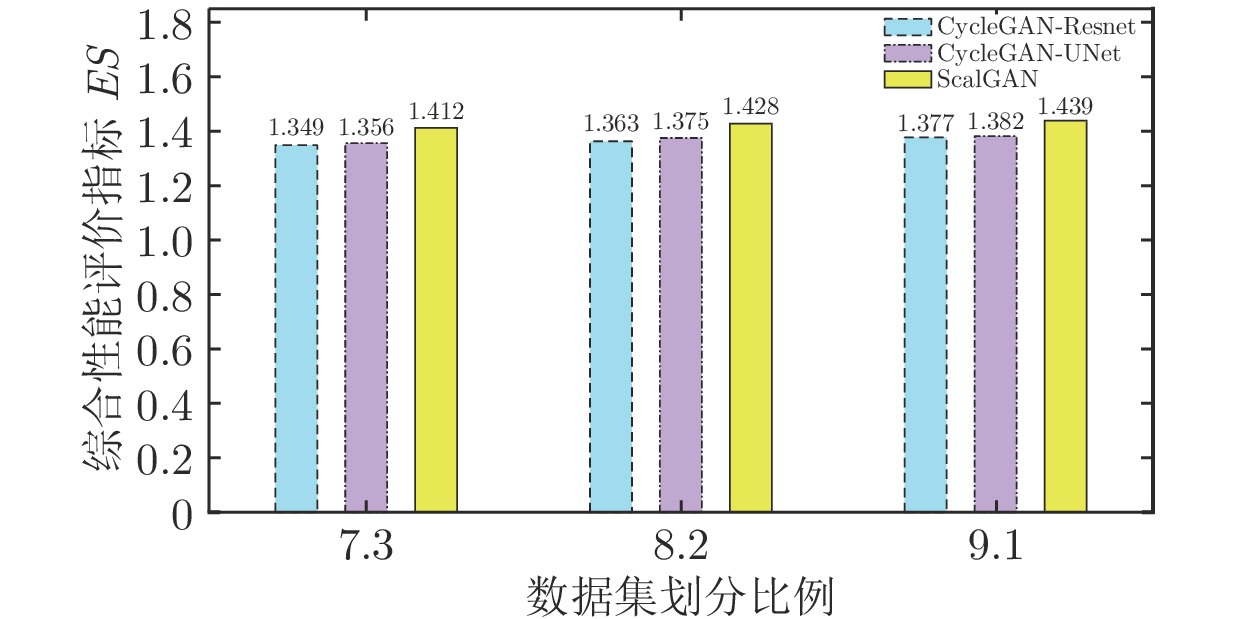

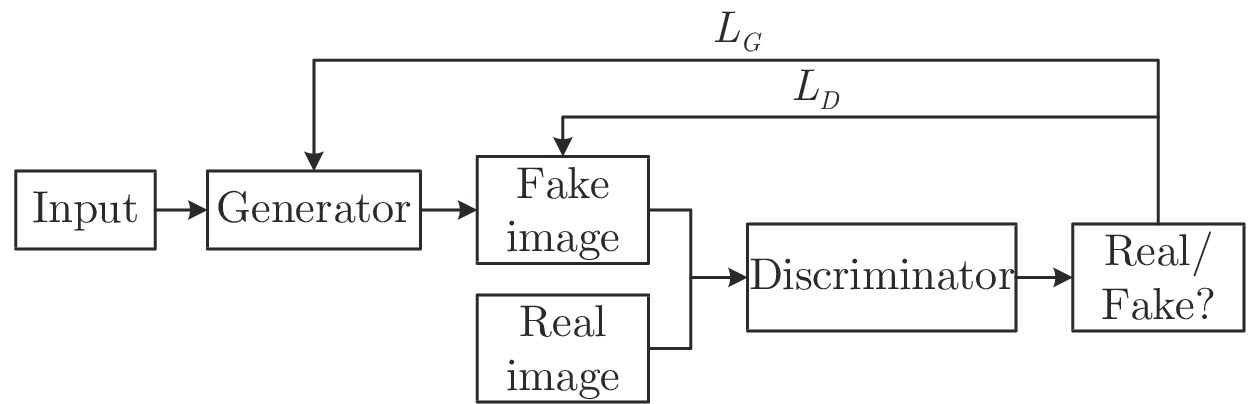

摘要: 发票是财务系统的重要组成部分. 随着计算机视觉和人工智能技术的发展, 出现了各种发票自动识别系统, 但是发票上的印章严重影响了识别准确率. 本文提出了一种用于自动消除发票印章的SealGAN网络. SealGAN网络是基于生成式对抗网络CycleGAN的改进, 采用两个独立的分类器来取代原本的判别网络, 从而降低单个分类器的分类要求, 提高分类器的学习性能, 并且结合ResNet和Unet两种结构构建下采样−精炼−上采样的生成网络, 生成更加清晰的发票图像. 同时提出了基于风格评价和内容评价的综合评价指标对SealGAN网络进行性能评价. 实验结果表明, 与CycleGAN-ResNet和CycleGAN-Unet网络相比较, Seal GAN网络不仅能实现自动消除印章, 而且还能更加清晰地保留印章下的发票内容, 网络性能评价指标较高.Abstract: Invoice is an important part of the financial system. With the development of computer vision and artificial intelligence technologies, various automatic invoice identification systems have been developed. However, the seals on the invoice often affect the identification success rate. In this paper, the SealGAN network structure is proposed, which can automatically eliminate the seal of invoice. SealGAN network is an improvement based on generative adversarial network CycleGAN. The two discriminant networks are replaced with two independent classifiers in the SealGAN, which reduces the classification requirement of each classifier, and the learning performance of classifiers can be improved. In addition, it combines the ResNet and UNet structures to construct a downsampling-refining-upsampling generation network, which can generate clearer images of invoice. And the network comprehensive evaluation index, including style evaluation and content evaluation, is proposed to evaluate the performance of network. Experimental results demonstrate that the SealGAN network can not only eliminate the seal automatically, but also retain the invoice content under the seal clearly, and the network performance evaluation index is higher than that of the CycleGAN-ResNet and CycleGAN-Unet.

-

Key words:

- Seal elimination /

- generative adversarial networks /

- SealGAN /

- CycleGAN /

- evaluation index

-

表 1 生成网络和分类器参数表

Table 1 Parameters of the generative network and classifier

生成网络 分类器 下采样 精炼 上采样 7×7 conv, 96 Residual_block(3×3, 384) ×7 4×4 deconv, 256, ×2 4×4 conv, 64, /2 4×4 conv, 192, /2 4×4 deconv, 256, ×2 4×4 conv, 128, /2 4×4 conv, 384, /2 4×4 deconv, 256, ×2 4×4 conv, 256, /2 4×4 conv, 384, /2 4×4 deconv, 256, ×2 4×4 conv, 512, /2 4×4 conv, 384, /2 4×4 deconv, 128, ×2 4×4 conv, 1 4×4 conv, 384, /2 4×4 deconv, 64, ×2 4×4 conv, 384, /2 7×7 conv, 3 表 2 三种网络性能评价指标

Table 2 Performance evaluation indices of three kinds of network

网络类型 CS1 CS2 $ ES $ 二次分割 0.340 0.991 1.331 CycleGAN-ResNet 0.678 0.699 1.377 CycleGAN-UNet 0.703 0.679 1.382 SealGAN 0.699 0.740 1.439 -

[1] 胡泽枫, 张学习, 黎贤钊. 基于卷积神经网络的批量发票识别系统研究. 工业控制计算机, 2019, 32(05): 104-105+107 doi: 10.3969/j.issn.1001-182X.2019.05.043Hu Ze-Feng, Zhang Xue-Xi, Li Zhao-Xian. Batch Invoice Recognition System Based on Convolutional Neural Network (CNN). Industrial Control Computer, 2019, 32(05): 104-105+107 doi: 10.3969/j.issn.1001-182X.2019.05.043 [2] 欧阳欢, 范大昭, 李东子. 多特征融合决策的发票印章识别. 计算机工程与设计, 2018, 39(09): 2842-2847Ou-Yang Huan, Fan Da-Zhao, Li Dong-Zi. Invoice seal identification based on multi-feature fusion decision. Computer Engineering and Design, 2018, 39(09): 2842-2847 [3] Chung W H, Wu M E, Ueng Y L, Su Y H. Seal imprint verification via feature analysis and classifications. Future Generation Computer Systems, 2019, 101: 458-466 doi: 10.1016/j.future.2019.04.027 [4] Xie R N, Mao W H, Shi G Z. Electronic invoice authenticity verifying scheme based on signature recognition. In: Proceedings of International Conference on Advanced Algorithms and Control Engineering (ICAACE), 2019, 1−8 [5] 季婧婧, 娄震. 基于二次分割的银行票据彩色印章的滤除. 现代电子技术, 2014, 37(22): 5-9 doi: 10.3969/j.issn.1004-373X.2014.22.002Ji Jing-Jing, Lou Zhen. Filtering of color seal on bank notes based on re⁃segmentation. Modern Electronics Technique, 2014, 37(22): 5-9 doi: 10.3969/j.issn.1004-373X.2014.22.002 [6] 崔文成, 任磊, 刘阳, 邵虹. 基于数字结构特征的发票号码识别算法. 数据采集与处理, 2017, 32(1): 119-125Cui Wen-Cheng, Ren Lei, Liu Yang, Chao Hong. Invoice Number recognition algorithm based on numerical structure characteristics. Journal of Dat Acquisition and Processing, 2017, 32(1): 119-125 [7] Goodfellow I J, Pouget-Abadie J, Mirza M, Xu B, WardeFarley D, Ozair S, et al. Generative adversarial nets. In: Proceedings of the 27th International Conference on Neural Information Processing Systems, 2014, 2672−2680 [8] Rezende D J, Mohamed S, Wierstra D. Stochastic back-propagation and approximate inference in deep generative models. In: Proceedings of International Conference on Machine Learning (ICML), Beijing, China, JMLR:W&CP. 2014. [9] Hinton G E, Osindero S, Teh Y W. A fast learning algorithm for deep belief nets. Neural Computation, Beijing, China. JMLR:W&CP, 2006, 18(7): 1527-1554 doi: 10.1162/neco.2006.18.7.1527 [10] 王坤峰, 苟超, 段艳杰, 林懿伦, 郑心湖, 王飞跃. 生成式对抗网络GAN的研究进展与展望. 自动化学报, 2017, 43(3): 321-332Wang Kun-Feng, Gou Chao, Duan Yan-Jie, Lin Yi-Lun, Zheng Xin-Hu, Wang Fei-Yue. Generative adversarial networks: the state of the art and beyond. Acta Automatica Sinica, 2017, 43(3): 321-33 [11] 林懿伦, 戴星原, 李力, 王晓, 王飞跃. 人工智能研究的新前线: 生成式对抗网络. 自动化学报, 2018, 44(5): 775-792Lin Yi-Lun, Dai Xing-Yuan, Li Li, Wang Xiao, Wang Fei-Yue. The new frontier of AI research: generative adversarial networks. Acta Automatica Sinica, 2018, 44(5): 775-792 [12] Radford A, Metz L, Chintala S. Unsupervised representation learning with deep convolutional generative adversarial networks. In: Proceedings of International Conference on Learning Representations (ICLR), 2015. San Diego, CA. [13] Ledig C, Theis L, Huszár F, Caballero J, Cunningham A, et al. Photo-realistic single image super-resolution using a generative adversarial network. In: Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017, 105−114. Honolulu, HI, USA, Institute of Electrical and Electronics Engineers. [14] Denton E, Chintala S, Szlam A, Fergus R. Deep generative image models using a Laplacian pyramid of adversarial networks. In: Proceedings of the 28th International Conference on Neural Information Processing Systems, Montreal, QC, Canada, Neural information processing systems foundation, 2015, 1486−1494 [15] Isola P, Zhu J Y, Zhou T, Efros A A. Image-to-image translation with conditional adversarial networks. In: Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Honolulu, HI, USA , Institute of Electrical and Electronics Engineers. 2017, 5967−5976 [16] Bao J M, Chen D, Wen F, Li H Q, Hua G. CVAE-GAN: Fine-grained image generation through asymmetric training. In: Proceedings of IEEE International Conference on Computer Vision (ICCV), Venice, Italy, Institute of Electrical and Electronics Engineers. 2017, 2764−2773 [17] Zhu J Y, Park T, Isola P, Efros A A. Unpaired image-to-image translation using cycle-consistent adversarial networks. In: Proceedings of IEEE International Conference on Computer Vision (ICCV), Venice, Italy, Institute of Electrical and Electronics Engineers. 2017, 2242−2251 [18] He K, Sun J. Convolutional neural networks at constrained time cost. In: Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Boston, MA, USA, Institute of Electrical and Electronics Engineers. 2015, 5353−5360 [19] He K M, Zhang X Y, Ren S Q, Sun J. Deep residual learning for image recognition. In: Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Las Vegas, NV, USA, Institute of Electrical and Electronics Engineers. 2016, 770−778 [20] Ronneberger O, Fischer P, Brox T. U-Net: Convolutional networks for biomedical image segmentation. In: Proceedings of 18th International Conference on Medical Image Computing and Computer-Assisted Intervention (MICCAI), Munich, Germany, Springer International Publishing Switzerland. 2015, 234−241 [21] Arjovsky M, Chintala S, Bottou L. Wasserstein generative adversarial network. In: Proceedings of the International Conference on Machine Learning, Sydney, Australia. 2017, 298−321 [22] Mao X D, Li Q, Xie H R, Lau, R Y K, Wang Z. Least squares generative adversarial networks. In: Proceedings of IEEE International Conference on Computer Vision (ICCV), Venice, Italy, Institute of Electrical and Electronics Engineers. 2017, 2813−282 [23] Szegedy C, Liu W, Jia Y, Sermanet P, Reed S, Anguelov D, Erhan D, Vanhoucke V, Rabinovich A. Going deeper with convolutions. In: Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Boston, MA, USA, Institute of Electrical and Electronics Engineers. 2015, 1−9 [24] Wang H, Wang Y T, Zhou Z, Ji X, Gong D H, Zhou J C, Li Z F, Liu W. CosFace: Large margin cosine loss for deep face recognition. In: Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Salt Lake City, USA, Institute of Electrical and Electronics Engineers.2018, 5265−5274 -

下载:

下载: