A Butterfly Detection Algorithm Based on Transfer Learning and Deformable Convolution Deep Learning

-

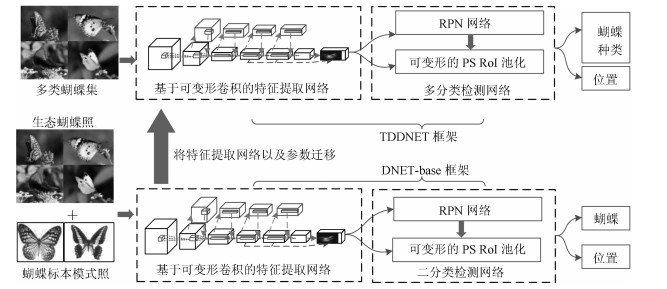

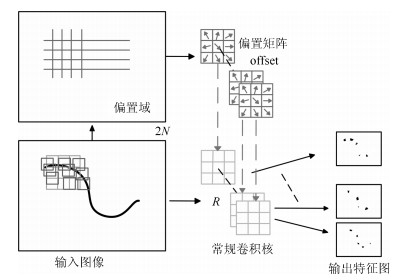

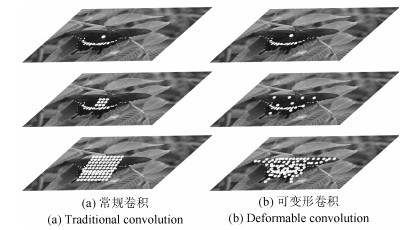

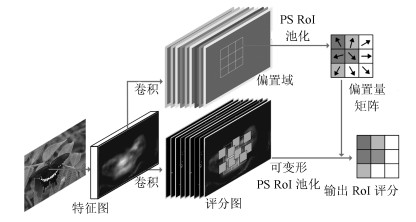

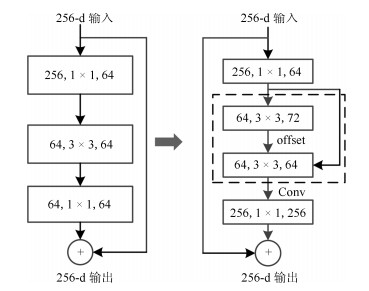

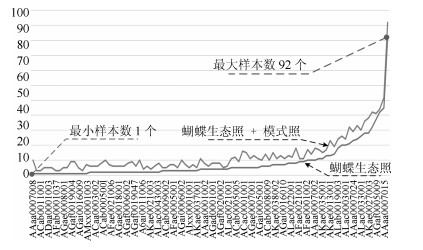

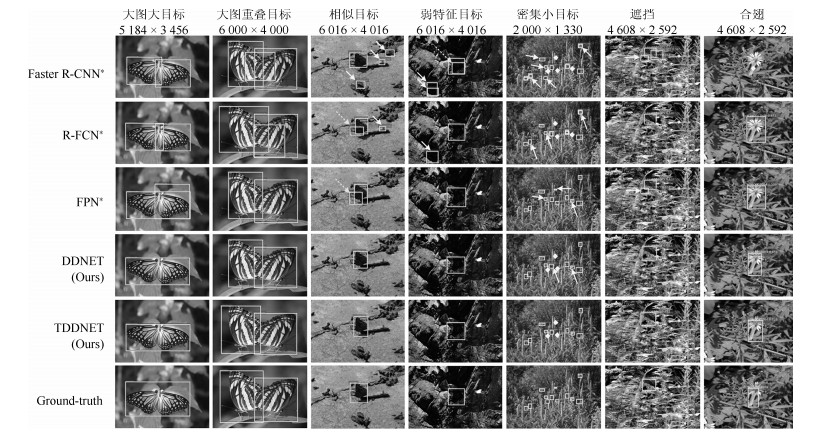

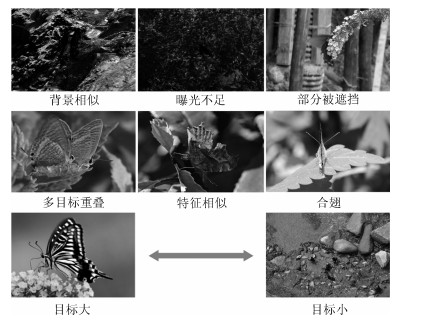

摘要: 针对自然生态蝴蝶多种特征检测的实际需求,以及生态环境下蝴蝶检测效率低、精度差问题,本文提出了一种基于迁移学习和可变形卷积深度神经网络的蝴蝶检测算法(Transfer learning and deformable convolution deep learning network,TDDNET).该算法首先使用可变形卷积模型重建ResNet-101卷积层,强化特征提取网络对蝴蝶特征的学习,并以此结合区域建议网络(Region proposal network,RPN)构建二分类蝴蝶检测网络,以下简称DNET-base;然后在DNET-base的模型上,构建RPN网络来指导可变形的敏感位置兴趣区域池化层,以便获得多尺度目标的评分特征图和更准确的位置,再由弱化非极大值抑制(Soft non-maximum suppression,Soft-NMS)精准分类形成TDDNET模型.随后通过模型迁移,将DNET-base训练参数迁移至TDDNET,有效降低数据分布不均造成的训练困难与检测性能差的影响,再由Fine-tuning方式快速训练TDDNET多分类网络,最终实现了对蝴蝶的精确检测.所提算法在854张蝴蝶测试集上对蝴蝶检测结果的mAP0.5为0.9414、mAP0.7为0.9235、检出率DR为0.9082以及分类准确率ACC为0.9370,均高于在同等硬件配置环境下的对比算法.对比实验表明,所提算法对生态照蝴蝶可实现较高精度的检测.Abstract: Aiming at the demand of butterfly multi-features recognition, and the problems of low precision and efficiency of butterfly detection in ecological environment, a butterfly detection with deformable convolution depth neural network based transfer learning is proposed (TDDNET). Firstly, the ResNet-101 convolutional layer is reconstructed by using the deformable convolutional model, which can reinforce the learning of feature extraction network for butterfly features. At the same time, this algorithm is combined with the region proposal network (RPN) to construct a two-classes detection network named DNET-base. Next, on the DNET-base to build TDDNET, the subnetwork RPN is used to guide the deformable sensitive position RoI pooling layer, which can obtain the scores feature map and the multi-scale object location. Then, we use the Soft-nms to obtain better detection results. Finally, the model after DNET-base training is transferred to the TDDNET, and fine-tuning the TDDNET multi-classification parameters. In testing datasets which have 854 images, the butterfly mAP0.5 of the proposed algorithm is 0.9414, mAP0.7 is 0.9235, the detection rate (DR) is 0.9082 and the classification accuracy (ACC) is 0.9370. The experiments demonstrate that the proposed algorithm outperforms the state-of-the-art model in the same hardware environment. The results show that the proposed algorithm can detect butterflies with high accuracy.

-

随着社会经济的发展和科学技术的进步, 现代化复杂工程系统的规模不断扩大, 功能越来越强. 复杂工程系统中的故障若未能得到有效处理, 不仅可能导致财产损失或人员伤亡, 还可能导致环境污染造成生态灾难[1-2]. 动态系统的故障诊断技术是提高系统安全性、可靠性和降低事故风险的关键技术, 已成为国内外自动控制领域的前沿研究方向之一[3-5]. 在过去的几十年里, 研究人员对故障诊断技术进行了广泛的研究, 取得了一系列的研究成果[6-11].

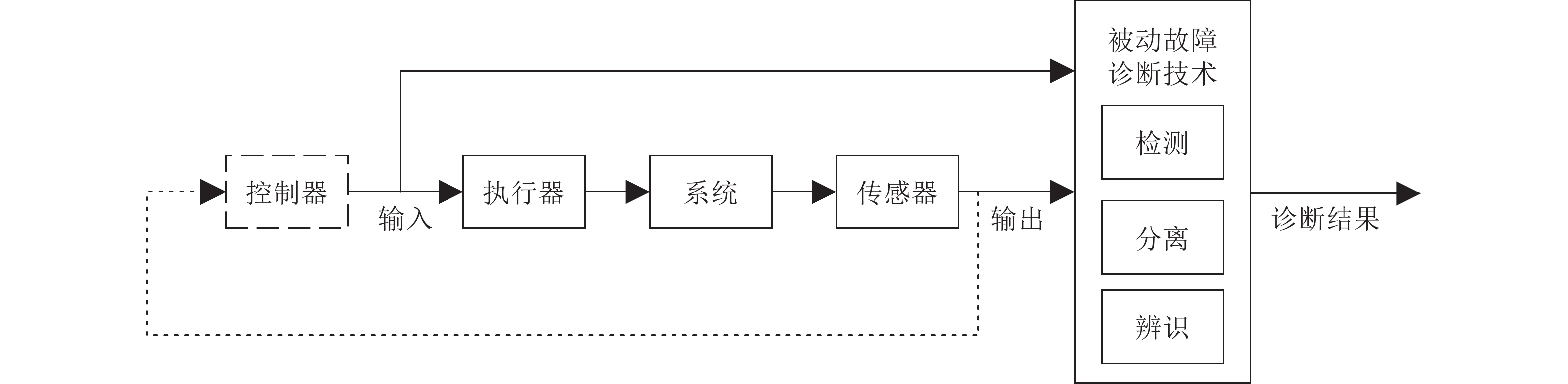

现有故障诊断方法绝大多数是在“被动”框架下进行的, 即仅利用系统的输入输出数据生成用于指示故障的残差信号, 没有对系统施加额外的输入信号, 从而不对系统的演化规律产生影响. 此类故障诊断方法可称为被动故障诊断方法. 被动故障诊断的框架限制了方法对故障的诊断能力, 也弱化了被动故障诊断方法在实际工程中的应用. 为了更加深入地研究动态系统的故障诊断理论, 推进故障诊断技术在实际工程中的应用, Zhang和Zarrop于1988年首次提出“主动”的故障诊断框架. 该思想一经提出便得到了学术界的重视, 一些学者对主动故障诊断方法进行了进一步的研究[12-16]. 与被动故障诊断不影响原系统演化规律这一特点不同, 主动故障诊断可通过设计合适的辅助信号输入至系统, 增强特定故障表现, 提高故障诊断性能, 提升故障诊断技术的实用性.

本文对主动故障诊断技术的现有研究成果进行综述. 首先介绍主动故障诊断的思想和辅助信号的特征, 然后对现有辅助信号设计方法进行分类概述, 并给出故障表现增强的形式与主动故障诊断技术的实现途径, 最后对主动故障诊断未来的发展方向进行展望.

1. 主动故障诊断概述

被动故障诊断的结构如图1所示. 被动故障诊断方法仅利用系统的输入输出数据对故障进行分析处理, 故障诊断单元不对系统进行任何输入上的改变, 诊断过程也不影响原系统的演化规律. 当输入输出数据中包含的故障信息不充分时, 被动故障诊断方法难以取得良好的诊断效果. 例如, 由于系统噪声或不确定性的存在, 幅值较小的早期故障引起的系统变化与系统噪声或不确定性引起的系统变化难以区分, 加之闭环系统中反馈控制器会在一定程度上掩盖或补偿因故障引起的系统异常, 这些情况都会导致被动故障诊断效果不佳.

与被动故障诊断不同, 主动故障诊断方法针对系统的特定故障, 设计满足一定要求的辅助信号, 该辅助信号通过输入作用于系统时, 可使特定故障在系统输入输出中表现更充分, 故障特征更明显, 从而更准确地实现对特定故障的诊断. 主动故障诊断的框架如图2所示, 其中关键技术包括辅助信号设计、故障表现增强和主动故障诊断算法设计等. 值得一提的是, 主动故障诊断的“主动”与主动容错控制中的“主动”含义不同, 主动容错控制是指系统主动对故障进行补偿或者根据故障重新配置控制律[17], 主动故障诊断中的“主动”是指通过对系统施加辅助信号, 增强故障在输入输出数据中的表现, 以获得更强的诊断能力, 是否利用辅助信号增强特定故障的表现也是主动故障诊断与被动故障诊断的本质区别.

在实际应用中, 很多现有的故障诊断方法均体现了主动故障诊断的思想. 例如, 铁路工人通过敲击车轮并根据产生的声音判断车轮是否存在故障. 在这一过程中, 对车轮的敲击是为了施加辅助信号, 该辅助信号激发了车轮故障在声音中的表现, 即敲击产生的声音中包含了大量与故障相关的信息, 从而可根据敲击产生的声音判断车轮是否存在裂纹等故障. 又如, 在操作员操纵机械臂执行任务的过程中, 当机械臂发生卡死故障时, 操作员可以通过施加使机械臂向特定方向运动的控制命令, 根据机械臂的执行情况来判断故障发生的位置. 上述主动故障诊断思想的应用实例均一定程度上依赖于人的经验, 缺乏科学理论指导. 动态系统的主动故障诊断研究仍为具有挑战性的科学问题.

一般来说, 动态系统主动故障诊断主要包括三个环节: 1) 辅助信号设计 — 针对系统特定故障, 通过适当方法设计满足一定要求的辅助信号; 2) 故障表现增强 — 将辅助信号注入系统, 激励系统产生增强特定故障表现的输出数据; 3) 故障诊断 — 采用合适的诊断算法对输入输出数据进行分析, 实现对特定故障的检测与诊断. 辅助信号是针对特定故障设计的, 其施加目的是增强特定故障的表现, 诊断方法的效果依赖于故障表现增强的程度. 辅助信号设计是前提, 故障表现增强是关键, 诊断方法是保证. 下面给出主动故障诊断的定义:

定义1. 主动故障诊断: 应用适当方法设计满足一定要求的辅助信号, 将其输入至原系统, 利用系统的输入输出数据进行故障诊断[18].

在主动故障诊断中, 当辅助信号输入至系统后, 在保证该信号对系统性能影响可接受的前提下, 该辅助信号可增强特定故障在系统输入输出数据中的表现. 因此与被动故障诊断相比, 主动故障诊断具有更强的诊断能力, 并且具有更好的应用潜力, 是故障诊断领域未来重要的研究方向. 两类故障诊断方法的对比如表1所示.

表 1 两类故障诊断技术对比Table 1 Comparison of two types of fault diagnosis techniques被动故障诊断 主动故障诊断 是否利用系统输入输出信息 是 是 是否存在额外辅助信号输入 否 是 是否影响原系统演化规律 否 是 现有理论研究成果 多 极少 故障诊断能力 弱 强 实际应用潜力 小 大 2. 辅助信号特征

主动故障诊断与被动故障诊断的主要区别在于是否有辅助信号输入至系统中. 主动故障诊断通过设计辅助信号并将其注入系统, 得到包含更多特定故障信息的系统输出, 进而通过适当的算法进行故障诊断, 因此辅助信号对实现主动故障诊断至关重要. 本节主要介绍辅助信号相关特征, 包括辅助信号的作用、辅助信号的形式以及辅助信号的评价标准等内容.

2.1 辅助信号的作用

辅助信号的主要作用是通过注入对象系统, 增强特定故障在输出信号中的表现, 实现特定故障的检测与分离, 以提高对特定故障的诊断能力[18-19]. 下面给出辅助信号的定义:

定义2. 辅助信号: 主动故障诊断方法中需要设计的满足一定要求的信号. 该信号输入至系统中, 可增强特定故障在输出信号中的表现, 配合相应方法完成对特定故障的诊断, 这样的信号称为辅助信号[19-25].

注1. 一些文献也将上述信号称为适当辅助信号, 为了表述的一致性, 本文统一称为辅助信号.

在主动故障诊断中, 需要将辅助信号注入系统. 出于实际系统的约束以及系统安全性的考虑, 辅助信号需要满足如下几个方面的条件:

1)幅值约束: 实际系统的输入、输出和状态存在上下限, 辅助信号输入至系统中不应使实际系统输入超出输入的幅值约束, 同时辅助信号激励的系统状态和输出也不应超出各自的幅值约束[18, 26-30].

2)系统性能约束: 若系统处于运行过程中, 辅助信号的注入需要考虑对系统性能的影响, 不能对原有系统造成过大影响[27, 31-33].

3)时间约束: 实际系统中, 若辅助信号注入时间过长, 会对系统性能造成较大影响; 若注入时间过短, 则可能降低故障诊断率. 因此需要在系统性能与故障诊断率之间进行权衡[32].

4)物理约束: 实际辅助信号需要一定装置产生, 故设计的辅助信号必须是物理可实现的, 例如瞬时功率不能过大、频率变化不能过快. 同时辅助信号需要满足因果性约束[34].

5)其他约束: 除了上述约束之外, 一些研究成果还讨论辅助信号的功率和能量等其他约束[18, 27, 35-36].

2.2 辅助信号的形式

根据不同的系统类型、约束条件、优化目标和设计方法, 设计出来的辅助信号形式多种多样, 主要有正弦类信号、分段恒定信号等常规形式信号以及通过求解优化问题得到的不定形式的信号. 下面介绍几种典型的辅助信号.

2.2.1 正弦类信号

正弦类信号是常见的辅助信号类型, 早期文献中的辅助信号大多为正弦信号, 包括单频正弦信号, 多频正弦信号和其他类似正弦形式的信号等[18].

Kerestecioğlu等讨论了辅助信号在使用统计检验方法进行系统模型参数变化检测中的应用, 结果表明渐近最优离线输入具有离散谱[35, 37-38]. Nikoukhah等研究了存在能量有界扰动的线性系统的主动故障诊断问题, 结果表明, 当以最小能量为优化目标, 诊断时间趋于无穷时, 最优辅助信号收敛至正弦波[39]. Niemann考虑了线性时不变系统的主动故障诊断问题, 并讨论了正弦信号作为辅助信号的优缺点: 优点是信号形式简单, 检测方便; 缺点是故障诊断时间取决于正弦信号选定的频率和幅值, 若选定结果不佳, 诊断时间可能会延长[40]. Ashari等研究了闭环系统的主动故障诊断问题, 在二次型形式的优化目标下, 当诊断时间趋于无穷时, 将问题转换到频域进行分析, 结果表明最优的辅助信号为正弦信号[41].

2.2.2 分段恒定信号

分段恒定信号也是一种常见的辅助信号类型, 包括等幅值等时间间隔的信号、幅值不等时间间隔相等的信号、幅值相等时间间隔不等的信号等形式.

Blanchini等讨论了连续时间线性系统的主动故障诊断问题, 分别给出了常值和正弦两种形式的辅助信号, 并给出了相应的设计方法[42]. Kim等考虑了三种度量方法用于衡量故障模型与标称模型之间的差异, 以最大化不同模型输出之间的差异作为优化目标, 考虑系统输入和输出的限制, 得到的最优辅助信号为分段恒定信号[43]. Choe等研究了分段恒定信号作为辅助信号的主动故障诊断问题, 给出了一种计算最优分段恒定信号的新算法, 在信号幅值变化次数较少的情况下, 辅助信号幅值更小但对主动故障诊断更加有效[23].

相比正弦类信号, 现有文献中对分段恒定形式的辅助信号研究较少, 多数是考虑系统输入限制或信号生成的难易程度等因素, 并不保证辅助信号的最优性. 理论上最优的辅助信号可能具有更复杂的形式, 不便实际应用. 相比于连续变化的辅助信号, 分段恒定信号的故障诊断时间更长, 但是其形式简单, 易于工程实施.

2.2.3 其他类型信号

除了正弦信号和分段恒定信号以外, 大部分的研究成果都没有限定具体的辅助信号形式, 而是将辅助信号的设计问题转化为满足特定约束条件的优化问题. 此类辅助信号形式多样, 没有固定的信号形式, 多为连续变化的信号.

注2. 单一频率的正弦信号无法充分满足主动故障诊断的需求, 需要更复杂的信号形式, 因此大部分研究成果都通过优化来确定最优或次优的辅助信号.

2.3 辅助信号的评价标准

除可增强特定故障表现这一基本要求外, 辅助信号往往还应该在某些评价标准下具有最优性. 常用的辅助信号评价标准有以下几种:

1)最大化输出集合之间的分离程度或者最大化数据分布之间的统计距离[27, 42-43].

3)最小化平均诊断错误率[35].

4)最小化辅助信号幅值、能量、范数或二次型函数[22, 25].

5)最小化与辅助信号和系统状态等参数有关的损失函数[44].

6)最大化辅助信号对残差信号的影响同时最小化对标称系统输出的影响[45].

7)在存在多种故障情况下, 最大化标称模型与不同故障模型数据集合之间的最小距离, 或最大化标称模型与不同故障模型的数据集合之间距离的加权和[34, 46].

此外, 很多文献都将两个或者多个评价标准的加权作为优化目标[17, 47].

3. 辅助信号设计

3.1 系统友好型与系统侵入型辅助信号设计

辅助信号作为可增强系统特定故障表现的激励输入[48-50], 与系统原有输入(指进行主动故障诊断之前的系统输入)一起可视为系统的总输入信号. 若系统原有输入不可中断, 则在辅助信号设计阶段需考虑原有输入的影响, 在辅助信号应用阶段需在保持原有输入的基础上将设计好的辅助信号与之叠加, 两个信号均可为主动故障诊断提供信息[13, 51-52]. 这类辅助信号可称为系统友好型辅助信号. 与之对应的情况是在对系统施加辅助信号时, 可暂时中断原有输入, 仅由辅助信号作为输入作用于系统. 在该情况下的辅助信号设计阶段, 可不考虑原有输入[12, 27, 30], 这类辅助信号称为系统侵入型辅助信号. 表2给出了两类辅助信号设计方法的部分典型参考文献.

表 2 系统友好型与系统侵入型辅助信号设计Table 2 “System-friendly”and“System-intrusive”auxiliary signals design类型 参考文献 系统友好型辅助信号设计 Nett et al. (1988)[13], Niemann (2006)[40], Niemann and Poulsen (2014)[45], Jacobson and Nett (1991)[51], Niemann (2012)[54], Niemann and Poulsen (2005)[56], Niemann (2006)[57], Poulsen and Niemann (2008)[58], Niemann and Poulsen (2015)[59] etc. 系统侵入型−随机性辅助信号设计 Zhang and Zarrop (1988)[12], Zhang (1989)[27], Paulson et al. (2018)[29], Mesbah et al. (2014)[30], Kerestecioğlu (1993)[33], Kim and Braatz (2013)[43], Punčochář et al. (2015)[62], Blackmore et al. (2008)[63], Heirung and Mesbah (2017)[64], Hatanaka and Uosaki (1999)[66], Hatanaka and Uosaki (1996)[68], Škach et al. (2017)[69] etc. 系统侵入型−确定性辅助信号设计 Raimondo et al. (2016)[14], Scott et al. (2014)[15], Ashari et al. (2012)[20], Choe et al. (2009)[23], Nikoukhah and Campbell (2006)[70], Marseglia et al. (2014)[71], Marseglia and Raimondo (2017)[73], Nikoukhah and Campbell (2008)[76] etc. 3.1.1 系统友好型辅助信号设计

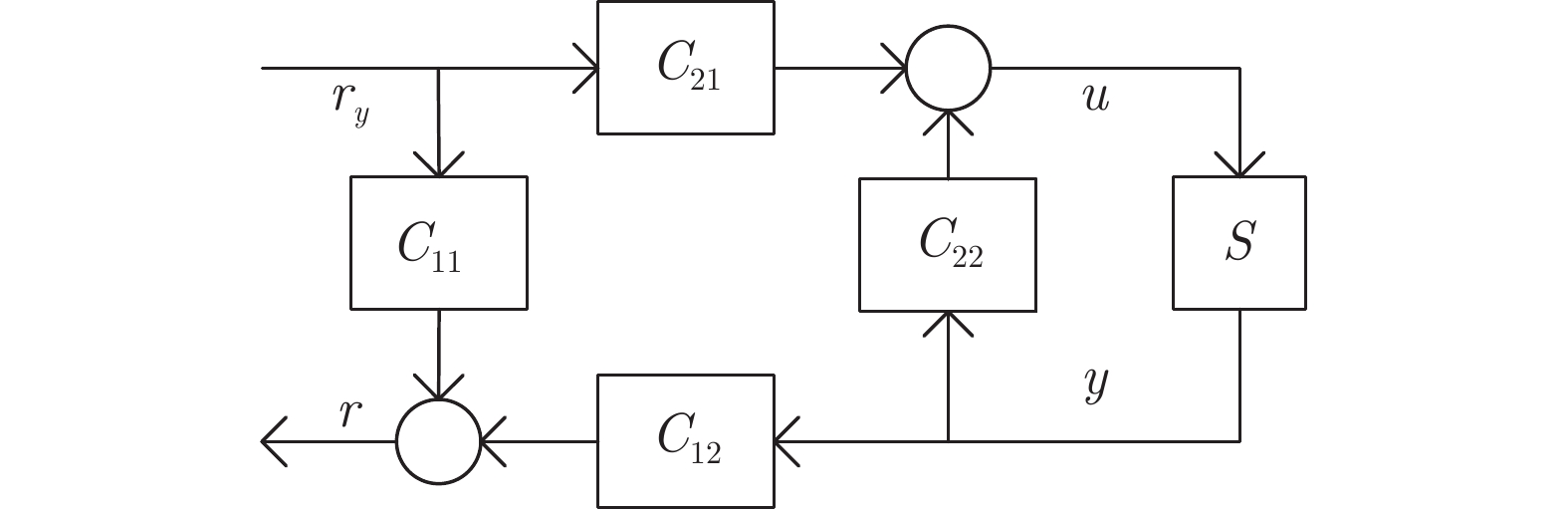

系统友好型辅助信号设计的框架最早由Nett等提出[13], 采用四参数控制器对线性系统的控制模块和故障诊断模块进行综合设计. 四参数控制器如图3所示, 其中传递函数矩阵

$ C_{21} $ 和$ C_{22} $ 代表控制器,$ C_{11} $ 和$ C_{12} $ 代表残差产生器, 其中$ r_y $ 表示辅助信号,$ r $ 表示残差信号. 该四参数控制器具有系统控制输入和辅助信号两个输入信号, 以及系统测量输出和残差信号两个输出信号. 各矩阵参数描述了系统控制性能与故障诊断的交互作用, 进而通过设计辅助信号和控制器实现系统控制和故障诊断的最佳权衡[13].早期四参数控制器的集成设计方法在控制和检测性能之间进行了权衡, 但并未给出辅助信号具体设计方法[19]. 针对动态系统中的参数故障, Niemann提出采用Youla-Jabr-Bongiorno-Kucera (YJBK)参数化方法设计四参数控制器和辅助信号, 并给出了故障特征矩阵的概念, 即辅助信号至残差信号的传递函数矩阵. 证明了该辅助信号设计方法和主动故障诊断框架对于开环系统和基于标称反馈控制器的闭环系统均适用, 同时有助于系统容错控制的实现[40]. 据此, Niemann设计了基于主动故障诊断的容错控制方法[53-54]. Wang等针对早期故障, 提出了采用双重YJBK参数设计辅助信号和容错控制器, 给出了主动故障检测和主动容错控制的统一故障处理体系[55].

针对闭环系统的主动故障诊断, Niemann等给出了新的方法, 该方法以最大化辅助信号对残差信号的影响且最小化对标称系统输出的影响为目标设计辅助信号, 采用累积和控制图(Cumulative sum, CUSUM) 方法实现对系统故障的实时检测[56]. Niemann将文献[56]中辅助信号设计方法拓展至闭环不确定性系统, 给出了在闭环不确定系统中精确检测参数故障的条件[57]. Poulsen等改进了文献[56]中所采用的CUSUM方法, 并利用改进的CUSUM方法在残差信号中检测由辅助信号激发的故障特征, 实现故障检测[58]. 文献[56-58]均只考虑了两个系统模型, 即一个标称系统模型和一个特定故障模型, 设计的辅助信号仅能诊断出系统单一故障, 方法适用范围有限.

此外, Niemann等针对具有特定参数故障的多输入多输出(Multiple-input multiple-out, MIMO)系统提出了一种辅助信号设计方法, 然后基于传递函数的奇异值分解对辅助信号设计方法进行了分析[45]. Niemann和Poulsen将基于YJBK参数化和故障特征矩阵的辅助信号设计方法推广到采样系统, 采用离散化和近似方法得到系统的故障特征矩阵, 进而设计辅助信号, 实现采样系统的主动故障诊断[59].

系统友好型辅助信号设计方法需要考虑系统原有输入和控制器的影响, 需实现控制与故障诊断的最佳权衡, 不能对系统状态和演化规律造成过大影响, 因此辅助信号可选择的范围较小.

3.1.2 系统侵入型辅助信号设计

系统侵入型辅助信号设计不考虑系统原有输入, 在设计过程中将原有输入置为零, 在应用阶段系统输入信号仅有辅助信号. 相较于系统友好型辅助信号, 其设计求解过程简单, 计算量小, 但将原有输入置零, 可能会改变到系统的原有运行轨迹, 对系统造成不良影响, 这是系统侵入型命名的含义. 根据系统不确定性、噪声或扰动描述形式的不同, 可将系统侵入型辅助信号设计方法分为随机性辅助信号设计方法和确定性辅助信号设计方法. 前者将系统不确定性、噪声或扰动表示为无界随机变量(分布函数定义域无界的随机变量)的形式[12, 27-28]; 后者将系统不确定性、噪声或扰动表示为有界凸集、能量有界信号、有界随机变量(分布函数定义域有界的随机变量)等形式[39, 60-61]. 其中随机性辅助信号设计方法将不同模型输出或状态分布函数尽可能分离但不能完全分离, 对应的主动故障诊断称为随机性主动故障诊断; 绝大多数确定性辅助信号设计方法可将不同模型的输出或状态集完全分离, 对应的主动故障诊断称为确定性主动故障诊断.

1)随机性辅助信号设计

当系统的不确定性、噪声或扰动为无界随机变量且其概率分布已知时, 辅助信号可采用随机性辅助信号设计方法获得[29, 62-63]. 随机性辅助信号的设计目标是最大化不同模型输出概率密度函数之间的统计距离[30, 64], 最小化误诊率[28, 65] 或在限制误诊率的情况下最小化检测时间[33].

Zhang采用序贯概率比检测(Sequential probability ratio test, SPRT)方法, 以最小化故障检测时间为优化目标, 分别求解两模型和多模型情况下的辅助信号[27]. 基于相同的优化目标, Uosaki等采用基于向后序贯概率比检测的方法求解辅助信号[34, 66]. Hatanaka等考虑了受控自回归滑动平均(Controlled auto regression and moving average, CARMA)模型输出方差的限制, 通过求解数学规划问题, 给出了具备最优自协方差序列的滤波辅助信号, 进而将该最优滤波辅助信号应用于切比雪夫系统获得最优辅助信号[67-68]. Kerestecioğlu等考虑了故障信息未知或部分已知情况下的随机性辅助信号设计[35, 37]. Kerestecioğlu首次将误诊率限定在可接受的范围内, 以Kullback判别信息作为模型输出分离程度的度量指标, 以最小化检测时间为优化目标, 采用动态规划方法求解辅助信号[33]. 早期的随机性辅助信号设计方法均采用传统的假设性检验框架, 没有利用系统的先验信息, 所求解的辅助信号保守性可能较强. 此外, 此类方法仅针对输入输出模型, 假设较为严格, 不一定有解析解, 具有一定的局限性[18].

随着主动故障诊断的不断发展, 针对状态空间模型的随机性辅助信号设计也取得一些研究成果[28-30, 62-64]. 在基于状态空间模型的随机性辅助信号设计中, 一般通过系统参数的变化来表示故障. 在线性系统中若扰动、测量误差和初始状态均服从正态分布且相互独立, 则相应的模型输出也服从正态分布.

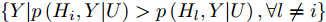

采用贝叶斯决策方法是实现误诊率最小化的重要途径, 在给定一组输入和输出数据以及标称模型和若干故障模型的情况下, 贝叶斯决策规则如图4所示,

$ H_{i} $ 表示系统模型,$ P(H_{i}) $ 表示模型$ i $ 的先验概率, 阴影部分表示模型选择错误的概率, 即贝叶斯风险. 贝叶斯决策产生许多决策区域$ \mathfrak{R}_{i} = $ $ \left\{Y | p\left(H_{i}, Y | U\right)>p\left(H_{l}, Y| U\right), \forall l \neq i\right\} $ , 若模型输出$ Y $ 落在$ \mathfrak{R}_{i}, $ 即$ i = {\rm{arg}} \max\limits_{j} p\left(Y| H_{j}, U\right)P(H_{j}) ,$ 则选择模型$ H_{i}. $ 贝叶斯决策方法的优化准则是使模型选择错误的概率降至最低, 即贝叶斯风险最小[63].基于贝叶斯决策方法, Mesbah等采用多项式混沌理论分析模型参数的不确定性, 利用蒙特卡罗模拟获得模型输出概率密度函数, 将巴氏距离作为多模型输出概率密度函数的分离指标和优化目标, 采用离线计算的方式求解满足条件的辅助信号[30]. 该方法计算简单, 易于操作, 但运用蒙特卡洛模拟获得的频率分布直方图来近似输出概率密度函数时, 输出概率密度函数的精度对频率分布直方图的划分区间数目敏感, 这在一定程度上限制了该方法的推广使用. Heirung等对该方法进行了改善, 采用累积分布函数的柯尔莫戈洛夫距离作为模型分离指标, 解决了上述问题, 并且降低了计算成本[64]. 此外, Kim等使用Kullback-Leibler散度(KL 散度)度量随机线性时不变系统模型输出的分离程度, 分别采用顺序半正定方法和半正定松弛优化方法求解最优辅助信号[28, 43]. Paulson等研究了初始条件不确定的闭环随机线性系统的多故障诊断的辅助信号设计问题[29].

马尔科夫模型可以很好地刻画实际工程系统, 具有重要研究意义. Škach等研究了带有非高斯不确定性的非线性马尔科夫跳变系统的多故障模型主动故障诊断问题, 创新性地使用了序贯蒙特卡罗方法, 与扩展卡尔曼非线性滤波方法相比, 该方法计算成本低, 无线性化误差, 性能稳定[69]. Punčochář 等研究了无限时间范围内随机线性马尔科夫切换系统的主动故障诊断问题[62].

基于贝叶斯决策的辅助信号设计方法能够充分利用系统的先验信息, 相比于早期基于传统假设性检验的随机性辅助信号设计方法, 该方法得到的辅助信号保守性小, 假设条件少, 适用范围广.

2)确定性辅助信号设计

确定性辅助信号设计将系统不确定性、噪声或扰动描述为有界凸集[15, 60]、能量有界形式[39, 70] 或有界的随机变量[61, 71]. 确定性辅助信号的设计目标是使各模型用于故障诊断的输出或状态集合完全分离, 或仅有一个模型的不确定性测度违反约束, 优化目标一般为在保证实现确定性主动故障诊断的基础上, 最小化辅助信号的能量, 使得辅助信号对系统的性能影响最小[14, 23, 47]. 下面根据这三种表示形式分别概述相应的确定性辅助信号设计方法.

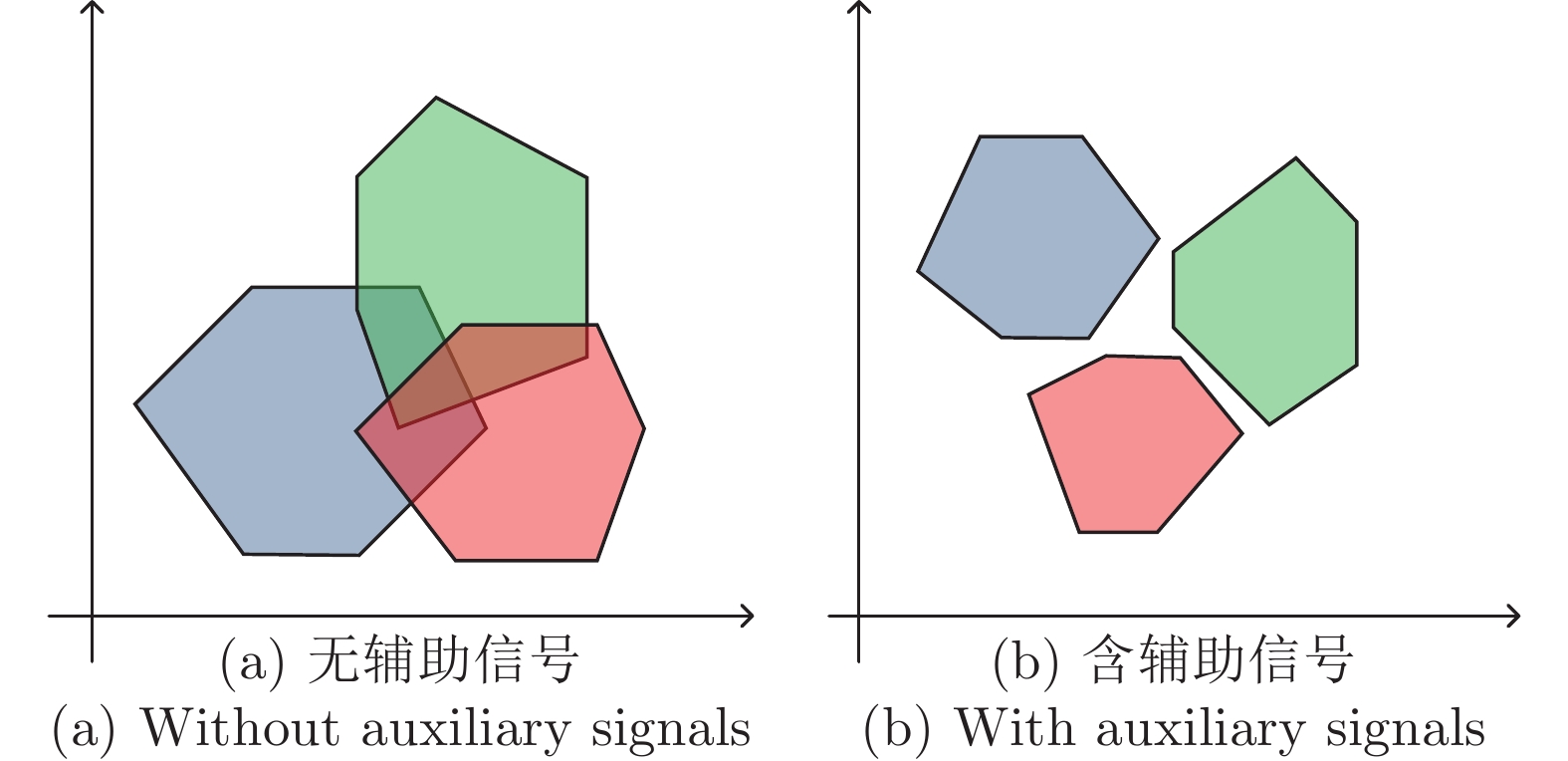

在系统不确定性、噪声或扰动描述为有界凸集的情况下, 模型的输出集合一般也可表示为有界凸集. 如图5所示, 根据给定的标称模型和若干特定故障模型, 设计辅助信号, 使得各模型输出集合完全分离, 即交集为零, 实现确定性故障诊断. 这种基于有界凸集的确定性辅助信号设计方法最早由Nikoukhah于1998年在文献[60]中提出, 文中采用凸多面体集合表示模型的不确定性, 但随着维数的升高, 凸多面体的计算难以实现.

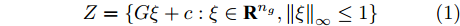

Scott等提出用全对称多胞体来表示模型不确定性, 利用全对称多胞体的性质来简化计算[72]. 其中n维的全对称多胞体定义如下[18]:

$$Z = \left\{ {G\xi + c:\xi \in {{\bf{R}}^{{n_g}}},{{\left\| \xi \right\|}_\infty } \le 1} \right\}$$ (1) 这里

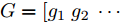

$c\in{\bf{R}}^{n}$ 表示全对称多胞体的中心,$G = [g_{1}\ g_{2}\ \cdots\ $ $g_{n_{g}}] $ 为一组生成器. 在此基础上, Scott等提出基于全对称多胞体的线性离散系统故障诊断方法, 该方法以模型输出全对称多胞体在空间三基准平面上的投影无交集作为模型分离的标准, 以最小化辅助信号的能量作为优化目标, 采用混合整数二次规划算法求解辅助信号[15]. 但该方法为离线设计方法, 没有根据模型输出实时调整辅助信号, 故在一定程度上所求得的辅助信号对系统性能的不良影响较大, 并且混合整数二次规划算法随着二进制变量数目的增多而无法求解. 因此, Marseglia等提出多参数闭环故障诊断方法, 该方法采用在线的设计方式, 每次仅将所求得的部分辅助信号应用至系统, 之后不断在线更新辅助信号, 且利用多参数方法减少了在线计算的复杂度[73].在实际系统中, 绝大多数状态变量和系统输出不满足全对称多胞体的条件, 为推广应用, Scott等采用约束型全对称多胞体表示系统的不确定性、噪声或扰动[14, 74-75], 其中约束型全对称多胞体定义如下:

$$Z = \left\{ {G\xi + c:{{\left\| \xi \right\|}_\infty } \le 1,A\xi = b} \right\}$$ (2) 这里,

$A\xi = b$ 表示对$ \xi $ 的线性约束[74-75]. Raimondo等采用约束型全对称多胞体, 在保证全对称多胞体计算效率的情况下, 将混合整数二次规划算法的应用范围由全对称多胞体不确定性拓展至一般凸多胞体不确定性[14].在系统不确定性、噪声或扰动描述为能量有界形式的情况下, 相应的确定性辅助信号设计方法最早由Nikoukhah等于2000年在文献[39]中提出. 该方法可以应用于具有任意能量有界干扰的线性离散系统, 以包含模型干扰、模型初始状态和辅助信号的二范数作为可分离性指标. 该指标表示分离两个模型的难易程度, 该指标越大, 分离模型越容易; 当该指标为零时, 无法分离两模型, 不存在可实现确定性主动故障诊断的辅助信号. 将可分离性指标作为优化条件, 采用Riccati公式求解该优化问题, 获得能使系统实现确定性故障诊断且能量最小的辅助信号. 此外, Nikoukhah等将上述方法拓展至具有先验信息的线性连续系统的主动故障诊断[70]; Nikoukhah和Campbell将上述方法扩展至线性系统的早期故障诊断[76]; Andjelkovic等将上述方法应用于非线性系统主动故障诊断[47]; Choe等将上述方法拓展至采样系统的主动故障诊断[23].

在系统不确定性、噪声或扰动描述为有界的随机变量的情况下, 将由确定性辅助信号设计方法获得的辅助信号输入至系统, 可实现混合随机性−确定性主动故障诊断(简称为混合性主动故障诊断). 在诊断过程中实现随机性主动故障诊断, 辅助信号的应用使得系统故障诊断率最高, 而在诊断决策点可实现确定性主动故障诊断. 其代表方法为Scott等针对线性离散系统提出的混合性主动故障诊断方法[61]. 该方法将模型不确定性表示为基于有界全对称多胞体的均匀分布随机变量, 通过求解双层规划问题将确定性主动故障诊断条件弱化, 获得在诊断过程中任意一点故障诊断率的下界, 并结合在诊断决策点处的条件, 以最小化辅助信号的能量作为优化目标, 求解相应的辅助信号. 与前面两种确定性设计方法相比, 该方法在不限制诊断时间的条件下, 通过增加辅助信号作用的时间, 减少了辅助信号的能量; 与随机性设计方法相比, 该方法明显缩短了故障检测时间. 但该方法仅适用于均匀分布随机变量的情况, 存在一定的局限性. Marseglia等将此方法拓展至系统不确定性、噪声或扰动表示形式为基于有界全对称多胞体的任意随机变量的线性离散系统[71].

相对于随机性辅助信号设计, 确定性辅助信号设计较为复杂, 计算量大, 且获得的辅助信号较为保守, 但可实现确定性主动故障诊断. 值得注意的是, 在目前的研究中, 确定性辅助信号设计都是针对状态空间模型.

3.2 在线与离线辅助信号设计

目前大多数主动故障诊断方法是离线设计辅助信号后将其直接应用于系统, 在应用过程中并不利用系统最新的状态或输出实时调整辅助信号, 这可能使得故障表现增强过程缓慢, 故障检测时间较长, 辅助信号保守性较高, 对系统性能的不良影响较大. 为此, 有学者提出采用在线辅助信号设计方式, 将离线设计好的辅助信号部分应用于系统, 根据系统最新的测量输出或状态估计实时调整辅助信号, 实现对特定故障的快速诊断, 且辅助信号保守性较低, 对系统性能的不良影响小. 但Nikoukhah等认为在线辅助信号设计重新配置了系统的反馈过程, 可能会导致系统不稳定[39]. 此外, 与离线辅助信号设计相比, 在线辅助信号设计计算量较大. 值得注意的两点: 一是在线辅助信号设计并不意味着所有的计算都需在线完成, 例如状态或输出到辅助信号的反馈可以离线计算, 减少在线计算的负担; 二是在线辅助信号设计并不意味着系统中存在闭环控制, 在线辅助信号设计仅是利用系统最新的输出或状态信息来实时调整离线设计好的辅助信号. 表3给出了在线与离线辅助信号设计方法的部分参考文献.

表 3 在线与离线辅助信号设计Table 3 On-line and off-line auxiliary signals design类型 参考文献 在线辅助信号设计 Ashari et al. (2012)[20], Zhang (1989)[27], Paulson et al. (2018)[29], Šimandl et al. (2005)[49], Nikoukhah et al. (2010)[77], Raimondo et al. (2013)[78], Heirung et al.(2019)[79], Paulson et al. (2017)[80], Wang et al.(2019)[81], Lin et al.(2017)[82] etc. 离线辅助信号设计 Blackmore and Williams (2006)[26], Mesbah et al. (2014)[30], Paulson et al. (2014)[31], Andjelkovic et al. (2008)[47], Blackmore et al. (2008)[63], Nikoukhah and Campbell (2006)[70], Fair and Campbell (2009)[84], Blackmore and Williams (2005)[92] etc. 由于现有的大多数辅助信号设计方法均是离线设计方法, 前一小节已经做过大量介绍, 因此本章节不再对离线辅助信号设计方法过多概述, 主要概述现有的在线辅助信号设计方法[27, 29, 49, 77-82].

针对CARMA模型, Zhang提出了在线辅助信号设计方法, 引入滚动时域技术, 不仅根据当前的系统输出和状态实时调整辅助信号, 而且考虑了系统未来的动态特性[27]. 针对状态空间模型, Šimandl等考虑了基于线性高斯马尔科夫模型的辅助信号设计问题, 采用闭环信息处理策略得到求解最优辅助信号的准则函数, 但最优解往往无法直接求解, 因此采用滚动时域技术来近似设计, 得到在线次优辅助信号[49]. Paulson等提出了针对非线性系统的在线辅助信号设计方法, 并与离线设计的辅助信号对比, 该方法对系统特定故障的诊断性能更加优良[80]. 此外, Paulson等还研究了初始条件不确定的闭环随机线性系统的多故障模型的在线辅助信号设计问题, 以巴氏距离作为各模型输出分布分离程度的度量指标, 通过选择适当的凸二次损失函数, 采用一种快速算法求解全局最优解, 且其计算复杂度与模型数量和每个模型中状态的数量无关[29]. Lin等首次考虑了离散事件系统在线辅助信号设计问题, 并分析了可诊断性, 给出了辅助信号设计算法[82].

为减少在线计算量, Raimondo等采用离线合成方法求解在线设计中反馈的近似显式解, 根据该反馈的近似显式解, 离线计算辅助信号, 直接将得到的辅助信号应用于系统, 其故障检测与诊断性能与完全在线计算的设计方法性能近似, 均保证了在指定时间范围内的故障诊断, 但该方法明显减少了在线计算负担[78].

4. 故障诊断实施

4.1 故障表现增强

与被动故障诊断不同, 主动故障诊断需要将辅助信号注入到系统. 辅助信号设计是主动故障诊断的重要任务, 其目的是将特定故障的表现凸显出来, 以便更准确地实现故障诊断. 下面给出主动故障诊断中故障表现增强的概念.

定义3. 故障表现增强: 通过注入辅助信号, 增强故障特征在系统输入输出数据中的表现, 使得不同模型之间有尽量大的区分度.

故障表现增强是注入辅助信号的结果, 通过分析故障表现增强后的输入输出数据可以有效地进行故障诊断. 目前, 故障表现增强的形式主要有基于概率的形式和基于数据集合的形式. 其中随机性主动故障诊断中多数使用前者, 确定性主动故障诊断中多数使用后者. 除了这两种形式之外, 还有少数其他形式, 如故障特征矩阵、残差信号等.

4.1.1 基于概率的形式

早期的文献多以Kullback判别信息衡量故障表现增强的程度. Uosaki等推导了一种最优辅助信号设计方法, 增加了标称模型和故障模型输出间的Kullback判别信息, 使得故障表现得到增强[34, 67]. Hatanaka等将该方法扩展到多个故障情况, 通过设计最优辅助信号, 得到标称模型和各故障模型之间最小距离的最大值, 以便在最坏情况下也能正常工作, 从而增加了故障检测的鲁棒性[46, 66].

与Kullback判别信息类似, KL散度也是一种衡量两个概率分布之间统计距离的常用方法, 因此KL散度也可以衡量随机性主动故障诊断中的故障表现增强程度. Kim等研究了具有加性高斯扰动或噪声的线性随机动态系统的主动故障诊断问题, 将各故障模型和标称模型均看作高斯过程, 使用KL散度度量两个高斯过程之间的统计距离, 距离越远, 误报的概率越低, 即故障表现增强的效果越好[28, 43].

与前面介绍的衡量故障表现增强的方法不同, 模型选择错误概率的大小也是目前广泛应用的故障表现增强的衡量标准, 具体做法是将随机性主动故障诊断问题转换为一个约束优化问题, 以最小化选择错误模型的概率为优化目标.

Paulson等利用贝叶斯风险量化选择错误模型的概率, 通过设计合适的辅助信号, 减小选择错误模型的概率, 实现故障表现增强, 从而有效地进行故障检测和诊断[80]. Punčochář等研究了离散随机系统的主动故障诊断问题, 设计一种由决策产生器和辅助信号发生器组成的故障检测器, 故障检测器的输出包含了故障表现增强后的信息, 从而判断该系统是否发生了故障[62, 69, 83].

4.1.2 基于数据集合的形式

在确定性主动故障诊断中, 理想的情况下, 对系统施加辅助信号之后, 不同模型的测量数据应当位于不相交的集合中[39]. 但若辅助信号设计不合适, 不同模型的数据集合可能会有一定重合, 这会导致无法实现确定性故障诊断. 因此, 可将各模型数据集合的分离程度作为衡量故障表现增强的标准, 通过设计合适的辅助信号, 使得各模型的数据集合尽可能完全分离, 实现故障表现增强.

Fair等将故障检测看为两模型分类问题, 每个模型的输出集构成有界凸集, 向系统注入辅助信号后, 可得到不相交的输出集, 即实现了故障表现增强[84]. Scola等将多个测量数据写为向量的形式, 定义了两个不相交的凸多面体, 将故障检测问题简化为判断该向量属于哪个多面体的问题, 故障表现增强的要求是正确划分该向量的归属[85]. Raimondo等提出了一种用于计算辅助信号的滚动时域方法, 把不同故障模型的状态值限制在相应的集合中, 对于不同的模型, 数据集合是不相交的, 从而实现了故障表现增强[78].

Tabatabaeipour和Wang等利用集成员的方法对系统的输出值进行度量, 将输出集合描述为集成员框架下的椭圆体, 故障表现增强是将各模型间的输出椭圆体尽可能分离, 因此可通过实际系统的输出椭圆体与标称(或故障)模型的输出椭圆体之间的分离程度判断实际系统所处的状态[86-87].

在混合性主动故障诊断中, 对于诊断过程而言, 注入辅助信号使得输出集合与模型匹配的概率值最大, 对于决策点而言, 注入辅助信号使得系统输出尽可能限制在一个集合内, 从而实现了故障表现增强[61].

4.1.3 其他形式

1)故障特征矩阵

Niemann等提出用故障特征矩阵作为系统故障特征. 通过设计辅助信号, 检测故障特征矩阵是否为零从而实现故障检测与诊断[40, 45, 53]. 在MIMO闭环系统的主动故障诊断中, 利用YJBK参数化方法设计四参数控制器和辅助信号, 同时得到故障特征矩阵. 当无故障时, 该矩阵为零, 当故障发生时, 该矩阵不为零, 从而实现了故障表现增强.

2)残差信号

目前大多数主动故障诊断技术均通过模型分离的形式来实现, 不需要利用被动故障诊断中所用的残差信号. 近年来也有文献通过设计辅助信号和残差产生器并分析辅助信号作用于系统后产生的残差来实现主动故障诊断[42, 88]. 故障表现增强的结果是产生的残差对故障更加敏感.

在被动故障诊断中, 有些故障可能很难被利用输入输出数据生成的残差指示出来, Yang等通过设计合适的辅助信号, 使得残差对故障更为敏感, 提高了故障诊断的性能[88]. Blanchini等将残差生成器与基于数据集合的主动故障诊断方法相结合, 设计残差生成器, 并将不同模型生成的残差限制在不同集合中, 每个集合对应一个系统模型, 可以通过注入辅助信号来保证集合的分离, 从而实现故障表现增强[42].

4.2 故障诊断

在目前的主动故障诊断中, 基本以故障检测为主要目标, 即判断故障有无. 主动故障诊断通过设计合适的辅助信号并施加至系统, 分析系统输入输出数据来实现. 故障检测过程被视为两类模型的分类问题, 即分离故障模型和标称模型, 故障分离过程被视为多模型分类问题, 即分离各个故障模型和标称模型. 目前学者已经提出了众多被动故障诊断的算法, 如状态估计、参数估计、等价空间、多元统计分析、信号处理等方法, 并取得了一定的应用成果[6, 89]. 主动故障检测可参考被动故障检测的方法, 并结合辅助信号设计, 使得检测性能得到进一步提高.

主动故障分离与主动故障检测类似, 主动故障检测是分离两类模型, 目前主动故障分离的做法是研究多故障模型的分离问题, 将各个故障模型和标称模型两两分开. 可通过设计一个辅助信号将所有模型分离, 也可通过设计多个辅助信号使各模型互相分离.

故障辨识是在故障分离之后, 确定故障的大小以及故障发生的时间. 但是在现有的主动故障诊断方法中, 大多假设已知故障模型信息, 因此故障辨识是与故障检测和分离一体化设计的. 在实际应用中, 若故障模型未知, 现有的方法无法进行故障辨识, 因此故障模型未知的主动故障辨识问题是主动故障诊断的研究难点之一.

4.3 典型实例

目前, 主动故障诊断理论仍处于发展初期, 尚待完善, 主动故障诊断技术在实际工程中的应用实例较少. 表4中列出了目前主动故障诊断一些典型应用对象.

表 4 主动故障诊断典型实例Table 4 Typical examples of active fault diagnosis系统 参考文献 飞行器 Kim and Braatz (2013)[43], Jacobson and Nett (1991)[51], Blackmore et al. (2008)[63], Blackmore and Williams (2005)[92] 电机 Campbell et al. (2006)[50], Nikoukhah et al. (2010)[77], Yang et al. (2014)[88] 水箱系统 Mesbah et al. (2014)[30], Paulson et al. (2014)[31], Palmer and Bollas (2019)[90] 钟摆系统 Škach et al. (2017)[69], Punčochář and Šimandl (2014)[83] 弹簧系统 Niemann (2006)[40], Blanchini et al. (2017)[42], Niemann and Poulsen (2014)[45] 化工过程 Zhang (1989)[27], Paulson et al. (2017)[80], Martin-Casas and Mesbah (2018)[91] 5. 总结与展望

现有被动故障诊断方法由于自身的局限性导致诊断能力较弱、工程应用困难, 而主动故障诊断方法能够很好地弥补被动故障诊断的不足, 通过设计辅助信号注入系统, 激发特定的故障表现, 然后利用一定的诊断算法对系统的输入输出数据进行分析, 从而得到诊断结果. 本文对动态系统的主动故障诊断技术进行了概述, 对主动故障诊断的思想、辅助信号的特征、辅助信号的设计方法及主动故障诊断的实施进行了详细介绍. 目前主动故障诊断仍处于探索阶段, 现有研究成果主要针对故障信息已知的特定故障, 而且工程应用较少. 面对工程系统越来越复杂的趋势, 对于主动故障诊断技术的研究与应用提出了更高的要求. 下面将对主动故障诊断的一些未来研究方向进行展望.

1)故障可检测性、故障可诊断性的理论研究

目前尚缺乏故障可检测性、故障可诊断性的权威定义, 且理论研究成果较少, 因此故障可检测性、故障可诊断性的理论研究是未来的研究重点之一. 其中, 一定方法框架下的充分条件、主动故障诊断中可诊断性的数学描述、特定假设下故障可诊断性的充要条件是迫切需要解决的挑战性问题.

2)主动故障分离、估计和辨识的理论研究

目前在主动故障诊断成果中, 故障检测多, 故障分离、估计和辨识较少. 故障分离、估计和辨识对系统在发生故障后对故障的准确定位和及时处理至关重要, 因此主动故障分离、估计和辨识的理论研究具有重要意义.

3)基于随机辅助信号的主动故障诊断

现有的主动故障诊断方法中, 辅助信号基本为非随机信号, 如正弦信号、分段恒定信号等, 只能增强特定故障表现, 这给主动故障诊断的研究带来了一定的局限性. 当辅助信号为随机信号时, 可以通过分析输出信号的均值、方差、概率密度函数、相关函数和功率谱密度等统计特性来判断系统是否存在多种故障并进一步分析故障的位置和大小等. 因此研究辅助信号为随机信号的主动故障诊断具有重要意义.

4)系统友好型辅助信号设计

很多工业系统, 如石油化工过程、火力发电系统等, 无法将原有输入置零然后施加辅助信号进行故障诊断, 必须保持系统的运行状态, 因此只能进行系统友好型辅助信号设计, 需要考虑与输入信号的联合设计, 但是目前该类辅助信号设计方法的研究较少. 因此研究系统友好型辅助信号设计是十分必要的, 也是主动故障诊断未来的重要发展方向之一.

5)针对微小故障的主动故障诊断

由于系统不确定性的存在, 由微小故障引起的系统变化与系统噪声或扰动引起的系统变化难以区分, 主动故障诊断方法可利用辅助信号激发故障在系统输出中的表现, 是解决微小故障检测的潜在途径. 但由于微小故障幅值过小, 故障表现增强的效果可能仍不明显, 针对微小故障的主动故障诊断有待进一步研究.

-

表 1 针对所提算法网络结构自身差异对比

Table 1 Contrast the differences of the network structure of the proposed algorithm

网络结构差异 mAP0.5 mAP0.7 DR ACC TDDNET (Soft-NMS) 0.9415 0.9235 0.9082 0.9370 TDDNET (NMS) 0.9358 0.9208 0.9004 0.9274 DDNET (NMS, 无迁移) 0.9137 0.9009 0.8503 0.9180 TDDNET(无可变形卷积) 0.8827 0.8506 0.8532 0.8728 表 2 针对所提算法中在不同层使用可变形卷积模型的差异

Table 2 Aiming at the difference of using deformable convolution network in different layers of the proposed algorithm

可变形卷积网络层 mAP0.5 mAP0.7 DR ACC TDDNET完整框架 0.9415 0.9235 0.9082 0.9370 TDDNET框架(除Res2c) 0.9402 0.9174 0.9004 0.9304 Res5 $(a, b, c)+$ PS RoI 0.9258 0.9076 0.8939 0.9186 PS RoI 0.9106 0.8902 0.8899 0.8960 Res5 $(a, b, c)$ 0.8802 0.8609 0.8693 0.8901 表 3 所提算法与其他目标检测算法的实验结果

Table 3 Experimental results of the proposed algorithm and other target detection algorithms

对比算法 mAP0.5 mAP0.7 DR ACC Faster R-CNN [12] 0.7879 0.7418 0.8308 0.7845 Faster R-CNN* 0.8207 0.7932 0.8554 0.8144 R-FCN [22] 0.8650 0.8405 0.8650 0.8911 R-FCN* 0.8957 0.8594 0.8747 0.9087 FPN [24] 0.8926 0.8644 0.8994 0.9057 FPN* 0.9288 0.9261 0.8982 0.9206 SSD [25] 0.7794 0.7013 0.8648 0.7564 YOLO-v3 [17] (ResNet50) 0.7787 0.7785 0.8751 0.7956 YOLO-v3 [17] (DarkNet) 0.7889 0.7822 0.8746 0.8050 TDDNET 0.9415 0.9235 0.9082 0.9370 -

[1] 寿建新, 周尧, 李宇飞.世界蝴蝶分类名录.陕西:陕西科学技术出版社, 2006Shou Jian-Xin, Zhou Yao, Li Yu-Fei. Systematic butterffly names of the world. Shaanxi:Shaanxi Science and Technology Press, 2006 [2] 马方舟, 徐海根, 陈萌萌.全国蝴蝶多样性观测网络(China BON-Butterflies)建设进展.生态与农村环境学报, 2018, 34(1):27-36 http://d.old.wanfangdata.com.cn/Periodical/ncsthj201801004Ma Fang-Zhou, Xu Hai-Geng, Chen Meng-Meng. Progress in construction of china butterfly diversity observation network (China BON-Butterflies). Journal of Ecology and Rural Environment, 2018, 34(1):27-36 http://d.old.wanfangdata.com.cn/Periodical/ncsthj201801004 [3] Kang S H, Cho J H, Lee S H. Identification of butterfly based on their shapes when viewed from different angles using an artificial neural network. Journal of Asia-Pacific Entomology, 2014, 17(2):143-149 doi: 10.1016/j.aspen.2013.12.004 [4] Kaya Y, Kayci L, Uyar M. Automatic identification of butterfly species based on local binary patterns and artificial neural network. Applied Soft Computing, 2015, 28:132-137 doi: 10.1016/j.asoc.2014.11.046 [5] 李凡.基于数字图像的蝴蝶种类自动识别研究[硕士学位论文], 北京林业大学, 中国, 2015Li Fan. The research on automatic identification of butterfly species based on the digital image[Master dithesis], Beijing Forestry University, China, 2015 [6] 孙晓, 潘汀, 任福继.基于ROI-KNN卷积神经网络的面部表情识别.自动化学报, 2016, 42(6):883-891 http://www.aas.net.cn/CN/abstract/abstract18879.shtmlSun Xiao, Pan Ting, Ren Fu-Ji. Facial expression recognition using ROI-KNN deep convolutional neural networks. Acta Automatica Sinica, 2016, 42(6):883-891 http://www.aas.net.cn/CN/abstract/abstract18879.shtml [7] 张慧, 王坤峰, 王飞跃.深度学习在目标视觉检测中的应用进展与展望.自动化学报, 2017, 43(8):1289-1305 http://www.aas.net.cn/CN/abstract/abstract19104.shtmlZhang Hui, Wang Kun-Feng, Wang Fei-Yue. Advances and perspectives on applications of deep learning in visual object detection. Acta Automatica Sinica, 2017, 43(8):1289-1305 http://www.aas.net.cn/CN/abstract/abstract19104.shtml [8] 常亮, 邓小明, 周明全, 武仲科, 袁野, 等.图像理解中的卷积神经网络.自动化学报, 2016, 42(9):1300-1312 http://www.aas.net.cn/CN/abstract/abstract18919.shtmlChang Liang, Deng Xiao-Ming, Zhou Ming-Quan Wu Zhong-Ke, Yuan Ye, et al. Convolutional neural networks in image understanding. Acta Automatica Sinica, 2016, 42(9):1300-1312 http://www.aas.net.cn/CN/abstract/abstract18919.shtml [9] Liu Z Y, Gao J F, Yang G G. Localization and classification of paddy field pests using a saliency map and deep convolutional neural network. Scientific Reports, 2016, 6:204-210 [10] 周爱明, 马鹏鹏, 席天宇, 王江宁, 冯晋, 邵泽中, 等.基于深度学习的蝴蝶科级标本图像自动识别.昆虫学报, 2017, 60(11):1339-1348 http://d.old.wanfangdata.com.cn/Periodical/kcxb201711012Zhou Ai-Ming, Ma Peng-Peng, Xi Tian-Yu, Wang Jiang-Ning, Feng Jin, Shao Ze-Zhong, et al. Automatic identification of butterfly specimen images at the family level based on deep learning method. Acta Entomologica Sinica, 2017, 60(11):1339-1348 http://d.old.wanfangdata.com.cn/Periodical/kcxb201711012 [11] 谢娟英, 侯琦, 史颖欢, 吕鹏, 景丽萍, 庄福振, 等.蝴蝶种类自动识别研究.计算机研究与发展, 2018, 55(8):1609-1618 http://d.old.wanfangdata.com.cn/Periodical/jsjyjyfz201808002Xie Juan-Ying, Hou Qi, Shi Ying-Huan, Lv Peng, Jing Li-Ping, Zhuan Fu-Zhen, et al. The automatic identification of butterfly species. Journal of Computer Research and Development, 2018, 55(8):1609-1618 http://d.old.wanfangdata.com.cn/Periodical/jsjyjyfz201808002 [12] Ren S Q, He Kai-Ming, Gitshick R. Faster R-CNN:Towards real-time object detection with region proposal networks. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2017, 39(6):1137-1149 [13] Zeiler M D, Fergus R. Visualizing and understanding convolutional networks. In: Proceedings of the 13th European Conference on Computer Vision, Zurich, Switzerland: Springer Verlag, 2014. 818-833 [14] Chatfield, Ken. Return of the devil in the details: Delving deep into convolutional nets. arXiv preprint, arXiv: 1405.3531, 2014 [15] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition. arXiv preprint, arXiv: 1409.1556, 2015 [16] Redmon J, Farhadi A. YOLO9000: better, faster, stronger. In: Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, Hawaii, USA: IEEE, 2017. 6517-6525 [17] Redmon J, Farhadi A. YOLO-v3: An incremental improvement. arXiv preprint, arXiv: 1804.02767, 2018 [18] He Kai-Ming, Zhang Xiang-Yu, Ren Shao-Ping. Deep residual learning for image recognition. In: Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, Nevada, USA: IEEE, 2016. 770-778 [19] Bodla N, Singh B, Chellappa R. Soft-NMS: Improving object detection with one line of code. In: Proceedings of the 2017 IEEE International Conference on Computer Vision, Venice, Italy: IEEE, 2017. 5562-5570 [20] Dai J F, Qi H Z, Xiong Y W. Deformable convolutional networks. In: Proceedings of the 2017 IEEE International Conference on Computer Vision, Venice, Italy: IEEE, 2017. 764-773 [21] Jadergarg M, Simonyan K, Zisserman A. Spatial transformer networks. In: Proceedings of the 30th Annual Conference on Neural Information Processing Systems, Barcelona, Spain: Curran Associates, Inc. 2016. 2017-2025 [22] Dai J F, Li Y, He K M. R-FCN: Object detection via region-based fully convolutional networks. In: Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA: IEEE, 2016. 379-387 [23] Shrivastava A, Gupta A, Girshick R. Training region-based object detectors with online hard example mining. In: Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, Nevada, USA: IEEE, 2016. 761-769 [24] Lin T Y, Dollar P, Girshick R B. Feature pyramid networks for object detection. In: Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, Hawaii, USA: IEEE, 2017. 936-944 [25] Liu W, Anguelov D, Erhan D. SSD: Single shot multibox detector. In: Proceedings of the 13th European conference on computer vision, Amsterdam, the Netherlands: Springer Verlag, 2016. 21-37 [26] 刘丽, 赵凌君, 郭承玉, 王亮, 汤俊.图像纹理分类方法研究进展和展望.自动化学报, 2018, 44(4):584-607 http://www.aas.net.cn/CN/abstract/abstract19252.shtmlLiu Li, Zhao Ling-Jun, Guo Cheng-Yu, Wang Liang, Tang Jun. Texture classification:state-of-the-art methods and prospects. Acta Automatica Sinica, 2018, 44(4):584-607 http://www.aas.net.cn/CN/abstract/abstract19252.shtml [27] 罗建豪, 吴建鑫.基于深度卷积特征的细粒度图像分类研究综述.自动化学报, 2017, 43(8):1306-1318 http://www.aas.net.cn/CN/abstract/abstract19105.shtmlLuo Jian-Hao, Wu Jian-Xin. A survey on fine-grained image categorization using deep convolutional features. Acta Automatica Sinica, 2017, 43(8):1306-1318 http://www.aas.net.cn/CN/abstract/abstract19105.shtml [28] Yu Fisher, Vladlen Koltun, Thomas Funkhouser. Dilated residual networks. In: Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, Hawaii, USA: IEEE, 2017. 636-644 [29] Zhou Y Z, Ye Q X, Qiu Q, Jiao J B. Oriented response networks. In: Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, Hawaii, USA: IEEE, 2017. 4961-4970 [30] Jeon Y, Kim J. Active convolution: Learning the shape of convolution for image classification. In: Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, Hawaii, USA: IEEE, 2017. 1846-1854 [31] He K M, Gkioxari G, Dollar P. Mask r-cnn. In: Proceedings of the 2017 IEEE International Conference on Computer Vision, Venice, Italy: IEEE, 2017. 2980-2988 [32] 李策, 张亚超, 蓝天, 杜少毅.一种高分辨率遥感图像视感知目标检测算法.西安交通大学学报, 2018, 6(52):9-16 http://d.old.wanfangdata.com.cn/Periodical/xajtdxxb201806002Li Ce, Zhang Ya-Chao, Lan Tian, Du Shao-Yi. An object detection algorithm with visual perception for high-resolution remote sensing images. Journal of Xi'an Jiaotong University, 2018, 6(52):9-16 http://d.old.wanfangdata.com.cn/Periodical/xajtdxxb201806002 [33] Kim S W, Kook H K. Parallel feature pyramid network for object detection. In: Proceedings of the 15th European Conference on Computer Vision, Munich, Germany: Springer Verlag, 2018. 234-250 [34] Cai Z W, Nuno V. Cascade R-CNN: Delving into high quality object detection. In: Proceedings of the 2018 IEEE Conference on Computer Vision and Pattern Recognition, Salt Lake, USA: IEEE, 2018. 6154-6162 [35] Szegedy C, Ioffe S, Vanhoucke V. Inception-v4, inception-resnet and the impact of residual connections on learning. In: Proceedings of the 31st AAAI Conference on Artificial Intelligence, San Francisco, California, USA: AAAI, 2017. 4278-4284 [36] Xie S N, Girxhick R, Dollar P. Aggregated residual transformations for deep neural networks. In: Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, Hawaii, USA: IEEE, 2017. 5987-5995 [37] Zhou P, Ni B B. Scale-transferrable object detection. In: Proceedings of the 2018 IEEE Conference on Computer Vision and Pattern Recognition, Salt Lake, USA: IEEE, 2018. 528-537 [38] Bharat Singh, Larry S. Davis. An Analysis of Scale Invariance in Object Detection SNIP. In: Proceedings of the 2018 IEEE Conference on Computer Vision and Pattern Recognition, Salt Lake, USA: IEEE, 2018. 3578-3587 期刊类型引用(12)

1. 陈克琼,卓士虎,赵晨曦,傅立涛,王家铭,李帷韬. 融合深度迁移学习和改进ThunderNet的瓷砖表面缺陷检测. 电子测量与仪器学报. 2024(03): 208-218 .  百度学术

百度学术2. 许翔,蒲智,鲁文蕊,王亚波. 基于改进Vision Transformer的蝴蝶品种分类. 电脑知识与技术. 2024(16): 1-5 .  百度学术

百度学术3. 郭子豪,董乐乐,曲志坚. 基于改进Faster RCNN的节肢动物目标检测方法. 计算机应用. 2023(01): 88-97 .  百度学术

百度学术4. 刘懿,任济寰,吴祥,薄煜明. 基于集成迁移学习的新装备装甲车辆分类. 兵工学报. 2023(08): 2319-2328 .  百度学术

百度学术5. 杨大为,蔡宇. 基于迁移学习与改进型AlexNet的蝴蝶分类算法. 信息与控制. 2023(04): 514-524 .  百度学术

百度学术6. 陈利,刘艳艳. 基于改进的Faster R-CNN的古建筑地砖缺陷检测. 电子技术应用. 2021(01): 31-35 .  百度学术

百度学术7. 罗维平,徐洋,陈永恒,周博,马双宝,吴雨川. 基于迁移学习和改进ResNet50网络的织物疵点检测算法. 毛纺科技. 2021(02): 71-78 .  百度学术

百度学术8. 王文庆,庞颖,刘洋,马晓华. 基于可变形卷积的图像边缘智能提取方法. 西安邮电大学学报. 2021(01): 84-89+103 .  百度学术

百度学术9. 陈慧. 基于深度学习算法的高校人才个性化智能推荐系统. 电子设计工程. 2021(21): 38-42 .  百度学术

百度学术10. 刘晨,赵晓晖,梁乃川,张永新. 基于ResNet50和迁移学习的岩性识别与分类研究. 计算机与数字工程. 2021(12): 2526-2530+2578 .  百度学术

百度学术11. 郑鑫,潘斌,张健. 可变形网络与迁移学习相结合的电力塔遥感影像目标检测法. 测绘学报. 2020(08): 1042-1050 .  百度学术

百度学术12. 谭镭,孙怀江. SKASNet:用于语义分割的轻量级卷积神经网络. 计算机工程. 2020(09): 261-267 .  百度学术

百度学术其他类型引用(19)

-

下载:

下载:

下载:

下载: