-

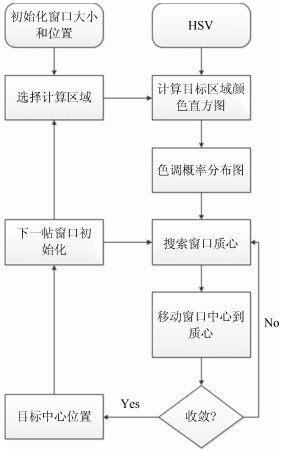

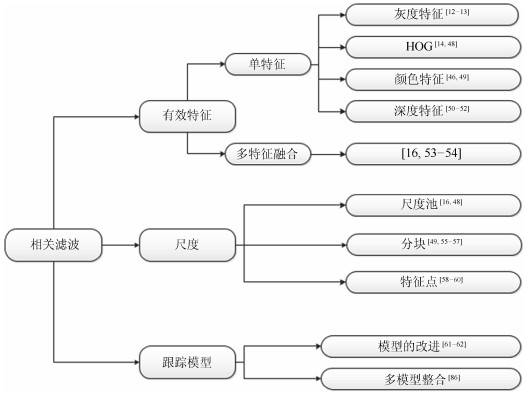

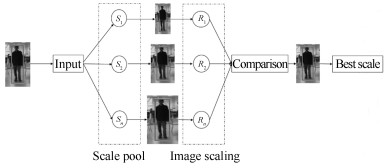

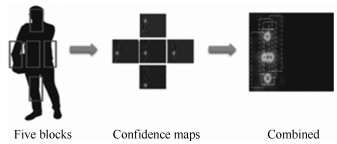

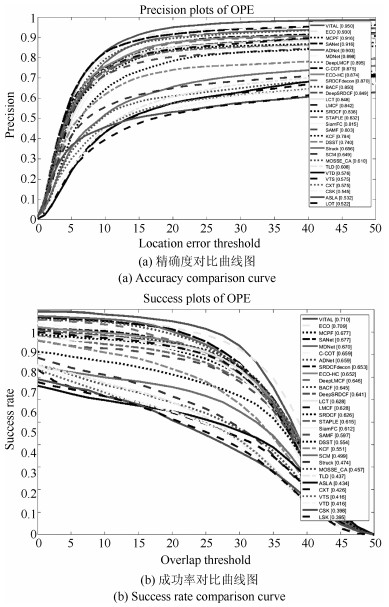

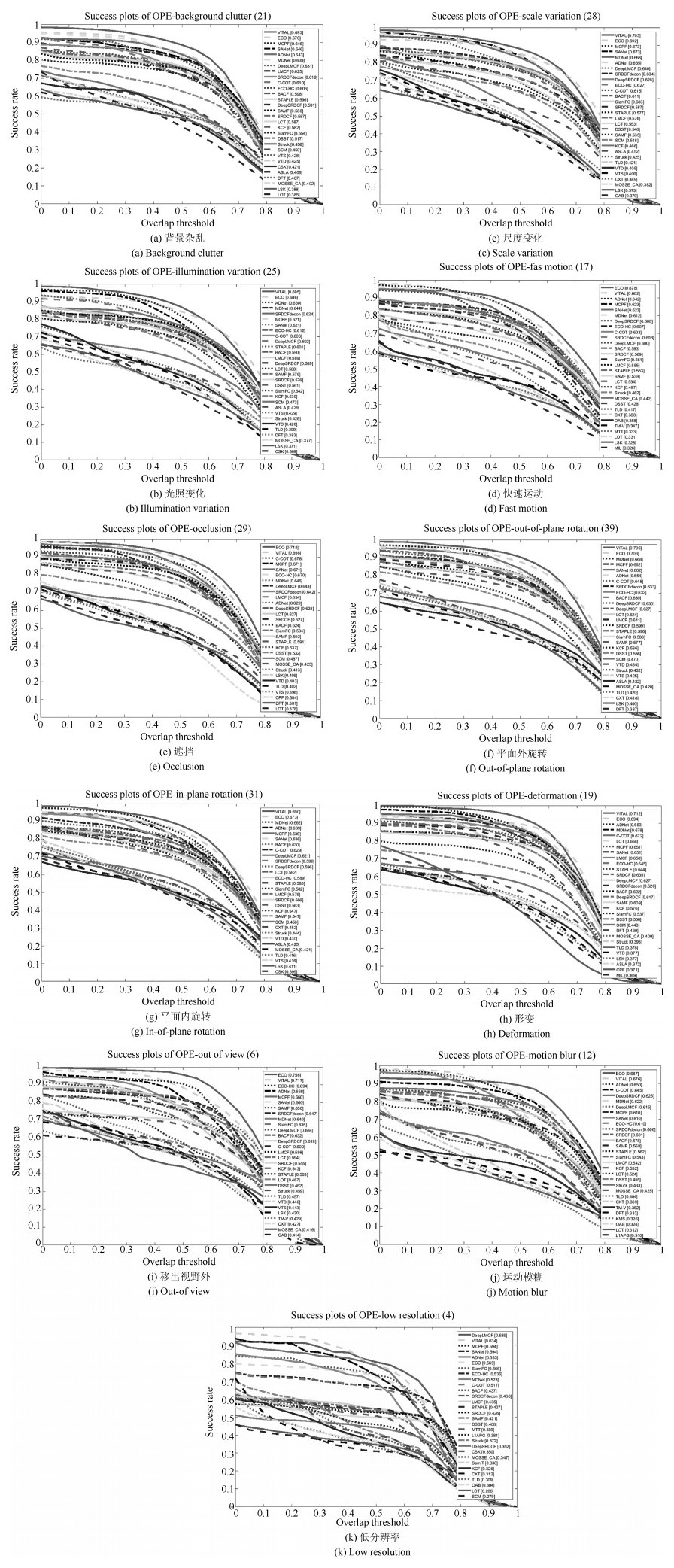

摘要: 目标跟踪一直以来都是计算机视觉领域的关键问题,最近随着人工智能技术的飞速发展,运动目标跟踪问题得到了越来越多的关注.本文对主流目标跟踪算法进行了综述,首先,介绍了目标跟踪中常见的问题,并由时间顺序对目标跟踪算法进行了分类:早期的经典跟踪算法、基于核相关滤波的跟踪算法以及基于深度学习的跟踪算法.接下来,对每一类中经典的跟踪算法的原始版本和各种改进版本做了介绍、分析以及比较.最后,使用OTB-2013数据集对目标跟踪算法进行测试,并对结果进行分析,得出了以下结论:1)相比于光流法、Kalman、Meanshift等传统算法,相关滤波类算法跟踪速度更快,深度学习类方法精度高.2)具有多特征融合以及深度特征的追踪器在跟踪精度方面的效果更好.3)使用强大的分类器是实现良好跟踪的基础.4)尺度的自适应以及模型的更新机制也影响着跟踪的精度.Abstract: Object tracking has always been a key issue in the computer vision field. Recently, with the rapid development of artificial intelligence, the issue of moving object tracking has attracted more and more attention. This paper reviews the main object tracking algorithms. Firstly, we introduce the common problems in object tracking and classify the object tracking algorithms into three groups:early object tracking algorithms, kernelized correlation filters (KCF) object tracking algorithms, deep learning object tracking algorithms. Then, according to the three groups, we introduce and analyze many famous object tracking algorithms and their following improved versions. Finally, we analyze and compare the performance from many object tracking algorithms using dataset OTB-2013, and conclude that:1) Compared with the optical flow method, Kalman, meanshift and other early algorithms, the tracking speed of KCF-based algorithms are faster and the deep learning based algorithms have higher accuracy. 2) The tracking algorithms with multiple feature fusion or deep features have higher tracking accuracy. 3) Powerful classifiers are the basis for good tracking results. 4) Scale adaptation and updating mechanism also affect tracking accuracy.1) 本文责任编委 桑农

-

表 1 各种目标跟踪算法的速度比较

Table 1 Speed comparison of various object tracking algorithms

基于相关滤波 AUC FPS 基于深度学习 AUC FPS MCPF[83] 0.677 0.5 VITAL[78] 0.710 1.5 BACF[15] 0.645 35 ECO[19] 0.709 6 LMCF[64] 0.628 85 SANet[81] 0.677 1 LCT[65] 0.628 27 MDNet[80] 0.670 1 SAMF[16] 0.597 7 C-COT[72] 0.659 0.3 DSST[50] 0.554 24 ADNet[84] 0.659 3 KCF[14] 0.551 172 HDT[85] 0.654 10 CSK[13] 0.398 368 SRDCFdecon[63] 0.653 1 MOSSE[12] 0.357 669 CF2[66] 0.562 11 ECO-HC[19] 0.652 20 DeepLMCF[64] 0.646 8 DeepSRDCF[62] 0.641 0.3 SiamFC[73] 0.612 58 DRT[63] 0.581 0.4 -

[1] Yang H X, Shao L, Zheng F, Wang L, Song Z. Recent advances and trends in visual tracking:a review. Neurocomputing, 2011, 74(18):3823-3831 doi: 10.1016/j.neucom.2011.07.024 [2] Smeulders A W M, Chu D M, Cucchiara R, Calderara S, Dehghan A, Shah M. Visual tracking:an experimental survey. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 36(7):1442-1468 doi: 10.1109/TPAMI.2013.230 [3] Choi J Y, Sung K S, Yang Y K. Multiple vehicles detection and tracking based on scale-invariant feature transform. In: Proceedings of the 2007 IEEE Intelligent Transportation Systems Conference. Seattle, WA, USA: IEEE, 2007. 528-533 [4] Bay H, Tuytelaars T, Van Gool L. SURF: speeded up robust features. In: Proceeding of Computer Vision-ECCV 2006. Lecture Notes in Computer Science, vol. 3951. Berlin, Heidelberg: Germany Springer, 2006. 404-417 [5] Nguyen M H, Wünsche B, Delmas P, Lutteroth C. Modelling of 3D objects using unconstrained and uncalibrated images taken with a handheld camera. In: Proceedings of the Computer Vision, Imaging and Computer Graphics. Communications in Computer and Information Science, vol.274. Berlin, Heidelberg: Springer, 2011. 86-101 [6] Kass M, Witkin A, Terzopoulos D. Snakes:active contour models. International Journal of Computer Vision, 1988, 1(4):321-331 doi: 10.1007/BF00133570 [7] Welch G, Bishop G. An Introduction to the Kalman Filter. Chapel Hill, NC, USA: University of North Carolina at Chapel Hill, 2001. [8] Nummiaro K, Koller-Meier E, Van Gool L. An adaptive color-based particle filter. Image and Vision Computing, 2003, 21(1):99-110 doi: 10.1016/S0262-8856(02)00129-4 [9] Du K, Ju Y F, Jin Y L, Li G, Li Y Y, Qian S L. Object tracking based on improved MeanShift and SIFT. In: Proceedings of the 2nd International Conference on Consumer Electronics, Communications and Networks. Yichang, China: IEEE, 2012. 2716-2719 [10] 李冠彬, 吴贺丰.基于颜色纹理直方图的带权分块均值漂移目标跟踪算法.计算机辅助设计与图形学学报, 2011, 23(12):2059-2066 http://d.old.wanfangdata.com.cn/Periodical/jsjfzsjytxxxb201112017Li Guan-Bin, Wu He-Feng. Weighted fragments-based meanshift tracking using color-texture histogram. Journal of Computer-Aided Design and Computer Graphics, 2011, 23(12):2059-2066 http://d.old.wanfangdata.com.cn/Periodical/jsjfzsjytxxxb201112017 [11] Exner D, Bruns E, Kurz D, Grundhöfer A, Bimber O. Fast and robust CAMShift tracking. In: Proceedings of the 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco, CA, USA: IEEE, 2010. 9-16 [12] Bolme D S, Beveridge J R, Draper B A, Lui Y M. Visual object tracking using adaptive correlation filters. In: Proceedings of the 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco, CA, USA: IEEE, 2010. 2544-2550 [13] Henriques J F, Caseiro R, Martins P, Batista J. Exploiting the circulant structure of tracking-by-detection with kernels. In: Proceedings of Computer Vision. Lecture Notes in Computer Science, vol.7575. Berlin, Heidelberg: Springer, 2012. 702-715 [14] Henriques J F, Caseiro R, Martins P, Batista J. High-speed tracking with kernelized correlation filters. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3):583-596 doi: 10.1109/TPAMI.2014.2345390 [15] Galoogahi H K, Fagg A, Lucey S. Learning background-aware correlation filters for visual tracking. In: Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice, Italy: IEEE, 2017. 1144-1152 [16] Li Y, Zhu J. A scale adaptive kernel correlation filter tracker with feature integration. In: Proceedings of Computer Vision, Lecture Notes in Computer Science, vol.8926. Zurich, Switzerland: Springer, 2014. 254-265 [17] Wu Y, Lim J, Yang M H. Online object tracking: a benchmark. In: Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Portland, USA: IEEE, 2013. 2411-2418 [18] Kristan M, Matas J, Leonardis A, Felsberg M, Cehovin L, Fernandez G, et al. The visual object tracking VOT2015 challenge results. In: Proceedings of the 2015 IEEE International Conference on Computer Vision Workshop. Santiago, USA: IEEE, 2015. 564-586 [19] Yun S, Choi J, Yoo Y, Yun K M, Choi J Y. Action-decision networks for visual tracking with deep reinforcement learning. In: Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA: IEEE, 2017. 1349-1358 [20] Kristan M, Leonardis A, Matas J, Felsberg M, Pflugfelder R, Zajc L C, et al. The visual object tracking VOT2017 challenge results. In: Proceedings of the 2017 IEEE International Conference on Computer Vision Workshop. Venice, Italy: IEEE, 2017. 1949-1972 [21] Zhang S P, Yao H X, Sun X, Lu X S. Sparse coding based visual tracking:review and experimental comparison. Pattern Recognition, 2013, 46(7):1772-1788 doi: 10.1016/j.patcog.2012.10.006 [22] Gong H F, Sim J, Likhachev M, Shi J B. Multi-hypothesis motion planning for visual object tracking. In: Proceedings of the 2011 International Conference on Computer Vision. Barcelona, Spain: IEEE, 2011. 619-626 [23] Sun D Q, Roth S, Black M J. Secrets of optical flow estimation and their principles. In: Proceedings of the 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco, CA: IEEE, 2010. 2432-2439 [24] Xu L, Jia J Y, Matsushita Y. Motion detail preserving optical flow estimation. In: Proceedings of the 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco, CA, USA: IEEE, 2010. 1293-1300 [25] Choi J, Kwon J, Lee K M. Visual tracking by reinforced decision making. Advances in Visual Computing, 2014. 270-280 [26] Babenko B, Yang M H, Belongie S. Robust object tracking with online multiple instance learning. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(8):1619-1632 doi: 10.1109/TPAMI.2010.226 [27] Kalal Z, Mikolajczyk K, Matas J. Tracking-learning-detection. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(7):1409-1422 doi: 10.1109/TPAMI.2011.239 [28] Avidan S. Support vector tracking. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2004, 26(8):1064-1072 doi: 10.1109/TPAMI.2004.53 [29] Hare S, Saffari A, Torr P H S. Struck: structured output tracking with kernels. In: Proceedings of the 2011 IEEE International Conference on Computer Vision. Barcelona, Spain: IEEE, 2011. 263-270 [30] Saffari A, Leistner C, Santner J, Godec M, Bischof H. On-line random forests. In: Proceedings of the IEEE 12th International Conference on Computer Vision Workshops. Kyoto, Japan: IEEE, 2009. 1393-1400 [31] Babenko B, Yang M H, Belongie S. Visual tracking with online multiple instance learning. In: Proceedings of the 2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami, FL: IEEE, 2009. 983-990 [32] Jiang N, Liu W Y, Wu Y. Learning adaptive metric for robust visual tracking. IEEE Transactions on Image Processing, 2011, 20(8):2288-2300 doi: 10.1109/TIP.2011.2114895 [33] Liu M, Wu C D, Zhang Y Z. Motion vehicle tracking based on multi-resolution optical flow and multi-scale Harris corner detection. In: Proceedings of the 2007 IEEE International Conference on Robotics and Biomimetics. Sanya, China: IEEE, 2007. 2032-2036 [34] 吴垠, 李良福, 肖樟树, 刘侍刚.基于尺度不变特征的光流法目标跟踪技术研究.计算机工程与应用, 2013, 49(15):157-161 doi: 10.3778/j.issn.1002-8331.1211-0207Wu Yin, Li Liang-Fu, Xiao Zhang-Shu, Liu Shi-Gang. Optical flow motion tracking algorithm based on SIFT feature. Computer Engineering and Applications, 2013, 49(15):157-161 doi: 10.3778/j.issn.1002-8331.1211-0207 [35] Rodríguez-Canosa G R, Thomas S, del Cerro J, Barrientos A, MacDonald B. A real-time method to detect and track moving objects (DATMO) from unmanned aerial vehicles (UAVs) using a single camera. Remote Sensing, 2012, 4(4):1090-1111 doi: 10.3390/rs4041090 [36] 刘大千, 刘万军, 费博雯, 曲海成.前景约束下的抗干扰匹配目标跟踪方法.自动化学报, 2018, 44(6):1138-1152 http://www.aas.net.cn/CN/abstract/abstract19303.shtmlLiu Da-Qian, Liu Wan-Jun, Fei Bo-Wen, Qu Hai-Cheng. A new method of anti-interference matching under foreground constraint for target tracking. Acta Automatica Sinica, 2018, 44(6):1138-1152 http://www.aas.net.cn/CN/abstract/abstract19303.shtml [37] 杨旭升, 张文安, 俞立.适用于事件触发的分布式随机目标跟踪方法.自动化学报, 2017, 43(8):1393-1401 http://www.aas.net.cn/CN/abstract/abstract19113.shtmlYang Xu-Sheng, Zhang Wen-An, Yu Li. Distributed tracking method for maneuvering targets with event-triggered mechanism. Acta Automatica Sinica, 2017, 43(8):1393-1401 http://www.aas.net.cn/CN/abstract/abstract19113.shtml [38] Kwolek B. CamShift-based tracking in joint color-spatial spaces. In: Proceedings of the Computer Analysis of Images and Patterns. Lecture Notes in Computer Science, vol.3691. Berlin, Heidelberg Germany: Springer, 2005. 693-700 [39] Guo W H, Feng Z R, Ren X D. Object tracking using local multiple features and a posterior probability measure. Sensors, 2017, 17(4):739 doi: 10.3390/s17040739 [40] Fu C H, Duan R, Kircali D, Kayacan E. Onboard robust visual tracking for UAVs using a reliable global-local object model. Sensors, 2016, 16(9):1406 doi: 10.3390/s16091406 [41] Yuan G W, Zhang J X, Han Y H, Zhou H, Xu D. A multiple objects tracking method based on a combination of Camshift and object trajectory tracking. In: Proceedings of Advances in Swarm and Computational Intelligence. Lecture Notes in Computer Science, vol.9142. Beijing, China: Springer, 2015. 155-163 [42] Huang S L, Hong J X. Moving object tracking system based on Camshift and Kalman filter. In: Proceedings of the 2011 IEEE International Conference on Consumer Electronics, Communications and Networks. Xianning, China: IEEE, 2011. 1423-1426 [43] Ditlevsen S, Samson A. Estimation in the partially observed stochastic Morris-Lecar neuronal model with particle filter and stochastic approximation methods. Annals of Applied Statistics, 2014, 8(2):674-702 doi: 10.1214/14-AOAS729 [44] Wang Z W, Yang X K, Xu Y, Yu S Y. CamShift guided particle filter for visual tracking. Pattern Recognition Letters, 2009, 30(4):407-413 doi: 10.1016/j.patrec.2008.10.017 [45] 王鑫, 唐振民.一种改进的基于Camshift的粒子滤波实时目标跟踪算法.中国图象图形学报, 2010, 15(10):1507-1514 http://d.old.wanfangdata.com.cn/Periodical/zgtxtxxb-a201010013Wang Xin, Tang Zhen-Min. An improved camshift-based particle filter algorithm for real-time target tracking. Journal of Image and Graphics, 2010, 15(10):1507-1514 http://d.old.wanfangdata.com.cn/Periodical/zgtxtxxb-a201010013 [46] Wang L, Chen F L, Yin H M. Detecting and tracking vehicles in traffic by unmanned aerial vehicles. Automation in Construction, 2016, 72:294-308 doi: 10.1016/j.autcon.2016.05.008 [47] 张宏志, 张金换, 岳卉, 黄世霖.基于CamShift的目标跟踪算法.计算机工程与设计, 2006, 27(11):2012-2014 doi: 10.3969/j.issn.1000-7024.2006.11.032Zhang Hong-Zhi, Zhang Jin-Huan, Yue Hui, Huang Shi-Lin. Object tracking algorithm based on CamShift. Computer Engineering and Design, 2006, 27(11):2012-2014 doi: 10.3969/j.issn.1000-7024.2006.11.032 [48] Danelljan M, Khan F S, Felsberg M, van de Weijer J. Adaptive color attributes for real-time visual tracking. In: Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, OH, USA: IEEE, 2014. 1090-1097 [49] Liu T, Wang G, Yang Q X. Real-time part-based visual tracking via adaptive correlation filters. In: Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, USA: IEEE, 2015. 4902-4912 [50] Danelljan M, Häger G, Khan F S, Felsberg M. Accurate scale estimation for robust visual tracking. In: Proceedings British Machine Vision Conference. London, England: BMVA Press, 2014. 65.1-65.11 [51] Zhu G B, Wang J Q, Wu Y, Zhang X Y, Lu H Q. MC-HOG correlation tracking with saliency proposal. In: Proceedings of the 13th AAAI Conference on Artificial Intelligence. Phoenix, USA: AAAI Press, 2016. 3690-3696 [52] Bibi A, Mueller M, Ghanem B. Target Response Adaptation for Correlation Filter Tracking. In: Proceedings of the 2016 IEEE European Conference on Computer Vision Workshop. Amsterdam, Netherlands: IEEE, 2016. 419-433 [53] O'Rourke S M, Herskowitz I, O'Shea E K. Yeast go the whole HOG for the hyperosmotic response. Trends in Genetics, 2002, 18(8):405-412 doi: 10.1016/S0168-9525(02)02723-3 [54] Bertinetto L, Valmadre J, Golodetz S, Miksik O, Torr P H S. Staple: complementary learners for real-time tracking. In: Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA: IEEE, 2016. 1401-1409 [55] Kristan M, Pflugfelder R, Leonardis A, Matas J, Čehovin L, Nebehay G, et al. The visual object tracking VOT2014 challenge results. In: Proceedings of Computer Vision. Lecture Notes in Computer Science, vol.8926. Zurich, Switzerland: Springer, 2015. 191-217 [56] Xu Y L, Wang J B, Li H, Li Y, Miao Z, Zhang Y F. Patch-based scale calculation for real-time visual tracking. IEEE Signal Processing Letters, 2016, 23(1):40-44 doi: 10.1109/LSP.2015.2479360 [57] Akin O, Erdem E, Erdem A, Mikolajczyk K. Deformable part-based tracking by coupled global and local correlation filters. Journal of Visual Communication and Image Representation, 2016, 38:763-774 doi: 10.1016/j.jvcir.2016.04.018 [58] Guo L S, Li J S, Zhu Y H, Tang Z Q. A novel features from accelerated segment test algorithm based on LBP on image matching. In: Proceedings of the 3rd IEEE International Conference on Communication Software and Networks. Xi'an, China: IEEE, 2011. 355-358 [59] Calonder M, Lepetit V, Strecha C, Fua P. BRIEF: binary robust independent elementary features. In: Proceedings of Computer Vision. Lecture Notes in Computer Science, vol.6314. Heraklion, Crete: Springer, 2010. 778-792 [60] Montero A S, Lang J, Laganiére R. Scalable kernel correlation filter with sparse feature integration. In: Proceedings of the 2015 IEEE International Conference on Computer Vision Workshop. Santiago, Chile: IEEE, 2015. 587-594 [61] 张微, 康宝生.相关滤波目标跟踪进展综述.中国图象图形学报, 2017, 22(8):1017-1033 http://d.old.wanfangdata.com.cn/Periodical/zgtxtxxb-a201708001Zhang Wei, Kang Bao-Sheng. Recent advances in correlation filter-based object tracking:a review. Journal of Image and Graphics, 2017, 22(8):1017-1033 http://d.old.wanfangdata.com.cn/Periodical/zgtxtxxb-a201708001 [62] Danelljan M, Häger G, Khan F S, Felsberg M. Learning spatially regularized correlation filters for visual tracking. In: Proceedings of the 2015 IEEE International Conference on Computer Vision. Santiago, Chile: IEEE, 2015. 4310-4318 [63] Danelljan M, Häger G, Khan F S, Felsberg M. Adaptive decontamination of the training set: a unified formulation for discriminative visual tracking. In: Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA: IEEE, 2016. 1430-1438 [64] Wang M M, Liu Y, Huang Z Y. Large margin object tracking with circulant feature maps. In: Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA: IEEE, 2017. 4800-4808 [65] Ma C, Yang X K, Zhang C Y, Yang M H. Long-term correlation tracking. In: Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, USA: IEEE, 2015. 5388-5396 [66] Ma C, Huang J B, Yang X K, Yang M H. Hierarchical convolutional features for visual tracking. In: Proceedings of the 2015 IEEE International Conference on Computer Vision. Santiago, Chile: IEEE, 2015. 3074-3082 [67] Wang N Y, Yeung D Y. Ensemble-based tracking: aggregating crowdsourced structured time series data. In: Proceedings of the 31st International Conference on Machine Learning. Beijing, China, 2014. 1107-1115 [68] Wang N Y, Yeung D Y. Learning a deep compact image representation for visual tracking. In: Proceedings of the 26th International Conference on Neural Information Processing Systems. Lake Tahoe, Nevada: Curran Associates Inc., 2013. 809-817 [69] Wang D, Lu H C, Yang M H. Least soft-threshold squares tracking. In: Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Portland, OR, USA: IEEE, 2013. 2371-2378 [70] Hare S, Golodetz S, Saffari A, Vineet V, Cheng M M, Hicks S L, et al. Struck:structured output tracking with kernels. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(10):2096-2109 doi: 10.1109/TPAMI.2015.2509974 [71] 管皓, 薛向阳, 安志勇.深度学习在视频目标跟踪中的应用进展与展望.自动化学报, 2016, 42(6):834-847 http://www.aas.net.cn/CN/abstract/abstract18874.shtmlGuan Hao, Xue Xiang-Yang, An Zhi-Yong. Advances on application of deep learning for video object tracking. Acta Automatica Sinica, 2016, 42(6):834-847 http://www.aas.net.cn/CN/abstract/abstract18874.shtml [72] Danelljan M, Robinson A, Khan F S, Felsberg M. Beyond correlation filters: Learning continuous convolution operators for visual tracking. In: Proceedings of Computer Vision. Lecture Notes in Computer Science, vol.9909. Amsterdam, Netherlands: Springer, 2016. 472-488 [73] Bertinetto L, Valmadre J, Henriques J F, Vedaldi A, Torr P H S. Fully-convolutional siamese networks for object tracking. In: Proceedings of Computer Vision. Lecture Notes in Computer Science, vol.9914. Amsterdam, Netherlands: Springer, 2016. 850-865 [74] Ding J W, Huang Y Z, Liu W, Huang K Q. Severely blurred object tracking by learning deep image representations. IEEE Transactions on Circuits and Systems for Video Technology, 2016, 26(2):319-331 doi: 10.1109/TCSVT.2015.2406231 [75] Dai L, Zhu Y S, Luo G B, He C. A low-complexity visual tracking approach with single hidden layer neural networks. In: Proceedings of the 13th International Conference on Control Automation Robotics and Vision. Singapore: IEEE, 2014. 810-814 [76] Li P X, Wang D, Wang L J, Lu H C. Deep visual tracking:review and experimental comparison. Pattern Recognition, 2018, 76:323-338 doi: 10.1016/j.patcog.2017.11.007 [77] Nam H, Baek M, Han B. Modeling and propagating CNNs in a tree structure for visual tracking. In: Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA: IEEE, 2016. 2137-2155 [78] Song Y B, Ma C, Wu X H, Gong L J, Bao L C, Zuo W M, et al. Visual tracking via adversarial learning. In: Proceedings of the 2018 IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City, Utah, USA: IEEE, 2018. 1084-1093 [79] Wu Y, Lim J, Yang M H. Object tracking benchmark. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9):1834-1848 doi: 10.1109/TPAMI.2014.2388226 [80] Nam H, Han B. Learning multi-domain convolutional neural networks for visual tracking. In: Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA: IEEE, 2016. 4293-4302 [81] Fan H, Ling H B. SANet: structure-aware network for visual tracking. In: Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Honolulu, HI, USA: IEEE, 2017. 2217-2224 [82] Han B, Sim J, Adam H. BranchOut: regularization for online ensemble tracking with convolutional neural networks. In: Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA: IEEE, 2017. 521-530 [83] Zhang T Z, Xu C S, Yang M H. Multi-task correlation particle filter for robust object tracking. In: Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA: IEEE, 2017. 4819-4827 [84] Yun S, Choi J, Yoo Y, Yun K M, Choi J Y. Action-decision networks for visual tracking with deep reinforcement learning. In: Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA: IEEE, 2017. 1349-1358 [85] Qi Y K, Zhang S P, Qin L, Yao H X, Huang Q M, Lim J, et al. Hedged deep tracking. In: Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA: IEEE, 2016. 4303-4311 [86] Gao J Y, Zhang T Z, Yang X S, Xu C S. Deep relative tracking. IEEE Transactions on Image Processing, 2017, 26(4):1845-1858 doi: 10.1109/TIP.2017.2656628 -

下载:

下载: