A Compressed Sensing Reconstruction Based on Elastic Collision and Gradient Pursuit Strategy for WSNs

-

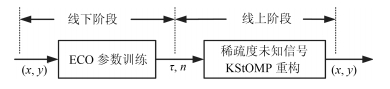

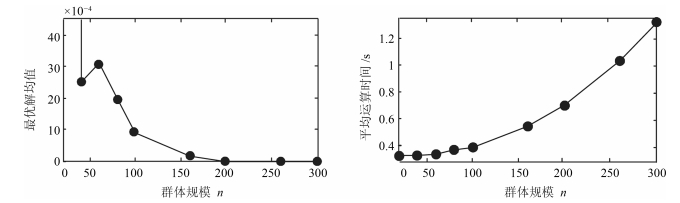

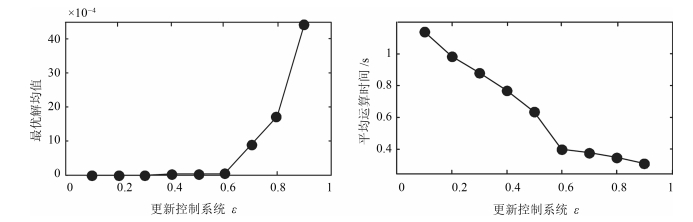

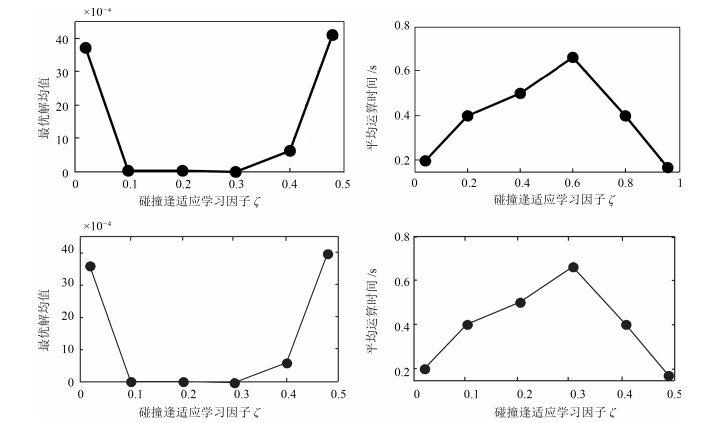

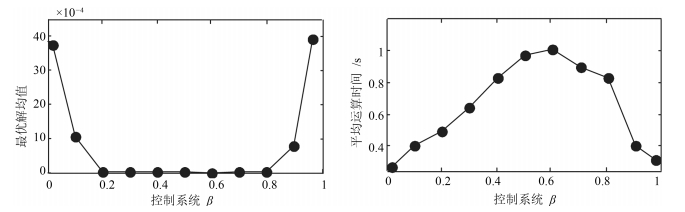

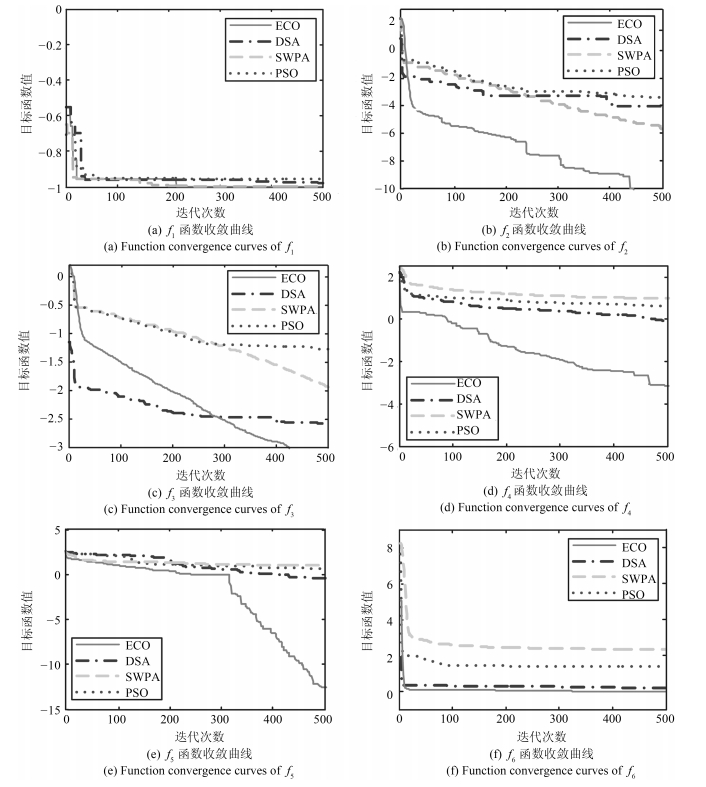

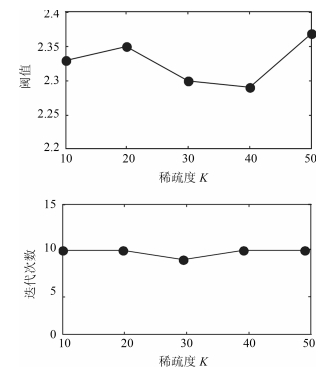

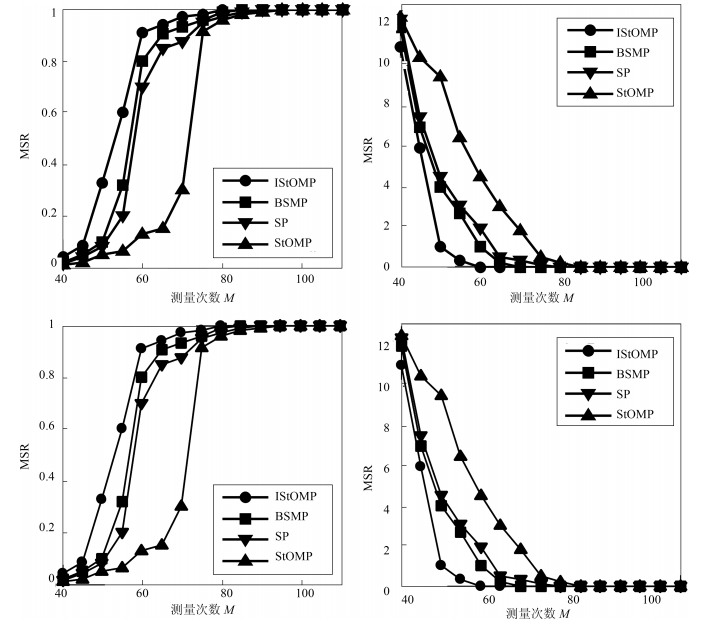

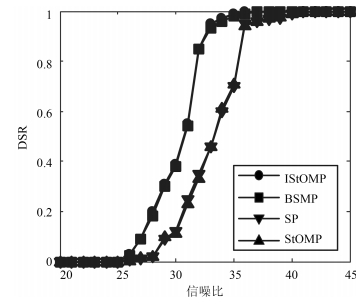

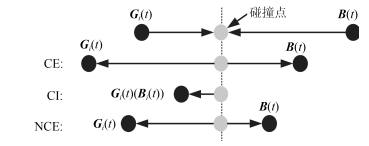

摘要: 为提高压缩感知(Compressed sensing, CS)大规模稀疏信号重构精度, 提出了一种联合弹性碰撞优化与改进梯度追踪的WSNs (Wireless sensor networks)压缩感知重构算法.首先, 创新地提出一种全新的智能优化算法---弹性碰撞优化算法(Elastic collision optimization algorithm, ECO), ECO模拟物理碰撞信息交互过程, 利用自身历史最优解和种群最优解指导进化方向, 并且个体以N(0, 1)概率形式散落于种群最优解周围, 在有效提升收敛速度的同时扩展了个体搜索空间, 理论定性分析表明ECO依概率1收敛于全局最优解, 而种群多样性指标分析证明了算法全局寻优能力.其次, 针对贪婪重构算法高维稀疏信号重构效率低、稀疏度事先设定的缺陷, 在设计重构有效性指数的基础上将ECO应用于压缩感知重构算法中, 并引入拟牛顿梯度追踪策略, 从而实现对大规模稀疏度未知数据的准确重构.最后, 利用多维测试函数和WSNs数据采集环境进行仿真, 仿真结果表明, ECO在收敛精度和成功率上具有一定优势, 而且相比于其他重构算法, 高维稀疏信号重构结果明显改善.Abstract: In order to improve the precision of compressed sensing (CS) sparse reconstruction algorithm, a CS reconstruction algorithm based on elastic collision optimization (ECO) and improved gradient pursuit strategy for WSNs is proposed. First of all, a new intelligent optimization computing technology: ECO is put forward. Referred to physical collision information interaction process, the historical optimal solution and population optimal solution are used to guide evolutionary direction and individuals are spread around the optimal solution in the form of N(0, 1), which helps to improve the convergence speed and extend the individual search space. Qualitative analysis shows that ECO can converge to the global optimal solution in probability 1 and the analysis of the diversity index shows that the algorithm has the ability of global optimization. Secondly, aiming at the defects of greedy reconstruction algorithm as low reconstruction efficiency and sparsity set in advance for high dimensional sparse signals, the ECO is applied to the CS reconstruction algorithm on the basis of the design validity index, and the quasi Newton gradient pursuit strategy is also introduced, which helps to realize the accurate reconstruction of large scale sparse data. Finally, simulation is carried out using multidimensional test functions and WSNs data acquisition environment. The simulation results show that ECO has certain advantages in convergence accuracy and success rate, and compared with other reconstruction algorithms, the reconstruction results significantly improved for high dimensional sparse signal.

-

Key words:

- Wireless sensor networks (WSNs) /

- elastic collision optimization (ECO) /

- convergence efficiency /

- compressed sensing (CS) /

- sparse reconstruction algorithm

-

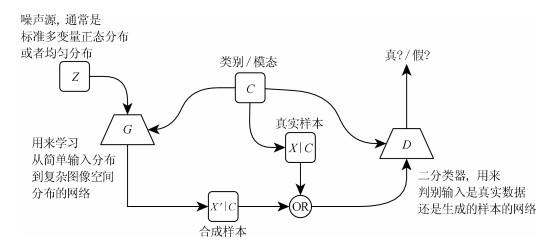

生成式对抗网络(Generative adversarial networks, GAN) [1]由Goodfellow等在2014年提出, 该理论基于博弈论场景, 其中生成器网络通过与对手竞争来学习变换由某些简单的输入分布(通常是标准多变量正态分布或者均匀分布)到图像空间的分布——即越来越真实的样本$x=g(z; \theta ^{(G)})$.作为对手, 判别器网络则试图区分从训练数据抽取的样本和从生成器中生成的样本.训练过程根据判别器网络发出的由$d(x; \theta^{(D)})$给出的概率值——指示是真实训练样本而不是从模型中抽取的伪造样本的概率——来指导生成器网络不断构造出越来越真的假样本[2].通过这种方式, 二者互相竞争, 共同进步, 生成模型产生的数据越来越真, 判别模型的识别能力越来越强, 整体来说, 双方都试图最小化各自的损失, 优化的最终目标是达到"纳什均衡" [3].近些年来, GAN已经成功地运用到很多问题上, 但训练GAN依旧是一件比较困难的事, 稳定GAN的学习是一个开放性的问题.幸运的是当仔细选择模型架构和超参数时, GAN的学习效果非常好, Radford等在卷积神经网络(Convolutional neural network, CNN)的基础上设计了DCGAN [4], 它将生成器中的全连接层用反卷积(Deconvolution)层代替, 在图像合成的任务中取得了非常好的表现, 并表明其潜在的表示空间能捕获到变化的重要因素.在GAN的学习过程中通过将生成过程分为许多级别的细节能极大地提高GAN生成样本的质量, Mirza等提出通过训练有条件的GAN (Conditional GAN, CGAN) [5]来引导GAN学习从分布$p(x|y)$中采样, 而不是简单地从边缘分布$p(x)$中采样, 使得GAN能着重关注那些能够阐述样本相关的统计特征, 并忽略不太相关的局部特征.然而, 无论是精心设计的DCGAN还是条件驱动的CGAN, 均是通过丰富的工程手段来优化GAN模型, 2017年, Arjovsky等[6]证明了当使用JS (Jensen-Shannon)散度作为真实分布与生成分布相近度的度量时, 在真实分布与生成分布的重叠区域可忽略的情况下, JS散度为一常数, 此时生成器的获得梯度为0, 网络无法继续优化, 继而提出了使用Earth-Mover (EM)距离作为相似度度量的Wasserstein GAN [7], 为解决GAN存在的训练困难、损失函数无法指导训练、生成样本缺乏多样性等问题指明了一个全新的方向.

网络结构的创新和优化是GAN得以不断发展的重要原因之一[8].在深度学习领域, 从LeCun等提出CNN模型[9]开始, 因为计算成本等问题, 此类深度模型一度被掩盖在诸如支持向量机(Support vector machine, SVM)等其他机器学习模型的光彩之下.直到Krizhevsky等在2012年提出Alex-Net [10]网络模型, 并藉此取得了当年ILSVRC比赛分类项目的冠军之后, 深度卷积神经网络才重新回到了大众的视野, 从这之后, 关于CNN的研究和应用层出不穷, 掀起了一个深度学习研究的热潮. CNN通过稀疏权重、参数共享和池化等技术在完成了对图像像素中的重要特征的检测之外还极大地减少了网络的参数规模.但是Hinton认为CNN的内部数据表示并没有考虑到简单和复杂对象之间的重要空间层级, 并依此提出了一种基于动态路由的胶囊神经网络(CapsNets) [11]. CapsNets使用"胶囊"——封装了多个卷积核能输出包含编码特征之间相对空间关系的网络单元——改变了CNN的"神经元"活动中存在的视角不变性的特点.也就是说CapsNets能够习得输入特征之间的空间结构关系, 意味着该结构下的神经活动将随着物体在图像中的"外观流形上的移动"而改变, 与此同时使检测概率保持恒定——即让网络具备活动等变性特征[12].

鉴于胶囊网络结构作为有别于传统CNN而提出的一种全新的神经网络结构, 本文将使用CapsNets来替代标准的CNN作为GAN中判别器的框架, 并对图像数据进行建模, 藉此通过实验来验证CapsNets在GAN领域应用的可能性, 同时在网络中加入条件约束, 和使用WGAN的改进版本WGAN-GP [13]来指导GAN的训练过程.本文提出的基于带条件约束的胶囊生成对抗网络(C-CapsGAN)在不同的图像数据集上都能够稳定生成高质量的图像, 同时通过实验与其他常见的几种GAN进行了对比, 发现C-CapsGAN还能够有效减少模式坍塌问题的发生.

1. 生成式对抗网络算法原理

1.1 GAN

GAN由两部分构成, 生成模型$ G $和判别模型$ D $, 生成模型$ G $捕捉真实数据样本的潜在分布, 并生成新的数据样本; 判别模型$ D $是一个二分类器, 判别输入是真实数据还是生成的样本.形象化表示生成式对抗网络中学习的最简单的方式是零和游戏, 其中函数$ V(\theta^{(G)}, \theta^{(D)}) $定义判别器的收益.生成器接收$ -V(\theta^{(G)}, \theta^{(D)}) $作为它自己的收益.在学习期间, 两位玩家都试图去最大化各自的收益, 因此收敛在:

$$ \begin{equation} G^{* } = \arg\ \min\limits_{G}\ \max\limits_{D}\ V(G, D) \end{equation} $$ (1) 则$ V $的默认选择是(其中, $ P_{\rm data} $和$ P_G $分别表示真实样本概率分布和模型分布):

$$ \begin{align} V(\theta^{(G)}, \theta^{(D)}) = \, & {\rm E}_{x\sim P_{\rm data}}\left [ \log\ D(x) \right ] + \\ &{\rm E}_{x\sim P_{G}}\left [ \log\ (1-D(x)) \right ] \end{align} $$ (2) 这驱使判别器试图学习将样本正确地分类为真或者是假, 同时, 生成器试图欺骗分类器让其相信样本是真实的.最终在收敛处, 生成器的样本与真实样本不可区分, 并且判别器处处都输出1/2.

GAN的结构如图 1所示, 其核心算法描述如下:

生成器与判别器的训练过程是交替进行的, 更新一方的参数时, 另一方的参数固定住不更新.根据目标公式$ V(\theta^{(G)}, \theta^{(D)}) $, 做法是:

1) 首先固定生成器$ G $, 找到一个$ D^{* } $使得$ V(\theta^{(G)}, \theta^{(D)}) $最大, 即$ {\max}_{D}\ V(G, D) $, 通过判别器尽可能地将生成图片和真实图片区别开来, 也就是要最大化两者之间的交叉熵;

2) 然后固定判别器$ D $, 找出使得$ {\max}_{D}\ V(G, D) $最小的$ G^{* } $, 既代表最好的生成器.

相比其他生成架构, 设计GAN的主要动机是学习过程既不需要近似推断, 也不需要配分函数梯度的近似.当$ {\max}_{D}\ V(G, D) $在$ \theta^{(G)} $中是凸性的时候, 该学习过程保证收敛且渐近一致.然而在实践中由神经网络表示的$ G $和$ D $以及$ {\max}_{D}\ V(G, D) $凹凸性往往是不确定的, 这就导致GAN的学习过程会变得很困难.

1.2 DCGAN、CGAN和WGAN

DCGAN将卷积网络引入GAN的结构, 并通过对网络拓扑结构和超参数的精心设计, 使得DCGAN在图像合成任务上表现非常好, DCGAN相比于原始GAN有以下特点[4]:

1) 在判别器网络中使用带步幅的卷积层(Strided convolutions)替换传统卷积神经网路中的池化层(Pooling), 并在生成器网络中使用微步幅卷积层(Fractionally-strided convolution)完成从随机噪声到图片的生成过程;

2) 在判别器网络和生成器网络中均使用批量归一化(Batch Normalization), 此举通过对隐藏层各神经元的输入作标准化处理, 能够提高神经网络训练速度.同时可以使前面层的权重变化对后面层造成的影响减小, 整体网络更加健壮;

3) 移除全连接层, 此举以牺牲网络收敛性来增加模型稳定性;

4) 判别器网络中的所有层使用Leaky ReLU激活函数.生成器网络中除了输出层以外都使用ReLU激活函数, 而输出层则使用Tanh激活函数.

CGAN针对GAN本身不可控的缺点, 在生成模型$ G $和判别模型$ D $的建模中加入条件$ C $监督信(条件$ C $可以是任意信息, 比如类别信息或者其他模态信息)以指导GAN网络生成, 相应的CGAN的目标函数$ V(\theta^{(G)}, \theta^{(D)}) $修改成:

$$ \begin{align} V(\theta^{(G)}, \theta^{(D)}) = \, & {\rm E}_{x\sim P_{\rm data}}\left [ \log D(x|C) \right ] + \\ &{\rm E}_{x\sim P_{G}}\left [ \log (1-D(x|C)) \right ] \end{align} $$ (3) 由式(3)可知, 除了加入条件监督信息之外, 其他均和原始GAN一致, 图 2是CGAN的架构图.

当条件$ C $被定义为标签$ y $的时候, 则可以认为CGAN是将无监督的GAN模型变为有监督模型的改进.

WGAN针对原始GAN定义的目标函数的优化过程可以等价为最小化真实分布$ P_{\rm data} $和生成分布$ P_G $之间的JS散度, 而存在当$ P_{\rm data} $和$ P_G $的支撑集是高维空间中的低维流形时, 两者重叠部分测度为0的概率为1, 使得JS散度固定为常数从而无法指导梯度下降的问题, 提出对样本分布进行限制的方法, 即通过假设样本服从某类特殊的函数族以避免梯度消失.

WGAN使用EM距离替换JS散度作为真实分布与生成分布相近度的度量[14], 定义如下($ \prod $是$ P_{\rm data} $和$ P_G $组合起来的所有可能的联合分布的集合):

$$ \begin{align} &W(\theta^{(G)}, \theta^{(D)}) = \\ &\quad \underset{\gamma \in \prod }{\min}\ \sum\limits_{x_G, x_D}\gamma (x_G, x_D)\Vert x_G-x_D \Vert \end{align} $$ (4) 由于取最小值的操作无法直接求解, 根据Kantorovich-Rubinstein对偶性, EM距离被转化为如下的形式来近似求解:

$$ \begin{align} &W(\theta^{(G)}, \theta^{(D)}) \approx L = \\ &\quad \underset{f \in 1-{\rm Lipschitz }}{\max}\left \{{\rm E}_{x\sim P_{\rm data}} [f(x)] - {\rm E}_{x\sim P_G} [f(x)]\right \} \end{align} $$ (5) 上式中$ f(\cdot) $是一个满足Lipschitz连续条件的函数.因此可以使用神经网络对$ f(\cdot) $进行拟合, 使得$ L $尽可能取到最大, 此时$ L $就会近似真实分布与生成分布之间的Wasserstein距离, 因此WGAN的目标函数变为:

$$ \begin{align} V(\theta^{(G)}, \theta^{(D)}) = \, & {\rm E}_{x\sim P_{\rm data}}\left [ C(x) \right ]- \\ & {\rm E}_{\widetilde{x}\sim P_G}\left [ C(\widetilde{x}) \right ] \end{align} $$ (6) 在原始WGAN, 作者采用权重剪枝的方式使得判别函数$ C $满足Lipschitz连续条件.而WGAN的改进版本WGAN-GP则使用梯度惩罚的方式从而进一步提高了网络的稳定性, 使得在多种网络结构上都可实现收敛, 性能优越, WGAN-GP的目标函数为:

$$ \begin{align} V(\theta^{(G)}, \theta^{(D)}) = \, & {\rm E}_{x\sim P_{\rm data}}\left [ C(x) \right ]-{\rm E}_{\widetilde{x}\sim P_G}\left [ C(\widetilde{x}) \right ]+ \\& \lambda {\rm E}_{\widetilde{x}\sim P_{\widetilde{x}}}\left [ \left ( \left \Vert \bigtriangledown _{\widetilde{x}}D(\widetilde{x}) \right \Vert_{2}-1 \right )^{2} \right ] \end{align} $$ (7) 2. 胶囊神经网络(CapsNets)

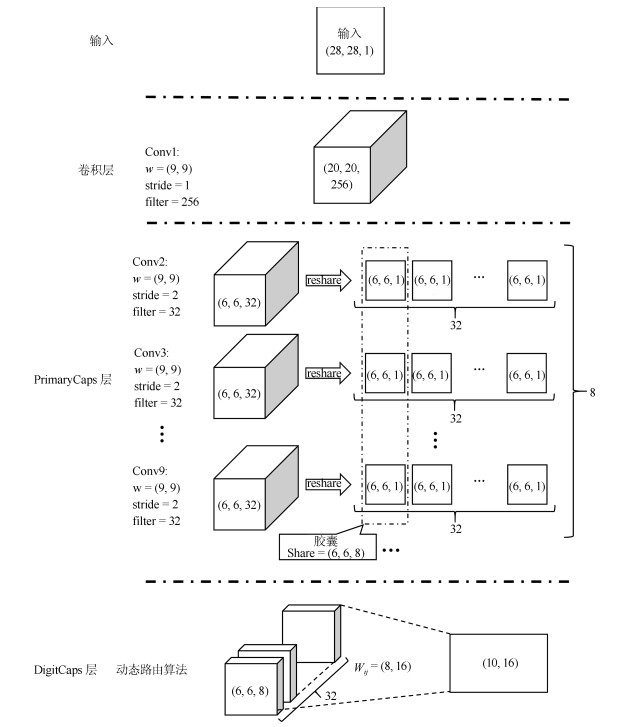

胶囊(Capsule)是一组用激活向量来表示一种特定类型实体的实例化参数的神经元, 或者称之为向量神经元.和CNN在层间直接使用重复特征检测器进行卷积运算从而学习得到关于输入分布的有用特征并泛化到其他分布不同, CapsNets使用向量输出神经元(激活向量的长度(限定在0到1之间)描述特征检测的概率, 方向表征对应特征的状态(位置, 颜色, 方向, 形状等))和按协议路由的最大池化替代CNN的标量输出特征检测器, 使得网络习得对象特征的同时, 还存储了对象特征之间的分层姿态关系.

Sabour等[9]在论文中使用了一种动态路由机制.该机制通过在连续胶囊层中的两两信息传递来实现深层神经网络中胶囊层之间的交互[15].对于在第$ l $层的每一个胶囊$ h_i^{(l)} $和在第$ l+1 $层的每个胶囊$ h_j^{(l+1)} $之间, 耦合系数$ C_{ij} $基于$ h_i $对$ h_j $的输出预测与其实际输出之间的一致性进行迭代调整, 换句话说, 对于每个低层胶囊$ h_i^{(l)} $而言, 其权重$ C_{ij} $定义了传给每个高层胶囊$ h_j^{(l+1)} $的输出的概率分布.特别的, 对于CapsNets结构中的第三层DigitCaps层, 胶囊的个数由任务的具体内容而定, 即对于包含$ K $类分类的任务而言, 通常设计为具有$ K $个胶囊, 其中每个胶囊代表一个类别.由于胶囊矢量输出的长度代表视觉实体的存在, 因此最后一层中每个胶囊的长度可被视为图像属于特定类$ k $的概率.

第一层, 是一个常规的卷积层, 在CapsNets中, 卷积层由256个$ (9, 9) $大小, 步长为1的卷积核构成, 使用ReLU激活函数, 生成$ (20, 20, 256) $张量.该卷积层的作用在于先对输入图片作低级特征抽取预处理.

第二层, PrimaryCaps层, 这一层包含32个主胶囊, 接受卷积层检测到的基本特征, 生成特征的组合.首先, 将32个$ (9, 9) $大小, 步长为2的卷积核应用到$ (20, 20, 256) $输入张量, 生成$ (6, 6, 32) $的输出张量; 然后, 将$ (6, 6, 32) $张量维度转换为$ (6, 6, 1, 32). $重复使用上述卷积操作最终生成8个$ (6, 6, 1, 32) $的张量, 因此最终输出为$ (6, 6, 8, 32) $张量.

第三层, DigitCaps层, 在原始论文中将这一层设置为了10个数字胶囊, 但其实对于包含$ K $类分类的任务而言, 该层可设计为具有$ K $个胶囊, 其中每个胶囊代表一个类别.胶囊接受一个$ (6, 6, 8, 32) $张量作为输入, 并通过$ (8, 16) $权重矩阵将8维输入空间映射到16维胶囊输出空间, 输出为$ (10, 16) $矩阵.

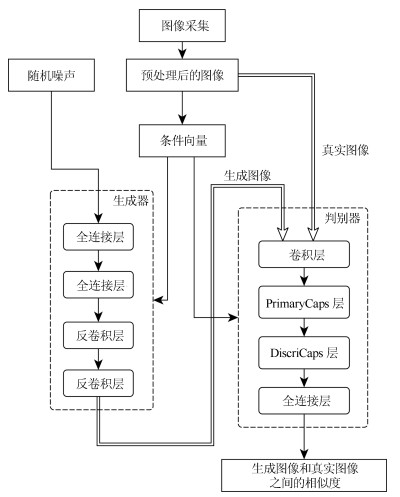

3. 基于条件约束的胶囊生成对抗网络(C-CapsGAN)

本文利用CapsNets来改进DCGAN模型结构的判别器, 然后将条件同时添加到判别器和生成器中负责约束训练, 同时利用WGAN-GP损失函数对训练过程进行指导, 从而建立一种带条件约束的胶囊生成对抗网络(Conditional-CapsuleGAN, C-CapsGAN), 并将通过实验验证该结构在生成图像方面的可行性, 同时探索了胶囊网络对解决训练过程收敛性和模式坍塌等问题的效果, 网络整体的架构如图 4.

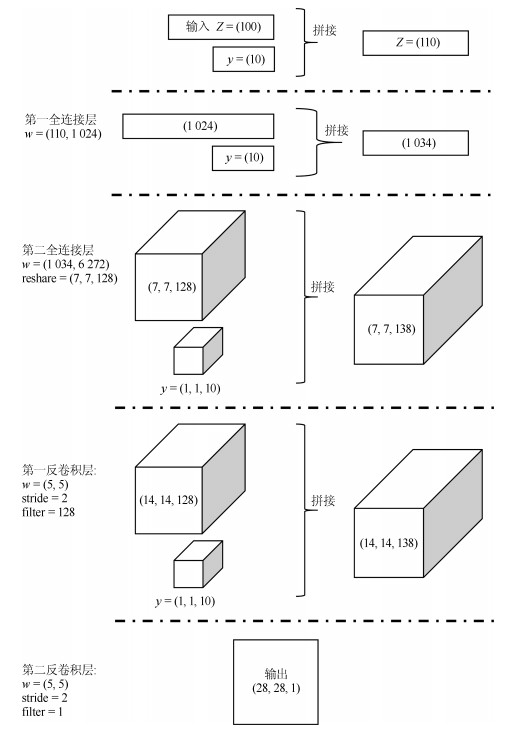

仿照DCGAN中的生成器结构, C-CapsGAN的生成模型如图 5所示(以MNIST手写数字数据集为例):

1) 将100维的随机噪声和10维的类别信息拼接(Concat)成110维的输入数据;

2) 将110维的输入数据经过全连接层得到一个1 024维输出并与10维的类别信息进行拼接得到1 034维的数据;

3) 将1 034维作为输入通过全连接层得到一个6 272维的输出然后维度转换(Reshape)成$ (7, 7, 128) $的三维张量, 再与$ (1, 1, 10) $的三维张量类别信息进行拼接得到$ (7, 7, 138) $的张量;

4) 将$ (7, 7, 138) $的张量通过卷积核大小为$ (5, 5) $、步长为2的转置卷积层, 输出$ (14, 14, 128) $的张量, 继续与$ (1, 1, 10) $的三维张量类别信息进行拼接得到$ (14, 14, 138) $的张量;

5) 将$ (14, 14, 138) $的张量重复执行一次上一步操作则输出$ (28, 28, 1) $张量, 即为一个生成样本;

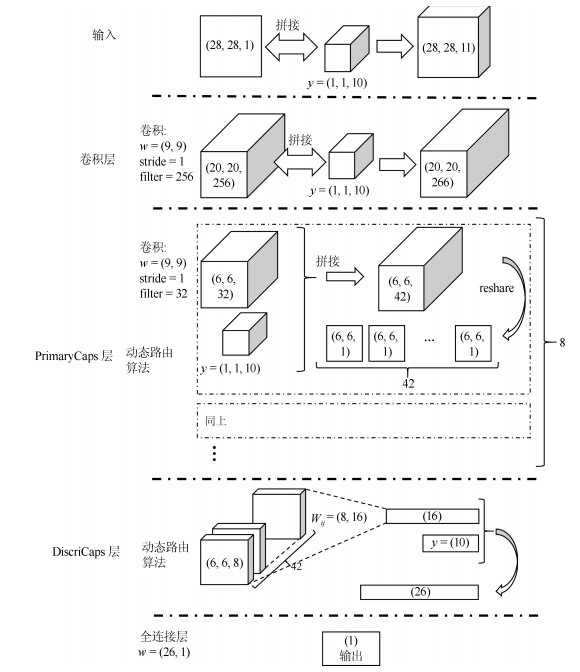

C-CapsGAN的判别模型则使用了CapsNets的架构, 如图 6所示(以MNIST手写数字数据集为例).

1) 将一张$ (28, 28, 1) $的样本和$ (1, 1, 10) $的三维张量类别信息拼接作为判别器的输入;

2) $ (28, 28, 11) $的输入数据通过卷积核大小为$ (9, 9) $、步长为1的卷积层, 输出$ (20, 20, 256) $的张量, 再与$ (1, 1, 10) $的三维张量类别信息进行拼接得到$ (20, 20, 266) $的张量;

3) 在PrimaryCaps层中, 以$ (20, 20, 266) $的张量作为输入, 通过8组卷积运算, 每组运算由32个$ (9, 9) $大小、步长为2的卷积核执行, 得到$ (6, 6, 32) $的张量再与$ (1, 1, 10) $的条件约束拼接得到$ (6, 6, 42) $张量, 最终得到$ (6, 6, 8, 42) $的输出张量, 再维度转换为$ (1 512, 8, 1) $作为DiscriCaps层输入;

4) 在DiscriCaps层, 该层作为二分类的输出, 因此设置为1个胶囊即可, 胶囊接受$ (1 512, 8, 1) $张量作为输入, 并通过$ (8, 16) $权重矩阵, 利用动态路由更新算法将8维输入空间映射到16维胶囊输出空间, 输出为$ (1, 16) $矩阵, 拼接条件约束之后再通过激活函数得到判别结果.

C-CapsGAN的模型训练. 判别器的任务不再是尽力区分生成样本与真实样本, 而是尽量拟合出样本间的Wasserstein距离, 从分类任务转化成回归任务.而生成器的任务则是尽力缩短样本间的Wasserstein距离.

$$ \begin{align} V(\theta^{(G)}, \theta^{(D)}) = \, &{\rm E}_{x\sim P_{\rm data}}\left [ C(x) \right ]-{\rm E}_{\widetilde{x}\sim P_G}\left [ C(\widetilde{x}) \right ]+ \\& \lambda {\rm E}_{\widetilde{x}\sim P_{\widetilde{x}}}\left [ \left ( \left \Vert \bigtriangledown _{\widetilde{x}}D(\widetilde{x}) \right \Vert_{2}-1 \right )^{2} \right ] \end{align} $$ (8) 由于模型是对每个样本独立地施加梯度惩罚, 所以判别器的模型架构中不使用Batch normalization, 因为它会引入同一个Batch中不同样本的相互依赖关系.在求得生成器和判别器的损失函数之后, 选择Adam作为优化器.

4. 实验与分析

本文在MNIST数据集和CIFAR-10数据集上进行实验分析, 实验环境:计算机处理器为Intel(R) Xeon(R) CPU E5-2620 v4 @ 2.10 GHz, 64 GB运行内存(RAM), NVIDIA Quadro M1200 GPU, TensorFlow框架.

4.1 MNIST实验

MNIST数据集包含0~9共10类手写数字灰度图像, 图像尺寸为$ (28, 28, 1) $, 整个数据集有60 000个训练样本, 10 000个测试样本[16].

在训练过程中, 使用图 5和图 6的结构作为C-CapsGAN的生成器和判别器对MNIST数据集进行训练, 同时为了保持对抗平衡, 设置判别器与生成器的迭代次数为1 : 2, 其他参数设置如下:

1) Batch设置为64;

2) Epoch设置为25轮;

3) Adam优化器的学习速率设置为0.0001, 一阶矩估计的指数衰减率为0.5, 二阶矩估计的指数衰减率为0.9;

4) 生成器除了最后一层使用Sigmoid函数作为激活函数之外, 其他层都使用ReLU作为激活函数;

5) 判别器则使用Leaky ReLU作为激活函数;

6) 生成器每一层中均使用Batch normalization对隐含层的输入进行批量归一化处理[17].

因为每个胶囊产生一个向量输出而不是单纯的标量输出, 同时, 由于每个胶囊都有与它前面层中的所有胶囊相关联的用于对其输出进行预测的附加参数[11].所以, 胶囊的个数能够影响判别器的判别性能, 于是在MNIST实验过程中, 以MNIST数据集为实验对象, 通过逐步减少胶囊的个数从而探究胶囊个数与样本生成质量之间关系, 然后把最优胶囊个数的C-CapsGAN从训练过程和生成结果方面与传统GAN、DCGAN进行对比.

4.1.1 MNIST实验结果

实验部分先逐步降低胶囊个数, 然后将效果最好的C-CapsGAN和传统GAN、DCGAN进行对比.

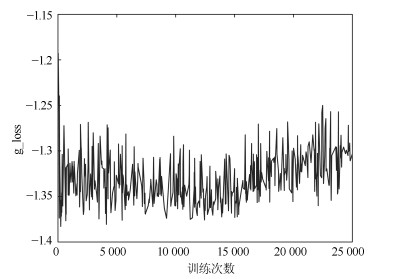

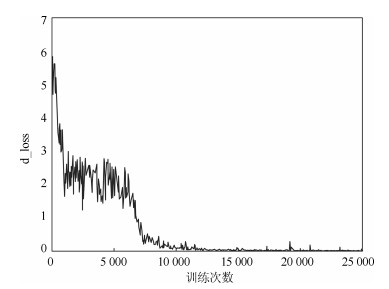

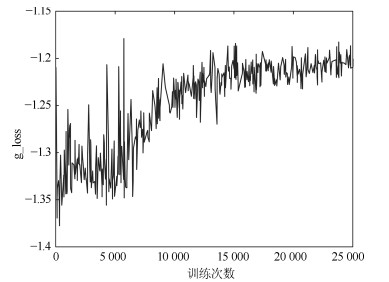

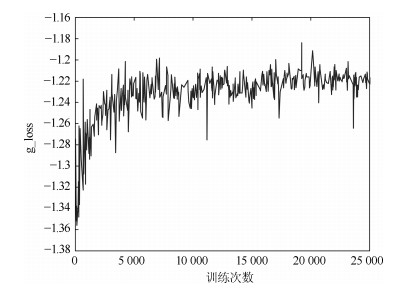

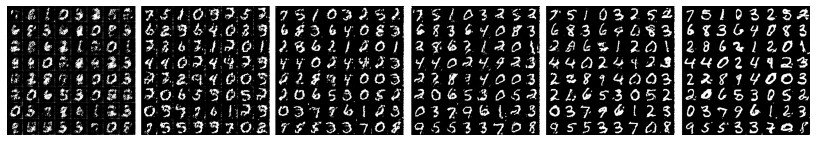

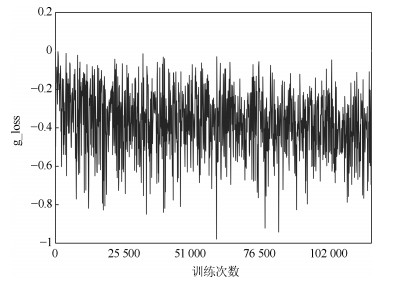

1) 首先, 将胶囊判别器的结构参数设置为和胶囊网络CapsNets相一致, 也就是PrimaryCaps层的胶囊个数设置为32个.于是图 7和图 8分别表示了C-CapsGAN的判别器的损失函数(d_loss)和生成器的损失函数(g_loss)随训练次数增加而变化的情况.

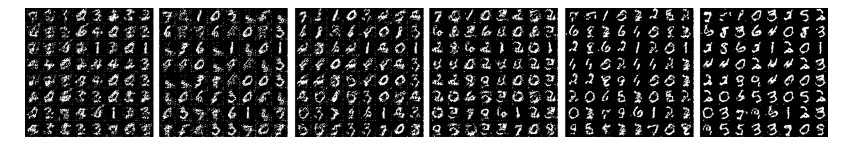

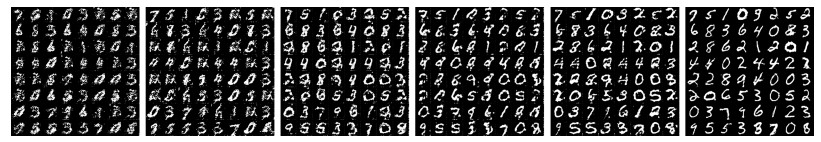

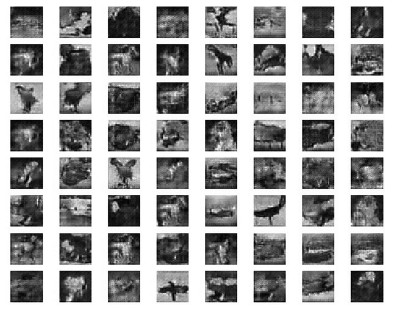

在趋势上, 判别器的损失函数处于缓慢下降状态, 生成器的损失函数处于缓慢上升状态.然而从d_loss趋势图发现, 判别器的损失总是很高, 意味着它总是能将生成样本判定为假样本, 这对生成器而言, 意味着无法找到能够欺骗判别器的参数集, 使得最终呈现的效果就是:生成样本无法往更优的方向发展. 图 9为数据集的其中一个Batch, 即64个生成样本随着Epoch次数的增加, 生成样本的进化情况, 可以看出收敛效果不是很好, 当训练结束之后, 生成样本的质量还有很大的提升空间.

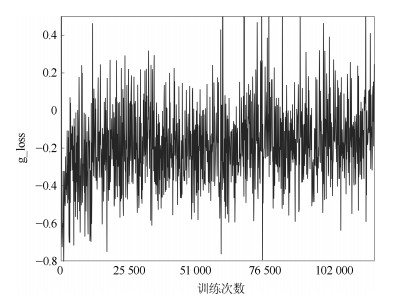

2) 然后, 降低胶囊判别器的中PrimaryCaps层的胶囊个数, 此次设置为24个. 图 10和图 11分别表示了C-CapsGAN的判别器的损失函数(d_loss)和生成器的损失函数(g_loss)随训练次数增加而变化的情况.

此时在趋势上发现, 在迭代10 000次之前, 判别器的损失函数和生成器的损失函数的状态和当PrimaryCaps层的胶囊个数为32的时候类似, 训练前期, 双方均处于成长阶段, 呈现出图中大幅震荡状态.当迭代超过10 000次之后, 判别器损失出现明显下降, 并在0~1之间小幅震荡, 意味着通过减少胶囊个数, 成功降低了判别器的判别能力, 同时由于动态路由算法, 即使存在有梯度消失风险, 也无需担心判别器出现失效情况.图 12为数据集的其中一个Batch, 即64个生成样本随着Epoch次数的增加, 生成样本的进化情况, 可以看出当胶囊个数变少之后, 生成器的收敛速度明显加快, 所以降低胶囊个数有助于生成器提高生成质量.

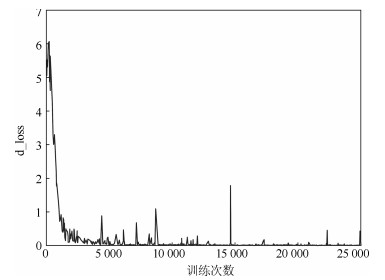

3) 实验继续降低胶囊判别器的中PrimaryCaps层的胶囊个数, 此次设置为16个. 图 13和图 14分别表示了C-CapsGAN的判别器的损失函数(d_loss)和生成器的损失函数(g_loss)随训练次数增加而变化的情况.

当实验继续降低胶囊个数的时候, 从图 13我们发现, 在训练初期判别器的损失就急剧下降, 这意味着判别器的判别能力由于胶囊个数太少而过低了. 图 15为数据集的其中一个Batch, 即64个生成样本随着Epoch次数的增加, 生成样本的进化情况, 可以看出当胶囊个数继续变少, 导致判别器的判别能力继续下降.当训练结束的时候, 生成样本的质量则不如胶囊个数为24的网络生成的样本高.

综上所述, 对于本文提出的C-CapsGAN方法, 胶囊的个数对生成样本的收敛速度和生成样本的质量至关重要, 胶囊个数存在最优值, 当胶囊个数过多, 判别器过于强大, 则很容易在训练过程中始终对生成器进行严厉惩罚, 从而使得生成器总是无法产生能够"迷惑"判别器的样本, 导致生成效率低下; 而当胶囊个数过少——判别器太弱, 则生成器很容易产生出判别器无法分辨的"真样本", 虽然生成效率很高, 但是生成质量会有所下降.对MNIST数据集实验来说, 设置PrimaryCaps层的胶囊个数在16~24之间较好.

传统GAN架构代表了全连接网络在生成式对抗领域的应用, 图 16是传统GAN在MNIST数据集下的训练过程和最优结果; 而DCGAN代表了卷积神经网络在生成式对抗领域的应用, 图 17是DCGAN在MNIST数据集下的训练过程和最优结果.通过将传统GAN、DCGAN和C-CapsGAN (24个胶囊)的生成样本进行对比从而直观展示了在生成对抗网络领域, 网络结构的升级能够提高生成样本质量.

实验发现:本文提出的方法在收敛性和生成图片的质量上均优于传统GAN结构上的表现, 表明了C-CapsGAN对比传统GAN的优越性; 在和DCGAN训练过程的对比表明, DCGAN的收敛性在前期(10轮之前)较C-CapsGAN好, 在DCGAN中, 当训练持续进行到第10轮时, 生成样本质量较真实样本质量虽有差距但能够接受, 然而随着训练的继续进行, DCGAN的优化效果不再显著, 意味着生成器并没有随着训练的继续而持续优化.反观在C-CapsGAN中, 生成样本则随着训练轮数的增加持续变好, C-CapsGAN对生成器的优化是持续有效的, 在24次Epoch之后, 网络生成的图片质量能够和DCGAN媲美.因此, 本文提出的方法较之DCGAN而言, 不容易陷入优化停滞, 其收敛的速度更加稳定和持续, 只要增加训练Epoch的大小, C-CapsGAN最终能够生成和真实样本无异的图像.

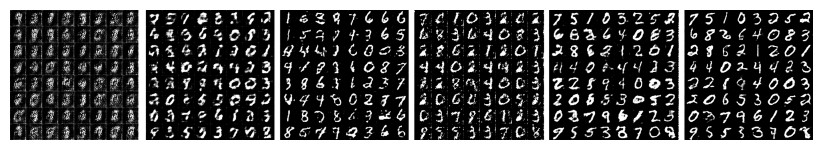

4.2 CIFAR-10实验

CIFAR-10数据集包含10类60 000个图像尺寸为$ (32, 32, 3) $的彩色图像, 其中有50 000个训练样本和10 000个测试样本[18].在GAN领域, CIFAR-10数据集作为一个有着3通道的彩色多类别数据集, 在保证样本数据精巧的同时不失复杂度, 一直是验证新型GAN有说服力的实验数据集之一.

在训练过程中, 与MNIST数据集的实验相似, 使用类似图 5和图 6的结构作为C-CapsGAN的生成器和判别器对CIFAR-10数据集进行训练, 生成器的输出和判别器和分类器的输入为$ (32, 32, 3) $大小的样本矩阵, 设置判别器与生成器的迭代次数为2:1, 其他参数设置如下:

1) Batch设置为32;

2) Epoch设置为75轮;

3) Adam优化器的学习速率设置为0.0001, 一阶矩估计的指数衰减率为0.5, 二阶矩估计的指数衰减率为0.9;

4) 生成器除了最后一层使用Tanh函数作为激活函数之外, 其他层都使用ReLU作为激活函数;

5) 判别器则使用Leaky ReLU作为激活函数;

本实验将胶囊判别器的网络参数设置为和原始CapsNets网络参数相同, 为了使实验结果更具客观性, 同时体现本文提出的C-CapsGAN方法良好的学习性能和对抗能力, 将会把C-CapsGAN采样结果与传统GAN、DCGAN在CIFAR-10数据集上的采样结果进行比较.

4.2.1 CIFAR-10实验结果

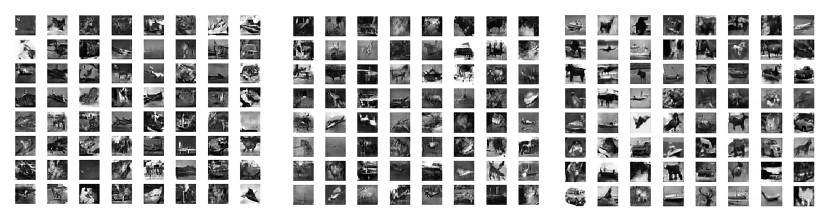

图 18和图 19分别表示了C-CapsGAN的判别器的损失函数(g_loss)和生成器的损失函数(d_loss)随训练次数增加而变化的情况.从损失变化图可以看到, 由于使用的CIFAR-10数据集的复杂性, 使得模型在轮数迭代期间, 判别器和生成器的训练过程一直呈现出此消彼长的震荡状态.

图 20是设置为32个胶囊C-CapsGAN在执行完指定Epoch之后随机采样生成的CIFAR-10数据样本, 可以看出, 经过充分的学习之后, C-CapsGAN生成的样本多样性好, 图像清晰锐利, 同时样本数据分布与真实的CIFAR-10数据集样本非常接近.

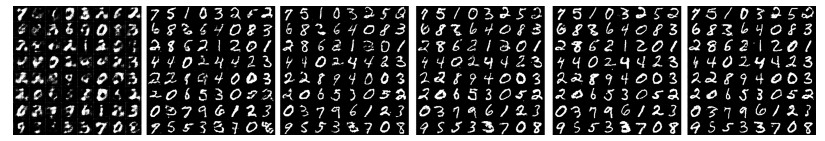

为了更为客观地反映C-CapsGAN优越的学习性能和生成能力, 本文还将C-CapsGAN与传统GAN和DCGAN同时在CIFAR-10数据集上训练的采样结果进行比较, 三者除了网络模型架构不同, 训练超参数、损失函数等其他非网络结构参数均保持一致.如下图 21是DCGAN结构在CIFAR-10数据集训练了Epoch次之后的随机采样结果; 图 22是传统GAN结构在CIFAR-10数据集训练了Epoch次之后的随机采样结果.可以直观地看出无论是多样性还是样本质量, 本文提出的方法均显著优于传统GAN和DCGAN.

同时, 在进行对比实验中发现, 无论是传统GAN还是DCGAN, 在训练后期, 随机采样的样本总是出现类似图 24所展示的情况, 样本之间的颜色呈现一致性.忽略样本内容分别观察DCGAN在Epoch为55、65、75的随机采样结果发现: Epoch为55时, DCGAN采样结果的颜色均偏亮黄色、Epoch为65时, DCGAN采样结果的颜色均偏暗黄色、Epoch为75时, DCGAN采样结果的颜色均偏灰色, 这和CIFAR-10数据集的真实分布是不相符合的.然而, 此类情况在本文提出的C-CapsGAN中并未出现, 正如图 23所示, 在训练后期通过对C-CapsGAN生成样本进行随机采样发现, 本文方法所生成的样本颜色多彩丰富.即意味着, 本文提出的方法相比传统GAN和DCGAN, 能够有效抑制模式坍塌的出现, 换言之, 正因为C-CapsGAN网络内部胶囊的存在, 才使得网络在习得对象特征的同时还存储了对象特征之间的分层姿态关系(位置、颜色、方向、形状等), 从而胶囊判别器能够指导生成器朝着真实样本分布的方向持续优化.

5. 结论

本文利用WGAN、CGAN的优点, 来探索最新的神经网络架构CapsNets在生成领域的应用, 新方法C-CapsGAN在MNIST数据集和CIFAR-10数据集均取得优异的生成结果.特别地, 在MINST数据集上着重探索了C-CapsGAN中胶囊个数对生成对抗网络的训练收敛性和生成质量的影响, 得出胶囊个数对于生成结果来说存在最优值的结论; 在CIFAR-10数据集上则探索了C-CapsGAN在彩色复杂数据集上的应用, 并通过对比现有的生成对抗网络架构的训练过程和样本结果发现, 本文的C-CapsGAN方法在胶囊结构的支持下能够更加有效地抑制模式坍塌问题.总的来说, 通过将胶囊个数调节合适的CapsNets架构运用到生成式对抗网络的判别器中, 使得在生成式对抗网络的内部同时存在反向传播和动态路由两种优化算法, 在生成高质量图像的同时能更好地应对可能出现的模式坍塌等常见问题.本文仍有不足之处, 由于CapsNets网络的引入, 胶囊层之间特征的聚类算法是通过迭代的方式进行的, 因此训练速度较慢, 在今后的工作中, 如何从网络结构的角度提高训练速度将是重要的研究命题.同时具有位姿特征的三维模型是当下研究的难点, 而胶囊的特性使得它能够比传统的卷积神经网络更适合三维结构模型, 未来的工作也会着重思考如何利用CapsNets在GAN的应用来更好地寻找刻画三维模型特征的方法.

-

表 1 基准测试函数

Table 1 Benchmark functions

函数名称 目标函数 维数 取值范围 Scaffer $ \begin{aligned} f_{1} \left(x \right)= 0.5-\frac{[{\sin^{2}\left({x_{1}^{2} +x_{2}^{2} } \right)^{0.5}}]}{[{1+0.001\left({x_{1}^{2} +x_{2}^{2} } \right)^{2}}]} \end{aligned} $ 2 [0, 1] Sphere $ f_{2} \left(x \right)=\sum\limits_{i=1}^n {x_{i}^{2} } $ 5 $ (-30, 30) $ Griewank $ \begin{aligned} f_{3} \left(x \right)=\frac{1}{4000}\sum\limits_{i=1}^n {x_{i}^{2} } - \prod\limits_{i=1}^n {\cos \left({\frac{x_{i} }{\sqrt{i}}} \right)} +1 \end{aligned} $ 20 $ (-30, 30) $ Scaffer7 $ \begin{aligned} f_{4} \left(x \right)=\sum\limits_{i=1}^{n-1} {\left({x_{i}^{2} +x_{i+1}^{2} } \right)^{0.25}} \times [{\sin^{2}({50\left({x_{i}^{2} +x_{i+1}^{2} } \right)^{0.1}})+2}] \end{aligned} $ 30 $ (-100, 100) $ Rastrigin $ \begin{aligned} f_{5} \left(x \right)= \sum\limits_{i=1}^n {({x_{i}^{2} -10\cos 2\pi x_{i} +10})} \end{aligned} $ $ n $ $ (-5.12, 5.12) $ Rosenrrock $ \begin{aligned} f_{6} \left(x \right)= \sum\limits_{i=1}^n {[{100\left({x_{i+1} -x_{i}^{2} } \right)^{2}+x_{i}^{2} }]} \end{aligned} $ $ n $ $ (-30, 30) $ 表 2 不同函数收敛性能指标对比结果

Table 2 Comparison results of convergence performance indexes of different functions

$ f $ 算法 $ Su $ (%) $ Max $ $ Min $ $ \overline {Ave} $ $ T$ (s) $ f_{1} $ ECO 100 -0.997 -1 -0.999 6.79 PSO 12 -0.23 -0.95 -0.68 11.37 DSA 100 -0.96 -1 -0.98 6.13 SWPA 100 -0.93 -1 -0.97 7.74 $ f_{2} $ ECO 100 1.78E-6 0 6.37E-10 6.37 PSO 100 5.27E-4 5.77E-6 1.19E-4 12.76 DSA 100 6.27E-3 3.09E-4 1.62E-3 8.36 SWPA 100 1.04E-4 3.33E-5 6.24E-5 14.55 $ f_{3} $ ECO 100 7.24E-4 0 1.29E-3 10.88 PSO 0 1.51 0.012 0.84 15.27 DSA 98 3.28E-3 1.93E-3 2.74E-3 12.70 SWPA 100 6.53E-3 2.85E-3 3.48E-3 11.09 $ f_{4} $ ECO 100 2.81E-5 6.34E-8 7.11E-7 22.16 PSO 0 17.11 6.25 10.78 27.94 DSA 79 0.07 1.83E-2 0.04 11.22 SWPA 80 0.18 3.64E-72 0.01 14.55 $ f_{5} $ ECO 100 1.11E-6 0 4.89E-9 7.41 PSO 0 20.47 11.25 19.86 10.28 DSA 65 0.063 3.21E-2 0.017 6.89 SWPA 86 0.025 4.44E-3 0.008 8.77 $ f_{6} $ ECO 17 0.467 0.013 0.227 15.23 PSO 0 88.171 21.073 44.110 20.79 DSA 0 22.145 6.667 8.936 18.81 SWPA 11 6.652 2.147 3.667 12.56 表 3 不同重构评价指标对比

Table 3 Comparison of evaluation indexes of different reconfiguration

重构算法稀疏度 $ K=15 $ MSE DSR (%) $ \overline {T_{l} } $ (s) SNR IStOMP 1.23 100 14.881 39.114 StOMP 91.27 7 9.524 27.047 SP 12.54 89 6.227 36.541 BSMP 16.76 99 8.123 35.046 -

[1] Luo C, Wu F, Sun J, Chen C W. Efficient measurement generation and pervasive sparsity for compressive data gathering. IEEE Transactions on Wireless Communications, 2010, 9(12): 3728-3738 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=c2a1c12bd89e33b724c1e1e60d41dd00 [2] Kennedy J, Eberhart R C. Particle swarm optimization. In: Proceedings of the 1995 IEEE International Conference on Neural Networks. Perth, Australia: IEEE, 1995. 1942-1948 [3] Colorni A, Dorigo M, Maniezzo V. Distributed optimization by ant colonies. In: Proceedings of the First European Conference on Artificial Life. Paris, France: Elsevier Publishing, 1991. 134-142 [4] Eusuff M M, Lansey K E. Optimization of water distribution network design using the shuffled frog leaping algorithm. Journal of Water Resources Planning and Management, 2003, 129(3): 210-225 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=0e23c56470bc29ab284b932833c2fe22 [5] Tan Y, Zhu Y C. Fireworks algorithm for optimization. In: Proceedings of the First International Conference on Advances in Swarm Intelligence. Beijing, China: Springer-Verlag, 2010. 355-364 [6] 莫修文, 张强, 陆敬安.模拟退火法建立数字岩心的一种补充优化方案.地球物理学报, 2016, 59(5): 1831-1838 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=dqwlxb201605026Mo Xiu-Wen, Zhang Qiang, Lu Jing-An. A complement optimization scheme to establish the digital core model based on the simulated annealing method. Chinese Journal of Geophysics, 2016, 59(5): 1831-1838 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=dqwlxb201605026 [7] 李宝磊, 施心陵, 苟常兴, 吕丹桔, 安镇宙, 张榆锋.多元优化算法及其收敛性分析.自动化学报, 2015, 41(5): 949-959 doi: 10.16383/j.aas.2015.c140585Li Bao-Lei, Shi Xin-Ling, Gou Chang-Xing, Lv Dan-Ju, An Zhen-Zhou, Zhang Yu-Feng. Multivariant optimization algorithm and its convergence analysis. Acta Automatica Sinica, 2015, 41(5): 949-959 doi: 10.16383/j.aas.2015.c140585 [8] Ebrahimi D, Assi C. Network coding-aware compressive data gathering for energy-efficient wireless sensor networks. ACM Transactions on Sensor Networks, 2015, 11(4): Article No. 61 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=8f2aa328e1976324b2567f8fb8839203 [9] Liang J J, Qin A K, Suganthan P N, Baskar S. Comprehensive learning particle swarm optimizer for global optimization of multimodal functions. IEEE Transactions on Evolutionary Computation, 2006, 10(3): 281-295 http://cn.bing.com/academic/profile?id=cf4e7f5803244a494e7503db7e0301fc&encoded=0&v=paper_preview&mkt=zh-cn [10] 马卫, 孙正兴.采用搜索趋化策略的布谷鸟全局优化算法.电子学报, 2015, 43(12): 2429-2439 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=dianzixb201512013Ma Wei, Sun Zheng-Xing. A global cuckoo optimization algorithm using coarse-to-fine search. Acta Electronica Sinica, 2015, 43(12): 2429-2439 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=dianzixb201512013 [11] 田瑾.高维多峰函数的量子行为粒子群优化算法改进研究.控制与决策, 2016, 31(11): 1967-1972 http://d.old.wanfangdata.com.cn/Periodical/kzyjc201611006Tian Jin. Improvement of quantum-behaved particle swarm optimization algorithm for high-dimensional and multi-modal function. Control and Decision, 2016, 31(11): 1967-1972 http://d.old.wanfangdata.com.cn/Periodical/kzyjc201611006 [12] Lee K S, Geem Z W. A new meta-heuristic algorithm for continuous engineering optimization: harmony search theory and practice. Computer Methods in Applied Mechanics and Engineering, 2005, 194(36-38): 3902-3933 http://cn.bing.com/academic/profile?id=cf8b4b943f7d683011d8b80fe90e576f&encoded=0&v=paper_preview&mkt=zh-cn [13] 崔晓晖, 印桂生, 董红斌.面向服务匹配问题的协同演化算法.软件学报, 2015, 26(7): 1601-1614 http://d.old.wanfangdata.com.cn/Periodical/rjxb201507004Cui Xiao-Hui, Yin Gui-Sheng, Dong Hong-Bin. Co-evolutionary algorithm for web service matching. Journal of Software, 2015, 26(7): 1601-1614 http://d.old.wanfangdata.com.cn/Periodical/rjxb201507004 [14] Donoho D L. Compressed sensing. IEEE Transactions on Information Theory, 2006, 52(4): 1289-1306 http://d.old.wanfangdata.com.cn/Periodical/hwyhmb200904014 [15] 王艳芬, 丛潇雨, 孙彦景.一种稀疏度自适应超宽带信道估计算法.电子科技大学学报, 2017, 46(3): 498-504 http://d.old.wanfangdata.com.cn/Periodical/dzkjdxxb201703004Wang Yan-Fen, Cong Xiao-Yu, Sun Yan-Jing. Sparsity adaptive algorithm for ultra-wideband channel estimation. Journal of University of Electronic Science and Technology of China, 2017, 46(3): 498-504 http://d.old.wanfangdata.com.cn/Periodical/dzkjdxxb201703004 [16] 杨成, 冯巍, 冯辉, 杨涛, 胡波.一种压缩采样中的稀疏度自适应子空间追踪算法.电子学报, 2010, 38(8): 1914-1917 http://d.old.wanfangdata.com.cn/Periodical/dianzixb201008032Yang Cheng, Feng Wei, Feng Hui, Yang Tao, Hu Bo. A sparsity adaptive subspace pursuit algorithm for compressive sampling. Acta Electronica Sinica, 2010, 38(8): 1914-1917 http://d.old.wanfangdata.com.cn/Periodical/dianzixb201008032 [17] Candés E J, Wakin M B. An introduction to compressive sampling. IEEE Signal Processing Magazine, 2008, 25(2): 21-30 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=f038caf0ee508db10a5b5fd193679bc2 [18] 方红, 杨海蓉.贪婪算法与压缩感知理论.自动化学报, 2011, 37(12): 1413-1421 doi: 10.3724/SP.J.1004.2011.01413Fang Hong, Yang Hai-Rong. Greedy algorithms and compressed sensing. Acta Automatica Sinica, 2011, 37(12): 1413-1421 doi: 10.3724/SP.J.1004.2011.01413 [19] Jing M L, Zhou X Q, Qi C. Quasi-newton iterative projection algorithm for sparse recovery. Neurocomputing, 2014, 144: 169-173 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=931bdad879f0a11b0d9e3465eb736397 [20] Wu T Q, Yao M, Yang J H. Dolphin swarm algorithm. Frontiers of Information Technology & Electronic Engineering, 2016, 17(8): 717-729 http://d.old.wanfangdata.com.cn/Periodical/zjdxxbc-e201608001 [21] 薛俊杰, 王瑛, 李浩, 肖吉阳.一种狼群智能算法及收敛性分析.控制与决策, 2016, 31(12): 2131-2139 http://d.old.wanfangdata.com.cn/Periodical/kzyjc201612003Xue Jun-Jie, Wang Ying, Li Hao, Xiao Ji-Yang. A smart wolf pack algorithm and its convergence analysis. Control and Decision, 2016, 31(12): 2131-2139 http://d.old.wanfangdata.com.cn/Periodical/kzyjc201612003 [22] 刘盼盼, 李雷, 王浩宇.压缩感知中基于变尺度法的贪婪重构算法的研究.通信学报, 2014, 35(12): 98-105 http://d.old.wanfangdata.com.cn/Periodical/txxb201412012Liu Pan-Pan, Li Lei, Wang Hao-Yu. Research on greedy reconstruction algorithms of compressed sensing based on variable metric method. Journal on Communications, 2014, 35(12): 98-105 http://d.old.wanfangdata.com.cn/Periodical/txxb201412012 [23] Dai W, Milenkovic O. Subspace pursuit for compressive sensing signal reconstruction. IEEE Transactions on Information Theory, 2009, 55(5): 2230-2249 http://d.old.wanfangdata.com.cn/OAPaper/oai_arXiv.org_0803.0811 [24] Sun B, Shan X, Wu K, Xiao Y. Anomaly detection based secure in-network aggregation for wireless sensor networks. IEEE Systems Journal, 2013, 7(1): 13-25 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=79912c1f6f0509917d4454d2752aa4a4 期刊类型引用(1)

1. 孔锐,蔡佳纯,黄钢,张冰. 基于复合生成对抗网络的对抗样本生成算法研究. 控制与决策. 2023(02): 528-536 .  百度学术

百度学术其他类型引用(8)

-

下载:

下载:

下载:

下载: