Regression GAN Based Prediction for Physical Properties of Total Hydrogen in Crude Oil

-

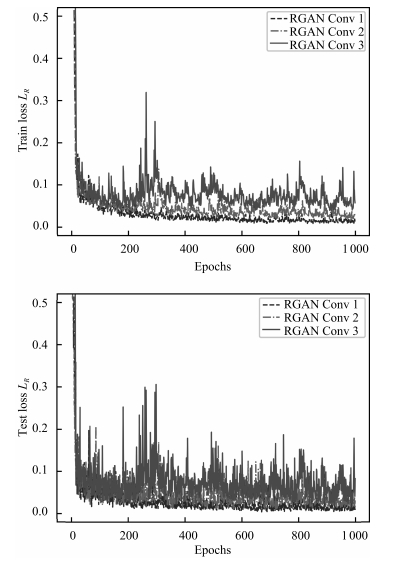

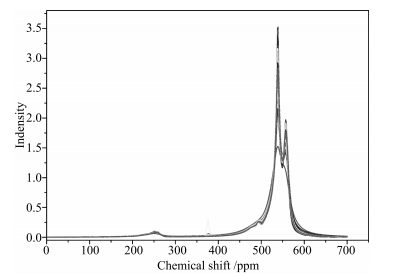

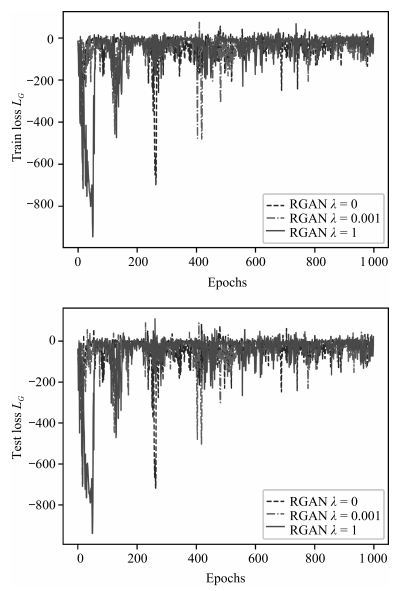

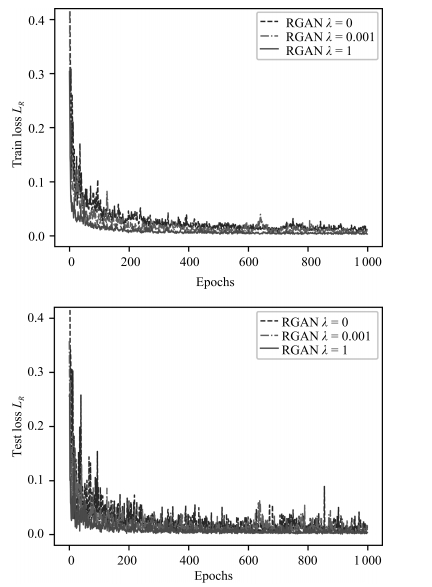

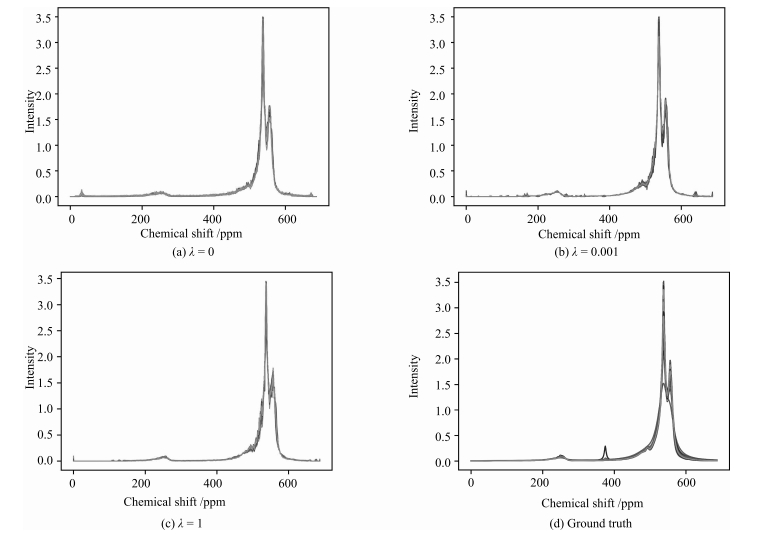

摘要: 针对生成对抗网络(Generative adversarial network,GAN)不适用于原油物性回归预测的问题,本文提出一种回归生成对抗网络(Regression GAN,RGAN)结构,该结构由生成模型G、判别模型D及回归模型R组成.通过判别模型D与生成模型G间的对抗学习,D提取原油物性核磁共振氢谱(1H NMR)谱图的潜在特征.首层潜在特征是样本空间的浅层表示利于解决回归问题,采用首层潜在特征建立回归模型R,提高了预测的精度及稳定性.通过增加条件变量和生成样本间的互信息约束,并采用回归模型R的MSE损失函数估计互信息下界,生成模型G产生更真实的样本.实验结果表明,RGAN有效地提高了原油总氢物性回归预测精度及稳定性,同时加快了生成模型的收敛速度,提高了谱图的生成质量.Abstract: In view that generative adversarial network (GAN) is not applicable to prediction of physical properties of crude oil, a novel regression GAN (RGAN) framework is proposed in this study, which consists of a generator G, a discriminator D and a regression model R. Through adversarial learning between discriminator D and generator G, D extracts a series of latent features of 1H nuclear magnetic resonance spectroscopy (1H NMR) of crude oil. The first layer of latent features is shallow representation of the data space, which helps to solve the regression task. The regression model R is established using the first layer of latent features, which improves the accuracy and stability of the prediction. At the same time, the MSE loss function of the regression model R is applied to estimate the lower bound of the mutual information between conditional variables and generated samples, therefore generator G can produce more realistic samples. Experiment results demonstrate that RGAN can improve the prediction accuracy and stability of physical properties of total hydrogen in crude oil efficiently, and also improve the convergence speed of the generator as well as the quality of spectra generation.

-

-

表 1 RGAN网络结构及超参数

Table 1 The network structure and hyperparameters of RGAN

Operation Kernel Strides Feature maps BN Nonlinearity $G(z)-121 \times 1$ Input Linear(Reshape) N/A N/A 256 × ReLU Tansposed Convolution 5$\times{}$1 2$\times{}$1 128 √ ReLU Tansposed Convolution 5$\times{}$1 2$\times{}$1 64 √ ReLU Tansposed Convolution 5$\times{}$1 2$\times{}$1 1 × TANH $D(x) - 1 \times 688 \times 1$ Input Convolution $(M)$ 10$\times{}$1 2$\times{}$1 64 × Leaky ReLU Convolution 10$\times{}$1 2$\times{}$1 128 √ Leaky ReLU $C - 1 \times 177 \times 1$ Input Convolution 10$\times{}$1 2$\times{}$1 256 √ Leaky ReLU Fully Connected N/A N/A 1 024 √ Leaky ReLU Fully Connected N/A N/A 1 × NONE $R(M) - 1\times 344 \times 64$ Input Convolution 10$\times{}$1 1$\times{}$1 128 √ Leaky ReLU Fully Connected N/A N/A 1 024 √ Leaky ReLU Fully Connected N/A N/A 1 √ TANH Optimizer Adam ($\alpha{}=2\times 10^{-4}$, $\beta{}_1=0.9$, $\beta{}_2=0.999$) Batch size 32 Iterations 1 000 Leaky ReLU slope 0.2 Weight, bias initialization Isotropic Gaussian ($\mu{}=0, $ $\sigma{}=0.02$) 表 2 RGAN与不同预测模型的比较

Table 2 Comparison between RGAN and different prediction models

Models $R_p$ MSEP SVM 0.573 0.084 PLS 0.755 0.028 CNN 0.727 0.030 CGAN + R 0.756 0.027 RGAN $(\lambda{}=0)$ 0.768 0.026 RGAN $(\lambda{}=0.001)$ 0.787 0.024 RGAN $(\lambda{}=1)$ 0.792 0.023 RGAN $(\lambda{}=5)$ 0.776 0.025 -

[1] Jackman L M, Sternhell S. Application of Nuclear Magnetic Resonance Spectroscopy in Organic Chemistry:International Series in Organic Chemistry (2nd edition). Amsterdam:Elsevier, 2013. [2] Simmler C, Napolitano J G, McAlpine J B, Chen S N, Pauli G F. Universal quantitative NMR analysis of complex natural samples. Current Opinion in Biotechnology, 2014, 25:51-59 doi: 10.1016/j.copbio.2013.08.004 [3] Molina V D, Angulo R, Dueñez F Z, Gunmán A. Partial least squares (PLS) and multiple linear correlations between heithaus stability parameters (P0) and the colloidal instability indices (CⅡ) with the 1H nuclear magnetic resonance (NMR) spectra of Colombian crude oils. Energy and Fuels, 2014, 28(3):1802-1810 doi: 10.1021/ef4022224 [4] Adams A, Piechatzek A, Schmitt G, Siegmund G. Single-sided nuclear magnetic resonance for condition monitoring of cross-linked polyethylene exposed to aggressive media. Analytica Chimica Acta, 2015, 887:163-171 doi: 10.1016/j.aca.2015.07.005 [5] Chen J J, Hürlimann M, Paulsen J, Freed D, Mandal S, Song Y Q. Dispersion of T1 and T2 nuclear magnetic resonance relaxation in crude oils. ChemPhysChem, 2014, 15(13):2676-2681 doi: 10.1002/cphc.v15.13 [6] Duarte L M, Filgueiras P R, Dias J C M, Oliveira L M S L, Castro E V R, de Oliveira M A L. Study of distillation temperature curves from Brazilian crude oil by 1H nuclear magnetic resonance spectroscopy in association with partial least squares regression. Energy and Fuels, 2017, 31(4):3892-3897 doi: 10.1021/acs.energyfuels.7b00187 [7] Zhang Y D, Chen S F, Wang S H, Yang J F, Phillips P. Magnetic resonance brain image classification based on weighted-type fractional Fourier transform and nonparallel support vector machine. International Journal of Imaging Systems and Technology, 2015, 25(4):317-327 doi: 10.1002/ima.v25.4 [8] LeCun Y, Bengio Y, Hinton G. Deep learning. Nature, 2015, 521(7553):436-444 doi: 10.1038/nature14539 [9] Goodfellow I J, Pouget-Abadie J, Mirza M, Xu B, Warde-Farley D, Ozair S, et al. Generative adversarial nets. In: Proceedings of the 27th International Conference on Neural Information Processing Systems. Montréal, Canada: NIPS, 2014. 2672-2680 [10] Kingma D P, Rezende D J, Mohamed S, Welling M. Semi-supervised learning with deep generative models. In: Proceedings of the 27th International Conference on Neural Information Processing Systems. Montréal, Canada: NIPS, 2014. 3581-3589 [11] Radford A, Metz L, Chintala S. Unsupervised representation learning with deep convolutional generative adversarial networks. arXiv preprint arXiv: 1511.06434, 2015. http://www.oalib.com/paper/4054347 [12] Springenberg J T. Unsupervised and semi-supervised learning with categorical generative adversarial networks. arXiv preprint arXiv: 1511.06390, 2015. http://arxiv.org/abs/1511.06390 [13] Mirza M, Osindero S. Conditional generative adversarial nets. arXiv preprint arXiv: 1411.1784, 2014. http://www.oalib.com/paper/4066323 [14] Zhao J B, Mathieu M, LeCun Y. Energy-based generative adversarial network. arXiv preprint arXiv: 1609.03126, 2016. http://arxiv.org/abs/1609.03126 [15] Arjovsky M, Chintala S, Bottou L. Wasserstein gan. arXiv preprint arXiv: 1701.07875, 2017. http://arxiv.org/abs/1701.07875 [16] Chen X, Duan Y, Houthooft R, Schulman J, Sutskever I, Abbeel P. Infogan: interpretable representation learning by information maximizing generative adversarial nets. In: Proceedings of the 29th International Conference on Neural Information Processing Systems. Barcelona, Spain: NIPS, 2016. 2172-2180 http://arxiv.org/abs/1606.03657 [17] Kingma D P, Welling M. Auto-encoding variational Bayes. arXiv preprint arXiv: 1312.6114, 2013. http://www.oalib.com/paper/4042889 期刊类型引用(6)

1. 王鑫,张昊宇,凌诚. 基于U-Net优化的SAR遥感图像语义分割. 计算机科学. 2021(S2): 376-381 .  百度学术

百度学术2. 顾炼,许诗起,竺乐庆. 基于FlowS-Unet的遥感图像建筑物变化检测. 自动化学报. 2020(06): 1291-1300 .  本站查看

本站查看3. 彭书娟,曲长文,李健伟,邵嘉琦,骆卉子. 基于ROEWA算子局部活动轮廓的SAR图像分割算法. 系统工程与电子技术. 2019(02): 280-290 .  百度学术

百度学术4. 王勇,景国强. 深度学习在建筑物变化检测中的应用. 电子技术与软件工程. 2019(05): 62 .  百度学术

百度学术5. 彭书娟,曲长文,李健伟. 基于正则化参数估计的SAR图像分割算法. 雷达科学与技术. 2018(01): 14-20 .  百度学术

百度学术6. 张帆,张新红. 基于位错理论的距离正则化水平集图像分割算法. 自动化学报. 2018(05): 943-952 .  本站查看

本站查看其他类型引用(8)

-

下载:

下载: