Strategy Self-adaptive Differential Evolution Algorithm Based on State Estimation Feedback

-

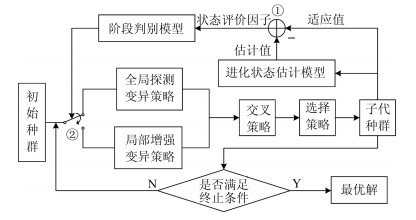

摘要: 借鉴闭环控制思想, 提出基于状态估计反馈的策略自适应差分进化(Differential evolution, DE)算法, 通过设计状态评价因子自适应判定种群个体所处于的阶段, 实现变异策略的反馈调节, 达到平衡算法全局探测和局部搜索的目的.首先, 基于抽象凸理论对种群个体建立进化状态估计模型, 提取下界估计信息并结合进化知识设计状态评价因子, 以判定当前种群的进化状态; 其次, 利用状态评价因子的反馈信息, 实现不同进化状态下策略的自适应调整以指导种群进化, 达到提高算法搜索效率的目的.另外, 20个典型测试函数与CEC2013测试集的实验结果表明, 所提算法在计算代价、收敛速度和解的质量方面优于主流改进差分进化算法和非差分进化算法.Abstract: Inspired by the idea of closed-loop control, a strategy self-adaptive differential evolution (DE) algorithm based on state estimation feedback is proposed, the stage of individual can be self-adaptively determined by designing the state judgment factor, and achieve the feedback adjustment of mutation strategies. Consequently, the algorithm can get a trade-off between the exploration and exploitation. Firstly, the estimation model of evolution state is established based on abstract convex theory, from which the underestimation information is extracted combining with the evolutionary information to design the state judgment factor, so that the evolution state of the current population is estimated. Secondly, according to the feedback information of the state judgment factor, the strategy in different evolution state is adaptively selected to guide the evolution of the population. Therefore, the searching efficiency of the algorithm can be improved. Additionally, experimental results of 20 benchmark functions and CEC2013 test set show that the proposed algorithm is superior to the main-stream differential evolution variants and non-differential evolution algorithms mentioned in this paper in terms of computational cost, convergence speed, and solution quality.

-

Key words:

- Differential evolution (DE) /

- state estimation /

- feedback /

- global optimization /

- abstract convex

-

随着无线通信技术的进步以及无线传感器网络(Wireless sensor network, WSN)和物联网等的高速发展, 如何精确定位监控区域内的多个目标已经成为信号处理领域中极具挑战和实际意义的问题.多目标定位可以应用于诸多场景, 例如, WSN中传感器节点定位[1]、室内定位[2]、污染源定位[3]、无线电监控等.

传统的定位算法主要分为两类.一类是基于测距的定位算法, 典型算法有利用到达时间测距(Time of arrival, ToA)、利用到达时间差测距(Time difference of arrival, TDoA)、利用到达角度测距(Angle of arrival, AoA)和利用接收信号强度进行三边测距(Received signal strength indicator, RSSI)[4]; 一类是非测距的定位算法, 典型算法有DVhop定位[5]、基于信道感知定位[6]和RSSI指纹定位[7-8]等.然而这些方法都显示出一定的局限性.

近年来, 压缩感知(Compressive sensing, CS)理论的兴起[9]为我们提供了一种全新的视角去看待多目标定位问题.通过对感知区域的网格化, 目标位置在空间域上的稀疏性为压缩感知理论体系的应用提供了可能.研究表明[10-11], 基于压缩感知的多目标定位方法能够实现比传统的定位方法更好的定位性能. Cevher等[12-13]提出了WSN中多目标定位的估计框架, 提出只需少量的测量, 便可以将目标位置的稀疏向量通过传感矩阵进行恢复.在此之后, Feng等[10]开始将多目标定位问题建立在压缩感知欠定方程上, 并采取了基追踪(Basis pursuit, BP)和基追踪降噪(Basis pursuit denoising, BPDN)等恢复算法进行仿真测试及性能比较. Zhang等[11]使用贪婪匹配追踪(Greedy matching pursuit, GMP)算法替代传统的压缩感知恢复算法, 提高了恢复的准确性, 同时对传感矩阵是否满足有限等距特性(Restricted isometry property, RIP)[9]进行了证明. Lin等[14]通过融合两种网格下的恢复结果获得了分集增益, 提高了定位精度.

然而, 之前基于压缩感知定位的研究有诸多不足. 1)求解基于压缩感知的多目标定位问题时, 基于优化逼近的方法定位精度高但计算复杂, 基于贪婪恢复的方法计算简单却定位精度低; 2)简单使用一般的压缩感知恢复算法来实现定位, 忽略了多目标定位问题中丰富的结构信息, 无法有效提升定位性能; 3)为降低密集网格划分带来的强相关性, 文献中广泛采用的正交预处理方法[10]削弱了原始定位模型中的信噪比, 使得定位算法的抗噪性能大幅降低.

鉴于此, 本文针对多目标定位问题, 给出了明确的系统模型, 证明预处理方法削弱模型信噪比, 提出一种新颖的基于压缩感知的层级贪婪匹配追踪定位算法(Hierarchical greedy matching pursuit, HGMP).所提算法具有线性计算复杂度, 提供了一种利用多目标定位场景中的结构信息实现快速贪婪定位的层级架构, 提高了多目标定位系统的定位精度和抗噪声性能.

1. 系统模型

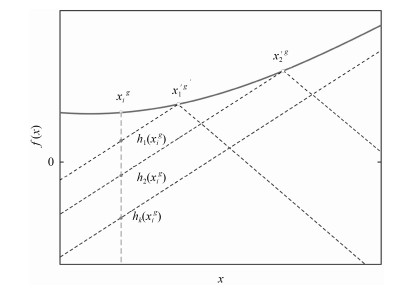

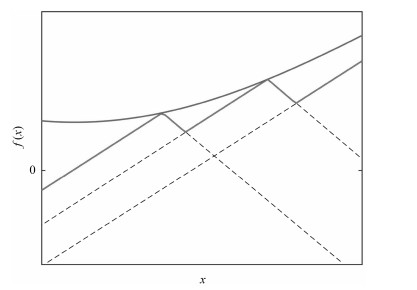

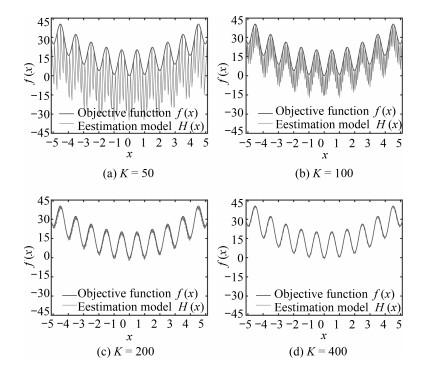

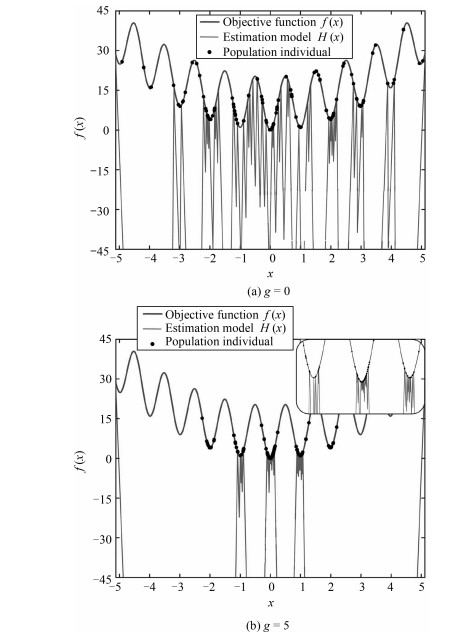

本节首先阐述基于德劳内三角剖分的空间网格化方法, 介绍基于压缩感知的多目标定位模型及各参数的意义.其次, 从压缩感知理论出发, 讨论定位问题中目标数、传感器数目、网格数目三者的相互制约关系.接着, 证明文献中广泛采用的基于正交的预处理操作本质上降低信噪比.最后, 在讨论部分阐述本文的主要动机.

1.1 空间德劳内三角网格划分

不失一般性, 设已知存在$K$个目标的二维感知区域被离散成$N$个网格点(目标服从感知区域内的连续均匀分布), 其中随机均匀散布$M$个传感器(位置已知), 每个传感器测量该点处的接收信号强度(Received signal strength, RSS).在空间网格点数目足够大的前提下, 可以用网格点近似估计目标的位置来确定$K$个目标发射源的位置.

空间网格化是构建定位模型的第一步, 文献中广泛采用均匀矩形网格划分.理论上, 三角形和四面体是二维和三维空间的单纯形, 可以剖分任意复杂的几何形状.因三角剖分具有良好的灵活性和稳定性, 20世纪80年代后, 对三角剖分的研究飞速发展, 除了在有限元分析, 流体力学等传统领域大放光彩外, 在模式识别, 虚拟现实, 计算机视觉等领域也得到广泛的应用.

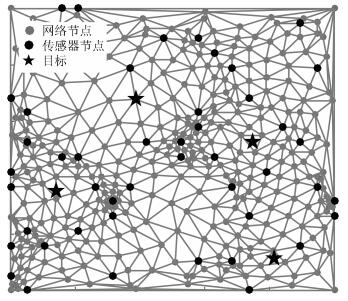

本文采用新提出的基于德劳内三角剖分的空间网格化方法(Delaunay triangulation spatial gridding, DTSG)[14]. DTSG方法利用传感器节点和四个边界点作为原始网格点, 对感知区域进行初步的德劳内三角剖分, 然后依次添加各个德劳内三角形的重心作为新的网格节点, 重新对感知区域进行德劳内三角剖分, 如此迭代分裂, 直至网格点个数满足预设大小.相比均匀矩形网格, 其具有灵活、网格多分辨率、网格密度自适应的特点. Lin等[14]的研究显示, 统计平均意义下, DTSG网格划分方法的定位性能优于传统的均匀矩形网格划分方法.而实际中, 传感器的布置符合一定的先验知识, 如在无线电监控中, 固定监测站点和移动监测平台往往布置在非法电台出现机率大的区域.所以, 这种由传感器节点位置生成网格的空间划分方法更切合实际应用.图 1给出了$M=50$, $N=441$设定下DTSG网格划分结果.其中黑色圆点为随机布置的传感器节点, 灰色圆点为依据DTSG算法生成的网格节点, 五角星为目标发射源.图 1中的目标发射源节点用于示意定位模型, 由DTSG方法可知网格划分与目标无关.

1.2 基于压缩感知的多目标定位模型

由于$K \ll N$, 所以目标的估计位置在空域上具有稀疏性.根据压缩感知理论, 多目标问题可以抽象为通过$M$维接收信号强度的有噪测量(噪声为测量噪声$n$, 近似为高斯噪声), 重建出$N$维空间中的$K$稀疏位置矢量的稀疏近似问题.模型为

$ \begin{align}\label{model1} \boldsymbol{y} = \Phi \Psi \boldsymbol{x} + \boldsymbol{n} = A\boldsymbol{x} + \boldsymbol{n} \end{align} $

(1) 其中, 称为传感矩阵, 是一个过完备字典.在模型(1)中, 我们用网格点来近似真实的目标位置.各参数的意义如下:

1) 目标稀疏位置矢量$\boldsymbol{x} \in {\bf R}_{+}^{N}$

为$K$稀疏矢量, 编码了目标在网格点中的近似位置.如果目标被近似到第$i$个网格点上时, $x_i$为与目标功率有关的正数$C$, 否则为$0$.

2) 基于RSS的稀疏基矩阵$\Psi \in {{\bf R}^{N \times N}}$

的每一列$\pmb \psi_j$代表所有网格点对网格点$j$处目标的RSS测量.在不考虑信号增益的条件下, 网格点$j$处目标在网格点$i$上的接收信号强度满足空间传播的衰落模型[10]

$ \begin{align}\label{propation1} RSS({d_{i, j}}) = {P_0} + {K_e} - 10\eta \lg \frac {{d_{i, \, j}}}{d_0} + \alpha + \beta \end{align} $

(2) 其中, $P_0$为信号发射功率, $K_e$为环境衰减因子, $d_{i, \, j}$为网格点$j$到网格点$i$的物理距离, $d_0$为近场参考距离. $\alpha$为快衰落的影响因子, $\beta$为阴影衰落的影响因子.显而易见, .不同于压缩感知原理中的稀疏基矩阵, 例如离散余弦变换基、快速傅里叶变换基、离散小波变换基等, 在多目标定位模型(1)中的稀疏基矩阵$\Psi$很可能不是$N$维空间的一个基矩阵, 即${\rm span}(\Psi)\subsetneq {{\bf R}^N}$.

3) 测量矩阵$\Phi \in {{\bf R}^{M \times N}}$

测量矩阵表示网格点中的传感器部署方案.多目标定位问题中, 稀疏基矩阵$\Phi$的前$M$列为传感器所在网格点, 所以测量矩阵形式为$\Phi =I_{M \times N}^M$ $=$ , 其中, $I_M$为$M$阶单位矩阵, 为全零矩阵.

4) 测量结果矢量$\boldsymbol{y} \in {{\bf R}^M}$

测量结果矢量$\boldsymbol{y}$为$M$个传感器的实际RSS测量结果. 中的任一元素$y_i$代表第$i$个传感器感知到的所有目标的功率叠加结果.

$ \begin{align} {y_i} = \sum\limits_{j = 1}^K {RSS({d_{i, j}})} \end{align} $

(3) 1.3 模型参数的约束关系

在多目标定位问题中, 研究者感兴趣的问题是需要多少个接收传感器才能成功定位给定数目的目标发射源?网格划分越密集, 是否定位精度会越高?借由压缩感知理论, 可以获得关于这些问题的初步结论.

对于无噪声压缩感知方程$\boldsymbol{y} = A\boldsymbol{x}$, 文献[11]证明, 若且$A$满足$(2K, \sigma)$的RIP条件, 则$\ell_1$范数最小化问题

$ \begin{align}\label{L1min} \min{\lVert \boldsymbol{x} \rVert}_{1} ~~{\rm s.t.}~~\boldsymbol{y} = A\boldsymbol{x} \end{align} $

(4) 的解为$\hat{\boldsymbol{x}}$, 若$\boldsymbol{x}$是严格$K$稀疏信号, 则; 若$\pmb x$是非严格$K$稀疏信号, 则$\hat{\boldsymbol{x}}$能重建出$\boldsymbol{x}$最主要的$K$个系数.当$\boldsymbol{y}$受到噪声污染时, 压缩感知方程(1)的$\ell_1$范数最小化解的重建误差为${{c_0}{\epsilon_0}+{c_1}{\epsilon}}$, 其中${c_0}$, ${c_1}$为很小的正常数, $\epsilon_0$为$\boldsymbol{y}$的重建允许误差范围, ${\epsilon}$为无噪声时的重建误差.

Zhang等[11]证明了多目标定位模型(1)的传感矩阵$A$以大概率满足RIP条件.所以从压缩感知的重构的角度来看, 给定网格划分结果确定了$A$的构成, 而$A$满足的RIP条件阶数又进一步确定了在当前传感矩阵下能够重构出的最大目标数$K$.同时, 为了重构出稀疏位置矢量$\boldsymbol{x}$, 传感器个数需满足$M$ $\ge$ ${\rm O}(K\lg (N/K))$.

在多目标定位问题中, 目标位置的参数空间是连续的.基于压缩感知的定位方法通过把参数空间网格离散化获得对目标位置的网格点近似估计, 然后由这些网格点构成有限离散的过完备字典(即传感矩阵$A$).网格划分越精细, 网格点和真实目标之间的误差就越小, 但过密的网格会造成稀疏基字典中原子间的相关性越强, 进而使得压缩感知的重构性能下降[15], 有如下定理[12].

定理1 [12]. 令$A \in {{\bf R}^{M \times N}}$为一个过完备字典, $\boldsymbol{a_j}$为其第$j$列, 定义相干性(Coherence) $\mu(A)$为

$ \begin{align} \mu \left( A \right) = \mathop {\max }\limits_{1 \le i \ne j \le N} \frac{{\left| {\left\langle {\boldsymbol{a_i}, \boldsymbol{a_j}} \right\rangle } \right|}}{{{{\left\| {\boldsymbol{a_i}} \right\|}_2}{{\left\| {\boldsymbol{a_j}} \right\|}_2}}} \end{align} $

(5) 令$K \le 1 + 1/16u$, 当$M \ge {\rm O}(K\lg (N/K))$时, 任何$K$稀疏向量$\boldsymbol{x}$可以从测量$\boldsymbol{y} = A\boldsymbol{x}$中通过求解式(4)以大概率恢复.

Cevher等[12]的研究表明, 在基于压缩感知的多目标定位场景中, $ \mu \left( A \right) $依赖于$\Delta /2D$.其中$\Delta$为网格精度, $D$为网格点和传感器之间的最大距离(由传感器部署和网格划分共同决定).从而, $\Delta$决定能够成功定位的目标数的下界, 而$D$决定其上界.

另一方面, 为了缓解密集网格划分造成的传感矩阵各列之间的强相关性对压缩感知重建性能的影响, Feng等[10]提出一种基于正交的预处理方法降低了原始传感矩阵各列之间的相关性.此后, 这种预处理方法被研究者广泛使用[10, 14, 16], 下面对基于正交的预处理方法做出了详细介绍, 并证明在有噪情况下, 其本质上放大了噪声的影响, 降低了信噪比.

1.4 基于正交的预处理方法及其不足

定义1 (预处理算子T). 给定模型$\boldsymbol{y} = A\boldsymbol{x}+\boldsymbol{n}$, 定义线性预处理算子为.其中, $A^†$表示$A$的伪逆, 表示对矩阵$A$的规范正交化操作.

设矩阵$A \in {\bf R}_r^{M \times N}$有SVD分解, 其中$U$和$V$均为正交矩阵, $\Sigma$的主对角线元素为$A$的奇异值, 非主对角元素为$0$. $r$为$A$的秩, $r \le M$.对测量结果矢量进行预处理

$ \begin{align} T\boldsymbol{y} = &\ T ( A\boldsymbol{x} + \boldsymbol{n} ) = \notag \\ &\ { V^{\rm T}(:, 1:r) } V {\Sigma ^† } { U^{\rm T} } ( U \Sigma{ V^{\rm T} }\boldsymbol{x} +\boldsymbol{n} ) = \notag \\ &\ {V^{\rm T}(:, 1:r) } \boldsymbol{x} + \boldsymbol{n}' \end{align} $

(6) 其中, $\boldsymbol{n}' = I_{r \times N}^r{\Sigma ^† }{U^{\rm T}}\boldsymbol{n}$.记$\boldsymbol{z} = T\boldsymbol{y}$, 经过预处理后, 多目标定位模型(1)可以表示为

$ \begin{align}\label{model2} \boldsymbol{z}= Q\boldsymbol{x} + \boldsymbol{n}' \end{align} $

(7) 其中, $V(:, 1:r)$为正交矩阵$V$的前$r$列构成的子矩阵.可以证明, 正交矩阵的随机子矩阵满足RIP条件[17].下文中, 称模型(1)为原始模型, 模型(7)为预处理模型, 相应地, $A$称为原始传感矩阵, $Q$称为预处理传感矩阵.

可见, 相对原始传感矩阵$A$, 预处理传感矩阵$Q$的列间相关性已被大大降低.但预处理算子$T$并不是一个无损操作.从原始模型(1)到预处理模型(7), 相对信号功率, 预处理算子$T$放大了噪声水平, 即预处理算子$T$削弱了信噪比(Signal to noise ratio, SNR), 有如下定理.

定义2 (信噪比SNR). 给定模型$\boldsymbol{y} = A\boldsymbol{x} + \boldsymbol{n}$, $\boldsymbol{x}$为随机向量.其中信号为$A\boldsymbol{x}$, 噪声.模型信噪比定义为

$ \begin{align} SNR = \frac{{\rm E}({\lVert A\boldsymbol{x} \rVert}_2^2)}{{\rm E}({\lVert \boldsymbol{n} \rVert}_2^2)} \end{align} $

(8) 定理2. 给定模型$\boldsymbol{y} = A\boldsymbol{x} + \boldsymbol{n}$, 其中$A \in {\bf R}_M^{M \times N}$, 为随机向量且各分量$x_i$满足i.i.d. 条件.模型信噪比为$SNR_1$.对应预处理模型为, 模型信噪比为$SNR_2$.如果存在E$(x_i^2)$, $i=1, 2, \cdots, N$, 则$SNR_2$ $\le$ $SNR_1$.

证明. $A =U \Sigma_1 V^{\rm T}$.其中,

$ \Sigma_1 =[\Sigma \, \, O_{M \times (N-M)}], \ \ \Sigma = {\rm diag}\{s_1, s_2, \cdots, s_M\} $

$s_i$为$A$的奇异值.

记$V^{\rm T}\boldsymbol{x}=(v_1, v_2, \cdots, v_N)^{\rm T}$, , $1/s_2$, $\cdots, 1/s_M\}$.所以

$ \begin{align*} &\lVert A\boldsymbol{x}\rVert_2^2 = \boldsymbol{x}^{\rm T}V\Sigma_1^{\rm T}U^{\rm T}U{\Sigma_1}V^{\rm T}\boldsymbol{x}=\mathop\sum\limits_{i=1}^{M}{s_i^2}{v_i}^2\\ &T=QA^† =[I_M, O_{M\times(N-M)}]V^{\rm T}\\ &\lVert TA\boldsymbol{x}\rVert_2^2 = \!\boldsymbol{x}^{\rm T}V\Sigma_1^{\rm T}U^{\rm T}U\Sigma^{†}\Sigma^{†}U^{\rm T}U{\Sigma_1}V^{\rm T}\boldsymbol{x}=\!\mathop\sum\limits_{i=1}^{M}{v_i}^2\\ &{\rm E}(\boldsymbol{n}^{\rm T}\boldsymbol{n})=M\sigma^2 \end{align*} $

接下来考虑${\rm E}\{\lVert T\boldsymbol{n}\rVert_2^2\}$:

$ {\rm E}\left\{ {\lVert T\boldsymbol{n}\rVert}_2^2 \right\}={\rm E}\left\{ {\lVert \Sigma^{†}U^{\rm T}\boldsymbol{n}\rVert}_2^2 \right\} $

令$\boldsymbol{z}=U^{\rm T}\boldsymbol{n}$, $U$为正交矩阵.因为高斯白噪的正交变换仍为高斯白噪.所以, $ \boldsymbol{z}\sim {\rm N}(0, \sigma^{2}I)$.从而有

$ {\rm E} \left\{ {\lVert \Sigma^{†}U^{\rm T}\boldsymbol{n}\rVert}_2^2 \right\} ={\rm E}\left\{ {\mathop\sum\limits_{i=1}^{M}{\dfrac{z_i^2}{s_i^2}}}\right\}= {\mathop\sum\limits_{i=1}^{M}{\dfrac{\sigma^2}{s_i^2}}} $

所以

$ \begin{align} &\frac{SNR_1}{SNR_2} = \frac{{\rm E}({\lVert A\boldsymbol{x} \rVert}_2^2){\rm E}({\lVert T\boldsymbol{n} \rVert}_2^2)} {{\rm E}({\lVert TA\boldsymbol{x} \rVert}_2^2){\rm E}({\lVert \boldsymbol{n} \rVert}_2^2)} \notag = \\ &\qquad \frac{{\rm E}\left(\mathop\sum\limits_{i=1}^{M}{s_i^2}{v_i}^2\right)\mathop\sum\limits_{i=1}^{M}{\frac{\sigma^2}{s_i^2}}} {{\rm E}\left(\mathop\sum\limits_{i=1}^{M}{v_i}^2\right)M\sigma^2}= \frac{\mathop\sum\limits_{i=1}^{M}{s_i^2}\mathop\sum\limits_{i=1}^{M}{\frac{1}{s_i^2}}} {M^2}\notag \end{align} $

由Cauchy-Schwarz不等式, 有

$ \begin{align} \mathop\sum\limits_{i=1}^{M}{s_i^2}\mathop\sum\limits_{i=1}^{M}{\frac{1}{s_i^2}} \ge \left(\mathop\sum\limits_{i=1}^{M}{s_i \frac{1}{s_i}}\right)^2=M^2 \notag \end{align} $

综上所述

$ \begin{align} SNR_2 \le SNR_1 \notag \end{align} $

等号成立的条件为: $A$的所有奇异值都为1.

在多目标定位模型(1)中, 按照空间传播损耗模型构建的原始传感矩阵$A$, 其奇异值一般远小于1, 根据定理2, 经过预处理算子$T$处理后, 预处理模型(7)的信噪比将远小于原始模型(1)的信噪比.

1.5 讨论

由上述分析可知, 密集划分网格会造成$A$各列间的强相关性, 进而影响重建性能.而文献中为降低列间相关性而采取的正交预处理操作又被证明是放大噪声影响, 降低模型信噪比.然而, 对于定位场景, 只有目标附近的字典原子才会对真实的信号构成具有明显贡献, 远离目标的位置的原子划分并不会给定位带来益处.所以, 对于给定的网格化空间和相应的过完备字典$A$, 可以将观测子空间视为信号子空间和噪声子空间的叠加.

此外, 在求解压缩感知定位问题上, 文献中采用的$\ell_1$范数最小化方法, 例如BP算法, 定位精度高, 抗噪声性能强, 但当$N$很大时, 其${\rm O}(N^3)$的计算成本过于昂贵. RIP条件意味着$A$近似正交的, 这启发了一系列通过迭代求解$\boldsymbol{x}$的$K$个最大稀疏的贪婪算法, 例如正交匹配追踪算法(Orthogonal matching pursuit, OMP)等.这些贪婪算法通常具有直观, 易于理解, 计算简单的优点.但在定位问题中, 其对噪声较为敏感, 且容易陷入局部最优解中.

所以, 本文的主要动机为以贪婪重建的方式, 利用多目标定位场景中隐含的结构信息, 从观测子空间中分离出信号子空间, 降低测量噪声和网格密集划分所带来的强相关性的影响, 提升贪婪恢复的定位准确性.更具体地, 原始模型(1)中隐藏着丰富的结构信息, 预处理模型(7)适合于贪婪求解, 利用原始模型(1)和预处理模型(7)进行联合迭代贪婪定位, 将获得更优异的定位表现.

2. 层级贪婪匹配追踪定位算法

本节首先分析多目标定位场景中隐含的结构信息.其次, 利用这些结构信息提出一种分层贪婪匹配追踪的多目标定位方法(HGMP).最后, 对所提算法的收敛性和计算复杂度做出分析.

2.1 多目标定位场景中的结构信息

1) 团块模式

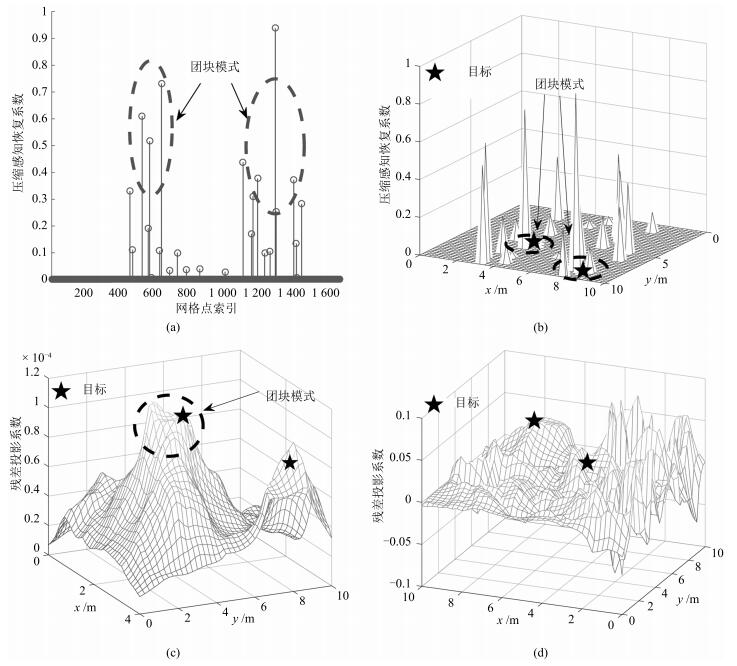

原始模型(1)是对多目标定位问题的网格点近似, 真实的目标位置可能分布在感知区域的任何位置, 不一定精确地在网格点上.所以, 接收信号投影到网格空间上的能量将分散在真实目标附近的原子团上.迭代过程中, 残差投影到网格空间上的能量将分散在对当前残差贡献最大目标附近的原子团上.具体地, 在真实目标位置附近的网格点上, 压缩感知恢复系数或残差在网格空间上的投影具有相近的取值, 且幅度明显高于远离目标位置的网格点上的, 称这种模式为团块模式.图 2 (a)和2 (b)分别展示的是恢复系数在网格点索引集上和网格空间上的团块模式. Yang等[16]注意到了恢复系数的团块模式, 其在BP算法的定位结果上利用KNN聚类对恢复位置进行加权平均, 鉴于BP算法的计算复杂度, 其很难被应用到实际中; 图 2 (c)展示的是在原始传感矩阵$A$上在OMP算法迭代过程中残差的团块模式, 可以清晰看到, 左边的目标对当前残差贡献最大, 其附近的原子团呈现出明显的团块模式; 图 2 (d)展示的是预处理传感矩阵$Q$上OMP算法迭代过程中残差在网格空间上的投影, 由于基于正交的预处理操作打乱了原始传感矩阵$A$中的相关性, 所以不再具有明显的团块模式.本文研究OMP算法迭代过程中残差在原始传感矩阵A的团块模式.

2) 冗余信息

如前所述, 为了在多目标定位问题中应用贪婪类压缩感知恢复算法, 文献中常采用预处理算子$T$.数学上, $T$是一个不可逆算子, 它把$M$维非稀疏矢量$\boldsymbol{y}$映射成$r$维()矢量$\boldsymbol{z}$, 再通过$\boldsymbol{z}$重建$N$维$K$稀疏矢量$\boldsymbol{x}$.前文的分析显示, $T$放大噪声的影响, 降低模型信噪比.此外, 预处理传感矩阵$Q$是一个正交矩阵的子矩阵, 相对原始传感矩阵而言, 其列之间的相关性已被大大降低.所以相对原始模型(1), 预处理模型损失了冗余的信息.对于一个系统来说, 冗余虽然带来有效性的降低, 但是另一方面, 却是系统可靠性的重要保障.在多目标定位问题中, 这种冗余信息的损失可以从$A$和$Q$的列相关性中得到解释. $A$中的每一列$\boldsymbol{a_j}$代表所有传感器对网格点$j$处目标的RSS测量, 空域中网格点$i$和网格点$j$距离越近, $\boldsymbol{a_i}$和$\boldsymbol{a_j}$就越相关.所以$A$的列之间的相关性具有清晰的物理意义.作为这种相关性在残差投影上的反映, 投影结果也会在空域上呈现出清晰的相关性, 如图 2 (c)所示, 残差在原始传感矩阵$A$上的投影呈现出清晰的团块模式.与此相反, 预处理传感矩阵$Q$是正交矩阵$V$的子矩阵, $Q$的列相关性已经无法直接体现空域上网格点间的相关性.如图 2 (d)所示, 残差在传感矩阵$Q$上的投影无清晰的团块模式.

2.2 算法步骤

提出的HGMP算法是一种层级的贪婪算法, 利用多目标定位场景中的结构信息, 具有线性计算复杂度和很好的可解释性. HGMP算法的思想是以贪婪的方式, 逐步发掘多目标定位问题中的残差在原始传感矩阵中投影的团块模式, 进而利用预处理模型获得贪婪恢复.算法特征为:全局估计层获得目标可能位置的全局估计, 稀疏恢复层利用全局估计信息进行目标稀疏位置矢量压缩感知贪婪重建.有以下核心算法步骤.

输入. 测量结果矢量$\boldsymbol{y}$, 原始感知矩阵$A$, 目标数$K$;

输出. 目标位置恢复点集$P$, $\boldsymbol{x}$的$K$稀疏逼近$\hat{\boldsymbol{x}}$;

初始化. 候选集$\Omega \leftarrow \phi $, 残差相关集$\Lambda \leftarrow \phi $, 删除集$\Delta \leftarrow \phi $, 残差$\boldsymbol{v} \leftarrow \boldsymbol{y}$, 格点索引集$\mathbb{N} \leftarrow \{ 1, 2$, $\cdots$, $N\}$;

预处理. 计算预处理感知矩阵$Q$, 计算;

全局估计层. 迭代量, 循环执行步骤$1$ $\sim$ $5$.

步骤1. 寻找对当前残差贡献最大的原子团$\Lambda$ $\leftarrow$ $\{ j| \langle {\boldsymbol{v}, \boldsymbol{a_j}} \rangle > Th( {\boldsymbol{v}, A} )$, ;

步骤2. 利用$\boldsymbol{z}$和$Q$, 在中进行局部正交匹配追踪, 得到$\Lambda$上的的恢复系数$\boldsymbol{\theta}$及其支撑集$\Pi$;

步骤3. 对$\boldsymbol{\theta}$及其支撑集$ \Pi$正则化, 结果为;

步骤4. 迭代更新. , ${\Delta \leftarrow \Delta \cup \Omega}$, $\boldsymbol{v}$ $\leftarrow$ $\boldsymbol{y}-A_{\Omega }A_{\Omega }^{†} \boldsymbol{y}$, ${i \leftarrow i + 1}$;

步骤5. 如果, 进入下一次迭代, 返回步骤1;否则, 进入稀疏恢复层, 执行步骤6;

稀疏恢复层.

步骤6. 扩大候选集

$ {\Omega \leftarrow \Omega \cup \left\{ {l\left. {\left| {l \in Neighbor(j, D), j \in \Omega , l \in \mathbb{N} \backslash \Omega } \right.} \right\}} \right.} $

步骤7. 利用$\boldsymbol{z}$和$Q$, 在候选集$\Omega$中进行正交匹配追踪, 得到$\boldsymbol{x}$的$K$稀疏逼近$\hat{\boldsymbol{x}}$及其支撑集$P$; 其中, $A_\Omega$表示$A$的索引集为$\Omega$的列构成的子矩阵.步骤1中, $Th(\boldsymbol{v}, A)$是自适应动态门限, 定义为

$ {Th(\boldsymbol{v}, A)=\max \{ A_{\mathbb{N} \backslash \Delta}^{\rm T}\boldsymbol{v} \}-{\rm std}(\{ A_{\mathbb{N} \backslash \Delta}^{\rm T}\boldsymbol{v} \}} $

动态门限能够自适应地提取对当前残差贡献最大的原子团, 噪声水平高时, 残差投影系数的方差较大, 动态门限自适应地降低门限值来对抗噪声的干扰, 保证空域上与当前残差相关的目标附近格点能够被选入残差相关集$\Lambda$.反之, 当噪声水平低时, 动态门限会提高门限值, 减少选入残差相关集$\Lambda$中弱相关格点的数目.

步骤3中, 正则化[18]处理旨在从恢复系数中找出幅度相近且具有最大能量的子集.给定恢复系数$\theta$及其下标集合$\Pi$, 在集合$\Pi$中寻找子集$\Pi_0$, 满足

$ \left| {\theta_i} \right| \le 2\left| {\theta_j} \right|, \quad\forall i, j \in {\Pi _0} $

正则化操作选择所有满足要求的子集$\Pi_0$中具有最大能量(的$\Pi_0$作为输出.

步骤6中, $Neighbor(j, D)$指在空域上与格点$j$的欧氏距离小于门限值的格点集合.

2.3 讨论和分析

1) 收敛性和抗噪声性能

不同于一般的基于压缩感知的定位方法, HGMP通过全局估计层获得目标可能位置的候选原子集合, 然后稀疏重建层在候选原子集合上获得最终的稀疏贪婪重建结果.这等效于从观测空间中分离出信号子空间, 然后在信号子空间上进行贪婪正交匹配追踪.在进行全局估计时, 利用原始传感矩阵$A$上残差投影的团块模式, 筛选出对当前残差贡献最大的原子团, 然后利用预处理传感矩阵$Q$易于贪婪恢复的优势获得局部正交匹配追踪恢复结果, 最后通过正则化处理从局部恢复结果中挑选出能量最大且贡献类似的原子团.由正则化操作的分析[18]可知, 最终全局估计层的输出原子团中一定包含OMP最终估计的$K$个原子, 而稀疏重建层算法是子空间上的OMP算法.所以, 在高信噪比条件下, HGMP将和OMP算法保持一致的收敛性.当信噪比较低时, OMP算法易受噪声干扰, 陷入局部最优解中, 而HGMP挑选原子的方法比OMP更为谨慎, 每次挑选出原子团而非单个最相关原子的模式也使得算法对噪声的鲁棒性更强.全局估计层把可能位置从$\mathbb{N}$缩小到候选集$\Omega$, 已经极大地去除了噪声造成的虚假目标位置候选点.所以, 在此基础上进行贪婪恢复定位具有明显的抗噪声优势.

2) 计算复杂度

步骤1中投影操作实质是矩阵向量乘法, 门限比对操作实质是一个遍历过程, 所以步骤1的复杂度为.

步骤2把残差的能量正交投影到残差相关集$\Lambda$上, 实质上是一个OMP子问题, 复杂度为, 其中$C_1 = card(\Lambda)$且$C_1 \ll N$.

步骤3中正则化操作实质上是大小为$C_1$的数集上的排序和二重循环遍历过程, 复杂度为 $+$ $K^{2})$.

步骤4在候选集$\Omega$中更新残差涉及一个最小二乘问题, 复杂度为, 其中$C_2 =card(\Omega)$, 且满足$C_2 \ll N$.

步骤6扩大候选集, 包含$C_2$个遍历格点集合的操作, 复杂度为.

所以, 全局恢复层的复杂度为${\rm O}(K(MN +$ $MC_1^2$ $+$ .渐进地, 当$N$很大时, 占主导作用, 全局估计层的渐进复杂度为${\rm O}(KMN)$.

稀疏恢复层是候选集上的稀疏度为$K$的OMP操作, 其复杂度为.

综上所述, 当$N$较小时, HGMP算法计算复杂度不高于.当$N$很大时, HGMP算法的渐进复杂度为${\rm O}(KMN)$.

3. 算法仿真

为验证所提算法在抗噪性能和计算复杂度方面的提升, 采用经典的OMP算法和BP算法作为对比.此外, 为了对比算法在DTSG网格划分和均匀矩形网格划分上的性能, 对于同样的仿真参数设置, 每一次蒙特卡洛仿真中在两种网格上分别进行定位.仿真的硬件环境为Intel Core i7-6700处理器, 主频3.4 GHz, 8 GB内存; 软件环境为Windows 10 + MATLAB R2016a.

3.1 评价度量

平均定位正确率(Mean localization accuracy rate, MLAR).如果在距离真实目标$T_i$小于1 m的范围内能够找到恢复点$\hat{T_i}$, 认为目标$T_i$被成功定位, 恢复点$\hat{T_i}$被称为目标$T_i$的匹配恢复点.把被成功定位的目标个数${\#Successful\_Localized\_Targets}$与总目标个数${\#Targets}$的比值记为恢复的正确率.

$ \begin{align} MLAR = \frac{{\#Successful\_ Localized\_Targets}}{{\#Targets}} \end{align} $

(9) 平均定位误差距离(Mean localization error distance, MLED)定义为目标$T_i$的真实位置$({x_i}$, ${y_i})$和最近的匹配恢复点位置$({\hat{x}_i, \hat{y}_i})$之间的平均欧氏距离, 公式为

$ \begin{align} MLED = \frac{1}{K}\sum\limits_{i = 1}^K {\sqrt {{{({x_i} - {{\hat x}_i})}^2} + ({y_i} - {{\hat y}_i})^2} } \end{align} $

(10) 平均运行时间(Mean run time, MRT)指每次蒙特卡洛仿真中算法运行时间的平均值, 以此来评价算法的时间复杂度.

3.2 仿真参数选择

感知区域设为$10\, {\rm m} \times 10\, {\rm m}$的方形区域, 网格点$N$ $=21 \times 21$, 目标数$K = 4$.目标有效全向辐射功率.稀疏基字典$\Psi$采用IEEE802.15.4标准中的室内传播损耗模型[14].

$ \begin{align} & RSS(d) = \begin{cases} {P_t} - 40.2 - 20\lg d, &D \le 8\\ {P_t} - 58.5 - 33\lg \frac{d}{8}, &D > 8 \end{cases} \end{align} $

(11) 测量噪声为高斯白噪声, 为了有效验证算法的定位性能, 消除随机因素的影响, 取3 000次仿真的均值作为实验结果(每一次仿真均重新撒布目标和传感器, 重新构造空间网格).

3.3 仿真结果和分析

下文中均匀矩形网格划分简称为矩形网格, DTSG网格划分简称为三角网格.

1) 抗噪声性能和计算复杂度

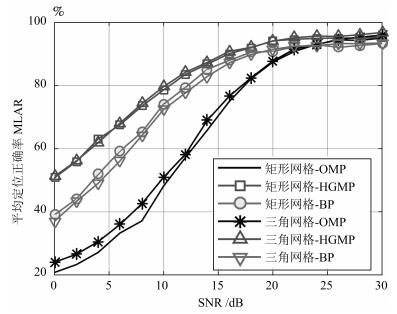

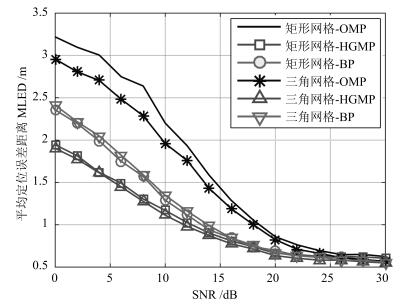

图 3和图 4分别给出了$M=50$时, 在均匀矩形网格划分和DTSG网格划分下各算法的平均定位正确率和平均定位误差距离受信噪比的影响.可以看出:

a) 随着信噪比的增加, 各算法的平均定位正确率不断上升, 平均定位误差距离不断下降.当SNR $>$ 25 dB时, BP和OMP的定位性能趋于收敛, 当SNR $>$ 22 dB时, HGMP的定位性能趋于收敛.由于基于压缩感知的多目标定位模型是对真实目标位置的一个逼近模型, 当信噪比大于一定程度时, 多目标定位问题中的测量噪声不再是主要矛盾.对于图 3, 限制MLAR继续增加的主要因素为定义成功定位的精度(仿真中为1 m)和网格精度(网格划分带来的模型逼近误差, 仿真中平均网格间距为0.5 m); 对于图 4, 限制MLED继续降低的主要因素为网格精度.

b) 在统计平均意义上, 对于BP算法和HGMP算法, DTSG三角网格划分和传统的均匀矩形网格划分的定位性能保持一致; 对于OMP, 在同样的噪声水平下, 三角网格划分能实现比均匀矩形划分更高的定位正确率和更低的定位误差距离.

c) 在噪声占主要影响因素的前提下(SNR $<$ 25 dB), 通过在迭代过程中利用残差的团块模式, 限制在信号子空间上进行贪婪重建, HGMP的定位正确率和定位误差距离优于BP的, 远远优于OMP的, 显示出良好的抗噪能力.

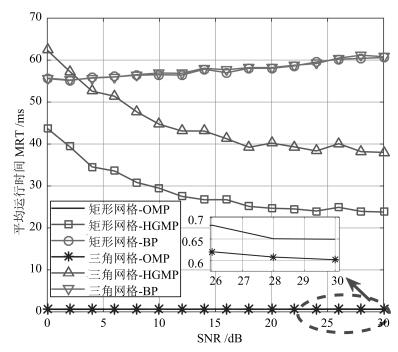

图 5给出上述实验过程中各算法的平均运行时间. HGMP算法的计算复杂度显著低于BP算法.随着信噪比的提高, HGMP的平均运行时间降低.这是因为噪声水平越低, 残差投影的团块结构越明显, 投影方差越小, 每次选入残差相关集$\Lambda$中的格点数目也越少, 从而运行时间也越少.同样的噪声水平下, HGMP算法在三角网格划分上的运行时间要高于矩形网格划分的, 近似是矩形网格划分的常数倍.这是因为计算残差相关集采取的动态门限函数和残差投影标准差相关, 由于三角网格划分的非均匀性和非规则性, 其投影方差大于均匀矩形网格划分的, 导致三角网格中的残差相关集包含更多的格点, 使得三角网格上的运行时间高于矩形网格上的.相对BP算法和HGMP算法, OMP只包含投影、最小二乘、更新残差三个步骤, 所以其计算最为简单, 但从图 3和图 4可以看出, OMP低计算复杂度的代价是对噪声敏感, 当SNR较低时, 定位性能低于HGMP和BP.

2) 传感器个数的影响

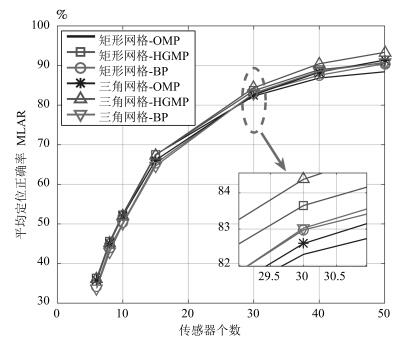

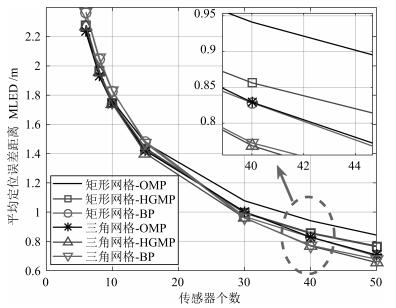

图 6和图 7分别给出了$SNR = 25$ dB条件下, 传感器数目为6, 8, 10, 15, 30, 40, 50时, 均匀矩形网格划分和DTSG网格划分下各算法的平均定位正确率和平均定位误差距离.可以清晰看出, 随着传感器的个数不断增加, 各算法的平均定位正确率不断上升, 平均定位误差距离不断下降, 但变化趋于平缓.对于$K=4$, $M=441$, 理论上需要传感器的下界为.从图 6和图 7可以看出, 当传感器个数小于20时, 所有算法的平均定位误差距离都大于1 m, 平均定位正确率小于70 %.当传感器个数大于30时, 除了在矩形网格划分上的OMP算法外, 其他算法的平均定位误差距离都小于1 m, 相应的平均定位正确率大于82 %.统计意义上, 对于1 m范围的成功定位精度, 经验值和理论值之间的差距为11个传感器.其次, 对于同一传感器数目, HGMP在DTSG三角网格划分和均匀矩形网格划分下都显示出优于其他算法的定位性能, 且在DTSG三角网格划分下的HGMP定位性能最优.

4. 结论

本文给出了一种新颖的基于压缩感知的多目标分层贪婪匹配定位方法(HGMP), 并证明了文献中广泛采用的正交预处理操作降低定位信噪比.所提算法从观测子空间中分离出信号子空间, 利用原始传感矩阵和预处理传感矩阵进行联合迭代贪婪定位, 提供一种利用多目标定位问题中丰富的结构信息实现鲁棒性贪婪定位的层级架构.理论分析和计算仿真表明, HGMP定位算法具有渐进线性复杂度${\rm O}(KMN)$.相同信噪比下, HGMP在不同网格划分上均展示出更好的定位性能.

-

表 1 标准测试函数的参数

Table 1 The parameters of benchmark functions

函数名 表达式 维数($N$) 取值范围 全局最小值 Sphere $f_1({\bm x})=\sum\limits_{i=1}^{N}x_i^2$ 30, 50 $(-100, 100)^N$ 0 SumSquares $f_2({\bm x})=\sum\limits_{i=1}^{N}ix_i^2$ 30, 50 $(-10, 10)^N$ 0 Schwefel 2.22 $f_3({\bm x})=\sum\limits_{i=1}^{N}\left|x_i\right|+\prod\limits_{i=1}^{N}\left|x_i\right|$ 30, 50 $(-10, 10)^N$ 0 Exponential $f_4({\bm x})=-\exp(-0.5$$\sum\limits_{i=1}^{N}$$x_i^2)$ 30, 50 $(-1, 1)^N$ $-1$ Tablet $f_5({\bm x})=10^6x_1^2+\sum\limits_{i=2}^{N}x_i^2$ 30, 50 $(-100, 100)^N$ 0 Step $f_6({\bm x})=\sum\limits_{i=1}^{N}\left\lfloor x_i+0.5\right\rfloor^2$ 30, 50 $(-100, 100)^N$ 0 Zakharov $f_7({\bm x})=\sum\limits_{i=1}^{N}x_i^2+\sum\limits_{i=1}^{N}(0.5ix_i)^2+\sum\limits_{i=1}^{N}(0.5ix_i)^4$ 30, 50 $(-5, 10)^N$ 0 Rosenbrock $f_8({\bm x})=\sum\limits_{i=1}^{N-1}[100(x_{i+1}-x_i^2)^2+(x_i-1)^2]$ 30, 50 $(-30, 30)^N$ 0 Griewank $f_9({\bm x})=1+\frac{1}{4000}\sum\limits_{i=1}^{N}x_i^2-\prod\limits_{i=1}^{N}\cos(\frac {x_i}{\sqrt{i}})$ 30, 50 $(-600, 600)^N$ 0 Schaffer 2 $f_{10}({\bm x})=\sum\limits_{i=1}^{N-1}(x_i^2+x_{i+1}^2)^{0.25}(\sin^2(50(x_i^2+x_{i+1}^2)^{0.1})+1)$ 30, 50 $(-100, 100)^N$ 0 Schwefel 2.26 $f_{11}({\bm x})=-\sum\limits_{i=1}^{N}x_i\sin(\sqrt{\left\|x_i\right\|})$ 30, 50 $(-500, 500)^N$ $-12 569.18$ Himmelblau $f_{12}({\bm x})=N^{-1}\sum\limits_{i=1}^{N}(x_i^4-16x_i^2+5x_i)$ 30, 50 $(-5, 5)^N$ -78.3323 Levy and Montalvo 1 $f_{13}({\bm x})=\frac{\pi}{N}(10\sin^2(\pi y_1)+\sum\limits_{i=1}^{N-1}(y_i-1)^{2} [1+\\ 10\sin^2(\pi y_{i+1})]+(y_N-1)^2)$, $y_i=1+\frac{1}{4}(x_i+1)$ 30, 50 $(-10, 10)^N$ 0 Levy and Montalvo 2 $f_{14}({\bm x})=0.1(\sin^2(3\pi x_i)+\sum\limits_{i=1}^{N-1}(x_i-1)^{2} [1+\sin^2(3\pi x_{i+1})]+\\ (x_N-1)^2[1+\sin^2(2\pi x_N)])$ 30, 50 $(-5, 5)^N$ 0 Ackley $f_{15}({\bm x})=-20\exp(-0.02\sqrt{N^{-1}\sum\limits_{i=1}^{N}x_i^2}) -\exp(N^{-1}$ 30, 50 $(-30, 30)^N$ 0 $\sum\limits_{i=1}^{N}\cos(2\pi x_i))+20+e$ Rastrigin $f_{16}({\bm x})=10N+\sum\limits_{i=1}^{N}(x_i^2-10\cos(2\pi x_i))$ 30, 50 $(-5, 5)^N$ 0 Penalized 1 $f_{17}(x)=\frac{\pi}{N}\{\sum\nolimits_{i=1}^{N-1}(y_i-1)^2[1+ \sin(\pi y_{i+1})]+(y_N-1)^2+$ $(10\sin^2(\pi y_1))\}+\sum\nolimits_{i=1}^Nu(x_i, 10, 100, 4)$, $y_i=1+\frac{x_i+1}{4}$ $u(x_i, a, k, m) = \left\{ \begin{array}{ll} k(x_i-a)^m, ~~~~ x_i> a \\ 0, ~~~~-a\leq x_i\leq a \\ k(-x_i-a)^m, ~~~~x_i < -a \end{array} \right.$ 30, 50 $(-50, 50)^N$ 0 Penalized 2 $f_{18}(x)=0.1\{\sin^2(3\pi x_1)+\sum\nolimits_{i=1}^{N-1} (x_i-1)^2[1+\sin^2(3\pi x_{i+1})]+$ $(x_N-1)^2[1+\sin^2(2\pi x_N)]\}+\sum\nolimits_{i=1}^Nu(x_i, 5, 100, 4)$ 30, 50 $-(50, 50)^N$ 0 Neumaier $f_{19}({\bm x})=\sum\limits_{i=1}^{N}(x_i-1)^2- \sum\limits_{i=2}^{N}x_ix_{i-1}+\frac{N(N+4)(N-1)}{6}$ 30, 50 $(-900, 900)^N$ 0 Alpine $f_{20}({\bm x})=\sum\limits_{i=1}^{N}\left|x_i\sin x_i+0.1x_i\right|$ 30, 50 $(-10, 10)^N$ 0 表 2 SEFDE中参数$K$设置下的平均函数评价次数和成功率

Table 2 Average numbers of function evaluations and success rates of parameter settings $K$ in SEFDE

Fun $N$ $K=2$ $K=3$ $K=4$ $K=5$ $K=6$ FEs SR FEs SR FEs SR FEs SR FEs SR $f_{1}$ 30 1.51E+04 1.00 1.19E+04 1.00 1.26E+04 1.00 1.21E+04 1.00 1.18E+04 1.00 $f_{2}$ 30 1.17E+04 1.00 1.14E+04 1.00 1.19E+04 1.00 1.06E+04 1.00 1.14E+04 1.00 $f_{3}$ 30 1.85E+04 1.00 1.76E+04 1.00 1.73E+04 1.00 1.75E+04 1.00 1.83E+04 1.00 $f_{4}$ 30 7.88E+03 1.00 7.89E+03 1.00 7.85E+03 1.00 7.83E+03 1.00 7.87E+03 1.00 $f_{5}$ 30 2.94E+04 1.00 2.97E+04 1.00 2.93E+04 1.00 2.91E+04 1.00 2.90E+04 1.00 $f_{6}$ 30 8.94E+03 1.00 8.61E+03 1.00 8.56E+03 1.00 8.28E+03 1.00 8.45E+03 1.00 $f_{7}$ 30 1.46E+05 1.00 1.45E+05 1.00 1.46E+05 1.00 1.46E+05 1.00 1.44E+05 1.00 $f_{8}$ 30 1.24E+05 1.00 1.20E+05 1.00 1.21E+05 1.00 1.22E+05 1.00 1.21E+05 1.00 $f_{9}$ 30 1.28E+04 1.00 1.26E+04 1.00 1.25E+04 1.00 1.27E+04 1.00 1.24E+04 1.00 $f_{10}$ 30 1.00E+05 1.00 1.09E+05 1.00 1.10E+05 1.00 1.07E+05 1.00 1.09E+05 1.00 $f_{11}$ 30 4.43E+04 1.00 4.34E+04 1.00 4.57E+04 1.00 4.40E+04 1.00 4.48E+04 1.00 $f_{12}$ 30 1.24E+04 1.00 1.71E+04 1.00 1.74E+04 1.00 1.64E+04 1.00 1.70E+04 1.00 $f_{13}$ 30 1.26E+04 1.00 1.24E+04 1.00 1.26E+04 1.00 1.27E+04 1.00 1.26E+04 1.00 $f_{14}$ 30 1.18E+04 1.00 1.19E+04 1.00 1.20E+04 1.00 1.22E+04 1.00 1.19E+04 1.00 $f_{15}$ 30 2.02E+04 1.00 1.95E+04 1.00 2.01E+04 1.00 2.02E+04 1.00 1.98E+04 1.00 $f_{16}$ 30 5.60E+04 1.00 5.44E+04 1.00 5.62E+04 1.00 5.34E+04 1.00 5.66E+04 1.00 $f_{17}$ 30 1.90E+04 1.00 1.96E+04 1.00 1.91E+04 1.00 1.92E+04 1.00 1.98E+04 1.00 $f_{18}$ 30 2.32E+04 1.00 2.29E+04 1.00 2.32E+04 1.00 2.30E+04 1.00 2.29E+04 1.00 $f_{19}$ 30 1.72E+05 1.00 1.70E+05 1.00 1.67E+05 1.00 1.70E+05 1.00 1.68E+05 1.00 $f_{20}$ 30 3.62E+04 1.00 3.75E+04 1.00 3.13E+04 1.00 3.48E+04 1.00 3.47E+04 1.00 AVE 4.41E+04 1.000 4.42E+04 1.000 4.41E+04 1.000 4.40E+04 1.000 4.41E+04 1.000 表 3 函数评价次数和成功率对比数据

Table 3 Compared data on function evaluations and success rates

Fun $N$ DELU SHADE EPSDE CoDE SEFDE FEs SR FEs SR FEs SR FEs SR FEs SR $f_{1}$ 30 1.22E+04 1.00 2.35E+04 1.00 1.67E+04 1.00 4.02E+04 1.00 ${\bf1.21E+04}$ 1.00 $f_{2}$ 30 1.07E+04 1.00 2.16E+04 1.00 1.51E+04 1.00 3.63E+04 1.00 ${\bf1.06E+04}$ 1.00 $f_{3}$ 30 3.15E+04 1.00 3.42E+04 1.00 2.32E+04 1.00 5.64E+04 1.00 ${\bf1.75E+04}$ 1.00 $f_{4}$ 30 7.98E+03 1.00 1.67E+04 1.00 9.36E+03 1.00 2.24E+04 1.00 ${\bf7.83E+03}$ 1.00 $f_{5}$ 30 2.55E+04 1.00 2.67E+04 1.00 ${\bf1.83E+04}$ 1.00 4.13E+04 1.00 2.91E+04 1.00 $f_{6}$ 30 1.16E+04 1.00 1.19E+04 1.00 ${\bf8.33E+03}$ 1.00 2.01E+04 1.00 ${\bf8.28E+03}$ 1.00 $f_{7}$ 30 7.71E+04 1.00 ${\bf5.98E+04}$ 1.00 1.33E+05 1.00 7.80E+04 1.00 1.46E+05 1.00 $f_{8}$ 30 ${\bf7.09E+04}$ 1.00 1.09E+05 1.00 1.16E+05 0.87 2.37E+05 1.00 1.22E+05 1.00 $f_{9}$ 30 1.54E+04 1.00 2.56E+04 1.00 1.76E+04 0.83 4.39E+04 1.00 ${\bf1.27E+04}$ 1.00 $f_{10}$ 30 ${\bf9.78E+04}$ 1.00 1.08E+05 0.97 1.13E+05 1.00 1.73E+05 1.00 1.07E+05 1.00 $f_{11}$ 30 ${\bf1.34E+04}$ 1.00 9.67E+04 1.00 3.71E+04 1.00 6.00E+04 1.00 4.40E+04 1.00 $f_{12}$ 30 1.98E+04 1.00 3.35E+04 0.97 2.33E+04 1.00 3.56E+04 1.00 ${\bf1.64E+04}$ 1.00 $f_{13}$ 30 ${\bf1.05E+04}$ 1.00 1.67E+04 1.00 1.30E+04 1.00 2.63E+04 1.00 1.27E+04 1.00 $f_{14}$ 30 ${\bf8.71E+03}$ 1.00 1.71E+04 1.00 1.15E+04 1.00 2.70E+04 1.00 1.22E+04 1.00 $f_{15}$ 30 2.65E+04 1.00 3.21E+04 1.00 2.32E+04 1.00 5.68E+04 1.00 ${\bf2.02E+04}$ 1.00 $f_{16}$ 30 5.94E+04 1.00 1.24E+05 1.00 6.40E+04 1.00 1.30E+05 0.97 ${\bf5.34E+04}$ 1.00 $f_{17}$ 30 ${\bf9.17E+03}$ 1.00 1.92E+04 1.00 1.29E+04 1.00 3.03E+04 1.00 1.92E+04 1.00 $f_{18}$ 30 1.52E+04 1.00 ${\bf1.50E+04}$ 1.00 1.59E+04 0.97 3.54E+04 1.00 2.30E+04 1.00 $f_{19}$ 30 1.68E+05 0.97 ${\bf1.09E+05}$ 1.00 NA 0.00 2.69E+05 1.00 1.70E+05 1.00 $f_{20}$ 30 NA 0.00 NA 0.00 1.00E+05 1.00 NA 0.00 ${\bf3.48E+04}$ 1.00 AVE 4.96E+04 0.95 6.00E+04 0.947 5.36E+04 0.934 8.59E+04 0.949 $\textbf{4.40E+04}$ $\textbf{1.000}$ 表 4 DELU、SHADE、EPSDE、CoDE、SEFDE 对30维测试函数的优化结果, 平均值(标准差)

Table 4 Compared data of 30 D optimization results on DELU、SHADE、EPSDE、CoDE、SEFDE, Mean (Std)

Fun $N$ DELU SHADE EPSDE CoDE SEFDE Mean error (Std Dev) Mean error (Std Dev) Mean error (Std Dev) Mean error (Std Dev) Mean error (Std Dev) $f_{1}$ 30 9.25E-19(2.99E-36)$^+$ 2.87E-19(2.31E-19)$^+$ 3.87E-31(9.46E-31)$^+$ 2.16E-10(1.73E-10)$^+$ ${\bf4.01E-38}({\bf5.05E-38})$ $f_{2}$ 30 2.56E-32(4.00E-32)$^+$ 4.40E-20(3.25E-20)$^+$ 5.52E-31(1.94E-30)$^+$ 2.83E-11(2.61E-11)$^+$ ${\bf5.83E-42}({\bf9.48E-42})$ $f_{3}$ 30 1.46E-11(1.23E-11)$^+$ 4.98E-10(2.39E-10)$^+$ 1.29E-16(2.15E-16)$^+$ 3.86E-06(1.32E-06)$^+$ ${\bf2.03E-23}({\bf1.62E-23})$ $f_{4}$ 30 ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ 4.07E-17(5.44E-17)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ 1.30E-14(1.13E-14)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$ $f_{5}$ 30 1.65E-20(4.70E-20)$^-$ 1.97E-18(2.27E-18)$^-$ ${\bf8.85E-30}({\bf1.75E-29})$$^-$ 4.04E-10(3.04E-10)$^+$ 1.06E-15(3.87E-16) $f_{6}$ 30 ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$ $f_{7}$ 30 ${\bf1.82E-04}({\bf3.39E-04})$$^-$ 3.57E-04(1.00E-03)$^-$ 1.42E+01(2.25E+01)$^-$ 5.69E-04(7.53E-04)$^-$ 3.59E+01(1.12E+01) $f_{8}$ 30 ${\bf1.28E-04}({\bf1.36E-04})$$^-$ 1.81E+01(1.11E+00)$^-$ 8.61E+00(2.09E+00)$^-$ 1.97E+01(5.80E-01)$^-$ 2.54E+01(8.26E-01) $f_{9}$ 30 ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ 2.47E-04(1.35E-03)$^+$ 6.57E-04(2.50E-03)$^+$ 2.47E-07(7.34E-07)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$ $f_{10}$ 30 ${\bf2.03E-02}({\bf6.76E-03})$$^-$ 3.56E-01(5.96E-02)$^+$ 2.35E-01(1.31E-01)$^+$ 1.97E+00(4.24E-01)$^+$ 1.84E-01(7.45E-02) $f_{11}$ 30 ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ 1.75E+02(5.85E+01)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ 1.66E-02(3.13E-02)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$ $f_{12}$ 30 ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ 3.14E-05(1.02E-07)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$ $f_{13}$ 30 2.19E-30(2.11E-30)$^+$ 5.53E-21(5.00E-21)$^+$ 2.91E-29(1.14E-28)$^+$ 1.80E-13(3.36E-13)$^+$ ${\bf1.57E-32}({\bf0.00E+00})$ $f_{14}$ 30 1.36E-32(3.13E-34)$^+$ 4.07E-21(6.03E-21)$^+$ 1.75E-32(9.04E-33)$^+$ 1.31E-13(1.51E-13)$^+$ ${\bf1.35E-32}({\bf0.00E+00})$ $f_{15}$ 30 2.42E-10(1.35E-10)$^+$ 1.19E-10(6.88E-11)$^+$ 6.04E-15(1.66E-15)$^+$ 3.75E-06(1.88E-06)$^+$ ${\bf4.00E-15}({\bf1.02E-15})$ $f_{16}$ 30 1.99E-06(2.50E-06)$^+$ 2.30E+01(2.38E+00)$^+$ 5.48E-02(1.39E-01)$^+$ 3.30E+01(5.81E+00)$^+$ ${\bf5.18E-07}({\bf1.12E-06})$ $f_{17}$ 30 4.57E-26(7.30E-26)$^+$ 2.85E-20(4.26E-20)$^+$ ${\bf6.02E-32}({\bf1.48E-31})$$^-$ 1.44E-12(1.26E-12)$^+$ 2.09E-26(1.95E-26) $f_{18}$ 30 3.80E-21(4.03E-21)$^+$ 3.51E-19(3.01E-19)$^+$ 3.66E-04(2.01E-03)$^+$ 2.45E-11(2.36E-11)$^+$ ${\bf2.48E-21}({\bf4.41E-21})$ $f_{19}$ 30 ${\bf3.67E+02}({\bf4.24E+02})$$^-$ 6.53E+02(6.50E+02)$^+$ 9.64E+02(4.81E+02)$^+$ 6.92E+02(8.00E+02)$^+$ 6.23E+02(5.05E+02) $f_{20}$ 30 2.20E-01(1.67E-05)$^+$ 1.60E-02(1.92E-03)$^+$ 1.38E-03(1.06E-03)$^+$ 1.75E+00(1.47E+00)$^+$ ${\bf2.07E-13}({\bf2.86E-13})$ $+/\approx/-$ 10/5/3 16/1/3 12/4/4 16/2/2 -/-/- 表 5 DELU、SHADE、EPSDE、CoDE、SEFDE对50维测试函数的优化结果, 平均值(标准差)

Table 5 Compared data of 50 D optimization results on DELU、SHADE、EPSDE、CoDE、SEFDE, Mean (Std)

Fun $N$ DELU SHADE EPSDE CoDE SEFDE Mean error (Std Dev) Mean error (Std Dev) Mean error (Std Dev) Mean error (Std Dev) Mean error (Std Dev) $f_{1}$ 50 4.24E-42(4.13E-42)$^+$ 2.05E-53(3.34E-53)$^+$ 2.52E-50(7.95E-50)$^+$ 4.94E-21(5.74E-21)$^+$ ${\bf2.30E-57}({\bf2.91E-57})$ $f_{2}$ 50 1.92E-32(4.01E-32)$^+$ ${\bf1.35E-53}({\bf3.43E-53})$$^-$ 1.80E-51(3.75E-51)$^-$ 4.46E-22(6.24E-22)$^+$ ${\bf1.59E-42}({\bf2.13E-42})$ $f_{3}$ 50 7.87E-29(9.66E-29)$^+$ 2.22E-27(1.67E-27)$^+$ 5.63E-29(1.68E-28)$^+$ 6.05E-12(2.77E-12)$^+$ ${\bf5.52E-29}({\bf4.63E-29})$ $f_{4}$ 50 ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ 9.99E-17(3.51E-17)$^+$ 1.33E-16(4.68E-17)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$ $f_{5}$ 50 7.64E-21(8.52E-21)$^+$ ${\bf1.03E-52}({\bf1.07E-52})$$^-$ 3.04E-50(7.79E-50)$^-$ 1.01E-20(1.21E-20)$^+$ 1.50E-27(1.66E-27) $f_{6}$ 50 ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ 5.00E-01(7.07E-01)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$ $f_{7}$ 50 1.77E-04(9.11E-05)$^-$ ${\bf8.22E-07}({\bf1.80E-06})$$^-$ 2.22E+02(6.11E+01)$^+$ 2.80E-04(3.97E-04)$^-$ 9.43E+01(9.34E+00) $f_{8}$ 50 ${\bf2.59E-06}({\bf1.29E-06})$$^-$ 1.34E+01(1.83E+00)$^-$ 2.72E+01(1.81E+01)$^-$ 5.16E+01(2.64E+01)$^+$ 3.73E+01(3.74E+00) $f_{9}$ 50 ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ 2.46E-03(5.69E-03)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$ $f_{10}$ 50 2.28E-02(1.14E-02)$^-$ 5.45E-02(3.68E-02)$^-$ ${\bf3.12E-03}({\bf4.16E-03})$$^-$ 1.11E-01(7.80E-02)$^-$ 2.19E-01(2.67E-01) $f_{11}$ 50 ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ 1.19E+01(3.79E+01)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$ $f_{12}$ 50 ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ 3.39E-01(3.95E-01)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$ $f_{13}$ 50 9.42E-33(1.44E-48)$^+$ 9.42E-33(1.44E-48)$^+$ 9.46E-33(6.47E-35)$^+$ 4.76E-25(4.46E-25)$^+$ ${\bf1.44E-33}({\bf1.11E-33})$ $f_{14}$ 50 1.35E-32(2.88E-48)$^+$ 1.35E-32(2.88E-48)$^+$ 1.40E-32(8.62E-34)$^+$ 1.06E-24(8.10E-25)$^+$ ${\bf1.33E-32}({\bf0.00E+00})$ $f_{15}$ 50 6.13E-15(1.95E-15)$^+$ 7.11E-15(0.00E+00)$^+$ 1.14E-14(4.97E-15)$^+$ 8.59E-12(4.34E-12)$^+$ ${\bf1.04E-15}({\bf3.89E-15})$ $f_{16}$ 50 2.45E-07(1.58E-07)$^+$ 1.84E-01(5.31E-02)$^+$ 4.42E+00(1.09E+01)$^+$ 4.27E+01(7.39E+00)$^+$ ${\bf1.96E-07}({\bf1.10E-07})$ $f_{17}$ 50 3.25E-30(1.48E-30)$^-$ ${\bf9.42E-33}({\bf1.44E-48})$$^-$ 1.00E-32(1.96E-33)$^-$ 9.53E-24(4.52E-25)$^+$ 1.68E-26(3.74E-26) $f_{18}$ 50 3.08E-32(5.23E-33)$^-$ ${\bf1.36E-32}({\bf3.90E-34})$$^-$ 1.10E-03(3.47E-03)$^+$ 1.29E-22(1.22E-22)$^+$ 1.71E-24(3.73E-24) $f_{19}$ 50 8.90E+03(6.05E+03)$^-$ ${\bf1.04E+03}({\bf6.24E+02})$$^-$ 1.26E+04(1.65E+03)$^-$ 1.09E+04(1.44E+03)$^-$ 1.66E+04(2.24E+03) $f_{20}$ 50 2.70E-01(4.67E-02)$^+$ 2.60E-01(5.16E-02)$^+$ 2.80E-01(4.22E-02)$^+$ 3.20E-01(4.22E-02)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$ $+/\approx/-$ 9/5/6 10/2/7 12/2/6 12/5/3 -/-/- 表 6 CLPSO、CMA-ES、GL-25和SEFDE的优化结果性能对比数据, 平均值(标准差)

Table 6 Compared data of optimization results on CLPSO、CMA-ES、GL-25 and SEFDE, Mean (Std)

Fun $N$ CLPSO CMA-ES GL-25 SEFDE Mean error (Std Dev) Mean error (Std Dev) Mean error (Std Dev) Mean error (Std Dev) $f_{1}$ 30 9.13E-14(3.33E-14)$^+$ 1.97E-29(2.07E-30)$^+$ 4.78E-87(1.69E-86)$^+$ ${\bf1.26E-103}({\bf2.39E-103})$ $f_{2}$ 30 9.79E-15(5.44E-15)$^+$ 3.75E-28(4.61E-29)$^+$ 2.66E-78(1.25E-77)$^+$ ${\bf2.40E-112}({\bf3.36E-112})$ $f_{3}$ 30 4.48E-09(1.48E-09)$^+$ 2.03E-14(9.76E-16)$^+$ 2.98E-28(1.12E-27)$^+$ ${\bf3.68E-60}({\bf3.36E-112})$ $f_{4}$ 30 3.37E-16(7.98E-17)$^+$ 4.81E-17(5.60E-17)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$ $f_{5}$ 30 9.33E-14(6.40E-14)$^+$ 1.50E-24(2.15E-25)$^+$ ${\bf4.38E-85}({\bf2.40E-84})$$^-$ 2.42E-45(2.29E-45) $f_{6}$ 30 ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$ $f_{7}$ 30 4.73E+00(1.20E+00)$^+$ ${\bf2.95E-27}({\bf4.82E-28})$$^-$ 3.14E-02(8.77E-02)$^-$ 2.66E-01(2.28E-01) $f_{8}$ 30 1.95E+01(2.62E+00)$^-$ ${\bf2.66E-01}({\bf1.01E+00})$$^-$ 2.21E+01(6.19E-01)$^+$ 2.19E+01(5.02E-01) $f_{9}$ 30 2.40E-09(3.67E-09)$^+$ 1.40E-03(3.70E-03)$^+$ 1.61E-15(4.55E-15)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$ $f_{10}$ 30 1.54E-01(2.09E-02)$^-$ 2.50E+02(1.23E+01)$^+$ 2.95E+00(1.00E+00)$^+$ ${\bf1.30E-01}({\bf6.42E-02})$ $f_{11}$ 30 ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ 5.19E+03(6.07E+02)$^+$ 4.46E+03(1.36E+03)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$ $f_{12}$ 30 ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ 1.30E+01(2.50E+00)$^+$ 3.14E-05(3.97E-14)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$ $f_{13}$ 30 1.13E-17(6.31E-18)$^+$ 9.13E-01(1.06E+00)$^+$ 8.82E-31(4.10E-30)$^+$ ${\bf1.57E-32}({\bf0.00E+00})$ $f_{14}$ 30 5.94E-17(3.31E-17)$^+$ 1.10E-03(3.35E-03)$^+$ 1.28E-30(5.05E-30)$^+$ ${\bf1.35E-32}({\bf0.00E+00})$ $f_{15}$ 30 9.76E-08(2.38E-08)$^+$ 1.93E+01(1.97E-01)$^+$ 1.09E-13(1.91E-13)$^+$ ${\bf7.55E-15}({\bf0.00E+00})$ $f_{16}$ 30 9.41E-07(6.48E-07)$^+$ 2.20E+02(5.64E+01)$^+$ 3.07E+01(2.71E+01)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$ $f_{17}$ 30 3.49E-16(1.59E-16)$^+$ 1.73E-02(3.93E-02)$^+$ 1.26E+02(1.09E+01)$^+$ ${\bf1.57E-32}({\bf0.00E+00})$ $f_{18}$ 30 2.52E-14(1.22E-14)$^+$ 2.20E-03(4.47E-03)$^+$ 1.97E+03(1.93E+02)$^+$ ${\bf1.35E-32}({\bf0.00E+00})$ $f_{19}$ 30 6.26E+03(9.93E+02)$^+$ ${\bf5.59E-10}({\bf7.36E-11})$$^-$ 2.49E+03(4.07E+02)$^+$ 5.60E+02(1.36E+02) $f_{20}$ 30 2.33E-04(9.49E-05)$^+$ 8.96E-02(1.46E-01)$^+$ 3.55E-04(9.33E-04)$^+$ ${\bf1.23E-10}({\bf2.47E-10})$ $+/\approx/-$ 15/3/2 16/1/3 16/2/2 -/-/- 表 7 SHADE、IDE、ZPEDE、SinDE、SEFDE的优化结果性能对比数据, 平均值(标准差)

Table 7 Compared data of optimization results on SHADE、IDE、ZEPDE、SinDE、SEFDE, Mean (Std)

Fun N SHADE IDE ZEPDE SinDE SEFDE Mean error (Std Dev) Mean error (Std Dev) Mean error (Std Dev) Mean error (Std Dev) Mean error (Std Dev) $F_{1}$ 30 ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ 2.27E-13(1.53E-28)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$ $F_{2}$ 30 ${\bf2.66E+04}({\bf1.13E+04})$$^-$ 1.68E+06(4.23E+05)$^-$ 1.97E+05(7.53E+04)$^-$ 2.66E+06(8.33E+05)$^-$ 2.85E+07(4.18E+06) $F_{3}$ 30 8.80E+05(1.96E+06)$^+$ 1.38E+05(1.85E+05)$^+$ 1.50E+06(2.07E+06)$^+$ 1.01E+05(3.77E+05)$^+$ ${\bf5.80E+04}({\bf3.74E+04})$ $F_{4}$ 30 ${\bf1.61E-03}(1.41E-03)$$^-$ 6.85E+03(1.10E+03)$^+$ 7.66E-01(4.78E-01)$^-$ 8.28E+03(1.54E+03)$^+$ 3.13E+03(1.12E+03) $F_{5}$ 30 ${\bf0.00E+00}(0.00E+00)$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ 1.14E-13(7.65E-29)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$ $F_{6}$ 30 4.28E+01(5.52E+00)$^+$ 4.34E+01(2.62E-04)$^+$ 4.34E+01(3.18E-13)$^+$ 4.34E+01(1.44E-14)$^+$ ${\bf1.52E+01}({\bf1.95E-01})$ $F_{7}$ 30 2.33E+01(9.32E+00)$^-$ 3.18E+00(1.55E+00)$^-$ 1.37E+01(4.88E+00)$^-$ ${\bf6.10E-01}(5.97E-01)$$^-$ 2.80E+01(7.96E+00) $F_{8}$ 30 2.09E+01(1.68E-01)$^+$ 2.11E+01(2.44E-02)$^+$ 2.11E+01(1.17E-01)$^+$ 2.11E+01(3.59E-02)$^+$ ${\bf2.09E+01}({\bf2.78E-02})$ $F_{9}$ 30 5.54E+01(1.98E+00)$^+$ 3.56E+01(5.54E+00)$^+$ 3.74E+01(5.85E+00)$^+$ 3.48E+01(4.34E+00)$^+$ ${\bf3.04E+01}({\bf6.01E-01})$ $F_{10}$ 30 7.37E-02(3.67E-02)$^+$ 4.38E-02(2.17E-02)$^+$ 1.37E-01(6.96E-02)$^+$ 7.93E-02(3.57E-02)$^+$ ${\bf2.71E-02}({\bf1.69E-03})$ $F_{11}$ 30 ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ ${\bf0.00E+00}({\bf0.00E+00})$$^\approx$ 3.65E-01(6.12E-01)$^+$ 5.92E+00(2.86E+00)$^+$ ${\bf0.00E+00}({\bf0.00E+00})$ $F_{12}$ 30 5.86E+01(1.11E+01)$^-$ 6.89E+01(8.82E+00)$^-$ 6.04E+01(1.76E+01)$^-$ ${\bf5.61E+01}(1.41E+01)$$^-$ 1.21E+02(9.62E+00) $F_{13}$ 30 1.45E+02(1.95E+01)$^+$ 1.34E+02(2.28E+01)$^+$ 1.32E+02(3.62E+01)$^+$ 1.39E+02(3.41E+01)$^+$ ${\bf1.24E+02}({\bf1.29E+00})$ $F_{14}$ 30 ${\bf3.45E-02}({\bf1.93E-02})$$^-$ 1.17E+02(8.38E+01)$^+$ 4.83E+00(2.70E+00)$^-$ 2.34E+02(9.23E+01)$^-$ 5.85E+00(2.05E+00) $F_{15}$ 30 6.82E+03(4.41E+02)$^+$ 6.54E+03(5.91E+02)$^+$ 6.59E+03(9.36E+03)$^+$ 6.80E+03(1.00E+03)$^+$ ${\bf5.95E+03}({\bf2.37E+02})$ $F_{16}$ 30 1.28E+00(2.07E-01)$^-$ 1.59E+00(2.36E-01)$^-$ ${\bf7.82E-01}({\bf6.74E-01})$$^-$ 2.08E+00(3.66E-01)$^-$ 1.02E+02(1.66E-01) $F_{17}$ 30 5.08E+01(4.27E-14)$^+$ 5.92E+01(1.41E+00)$^+$ 5.11E+01(1.60E-01)$^+$ 6.52E+01(3.47E+00)$^+$ ${\bf4.21E+01}({\bf6.06E+01})$ $F_{18}$ 30 1.37E+02(1.29E+01)$^-$ 1.68E+02(1.27E+01)$^-$ ${\bf1.03E+02}({\bf1.19E+01})$$^-$ 1.41E+02(2.27E+01)$^-$ 3.01E+02(9.05E+00) $F_{19}$ 30 2.64E+00(2.83E-01)$^-$ ${\bf2.24E+00}({\bf3.66E-01})$$^-$ 3.71E+00(7.55E-01)$^-$ 4.85E+00(8.82E-01)$^-$ 1.03E+02(1.58E-01) $F_{20}$ 30 1.93E+01(7.70E-01)$^-$ 1.93E+01(4.47E-01)$^-$ 1.97E+01(7.88E-01)$^-$ ${\bf1.92E+01}(7.52E-01)$$^-$ 1.12E+02(9.46E-02) $F_{21}$ 30 8.45E+02(3.63E+02)$^+$ 7.32E+02(3.82E+02)$^+$ 6.33E+02(4.48E+02)$^+$ 5.84E+02(4.22E+02)$^+$ ${\bf5.03E+02}({\bf4.03E+01})$ $F_{22}$ 30 ${\bf1.33E+01}({\bf7.12E+00})$$^-$ 6.88E+01(2.03E+01)$^-$ 4.23E+02(5.75E+02)$^+$ 3.51E+02(2.72E+02)$^+$ 2.41E+02(1.24E+01) $F_{23}$ 30 7.63E+03(6.58E+02)$^+$ 7.32E+03(6.92E+02)$^+$ 7.02E+03(8.73E+02)$^+$ 6.59E+03(8.47E+02)$^+$ ${\bf6.38E+03}({\bf2.25E+02})$ $F_{24}$ 30 2.34E+02(1.01E+01)$^+$ 2.02E+02(1.14E+00)$^-$ 2.35E+02(1.09E+01)$^+$ ${\bf2.00E+02}(1.34E-01)$$^-$ 2.32E+02(1.18E+00) $F_{25}$ 30 3.40E+02(3.09E+01)$^+$ 3.03E+02(1.09E+01)$^+$ 3.23E+02(1.31E+01)$^+$ 2.97E+02(1.33E+01)$^+$ ${\bf2.58E+02}({\bf1.05E+01})$ $F_{26}$ 30 2.58E+02(8.08E+01)$^-$ ${\bf2.23E+02}({\bf4.46E+01})$$^-$ 2.27E+02(6.20E+01)$^-$ 2.76E+02(5.96E+01)$^-$ 3.02E+02(1.90E-01) $F_{27}$ 30 9.36E+02(3.07E+02)$^+$ ${\bf3.58E+02}({\bf3.30E+01})$$^-$ 9.38E+02(1.40E+02)$^+$ 4.75E+02(1.55E+02)$^-$ 6.11E+02(1.62E+02) $F_{28}$ 30 4.58E+02(4.13E+02)$^+$ ${\bf4.00E+02}({\bf0.00E+00})$$^\approx$ ${\bf4.00E+02}({\bf0.00E+00})$$^\approx$ ${\bf4.00E+02}(0.00E+00)$$^\approx$ ${\bf4.00E+02}({\bf0.00E+00})$ $+/\approx/-$ 14/3/11 13/4/11 15/3/10 16/1/11 -/-/- -

[1] Storn R, Price K. Differential evolution - a simple and efficient heuristic for global optimization over continuous spaces. Journal of Global Optimization, 1997, 11(4): 341-359 doi: 10.1023/A:1008202821328 [2] Das S, Suganthan P N. Differential evolution: a survey of the state-of-the-art. IEEE Transactions on Evolutionary Computation, 2011, 15(1): 4-31 doi: 10.1109/TEVC.2010.2059031 [3] Raghunathan T, Ghose D. Differential evolution based 3-D guidance law for a realistic interceptor model. Applied Soft Computing, 2014, 16: 20-33 doi: 10.1016/j.asoc.2013.11.017 [4] 胡蓉, 钱斌.一种求解随机有限缓冲区流水线调度的混合差分进化算法.自动化学报, 2009, 35(12): 1580-1586 doi: 10.3724/SP.J.1004.2009.01580Hu Rong, Qian Bin. A hybrid differential evolution algorithm for stochastic flow shop scheduling with limited buffers. Acta Automatica Sinica, 2009, 35(12): 1580-1586 doi: 10.3724/SP.J.1004.2009.01580 [5] Pandit M, Srivastava L, Sharma M. Environmental economic dispatch in multi-area power system employing improved differential evolution with fuzzy selection. Applied Soft Computing, 2015, 28: 498-510 doi: 10.1016/j.asoc.2014.12.027 [6] Zhang G J, Zhou X G, Yu X F, Hao X H, Yu L. Enhancing protein conformational space sampling using distance profile-guided differential evolution. IEEE/ACM Transactions on Computational Biology and Bioinformatics, 2017, 14(6): 1288-1301 doi: 10.1109/TCBB.2016.2566617 [7] 朱腾, 王京春, 熊智华.基于改进DE-NMPC的酸碱中和反应pH值控制.自动化学报, 2010, 36(1): 159-163 doi: 10.3724/SP.J.1004.2010.00159Zhu Teng, Wang Jing-Chun, Xiong Zhi-Hua. DE-based nonlinear model predictive control of a pH neutralization process. Acta Automatica Sinica, 2010, 36(1): 159-163 doi: 10.3724/SP.J.1004.2010.00159 [8] Qiao D P, Pang G K H. A modified differential evolution with heuristic algorithm for nonconvex optimization on sensor network localization. IEEE Transactions on Vehicular Technology, 2016, 65(3): 1676-1689 doi: 10.1109/TVT.2015.2409319 [9] Das S, Mullick S S, Suganthan P N. Recent advances in differential evolution - an updated survey. Swarm and Evolutionary Computation, 2016, 27: 1-30 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=abbffecca110c67e0656d3a7220658fc [10] Dragoi E N, Dafinescu V. Parameter control and hybridization techniques in differential evolution: a survey. Artificial Intelligence Review, 2016, 45(4): 447-470 doi: 10.1007/s10462-015-9452-8 [11] Cheng M Y, Tran D H. Two-phase differential evolution for the multiobjective optimization of time - cost tradeoffs in resource-constrained construction projects. IEEE Transactions on Engineering Management, 2014, 61(3): 450-461 doi: 10.1109/TEM.2014.2327512 [12] Liu Z Z, Wang Y, Yang S X, Cai Z X. Differential evolution with a two-stage optimization mechanism for numerical optimization. In: Proceedings of the 2016 IEEE Congress on Evolutionary Computation (CEC). Vancouver, BC, Canada: IEEE, 2016. 3170-3177 [13] Tang L X, Dong Y, Liu J Y. Differential evolution with an individual-dependent mechanism. IEEE Transactions on Evolutionary Computation, 2015, 19(4): 560-574 doi: 10.1109/TEVC.2014.2360890 [14] Yu W J, Shen M E, Chen W N, Zhan Z H, Gong Y J, Lin Y, Liu Q, Zhang J. Differential evolution with two-level parameter adaptation. IEEE Transactions on Cybernetics, 2014, 44(7): 1080-1099 doi: 10.1109/TCYB.2013.2279211 [15] 张贵军, 陈铭, 周晓根.动态小生境半径两阶段多模态差分进化算法.控制与决策, 2016, 31(7): 1185-1191 http://d.old.wanfangdata.com.cn/Periodical/kzyjc201607006Zhang Gui-Jun, Chen Ming, Zhou Xiao-Gen. Two-stage differential evolution algorithm using dynamic niche radius for multimodal optimization. Control and Decision, 2016, 31(7): 1185-1191 http://d.old.wanfangdata.com.cn/Periodical/kzyjc201607006 [16] Price K, Storn R M, Lampinen J A. Differential Evolution - A Practical Approach to Global Optimization. Berlin Heidelberg: Springer, 2005: 1-24 [17] 张贵军, 何洋军, 郭海锋, 冯远静, 徐建明.基于广义凸下界估计的多模态差分进化算法.软件学报, 2013, 24(6): 1177-1195 http://d.old.wanfangdata.com.cn/Periodical/rjxb201306002Zhang Gui-Jun, He Yang-Jun, Guo Hai-Feng, Feng Yuan-Jing, Xu Jian-Ming. Differential evolution algorithm for multimodal optimization based on abstract convex underestimation. Journal of Software, 2013, 24(6): 1177-1195 http://d.old.wanfangdata.com.cn/Periodical/rjxb201306002 [18] 周晓根, 张贵军, 郝小虎.局部抽象凸区域剖分差分进化算法.自动化学报, 2015, 41(7): 1315-1327 doi: 10.16383/j.aas.2015.c140680Zhou Xiao-Gen, Zhang Gui-Jun, Hao Xiao-Hu. Differential evolution algorithm with local abstract convex region partition. Acta Automatica Sinica, 2015, 41(7): 1315-1327 doi: 10.16383/j.aas.2015.c140680 [19] Beliakov G. Extended cutting angle method of global optimization. Pacific Journal of Optimization, 2008, 4(1): 153-176 [20] Beliakov G, Lim K F. Challenges of continuous global optimization in molecular structure prediction. European Journal of Operational Research, 2007, 181(3): 1198-1213 doi: 10.1016/j.ejor.2005.08.033 [21] 周晓根, 张贵军, 郝小虎, 俞立.一种基于局部Lipschitz下界估计支撑面的差分进化算法.计算机学报, 2016, 39(12): 2631-2651 doi: 10.11897/SP.J.1016.2016.02631Zhou Xiao-Gen, Zhang Gui-Jun, Hao Xiao-Hu, Yu Li. Differential evolution algorithm based on local lipschitz underestimate supporting hyperplanes. Chinese Journal of Computers, 2016, 39(12): 2631-2651 doi: 10.11897/SP.J.1016.2016.02631 [22] Ali M M, Khompatraporn C, Zabinsky Z B. A numerical evaluation of several stochastic algorithms on selected continuous global optimization test problems. Journal of Global Optimization, 2005, 31(4): 635-672 doi: 10.1007/s10898-004-9972-2 [23] Sarker R A, Elsayed S M, Ray T. Differential evolution with dynamic parameters selection for optimization problems. IEEE Transactions on Evolutionary Computation, 2014, 18(5): 689-707 [24] Dragoi E N, Dafinescu V. Parameter control and hybridization techniques in differential evolution: a survey. Artificial Intelligence Review, 2015, 45(4): 447-470 [25] Zhou X G, Zhang G J. Abstract convex underestimation assisted multistage differential evolution. IEEE Transactions on Cybernetics, 2017, 47(9): 2730-2741 doi: 10.1109/TCYB.2017.2710626 [26] Zhou X G, Zhang G J, Hao X H, Yu L. A novel differential evolution algorithm using local abstract convex underestimate strategy for global optimization. Computers & Operations Research, 2016, 75: 132-149 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=dd11fc41fe4a435f970157e38de1f775 [27] Tanabe R, Fukunaga A. Success-history based parameter adaptation for differential evolution. In: Proceedings of the 2013 IEEE Congress on Evolutionary Computation (CEC). Cancun, Mexico: IEEE, 2013. 71-78 [28] Mallipeddi R, Suganthan P N, Pan Q K, Tasgetiren M F. Differential evolution algorithm with ensemble of parameters and mutation strategies. Applied Soft Computing, 2011, 11(2): 1679-1696 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=cface92266298dbf8ec3818bbe607897 [29] Wang Y, Cai Z X, Zhang Q F. Differential evolution with composite trial vector generation strategies and control parameters. IEEE Transactions on Evolutionary Computation, 2011, 15(1): 55-66 doi: 10.1109/TEVC.2010.2087271 [30] Corder G W, Foreman D I. Nonparametric Statistics for Non-Statisticians: A Step-by-Step Approach. Hoboken, NJ: Wiley 2009. 38-55 [31] Shang Y W, Qiu Y H. A note on the extended Rosenbrock function. Evolutionary Computation, 2006, 14(1): 119-126 [32] Liang J J, Qin A K, Suganthan P N, Baskar S. Comprehensive learning particle swarm optimizer for global optimization of multimodal functions. IEEE Transactions on Evolutionary Computation, 2006, 10(3): 281-295 [33] Hansen N, Ostermeier A. Completely derandomized self-adaptation in evolution strategies. Evolutionary Computation, 2001, 9(2): 159-195 http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=58e04c72ec259f9411f7e06253975afb [34] García-Martínez C, Lozano M, Herrera F, Molina D, Sánchez A M. Global and local real-coded genetic algorithms based on parent-centric crossover operators. European Journal of Operational Research, 2008, 185(3): 1088-1113 doi: 10.1016/j.ejor.2006.06.043 [35] Fan Q Q, Yan X F. Self-adaptive differential evolution algorithm with zoning evolution of control parameters and adaptive mutation strategies. IEEE Transactions on Cybernetics, 2016, 46(1): 219-232 doi: 10.1109/TCYB.2015.2399478 [36] Draa A, Bouzoubia S, Boukhalfa I. A sinusoidal differential evolution algorithm for numerical optimisation. Applied Soft Computing, 2015, 27: 99-126 doi: 10.1016/j.asoc.2014.11.003 [37] Liang J J, Qu B Y, Suganthan P N, Hernández-Díaz A G. Problem definitions and evaluation criteria for the CEC 2013 special session on real-parameter optimization, Technical Report 201212, Computational Intelligence Laboratory, Zhengzhou University, Zhengzhou, China and Nanyang Technological University, Singapore, 2013. -

下载:

下载:

下载:

下载: