-

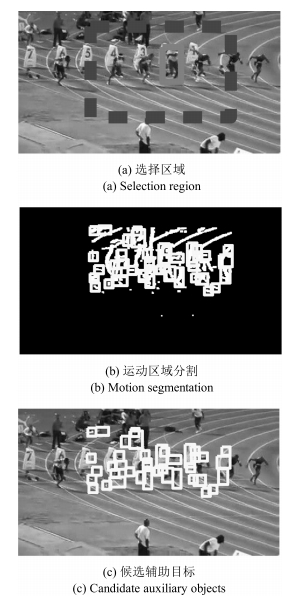

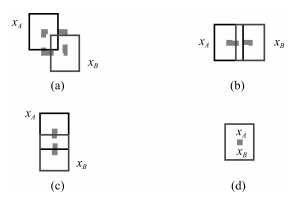

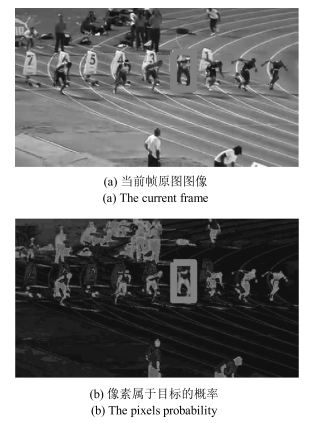

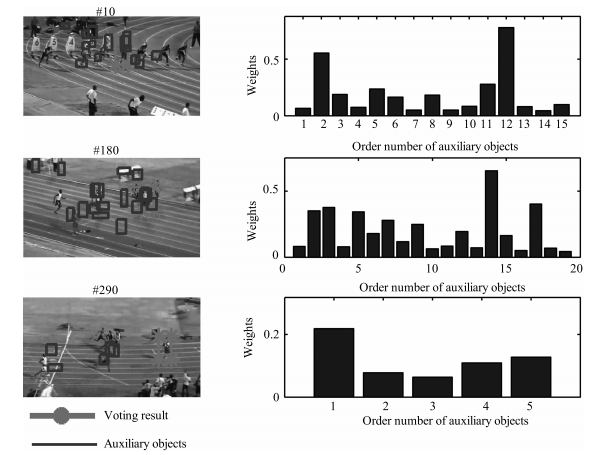

摘要: 在目标的动态背景中存在有利于目标跟踪的信息.使用辅助目标来描述目标的动态背景,在跟踪目标的同时建立辅助目标与目标之间的运动依赖关系.用多个辅助目标预测目标的位置,将辅助目标预测结果与目标跟踪器预测结果融合得到目标位置.方法包括,利用辅助目标与目标之间的运动依赖关系和辅助目标自身跟踪精度的辅助目标选择方法;使用多个低精度辅助目标跟踪器获得良好的目标预测结果的辅助目标跟踪和目标预测方法;以及根据目标跟踪结果更新辅助目标跟踪参数的方法.辅助目标具有多样性和独立性.基于辅助目标的目标跟踪方法可以与其他目标跟踪器结合,具有推广泛化能力.实验结果表明,辅助目标在目标跟踪中发挥重要作用,与其他目标跟踪方法对比结果表明,有更好的鲁棒性和目标跟踪精度.Abstract: The dynamic background of images contains effective information that is favorable for object tracking. This paper uses auxiliary objects describing the target background. Motion dependencies between auxiliary objects and target itself are established first. Then the tracking of auxiliary objects by trackers with relative lower precisions predicts the target position. The position results predicted by auxiliary objects and by the basic tracker are fused to get a better result. Meanwhile, parameters updating is done according to the tracking result. Extensive experimental results show that auxiliary objects are effective for tracking the target. Comparison with other trackers proves the method's better robustness and precision.

-

Key words:

- Object tracking /

- dynamic background /

- auxiliary objects /

- trackers fusion

1) 本文责任编委 赖剑煌 -

表 1 辅助目标对跟踪速度(帧/秒)和中心位置误差(像素)的影响

Table 1 The effect of auxiliary objects number on speed (FPS) and precision (CLE)

辅助目标数量 KCFAOT PFAOT FPS CLE FPS CLE 0 178.47 329.81 1.96 11.11 1 34.5 120.17 1.85 8.38 5 16.11 7.39 1.8 7.81 10 9.75 6.58 1.62 8.18 20 5.43 7.15 1.51 8.12 40 3.167 6.79 1.25 8.42 表 2 所提出方法与12种跟踪算法在50个视频下的中心位置误差阈值为20像素的平均成功率(%)和平均中心位置误差(像素)比较

Table 2 The performance of our method and 12 other trackers in 50 videos in terms of success rate (%) at 20 pixels threshold and mean center location error (pixels)

评价标准 KCFAOT KCF CT Frag DFT IVT CPF ASLA CXT KMS L1APG LOT TLD 平均成功率 76.29 68.67 35.16 38.53 34.69 48.89 53.52 61.06 56.68 42.16 51.65 44.12 53.97 平均位置误差 42.56 63.64 90.71 107.77 112.24 97.69 53.39 69.74 69.37 - 92.86 - - "-"表示有判断目标丢失 表 3 KCFAOT与12种跟踪方法的成功率(%)结果对比

Table 3 The overlap success rates (%) of KCFAOT and 12 other trackers

KCFAOT KCF CT Frag DFT IVT CPF ASLA CXT KMS L1APG LOT TLD Basketball 98 92 9 82 89 33 74 60 4 62 31 64 48 Biker 46 46 48 37 46 44 48 46 70 44 44 44 39 Bird1 35 7 29 7 28 3 39 22 6 31 4 21 0 BlurBody 72 58 2 27 12 2 14 1 46 38 87 10 1 BlurOwl 55 23 7 16 11 5 17 7 99 54 10 8 63 Bolt 100 99 1 14 4 2 96 2 3 34 2 90 1 Bolt2 94 2 100 45 2 3 89 2 5 61 2 59 1 BlurCar3 92 99 22 54 11 17 14 11 100 15 32 29 78 BlurCar4 91 99 3 47 43 3 12 30 100 54 99 13 11 Board 62 68 5 50 9 5 26 17 4 48 4 10 8 Boy 100 100 66 57 49 33 100 44 96 99 93 67 100 Car2 99 100 42 39 13 100 80 100 100 7 100 8 92 Car24 100 100 55 21 11 100 60 100 100 17 100 39 97 CarDark 100 100 2 55 54 71 23 100 70 63 100 63 65 CarScale 79 81 64 68 65 78 67 73 70 56 65 47 63 Couple 74 26 31 91 9 9 85 23 64 11 61 64 22 Coupon 100 100 17 21 100 100 21 100 100 37 15 28 15 Crossing 100 100 100 40 68 100 88 100 56 100 25 41 57 Crowds 100 100 1 3 100 12 3 100 100 2 100 2 59 Dancer2 96 100 93 84 100 100 77 100 100 67 100 61 100 David 100 100 82 10 31 100 23 100 100 49 81 37 66 David3 96 100 40 79 75 75 55 72 16 98 46 98 35 Deer 99 82 1 15 31 3 7 4 80 54 72 25 28 Diving 57 54 5 18 25 30 73 37 20 75 20 46 19 Dog 100 99 99 86 72 15 86 100 100 62 94 90 82 DragonBaby 53 34 22 48 12 33 49 29 72 49 22 70 18 FaceOcc1 75 78 9 98 62 65 31 53 42 54 65 26 17 Fish 91 100 87 56 86 100 12 100 100 31 5 21 40 Football 17 80 62 98 84 79 18 75 80 15 80 99 79 Freeman3 92 91 10 61 65 76 93 100 100 51 75 60 83 Girl 98 86 69 65 30 47 75 100 94 54 100 64 94 Girl2 84 7 7 16 7 8 97 38 11 80 7 79 25 Gym 84 79 27 94 23 61 95 78 63 97 2 96 85 Human3 3 1 2 2 1 1 2 1 1 2 1 2 1 Human4 52 53 20 8 20 19 30 20 11 22 19 25 15 Human5 45 27 24 4 9 28 12 100 38 24 96 61 99 Human6 34 29 26 33 28 38 47 52 21 26 43 37 48 Lemming 54 49 1 47 52 17 87 17 77 81 17 79 80 Matrix 33 17 14 7 6 2 18 18 12 24 12 1 1 MotorRolling 5 5 4 7 4 3 4 5 2 5 3 5 10 RedTeam 100 100 100 26 47 100 79 100 44 19 100 21 57 Skater 98 93 98 59 48 98 96 98 100 94 84 95 90 Skater2 91 69 1 57 6 7 50 25 17 52 6 74 32 Skating2 60 38 6 11 5 9 48 24 4 28 3 57 2 Skiing 64 7 11 4 7 11 6 14 9 11 9 2 6 Sylvester 81 84 48 74 44 68 83 80 100 66 52 82 91 Trellis 97 100 37 37 51 35 23 91 86 35 18 31 43 Twinnings 99 90 99 64 83 58 59 73 62 69 93 68 80 Walking2 47 43 40 35 40 100 36 65 44 48 98 39 38 Woman 98 94 20 19 95 20 19 94 14 13 20 16 40 效果最好的用粗体标注 表 4 KCFAOT与12种跟踪方法的平均位置误差(像素)结果对比

Table 4 The CLE (pixels) of KCFAOT and 12 other trackers

KCFAOT KCF CT Frag DFT IVT CPF ASLA CXT KMS L1APG LOT TLD Basketball 7.1 8.07 100.58 11.52 18.03 88.21 55.34 102.48 171.16 76.11 137.81 69.23 - Biker 30.46 77.18 24.49 93.46 81.68 93.81 51.99 85.57 14.25 103.96 80.72 74.58 - Bird1 118.05 151.82 123.15 325.31 131.37 175.61 122.24 124.07 212.19 - 334.25 170.4 - BlurBody 16.03 64.03 87.12 37.79 259.16 167.37 45.91 145.89 22.74 27.33 12.05 94.57 - BlurOwl 65.83 183.43 109.42 223.42 111.12 166.78 62.16 108.41 6.63 24.91 176.33 83.44 - Bolt 7.63 6.74 379.41 258.83 367.28 377.62 12.43 390.85 376.59 109.46 408.53 13.68 - Bolt2 7.15 329.81 9.68 43.21 276.7 82.69 10.8 284.67 237.22 39.93 304.19 78.84 - BlurCar3 12.6 4.14 66.11 58.22 154.69 142.55 57.25 101.79 3.99 97.1 112.88 113.92 - BlurCar4 12.16 10.72 158.49 56.8 18.53 131.6 45.31 48.79 10.12 21.88 7.04 183.2 - Board 19.56 35.74 79.02 92.26 100.16 148.77 55.1 90.13 152.34 25.39 173.97 186.21 148.56 Boy 4.48 2.67 37.77 33.9 106.31 91.82 4.83 73.66 4.03 5.37 7.17 64.33 4.09 Car2 3.38 3.97 47.09 89.4 87.69 1.66 12.11 1.42 1.57 120.63 1.32 106.05 - Car24 5.83 4.41 77.14 127.07 165.62 1.36 26.01 2.53 2.29 - 2.24 87.82 - CarDark 5.86 5.76 121.4 37.72 58.85 19.29 42.13 0.98 21.63 28.78 1.16 28.49 - CarScale 12.88 16.14 77.39 15.03 75.75 11.4 30.41 15.31 25.01 39.81 79.95 99.69 - Couple 16.75 47.17 76.43 9.79 108.6 134.64 13.29 87.82 40.74 108.78 28.72 36.96 - Coupon 1.44 1.34 20.66 71.57 2.52 11.8 72.06 1.88 4.69 24.11 33.53 26.15 - Crossing 2.94 2.42 4.64 57.67 22.28 2.97 10.18 1.37 30.73 9.18 63.29 53.22 27.04 Crowds 4.91 3 413.86 371.33 3.33 236.36 369.35 4.26 4.44 364.21 4.61 394.52 - Dancer2 7.61 6.41 8.33 11.24 5.51 8.38 13.22 6.31 7.64 17.35 8.02 15.76 6.89 David 4.52 8.06 15.1 93.02 42.88 4.78 26.05 5.33 7.96 19.44 13.98 23.99 - David3 6.71 4.06 78.91 12.86 50.93 51.76 18.49 54.35 221.97 9.57 90.03 9.5 135.75 Deer 5.64 21.27 240.97 111.85 98.75 194.3 93.9 152.9 13.32 44.78 24.07 64.54 - Diving 27.96 42.22 98.97 84.74 50.57 74.89 17.73 80.79 66.14 15.7 95.76 36.99 - Dog 7.38 5.22 10.08 12.18 15.81 99.03 10.3 6.32 7.45 24.07 9.01 10.19 - DragonBaby 74.78 50.52 53.69 46.39 75.58 92.86 35.56 49.88 20.31 - 101.62 27.88 - FaceOcc1 15.82 14.83 36.1 11.17 23.59 18.74 27.8 37.74 22.62 18.97 17.82 34.5 33.48 Fish 9.41 4.08 9.39 22.73 8.84 5.09 39.16 3.81 5.93 29.3 29.64 34.16 - Football 230.41 14.8 22.17 5.51 9.29 14.56 181.72 15.26 13.38 105.89 15.19 6.81 14.29 Freeman3 9.34 19.57 38.31 58.3 32.6 36.07 6.3 3.58 3.42 83.81 33.31 40.22 - Girl 8.27 11.92 19.77 20.12 23.98 26.38 18.39 6.72 5.74 30.63 2.75 22.94 8.32 Girl2 35.29 264.55 103.47 257.63 236.34 209.21 8.31 86.98 135.45 14.68 220.53 34.13 - Gym 15.16 16.45 25.65 10.04 104.47 27.52 10.52 14.83 19.18 9.56 79.91 9.69 14.23 Human3 241.45 260.8 212.6 224.23 227.09 262.45 157.83 252.25 173.66 254.84 284.02 207.78 - Human4 130.56 131.46 295.71 310.21 245.91 295.95 202.23 308.54 327.55 - 319.63 212.91 - Human5 112.98 175.52 238.86 286.2 259.06 180.92 218.33 6.8 188.88 - 7.47 89.44 - Human6 83.42 107.67 53.24 84.19 131.11 115.03 23.11 79.22 87.48 205.11 63.6 43.05 - Lemming 81.61 77.97 141.85 98.84 77.75 184 11.48 185.26 27.71 14 177.44 20.41 - Matrix 144.89 76.42 98.9 163.58 105.78 97.26 136.88 55.14 162.7 50.51 62.01 - - MotorRolling 167.49 228.06 167.86 142.22 174.17 169.64 155.46 190.88 142.5 147.97 207.11 133.19 - RedTeam 4.32 3.81 5.17 54.9 50.26 2.83 13.88 3.02 29.85 122.59 4.26 69.74 - Skater 10.18 10.94 8.27 24.25 46.03 9.14 8.8 7.84 6.86 11.33 14.21 9.23 11.27 Skater2 10.48 18.07 63.11 20.02 125.04 63.86 23.09 37.08 56.95 24.57 110.4 15.71 - Skating2 20.48 30.76 64.53 126.57 259.39 157.18 24.85 45.32 203.63 31.19 189.21 22.71 - Skiing 31.22 260.45 265.01 271.52 276.2 276.76 256.2 252.66 145.09 265.3 265.73 248.51 - Sylvester 13.65 13.3 37.08 14.4 44.88 36.75 14.16 19.71 5.79 18.24 25.97 11.68 9.88 Trellis 12.99 8.21 34.92 63.65 44.87 108.55 43.9 5.46 10.44 46.52 61.96 51.09 - Twinnings 4.94 6.67 10.35 16.03 12.6 16.73 21.09 12.43 18.09 19.44 10.79 28.74 - Walking2 26.27 29.57 62.06 57.31 29.09 4.19 55.02 29.91 34 44.98 4.7 64.56 - Woman 6.22 10.09 120.16 106.69 8.5 188.89 120.59 10.22 120.05 130.24 128.51 130.56 - 效果最好的用粗体标注 表 5 测试视频属性统计

Table 5 The counts for the attitudes of test videos

视频属性 IV SV OCC DEF MB FM IPR OPR OV BC LR 视频数量 15 34 22 24 14 21 21 29 6 17 5 表 6 不同方法不同视频属性下的平均成功率(%)

Table 6 The average success rates (%) of different trackers in different videos

平均成功率 KCFAOT KCF CT Frag DFT IVT CPF ASLA CXT KMS L1APG LOT TLD 总计 76.29 68.67 35.16 38.53 34.69 48.89 53.52 61.06 56.68 42.16 51.65 44.12 53.97 IV 86.27 85.64 36.43 36.98 40.23 62.92 54.5 76.9 76.59 36.54 59.11 43.13 71.28 SV 73.94 64.03 36.38 31.38 27.18 48.47 55.68 60.9 54.58 40.05 52.75 41.64 56.48 OCC 65.84 56.02 30.46 33.22 37.51 42.21 51.68 54.18 35.99 40.28 44 44.97 41.74 DEF 65.83 46.98 22.04 29.19 28.03 24.8 49.21 46.09 26.11 42.76 28.87 47.63 34.96 MB 82.02 62.57 24.14 30.78 24.65 29.73 51.21 45.96 57.26 48.69 44.39 34.39 46.75 FM 69.1 61.26 20.95 37.89 30.96 26.79 50.49 38.34 55.32 44.66 38.94 36.61 49 IPR 83.75 80.97 48.82 46.96 36.87 56.44 64.21 68.05 68.99 50.34 56.92 51.96 62.85 OPR 73.19 64.25 36.65 43.41 38.45 42.12 61.68 57.6 47.64 49.64 41.33 52.14 52.08 OV 48.38 42.53 13.61 39.5 33.48 19.29 57.5 27.06 41.02 53.6 20.09 47.09 45.4 BC 75.23 73.75 32.04 32.97 29.24 56.03 42.38 66.21 59.2 26.01 55.89 32.2 53.7 LR 82.18 81.07 78.5 26.51 42.76 89.02 63.69 82.97 44.08 25.73 90.34 24.76 49.27 表 7 不同方法不同视频属性下的均位置误差(像素)

Table 7 The CLE (pixels) of different trackers in different videos

平均位置误差 KCFAOT KCF CT Frag DFT IVT CPF ASLA CXT KMS L1APG LOT TLD 总计 42.56 63.64 90.71 107.77 112.24 97.69 53.39 69.74 69.37 - 92.86 - - IV 27.28 28.34 101.56 106.46 95.07 79.25 56.26 56.55 48.16 - 70.23 - - SV 47.56 74.49 89.47 119.71 127.29 102.67 50.42 69.81 68.08 - 94.76 - - OCC 67.08 92.03 108.12 127.01 122.41 129.72 65.4 97.11 107.06 - 126.09 - - DEF 68.53 119.62 134.71 158.55 161.94 163.45 83.07 114.44 139.42 - 162.43 94.91 - MB 25.08 91.08 84.77 129.95 124.54 131.5 40.86 68.78 62.31 - 108.69 91.88 - FM 41.7 58.17 89.35 99.84 108.15 126.23 43.05 84.66 63.31 - 112.59 - - IPR 26.33 30.69 55.28 63.16 83.94 66.27 32.75 47.52 34.93 - 60.3 - - OPR 49.95 70.87 73.77 88.79 99.27 105.91 42.55 71.82 72.25 - 105.91 - - OV 71.56 83.98 99.35 118.76 100.71 153.69 38.23 126.56 87 - 162.85 78.7 - BC 58 64.08 105.81 117.38 123.86 86.74 73.6 72.61 71.5 - 90.97 - - LR 19.19 25.75 31.87 63.86 56.57 22.35 33.52 26.85 35.99 107.27 20.63 72.65 - -

[1] Yilmaz A, Javed O, Shah M. Object tracking:a survey. ACM Computing Surveys, 2006, 38(4):Article No.13 doi: 10.1145/1177352 [2] Li X, Hu W M, Shen C H, Zhang Z F, Dick A, van den Hengel A. A survey of appearance models in visual object tracking. ACM Transactions on Intelligent Systems and Technology, 2013, 4(4):Article No.58 [3] Liu Q, Zhao X G, Hou Z G. Survey of single-target visual tracking methods based on online learning. Computer Vision, 2014, 8(5):419-428 doi: 10.1049/iet-cvi.2013.0134 [4] Smeulders A, Chu D M, Cucchiara R. Visual tracking:an experimental survey. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 36(7):1442-1468 doi: 10.1109/TPAMI.2013.230 [5] 尹宏鹏, 陈波, 柴毅, 刘兆栋.基于视觉的目标检测与跟踪综述.自动化学报, 2016, 42(10):1466-1489 http://www.aas.net.cn/CN/abstract/abstract18935.shtmlYin Hong-Peng, Chen Bo, Chai Yi, Liu Zhao-Dong. Vision-based object detection and tracking:a review. Acta Electronica Sinica, 2016, 42(10):1466-1489 http://www.aas.net.cn/CN/abstract/abstract18935.shtml [6] Comaniciu D, Ramesh V, Meer P. Real-time tracking of non-rigid objects using mean shift. In:Proceedings of the 2000 IEEE Conference on Computer Vision and Pattern Recognition. Hilton Head, SC, USA:IEEE, 2000. 2142-2151 [7] Vojir T, Noskova J, Matas J. Robust scale-adaptive mean-shift for tracking. In:Proceedings of the 2013 Scandinavian Conference on Image Analysis. Berlin, Germany:Heidelberg Springer, 2013. 652-663 [8] Zhou S K, Chellappa R, Moghaddam B. Visual tracking and recognition using appearance-adaptive models in particle filters. IEEE Transactions on Image Processing, 2004, 13(11):1491-1506 doi: 10.1109/TIP.2004.836152 [9] Oron S, Bar-Hillel A, Levi D, Avidan S. Locally orderless tracking. International Journal of Computer Vision, 2015, 111(2):213-228 doi: 10.1007/s11263-014-0740-6 [10] Delabarre B, Marchand E. Dense non-rigid visual tracking with a robust similarity function. In:Proceedings of the 2014 IEEE International Conference on Image Processing (ICIP). Paris, France:IEEE, 2014. 2-7 [11] Lin L, Lu Y Y, Li C L, Cheng H, Zuo W M. Detection-free multi-object tracking by reconfigurable inference with bundle representations. IEEE Transactions on Cybernetics, 2016, 46(11):2447-2458 doi: 10.1109/TCYB.2015.2478515 [12] Liu X B, Lin L, Yan S C, Jin H, Jiang W B. Adaptive object tracking by learning hybrid template online. IEEE Transactions on Circuits and Systems for Video Technology, 2011, 21(11):1588-1599 doi: 10.1109/TCSVT.2011.2129410 [13] Ross D A, Lim J, Lin R S, Yang M H. Incremental learning for robust visual tracking. International Journal of Computer Vision, 2008, 77(1-3):125-141 doi: 10.1007/s11263-007-0075-7 [14] Lu D, Li L S, Yan Q S. A survey:target tracking algorithm based on sparse representation. In:Proceedings of the 7th International Symposium on Computational Intelligence and Design. Hangzhou, China:IEEE, 2015. 195-199 [15] Mei X, Ling H B. Robust visual tracking using ι minimization. In:Proceedings of the 12th IEEE International Conference on Computer Vision. Kyoto, Japan:IEEE, 2009. 1436-1443 [16] Mei X, Ling H B, Wu Y, Blasch E, Bai L. Minimum error bounded efficient ι tracker with occlusion detection. In:Proceedings of the 2011 IEEE Conference on Computer Vision and Pattern Recognition. Colorado Springs, CO, USA:IEEE, 2011. 1257-1264 [17] Wang J Y, Chen X L, Gao W. Online selecting discriminative tracking features using particle filter. In:Proceedings of the 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Diego, CA, USA:IEEE, 2005. 1037-1042 [18] Babenko B, Yang M H, Belongie S. Visual tracking with online multiple instance learning. In:Proceedings of the 2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami, FL, USA:IEEE, 2009. 983-990 [19] Kalal Z, Mikolajczyk K, Matas J. Tracking-learning-detection. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(7):1409-1422 doi: 10.1109/TPAMI.2011.239 [20] 王丽佳, 贾松敏, 李秀智, 王爽.基于改进在线多示例学习算法的机器人目标跟踪.自动化学报, 2014, 40(12):2916-2925 http://www.aas.net.cn/CN/abstract/abstract18569.shtmlWang Li-Jia, Jia Song-Min, Li Xiu-Zhi, Wang Shuang. Person following for mobile robot using improved multiple instance learning. Acta Automatica Sinica, 2014, 40(12):2916-2925 http://www.aas.net.cn/CN/abstract/abstract18569.shtml [21] Grabner H, Bischof H. On-line boosting and vision. In:Proceedings of the 2006 IEEE Conference on Computer Vision and Pattern Recognition. New York, NY, USA:IEEE, 2006. 260-267 [22] Hare S, Golodetz S, Saffari A, Vineet V, Cheng M M, Hicks S L, Torr P H. Struck:structured output tracking with kernels. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(10):2096-2109 doi: 10.1109/TPAMI.2015.2509974 [23] Matas J, Mikolajczyk K, Kalal Z. P-N learning:bootstrapping binary classifiers by structural constraints. In:Proceedings of the 2010 IEEE Conference on Computer Vision and Pattern Recognition. San Francisco, CA, USA:IEEE, 2010. 49-56 [24] Wang X Y, Hua G, Han T X. Discriminative tracking by metric learning. In:Proceedings of the 11th European Conference on Computer Vision. Heraklion, Crete, Greece:Springer, 2010. 200-214 [25] 李庆武, 朱国庆, 周妍, 霍冠英.基于特征在线选择的目标压缩跟踪算法.自动化学报, 2015, 41(11):1961-1970 http://www.aas.net.cn/CN/abstract/abstract18770.shtmlLi Qing-Wu, Zhu Guo-Qing, Zhou Yan, Huo Guan-Ying. Object compressive tracking via online feature selection. Acta Automatic Sinica, 2015, 41(11):1961-1970 http://www.aas.net.cn/CN/abstract/abstract18770.shtml [26] Wu Y, Lim J, Yang M H. Object tracking benchmark. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9):1834-1848 doi: 10.1109/TPAMI.2014.2388226 [27] Yang M, Wu Y, Hua G. Context-aware visual tracking. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2009, 31(7):1195-1209 doi: 10.1109/TPAMI.2008.146 [28] Dinh T B, Vo N, Medioni G. Context tracker:exploring supporters and distracters in unconstrained environments. In:Proceedings of the 2011 IEEE Conference on Computer Vision and Pattern Recognition. Colorado Springs, CO, USA:IEEE, 2011. 1177-1184 [29] Wen L Y, Cai Z W, Lei Z, Yi D, Li S Z. Online Spatio-temporal structural context learning for visual tracking. In:Proceedings of the 12th European Conference on Computer Vision. Florence, Italy:Springer, 2012. 716-729 [30] Zhu G B, Wang J Q, Zhao C Y, Lu H Q. Weighted part context learning for visual tracking. IEEE Transactions on Image Processing, 2015, 24(12):5140-5151 doi: 10.1109/TIP.2015.2479460 [31] Quan W, Jiang Y Q, Zhang J J, Chen J X. Robust object tracking with active context learning. The Visual Computer, 2015, 31(10):1307-1318 doi: 10.1007/s00371-014-1012-8 [32] Li Y, Zhu J K, Hoi S C H. Reliable patch trackers:robust visual tracking by exploiting reliable patches. In:Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA, USA:IEEE, 2015. 353-361 [33] Yuan X H, Kong L B, Feng D C, Wei Z C. Automatic feature point detection and tracking of human actions in time-of-flight videos. IEEE/CAA Journal of Automatica Sinica, 2017, 4(4):677-685 doi: 10.1109/JAS.2017.7510625 [34] Bolme D S, Beveridge J R, Draper B A, Lui Y M. Visual object tracking using adaptive correlation filters. In:Proceedings of the 2010 IEEE Conference on Computer Vision and Pattern Recognition. San Francisco, CA, USA:IEEE, 2010. 2544-2550 [35] Henriques J F, Caseiro R, Martins P, Batista J. Exploiting the circulant structure of tracking-by-detection with kernels. In:Proceedings of the 12th European Conference on Computer Vision. Florence, Italy:Springer, 2012. 702-715 [36] Henriques J F, Rui C, Martins P, Batista J. High-speed tracking with kernelized correlation filters. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 37(3):583-596 http://www.ncbi.nlm.nih.gov/pubmed/26353263 [37] Liu T, Wang G, Yang Q X. Real-time part-based visual tracking via adaptive correlation filters. In:Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA, USA:IEEE, 2015. 4902-4912 [38] Ma C, Yang X K, Zhang C Y, Yang M H. Long-term correlation tracking. In:Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA, USA:IEEE, 2015. 5388-5396 [39] Zhang K H, Zhang L, Liu Q S, Zhang D, Yang M H. Fast visual tracking via dense spatio-temporal context learning. In:Proceedings of the 13th European Conference on Computer Vision. Zurich, Switzerland:Springer, 2014. 127-141 [40] Stuart R, Peter N[著], 姜哲, 金奕江, 张敏[译]. 人工智能: 一种现代方法(第2版). 北京: 人民邮电出版社, 2010. 368-370Stuart R, Peter N[Author], Jiang Zhe, Jin Yi-Jiang, Zhang Min[Translator]. Artificial Intelligence:A Modern Approach (2nd Edition). Beijing:Posts and Telecommunications Press, 2010. 368-370 [41] Jiang H L, Li J H, Wang D, Lu H C. Multi-feature tracking via adaptive weights. Neurocomputing, 2016, 207:189-201 doi: 10.1016/j.neucom.2016.03.074 [42] Chen H K, Zhao X G, Tan M. Target salient confidence for visual tracking. In:Proceedings of the 7th International Congress on Image and Signal Processing. Dalian, China:IEEE, 2015. 436-441 [43] Possegger H, Mauthner T, Bischof H. In defense of color-based model-free tracking. In:Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA, USA:IEEE, 2015. 2113-2120 [44] Zhang K H, Zhang L, Yang M H. Real-time compressive tracking. In:Proceedings of the 12th European Conference on Computer Vision. Florence, Italy:Springer, 2012. 864-877 [45] Adam A, Rivlin E, Shimshoni I. Robust fragments-based tracking using the integral histogram. In:Proceedings of the 2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. New York, NY, USA:IEEE, 2006. 798-805 [46] Sevilla-Lara L, Learned-Miller E. Distribution fields for tracking. In:Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Providence, RI, USA:IEEE, 2012. 1910-1917 [47] Pérez P, Hue C, Vermaak J, Gangnet M. Color-based probabilistic tracking. In:Proceedings of the 7th European Conference on Computer Vision. Copenhagen, Denmark:Springer, 2002. 661-675 [48] Jia X, Lu H C, Yang M H. Visual tracking via adaptive structural local sparse appearance model. In:Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Providence, RI, USA:IEEE, 2012. 1822-1829 [49] Comaniciu D, Ramesh V, Meer P. Kernel-based object tracking. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2003, 25(5):564-575 doi: 10.1109/TPAMI.2003.1195991 [50] Bao C L, Wu Y, Ling H B, Ji H. Real time robust L1 tracker using accelerated proximal gradient approach. In:Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Providence, RI, USA:IEEE, 2012. 1830-1837 -

下载:

下载: