Road Structural Feature Based Monocular Visual Localization for Intelligent Vehicle

-

摘要: 高精度定位是实现自动驾驶的关键.在城市密集区域,全球定位系统(Global positioning system,GPS)等卫星定位系统受到遮挡、干扰、多路径反射等影响,无法保障自动驾驶所需的定位精度.视觉定位技术通过图像特征匹配进行位置估计,被广泛研究.然而传统基于特征点的方法容易受到移动目标的干扰,在高动态交通场景中的应用面临挑战.在结构化道路场景中,车道等线特征普遍存在,为人类驾驶员的视觉理解与决策提供重要线索.受该思路的启发,本文利用场景中的三垂线和点特征构建道路结构特征(Road structural feature,RSF),并在此基础上提出一个基于道路结构特征的单目视觉定位算法.本文利用在北京市区的典型路口、路段、街道等场所采集的车载视频数据进行实验验证,以同步采集的高精度GPS惯性导航组合定位系统数据为参照,与传统视觉定位算法进行比较.结果表明,本文算法在朝向估计上明显优于传统算法,对环境中的动态干扰有更高的鲁棒性.在卫星信号易受干扰的区域,可以有效地弥补GPS等定位系统的不足,为满足自动驾驶所需的车道级定位要求提供重要的技术手段.Abstract: Precise localization is an essential issue for autonomous driving applications, while global positioning system (GPS)-based systems are challenged to meet requirements such as lane-level accuracy, especially in crowded urban environment. This paper introduces a new visual-based localization approach in dynamic traffic environments, focusing on structured roads like straight roads or intersections. Such environments show several line segments on lane markings, curbs, poles, building edges, etc., which demonstrate the road's longitude, latitude and vertical directions. Based on this observation, we define a road structural feature (RSF) as sets of segments along three perpendicular axes together with feature points, and propose an RSF based monocular visual localization method. Extensive experiments are conducted on three typical scenarios, including highway, intersection and downtown streets. Results show better accuracy compared with a state-of-the-art visual localization method using feature points. We demonstrate that the proposed method can help improving localization accuracy in GPS restricted area, and discuss the remained challenges leading to future studies.

-

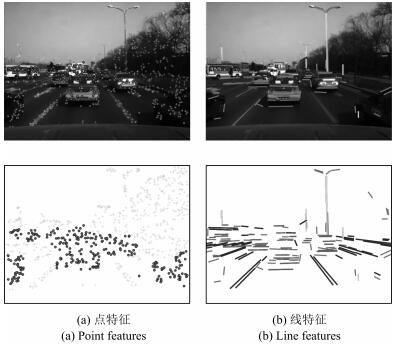

智能车或自动驾驶技术受到广泛的关注, 精确的定位技术是其重要环节.面向城市道路环境, 车道级定位是实现智能车轨迹规划或决策的关键.全球定位系统(Global positioning system, GPS)被广泛运用于汽车导航系统.单点GPS定位误差为数米, 且受到信号遮挡、干扰、多路径反射等影响, 在城市密集区域, 无法保障自动驾驶所需的定位精度.而以视觉里程计为代表, 通过环境数据匹配进行运动估计的视觉定位方法可以有效提高相对定位精度.但城市环境中来自车辆、行人等动态目标的干扰给传统视觉定位算法带来了巨大挑战.如图 1(a)所示, 在一帧图像中, 共检测了785个特征点, 其中有277个在周围车辆上.移动干扰特征点的比率已经超出了视觉定位算法中外点滤除的极限, 导致定位结果产生偏差.

在人类驾驶员视觉理解过程中, 相比于特征点, 车道等结构化道路信息起到更重要作用.以图 1(b)为例, 图像中包括沿道路方向、水平垂直道路方向和竖直方向的三种线特征, 这些信息为驾驶员有效定位自身车辆与道路的关系提供重要线索.受该思路启发, 本文提出一个基于道路结构特征(Road structural feature, RSF)的智能车单目视觉定位算法, 用于解决高动态结构化道路环境下的定位问题.本文结合场景中的三垂线和点特征, 定义道路结构特征, 并在此基础上建立定位算法, 包括道路结构预测、特征提取和车辆运动估计.本文利用安装在智能车平台上的摄像头在北京市区的路口、拥堵路段、密集街道等典型复杂场景进行数据采集, 对本文提出的算法进行实验分析, 以同步采集的高精度GPS惯性导航组合定位系统(GPS/惯导)数据为参照, 与传统视觉定位算法进行比较, 验证本文算法的有效性.

本文结构如下:第1节围绕近年来国内外视觉定位的前沿研究, 分析其在大范围高动态交通场景应用中所面临的关键难点; 第2节给出道路结构特征的定义, 并概述基于道路结构特征的定位算法; 第3节详细描述定位算法中的细节; 第4节给出实验结果, 并与高精度GPS/惯导和传统视觉定位方法作比较; 第5节总结本文算法并给出今后的研究展望.

1. 相关研究

基于视觉的定位算法被广泛用于智能车定位系统, 视觉里程计(Visual odometry)[1]是其中最重要的领域之一.视觉里程计利用单个或者多个相机的输入信息, 通过前后帧特征匹配, 估计本体的运动.有关视觉里程计的研究最早可以追溯到1980年.当时, Moravec等[2]利用一个可滑动相机获取视觉信息, 并以此作为输入, 完成了机器人的室内导航. 1987年, Matthies等[3]提出了利用视觉做定位的概念, 设计了包含特征提取、特征匹配与跟踪、运动估计的理论框架. 2004年, Nistér等[4]首次明确了视觉里程计这一概念, 并在2006年详细描述了视觉里程计系统[5].他们设计了一种实时的视觉里程计系统, 真正意义上实现了机器人室外运动导航, 同时提出了两类视觉里程计的实现途径和流程, 即单目视觉和立体视觉的方法, 之后的研究大多在此基础上进行改进.

通用的视觉里程计以特征点匹配为基础, 定位结果受到累计误差和移动物体干扰两方面因素的影响.针对累计误差, 光束平差法(Bundle adjustment)[6]是一个常用的处理方法, 通过最小化三维特征点在不同图像上的重投影误差, 同时优化三维特征点和相机位置, 提高了定位精度, 但计算代价较高.为降低时间复杂度, Mouragnon等[7]使用局部光束平差法, 在处理累计误差和计算代价上做了一个平衡.针对移动物体的干扰, 传统的方法将移动物体上的特征点当作噪声, 利用随机采样一致性方法(Random sample consensus, RANSAC)[8]来滤除噪声, 但这只能处理少量干扰问题. Ozden等[9]建立了一个多模型的定位与场景重建方法, 将视频中的特征点进行聚类, 提取移动物体, 去除干扰. Kundu等[10]将光束平差法与多模型方法结合, 有效提高了定位精度, 但在移动物体较多的环境下, 有效性受到制约.近几年的视觉里程计的研究将定位和建图结合起来, 建立视觉SLAM方法, 例如lsd-SLAM[11]、Orb-SLAM[12]等.此类方法有效减少了累计误差, 但由于需要在定位的同时重建三维场景, 导致高动态环境下移动物体的干扰增加.

另一类视觉定位算法则采用与地图匹配的方式进行定位. Geiger等[13]利用视觉里程计生成的轨迹和二维地图上的道路进行形状比对, 确定车辆实际位置.算法可定位到所处道路, 但无法到达车道级精度. Ramalingam等[14-15]直接利用城市的三维模型, 将图像中的特征点和线投影到三维模型中, 直接获取对应的三维位置, 避免了三维重建过程中的误差.算法提高了定位精度, 但目前三维模型的可获取性不够广泛, 算法的局限性高.另一些研究者则采用智能车预先建立地图进行定位. Achar等[16]利用词袋(Bag-of-words)的方法, 在需要定位的街道上预先行驶若干圈采集数据, 生成特征地图, 在线定位时, 将图像特征点和数据库中特征点进行匹配并定位. Ziegler等[17]同时建立了道路的几何地图与特征点云地图, 提高了在线匹配的精度.该智能车完成了103千米的自动驾驶, 但地图建立存在大量手工操作, 人力和时间成本高.

传统的视觉定位算法使用特征点进行定位, 在高动态交通场景中, 特征点易受移动车辆的干扰, 导致定位结果出现偏差. Geiger等[18]将图像特征投影到路面上, 利用标志线的角点对定位进行优化, 适用于低动态场景, 但无法处理拥堵环境.考虑到道路场景中线特征的朝向特殊性, Zhang等[19]利用室外的垂直线特征进行定位, 将原三维定位问题转换为二维定位问题, 降低了复杂度, 但垂直线特征不通用, 局限性大. Barinova等[20-21]则将线段进行聚类, 并检测消失点, 利用消失点之间的几何约束确定三垂线.该算法只在部分图片中进行测试, 缺乏有效性验证, 且计算代价高.本文对三垂线的检测进行优化, 并将其用于结构化道路场景定位算法, 极大地提高了定位估计的朝向稳定性.

2. 系统概述

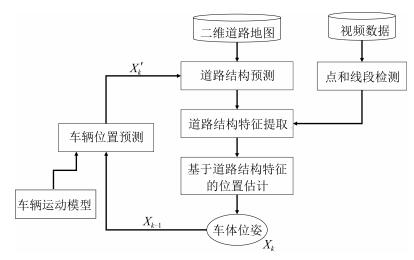

本文提出的定位算法框架如图 2所示.以下首先给出道路结构特征的定义, 在此基础上简述算法的主要步骤, 包含道路结构的预测、道路结构特征提取和基于道路结构特征的位置估计.

2.1 道路结构特征定义

道路结构特征是一组带有语意信息, 描述典型结构化道路场景特征的基本元素集合.在本研究中, 道路结构特征由图像中对应于道路行进方向、水平垂直道路方向和竖直方向的三组线特征${L}_1, {L}_2, {L}_3$, 以及点特征${P}$构成, 即.其中线特征${L}_1, {L}_2$, ${L}_3$在道路坐标系下相互垂直, 在本文中简称三垂线.

2.2 道路结构预测

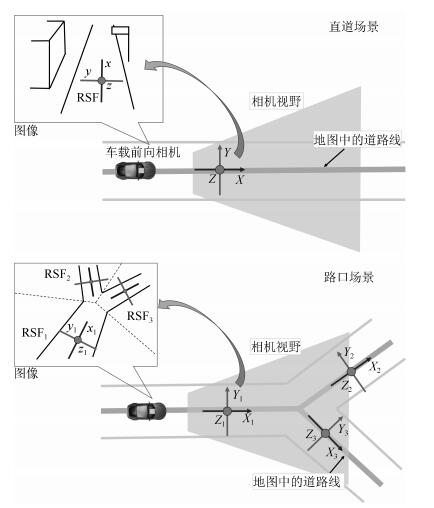

随着定位服务(Location based services, LBS)技术的发展, 地图作为数据基础被广泛建立, 部分已开放使用(例如OpenStreetMap).这些地图中包含道路中心线、路口节点等信息, 为预测局部道路结构提供依据.如图 3所示, 对于直道场景, 根据智能车当前的定位信息和相机标定参数, 可在地图中确定相机的可视区域, 结合地图中道路中心线信息, 建立局部道路坐标系.利用车辆位置以及相机参数等信息, 将局部道路坐标系映射到图像中, 预测对应于道路行进方向、水平垂直道路方向和竖直方向的三组线特征${L}_1$, ${L}_2, {L}_3$的方向.对于路口场景, 根据地图中道路中心线, 将相机可视区域分割为一系列小区域, 每个小区域都根据道路中心线定义自身的道路局部坐标系, 再映射到图像中, 将图像分为相应的区域, 并在每个区域中预测对应的三组线特征方向.

2.3 道路结构特征提取

道路结构特征的提取以线段检测算法和特征点检测算法为基础, 实时检测图像中的线段和特征点, 构建道路结构特征.对于线特征, 定义线和道路坐标系三方向的距离函数, 以此将图像中的线段进行分类.通常情况下, 路面上的车道线、道路边界、车辆侧面的线段等会被分成第一类${L}_1$; 路面上的停止线、车辆后侧的横向线段、路牌上的横向线段会被分成第二类${L}_2$; 路灯、路边建筑物、大型车辆等的竖直方向线段会被分为第三类${L}_3$.对于点特征, 直接根据通用特征点检测结果, 生成特征点集合${P}$.

2.4 基于道路结构特征的位置估计

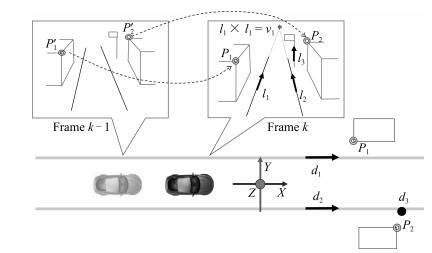

车辆的位置估计采用随机采样一致性方法(RANSAC).在检测到所有道路结构特征后, 基于随机采样构建样本集合$\{{C}_{\rm RSF}^i\}$.一个有效的采样${C}_{\rm RSF}$包含三条线段和两个点.其中三条线段中两条相互平行, 并且垂直于第三条.

$ {C_{{\rm{RSF}}}} = \{ {l_1}, {l_2} \in {L_u}, {l_3} \in {L_v}, u \ne v, {p_1}, {p_2} \in P\} $

(1) 图 4所示为当$u=1, v=3$的一个样例. ${l}_1$和${l}_2$为沿道路方向上的线段, ${l}_3$为竖直方向上的线段, ${p}_1$和${p}_2$为图像中任意两个特征点.在利用采样进行位置姿态${x}$求解的过程中, 使用其中的线特征求解旋转, 再使用点特征估计平移, 平移尺度的估计则使用车速信息累计求解.位置姿态求解结果使用后验概率进行评价.其中为观测模型, $p(x_k^i|x_{k-1})$为车辆运动模型.通过一定次数的随机采样${C}_{\rm RSF}$ (本文实验中采样次数为200), 最优位置估计结果$\hat{{x}}_k$通过最大化后验概率求得.

$ \begin{align} \hat{{x}}_k = \displaystyle \arg\max _{{x}_k^i \sim {C}_{\rm RSF}^i} \{ p({Z}_{\rm RSF} | {x}_k^i) p({x}_k^i|{x}_{k-1}) \} \end{align} $

(2) 3. 算法细节

3.1 坐标系定义

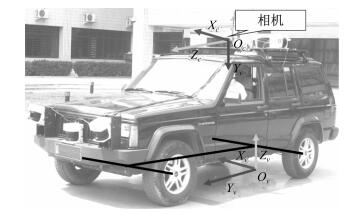

车体与相机的坐标系定义如图 5所示.定义为车体在世界坐标系下的位置姿态.其中, ${R}_{v}$为旋转矩阵, ${s}_{v}$为平移向量.车体坐标系定义为右手系准则, 其中原点位于车辆后轴中心, $x, y$, $z$的方向分别为车辆右侧, 前方和上方.相机固定在车顶前侧上方, 定义为相机的在世界坐标系下的位置姿态.相机坐标系定义为右手系准侧, 其中原点为相机中心, $x, y, z$的方向分别为相机右侧、下方和前方.相机和车体的刚性固定, 车体坐标系到图像映射可通过标定得到.其中${K}$为相机内参数, ${R}_{vc}$和${s}_{vc}$分别为外参数中的旋转矩阵和平移向量, 即车体在相机坐标系下的旋转矩阵和平移向量.

3.2 道路结构预测

定义${e}_1=(1, 0, 0)^{\rm T}, {e}_2=(0, 1, 0)^{\rm T}, {e}_3=(0, 0, 1)^{\rm T}$为$x, y$, $z$方向的单位向量, 车体在世界坐标系下的三个方向可表示为

$ \left[{\begin{array}{*{20}{c}} {{d_x}}&{{d_y}}&{{d_z}} \end{array}} \right] = {R_v}\left[{\begin{array}{*{20}{c}} {{e_1}}&{{e_2}}&{{e_3}} \end{array}} \right] $

(3) 其中, ${d}_y={R}_{v}{e}_2$为车体朝向.定义$\{{R}_{v, k}, {s}_{v, k}\}$为车体在$k$时刻的位置姿态, $\{\hat{{R}}_{v, k}, \hat{{s}}_{v, k}\}$为对应时刻的预测结果.假设车体的运动在朝向上变化均匀, 则车辆在$k$时刻的旋转矩阵可以通过前一帧的旋转矩阵和前两帧之间的相对旋转求解

$ \hat{{R}}_{v, k}={R}_{rel}{R}_{v, k-1}=\left({R}_{v, k-1}{R}_{v, k-2}^{\rm T}\right){R}_{v, k-1} \label{eq:R_t_predict} $

(4) 平移的预测则将车辆在两帧间的位移进行求和.在较短的时间内, 位移方向近似为前后帧车辆朝向的角平分线的方向, 即

$ \hat{{s}}_{v, k} \approx {s}_{v, k-1} + \frac{{d}_{y, k-1}+\hat{{d}}_{y, k}}{2}\int_{t_{k-1}}^{t_k}{v_t}{\rm d}t $

(5) 其中, ${d}_{y, k-1}$为车体$k-1$时刻的朝向, $\hat{{d}}_{y, k}$为车体$k$时刻朝向预测结果, $v$为车速.相机在$k$时刻的位置姿态通过车体的位置姿态预测结果和标定参数进行求解.

$ {\widehat R_{c, k}} = {\widehat R_{v, k}}{R_{cv}} $

(6) $ {\widehat s_{c, k}} = {\widehat s_{v, k}} + {\widehat R_{v, k}}{s_{cv}} $

(7) 世界坐标系下到相机的投影矩阵的预测为

$ {\hat P_c} = K[\widehat R_{c, k}^{\rm{T}}|-\widehat R_{c, k}^{\rm{T}}{\widehat s_{c, k}}] $

(8) 车体和相机的位置预测完成后, 道路结构通过相机的投影矩阵变换到图像坐标系下, 如图 3所示.对于直道环境, 只有一条道路线被投影到图像中, 生成一个局部道路坐标系; 对于路口环境, 多条道路线被投影到图像中, 将图像分割成不同区域, 每个区域包含一个局部道路坐标系; 对于弯道环境, 用多段线段拟合弯道, 再将其投影到图像中, 与路口环境类似.对于每一个区域, 道路坐标系对应三个朝向${d}_j$ $(j=1, 2, 3)$, 分别为道路行进方向、水平垂直道路方向和竖直方向.虽然对于二维地图, 道路朝向只有一个自由度, 但为了系统的统一, 以及今后有三维道路地图后算法的可扩展性, 使用旋转矩阵${R}_r=[{d}_1 \ {d}_2 \ {d}_3]$来描述道路朝向.

3.3 道路结构特征提取

道路结构特征RSF定义为$\{{L}_1, {L}_2, {L}_3, {P}\}$, 即三垂线和特征点的集合.道路结构特征的提取中最重要的部分为从图像基础特征(线段和点)中建立道路结构特征.对于特征点, 直接使用通用特征点检测跟踪结果; 对于三垂线特征, 利用预测的道路结构, 将通用线段特征依照朝向进行分类, 关键点在于定义图像线段和道路坐标系三方向的距离函数.

图像上的任意线段${l}_i$转换到相机坐标系下, 构成一个过相机中心的平面${\pi}_i^l = [{l}_i^{\rm T}{K} \ \ 0]^{\rm T}$, 其法线方向为

$ {n}_i=\frac{{K}^{\rm T}{l}_i}{\left\|{K}^{\rm T}{l}_i\right\|} $

(9) 定义线段${l}_i$到道路方向${R}_r{e}_j$的距离函数为线段对应平面法线${n}_i$和道路方向${R}_r{e}_j$夹角余弦值的平方, 即

$ {d^2}({l_i}, {R_r}{e_j}) = {\left( {n_i^{\rm{T}}R_c^{\rm{T}}{R_r}{e_j}} \right)^2} = {\left( {\frac{{l_i^{\rm{T}}KR_c^{\rm{T}}{R_r}{e_j}}}{{\left\| {{K^{\rm{T}}}{l_i}} \right\|}}} \right)^2} $

(10) 对于任意线段${l}_i$, 计算它和局部坐标系下三方向的距离, 将其归类为距离最近的方向, 并将其朝向记录为${d}_i$.当最小距离大于给定阈值$\epsilon$时, 该线段则被当作噪声滤除.

3.4 车体位置姿态估计

给定一个道路结构特征的采样${C}_{\rm RSF}$, 如式(1) 所示.其中${l}_1$, ${l}_2\in {L}_u$为图像上的两条线段, 对应两条在道路坐标系下的平行线; ${l}_3\in {L}_v$为第三条线段, 在道路坐标系下垂直于前两条线段. ${p}_1, {p}_2\in {P}$为两个特征点.令$\hat{{d}}_1, \hat{{d}}_2$, $\hat{{d}}_3$为三垂线特征${l}_1, {l}_2, {l}_3$的朝向估计结果, ${p}_1$和${p}_2$为当前帧检测到的特征点, $p'_1$和$p'_2$为前一帧的跟踪结果.

3.4.1 旋转矩阵求解

根据线特征和对应朝向的距离定义, 有

$ l_1^{\rm{T}}KR{\widehat d_1} = 0 $

(11) $ {l}_2^{\rm T}{K}{R}\hat{{d}}_2=0 \label{eq:l_1, l_2} $

(12) $ {l}_3^{\rm T}{K}{R}\hat{{d}}_3=0 \label{eq:l_3} $

(13) 从特征采样中已知${l}_1$和${l}_2$在道路坐标系下的朝向一致, 即$\hat{{d}}_1=\hat{{d}}_2$, 则${l}_1$和${l}_2$在图像上的交点对应于该朝向的消失点, 即

$ {v}_1= {l}_1\times {l}_2 = \lambda {K}{R}\hat{{d}}_1 \label{eq:vp} $

(14) 根据罗德里格斯矩阵, 旋转矩阵可改写为

$ R = {\left( {I-S} \right)^{-1}}\left( {I + S} \right) $

(15) $ S = \left[{\begin{array}{*{20}{c}} 0&{-c}&{-b}\\ c&0&{-a}\\ b&a&0 \end{array}} \right] $

(16) 将式(15) 代入式(14) 中, 可得

$ (I-S){K^{-1}}({l_1} \times {l_2}) = \lambda(I + S){\widehat d_1} $

(17) 结合式(16) 和式(17), 共有4个参数$a, b, c, \lambda$需要求解.式(17) 和式(13) 共给出4个约束方程, 通过联立方程组可求解这4个参数.在求解过程中, 最多产生两组可行解, 这两组可行解对应${l}_3$的方向相反.通过和预测的旋转矩阵$\hat{{R}}_c$做比较, 可滤除错误解, 留下唯一可行解.

3.4.2 平移向量求解

在世界坐标系下, 令当前帧相机的投影矩阵为${P}={K}[{R}|{t}]$, 前一帧相机的投影矩阵为${P'}={K}[{R'}|{t}^\prime]$, 则相机的相对旋转和平移为

$ {R}_{\rm rel} = {R} {{R'}}^{\rm T} $

(18) $ {t}_{\rm rel}={t} - {R}_{\rm rel}^{\rm T} {t'} \label{eq:t} $

(19) 根据对极几何约束可得

$ {p}^{\rm T} {F} {p'}=0 \label{eq:pFp} $

(20) 其中,

$ {F} = {K}^{-{\rm T}} {\left[{t}_{\rm rel}\right]}_\times {R}_{\rm rel} {K}^{-1} \label{eq:F} $

(21) 由于旋转矩阵已知, 式(20) 中待求解的只有平移向量, 共三个自由度.使用两个特征点, 即可通过式(20) 求解出归一化的平移向量, 尺度因子则需要通过其他方式求解.在本文实验中, 尺度因子通过车轮编码器所获取的车速信息求解.相对位移求解完成后, 通过式(19) 求解当前相机的绝对位置, 再利用标定参数, 得到车体的绝对位置.

3.4.3 后验概率估计

每一个采样${C}_{\rm RSF}$都可求解出相应的旋转矩阵和平移向量.由于采样的随机性, 需要多次采样来得到最优解.而最优解的估计可以通过最大化后验概率得到.其中, $p(x_k^i|x_{k-1})$为运动模型, 通过车辆的基础运动模型加上高斯噪声求解; 为观测模型, 需要定义观测值与真值的误差函数来求解.

本文误差函数定义为线特征与点特征的误差加权和, 即

$ E= E_{l} + \lambda E_{p} $

(22) 对于三垂线特征, 误差定义为线段长度的平方乘以它到对应道路朝向的距离, 即

$ E_{l} = \sum_{i} {\rm len}^2({l}_i) \times d^2({l}_i, \hat{{d}}_i) $

(23) 其中, ${\rm len}({l}_i)$是线段${l}_i$的长度, $d^2({l}_i, \hat{{d}}_i)$是线段和对应道路朝向的距离, 即

$ {d^2}({l_i}, {\widehat d_i}) = {\left( {\frac{{l_i^{\rm{T}}KR_c^{\rm{T}}{{\widehat d}_i}}}{{\left\| {{K^{\rm{T}}}{l_i}} \right\|}}} \right)^2} $

(24) 对于点特征, 误差定义为点到对应对极线距离的平方, 即

$ E_{p} = \sum_{i} \left[d^2({p}, {F} {p'}) + d^2({p'}, {F}^{\rm T}{p})\right] $

(25) 其中, 距离$d({p}, {F} {p'})$是点${p}$到对极线${F} {p}^\prime$的距离.

3.5 鲁棒性优化

道路结构特征的采样${C}_{\rm RSF}$需要包含三条线段和两个特征点, 其中三条线段${l}_1, {l}_2, {l}_3$需要满足${d}_1={d}_2$, ${d}_1\times {d}_3=0$.因此, 算法需要检测至少两个主方向上的线段.对于空旷环境, 即移动车辆、路灯、建筑物较少的情况, 水平垂直道路方向和竖直方向上的线特征均较少, 只有道路行进方向的线特征可被稳定检测.在这种情况下, 假设路面平整, 车辆颠簸不明显, 车辆运动只包含三个自由度对应旋转矩阵${R}$退化为一个自由度.利用公式, 通过一条线段求解旋转矩阵.同理, 当仅能检测到其他两个主方向上的线段时, 也将车辆运动退化为二维运动求解.此外, 当无法检测到有效数目的主方向线段时, 则根据通用的特征点定位算法求解.算法根据当前帧图像所能检测到的三垂线数目动态切换.

4. 实验与分析

4.1 概述

本文利用如图 5所示的智能车平台, 在北京市区的路口、拥堵路段、密集街道等典型复杂场景进行数据采集和算法验证1.实验中利用PointGray公司的Flea2相机采集图像序列, 图像分辨率为640像素$\times$ 480像素, 关键帧采样帧率为3 Hz; 利用车轮编码器采集车速信息, 用于平移尺度的求解.为了对算法的精度进行比较验证, 实验中使用一台拥有光纤陀螺的GPS惯性导航组合定位系统对车辆位置方向进行高精度测量.

1实验相关视频已上传至优酷: http://v.youku.com/v_show/id_XMTU4MDIzOTM5Mg==.html?from=y1.7-1.2

实验中使用线段检测工具包(Line segment detector, LSD)[22]进行图像线段检测, 参考文献[23]中的算法进行图像特征点检测跟踪.本文算法的实验结果与目前被广泛使用的单目视觉里程计算法libviso2[13]、最新发表的Orb-SLAM算法[12]以及高精度GPS/惯导进行比较.以下分别对路口、拥堵路段和密集街道等三种典型场景的实验结果进行展示, 最后给出分析讨论.在路口和拥堵路段场景, Orb-SLAM在初始化时特征点集中于前方移动车辆上, 导致定位失败.在密集街道场景中, 移动车辆少, Orb-SLAM结果较为稳定.因此本文仅在密集街道场景中加入与Orb-SLAM定位结果的比较.

4.2 案例分析

4.2.1 路口实验

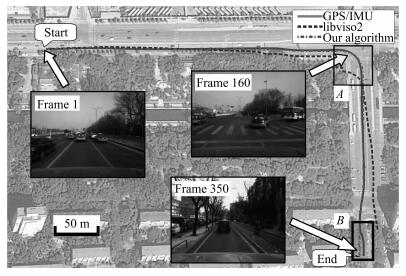

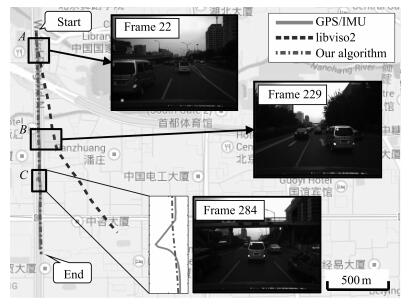

路口实验场景起始点坐标为(39.9754760, 116.3911050), 行驶距离约为600米, 时间约为2分钟, 采集了共350帧关键帧, 车辆行驶过程中包括两次右换道、一次右转和一次靠右并入辅路等驾驶行为, 如图 6所示.

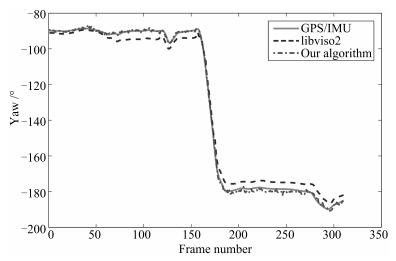

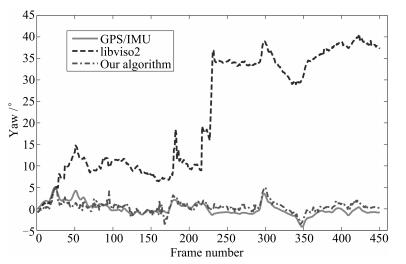

图 6中点虚线、虚线和实线分别为本文算法、libviso2和GPS/IMU的定位结果.如图 6中$B$区域所示, 在本次实验终点处, 虽然实验车沿直线行驶进入辅路, 然而由于周边树木建筑物密集, 卫星信号受到干扰, GPS定位结果有明显偏移.在$B$区域以外的其他区域中, 卫星信号条件良好, GPS定位有较高的精度, 因此本文利用$B$区域以外的GPS数据作为参照, 定量化验证本算法的定位精度, 并与libviso2的结果进行比较.实验中, libviso2的结果在车辆右转过程中产生明显偏差, 如$A$区域所示, 而本文算法表现良好, 轨迹和GPS接近. 图 7展示了算法对车辆朝向的估计结果.本文算法与GPS/IMU的结果非常接近, 而libviso2的结果却存在明显偏差.虽然偏差只有5度, 但由此引起的位置偏差非常大, 在进入$B$区域前与GPS相比有约15米的误差.说明在定位中, 朝向的估计精度有着重要的影响, 而实验结果表明本文算法在朝向估计上精度明显高于libviso2.需要说明的是, 本文算法在朝向结算上只使用了当前帧的信息, 导致结果存在局部噪声, 呈现轻微锯齿状.这个现象可以通过今后引入前后帧跟踪予以缓解.

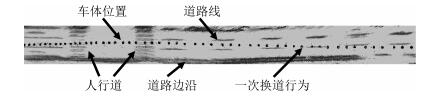

为了使结果更加直观, 将图像中的沿道路线方向的线段结合定位结果投影到地平面上, 得到如图 8所示结果.通过投影结果, 可以较清晰地看到斑马线、道路标线、道路边界等信息.结合车体运动轨迹, 可以检测出一些高层的运动信息, 例如车辆换道等.

4.2.2 拥堵路段

拥堵路段实验场景在四环主路, 车流量大, 行驶速度缓慢, 道路笔直, 多处有过街天桥.车辆由北向南行驶, 起始点坐标为(39.9544800, 116.3031370), 行驶时间约为2分30秒, 全长约1 800米, 共采集450帧关键帧, 期间做了若干次换道.实验中未使用地图信息, 而利用前一帧的处理结果, 推测当前帧道路结构.实验结果如图 9所示, 其中点虚线、虚线和实线轨迹分别表示本文算法、libviso2和GPS/IMU的结果. libviso2的结果在第22帧和第229帧附近有两处较大偏差(如图 9中$A$区域和$B$区域所示), 原因是一辆环境车占据了图像中很大区域, 且进行换道, 即包含相对于车道的横向运动.图像中该车上的特征点为实验车的运动估计带来干扰, 特别是在朝向求解上(如图 10所示).另外, 实验路线中多处经过过街天桥.这些天桥对卫星信号造成遮挡或干扰, 使得经过天桥时, GPS定位结果出现很大偏差.如图 9中$C$区域所示, GPS轨迹呈现约10米的偏差.相比之下, 本文算法的结果在朝向及位置估计上均稳定可靠, 结果优于GPS和libviso2.

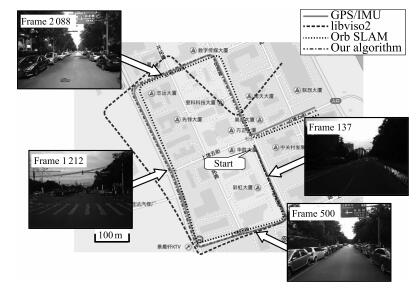

4.2.3 密集街道

密集街道场景在北京上地信息路附近区域.车辆行驶了约6分30秒, 全长约2 000米, 采集了3 800帧视频数据, 期间做了若干次换道和左右转弯.定位结果如图 11所示, 其中点虚线、点线和虚线, 实线轨迹分别表示本文算法、Orb-SLAM、libviso2和GPS/IMU的结果.由于Orb-SLAM算法存在平移尺度漂移, 为了更好地比较结果, 利用车速信息将平移尺度修正. 图 11所示结果中, libviso2的结果在几次转弯后出现明显偏差, 而本文算法和Orb-SLAM误差相对较小.以GPS值作为参考值计算误差, 本文算法精度高于Orb-SLAM (数值对比结果见表 1).在本场景中, 部分区域没有车道线信息, 且由于路边停放的车辆, 道路边沿被遮挡, 道路结构信息不明显(如图 11中第500帧和第2 088帧图像).尽管如此, 但车辆大多沿道路方向停放, 其所提供的线特征与道路行驶方向以及垂直方向吻合.在本文算法的三垂线检测过程中, 环境车辆上提供了大量符合场景约束的线段特征, 使得朝向估计稳定, 定位准确.

表 1 三组实验的平移和朝向误差Table 1 Translation and rotation errors路口实验 拥堵路段 密集街道 平移(%) 朝向(°/m) 平移(%) 朝向(°/m) 平移(%) 朝向(°/m) 均差, 95% 均差, 95% 均差, 95% 均差, 95% 均差, 95% 均差, 95% libviso2 3.94, 7.85 0.0144, 0.0323 18.60, 34.09 0.0249, 0.0428 6.63, 11.70 0.0137, 0.0227 Orb-SLAM — — — — 3.18, 5.33 0.0101, 0.0218 Our 1.07, 2.94 0.0024, 0.0049 0.89, 1.82 0.0016, 0.0040 0.69, 1.23 0.0031, 0.0075 4.3 分析讨论

在路口、拥堵路段、密集街道三组实验中, 对每组数据进行分段, 每100米为一段统计平移和朝向误差(百分比), 得到多段测试的结果; 对每组实验求平均误差和95%置信度区间, 得表 1 (参考Kitti数据库中的关于视觉里程计的误差定义2进行评价).从表 1中可知, 本文方法的平移误差均值在三组实验中分别为1.07%、0.89%和0.69%, 算法精度较高.误差独立统计中95%的误差值在3%以下(分别为2.94%、1.82%和1.23%), 说明算法的鲁棒性较高.基于特征点的libviso2算法整体误差较大, 尤其在拥堵路段, 由于移动障碍物干扰较大, 导致libviso2的平均误差达到18.49%.在前两组实验中由于移动车辆干扰过大, Orb-SLAM在初始化时特征点大多在前方车辆上, 导致定位完全失败.在第三组密集街道实验中, 移动车辆数目较少, Orb-SLAM算法平移误差为3.18%, 定位精度高于libviso2, 但低于本文算法.

2http://www.cvlibs.net/datasets/kitti/eval_odometry.php

从路口、拥堵路段、密集街道三组实验中可知, 在视觉定位算法中, 朝向(旋转)求解的准确性极大地影响了定位精度.本文提出的基于道路结构特征的定位算法, 通过可以利用结构化道路场景所普遍拥有的三垂线信息, 提高了对车体朝向估计的准确性. 图 12简要列举了在不同场景下的三垂线检测结果.其中图 12(a)为开阔场景, 道路上来往车辆很少; 图 12(b)为拥堵场景, 周围车辆数目较多; 图 12(c)为接近天桥场景, 且存在地面标识.这三个结果说明在任何拥堵状态下, 三垂线检测都很稳定, 尤其在可视范围内有天桥和建筑物时, 三垂线的数目明显增加. 图 12(d)和图 12(e)为车道线不明显和相机过曝光下的检测结果, 三垂线的检测没有受到过多影响. 图 12(f)~12(h)为主体车进行换道, 转弯等驾驶行为时的检测结果.在车辆转弯的过程中, 斑马线特征明显, 因此转弯时朝向求解精度很高, 与前面的定位结果一致. 图 12(i)和图 12(j)为直道实验中, 基于点特征的视觉定位算法受到的两次环境车干扰.环境车分别从左侧和右侧进入相机视野且进行换道行为, 导致点特征不稳定, 影响了基于点特征的定位结果.而三垂线特征对于环境车的干扰具有较好的鲁棒性.

实验结果表明, 在结构化道路场景中, 本文算法定位准确, 特别是在朝向估计上, 明显优于传统基于特征点的方法.在卫星信号易受干扰的城市密集区域, 本文算法可以有效弥补GPS定位的不足, 满足自动驾驶所需的车道级定位精度.然而本文算法在实际应用中仍然面临以下问题: 1) 算法为开环算法, 存在累计误差, 特别是缺乏地图信息的区域.如何构建与GPS和地图的融合定位算法是实际应用的关键. 2) 算法无法解决弯道场景下的定位问题.虽然理论上可以将弯道分解为若干个短直道, 然而这样的近似为描述真实的道路结构带来一定的误差, 导致算法在实际应用中缺乏足够的精度和鲁棒性.

5. 总结与展望

本文结合道路场景中的线特征与点特征, 定义道路结构特征, 提出基于该特征的单目视觉定位算法, 有效提高了高动态结构化道路环境下的定位精度.在结构化道路场景中, 线特征方向性明显, 呈现三个主要方向(道路行进方向、水平垂直道路方向和竖直方向)且相互垂直.本文算法利用路面、周围车辆和道路设施上的线段, 提取三垂线特征, 估计车辆与局部道路坐标系之间的朝向关系, 并结合图像点特征进行定位.实验结果表明, 在结构化道路场景中, 本文算法优于传统基于特征点的视觉定位算法, 在高动态交通环境中对来自车辆的干扰有很好的鲁棒性.在卫星信号易受干扰的区域, 可以有效地弥补GPS等定位系统的不足, 为满足自动驾驶所需的车道级定位要求提供重要的技术手段.

本文提出了一个利用道路结构化特征点视觉定位算法.然而面向真实复杂场景的实际应用, 仍面临以下研究课题: 1) 构建闭环定位的应用系统, 从而减少累积误差; 2) 拓展算法, 解决弯道场景的定位问题; 3) 建立多传感器或多源信息融合的解决方案, 提高算法的鲁棒性.针对累计误差, 算法可与路口检测或交通场景理解算法(如文献[24-25])相结合, 利用道路结构的拓扑性, 消除累计误差, 构建闭环定位的应用系统.针对弯道场景, 算法可融合地图信息进行拓展, 建立基于曲线车道结构特征的视觉定位算法.曲线车道结构特征的提取可参考文献[26], 建立基于车道平行平面曲线的提取与映射.这些将在今后的研究中逐步开展.

-

表 1 三组实验的平移和朝向误差

Table 1 Translation and rotation errors

路口实验 拥堵路段 密集街道 平移(%) 朝向(°/m) 平移(%) 朝向(°/m) 平移(%) 朝向(°/m) 均差, 95% 均差, 95% 均差, 95% 均差, 95% 均差, 95% 均差, 95% libviso2 3.94, 7.85 0.0144, 0.0323 18.60, 34.09 0.0249, 0.0428 6.63, 11.70 0.0137, 0.0227 Orb-SLAM — — — — 3.18, 5.33 0.0101, 0.0218 Our 1.07, 2.94 0.0024, 0.0049 0.89, 1.82 0.0016, 0.0040 0.69, 1.23 0.0031, 0.0075 -

[1] 李宇波, 朱效洲, 卢惠民, 张辉.视觉里程计技术综述.计算机应用研究, 2012, 29(8): 2801-2805, 2810 http://www.cnki.com.cn/Article/CJFDTOTAL-JSYJ201208002.htmLi Yu-Bo, Zhu Xiao-Zhou, Lu Hui-Min, Zhang Hui. Review on visual odometry technology. Application Research of Computers, 2012, 29(8): 2801-2805, 2810 http://www.cnki.com.cn/Article/CJFDTOTAL-JSYJ201208002.htm [2] Moravec H P. Obstacle Avoidance and Navigation in the Real World by a Seeing Robot Rover, Technical Report ADA092604, Department of Computer Science, Stanford University, USA, 1980. [3] Matthies L, Shafer S. Error modeling in stereo navigation. IEEE Journal on Robotics and Automation, 1987, 3(3): 239-248 doi: 10.1109/JRA.1987.1087097 [4] Nistér D, Naroditsky O, Bergen J. Visual odometry. In: Proceedings of the 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Washington, DC, USA: IEEE, 2004. 652-659 [5] Nistér D, Naroditsky O, Bergen J. Visual odometry for ground vehicle applications. Journal of Field Robotics, 2006, 23(1): 3-20 doi: 10.1002/(ISSN)1556-4967 [6] Triggs B, McLauchlan P F, Hartley R I, Fitzgibbon A W. Bundle adjustment-a modern synthesis. Vision Algorithms: Theory and Practice. Berlin Heidelberg, Germany: Springer-Verlag, 2000. 298-372 [7] Mouragnon E, Lhuillier M, Dhome M, Dekeyser F, Sayd P. Real time localization and 3D reconstruction. In: Proceedings of the 2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. New York, NY, USA: IEEE, 2006. 363-370 [8] Fischler M A, Bolles R C. Random sample consensus: a paradigm for model fitting with applications to image analysis and automated cartography. Communications of the ACM, 1981, 24(6): 381-395 doi: 10.1145/358669.358692 [9] Ozden K E, Schindler K, Van Gool L. Multibody structure-from-motion in practice. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(6): 1134-1141 doi: 10.1109/TPAMI.2010.23 [10] Kundu A, Krishna K M, Jawahar C V. Realtime multibody visual SLAM with a smoothly moving monocular camera. In: Proceedings of the 2011 IEEE International Conference on Computer Vision. Barcelona, Spain: IEEE, 2011. 2080-2087 [11] Engel J, Schöps T, Cremers D. LSD-SLAM: large-scale direct monocular SLAM. In: Proceedings of the 13th European Conference on Computer Vision. Berlin Heidelberg, Germany: Springer, 2014. 834-849 [12] Mur-Artal R, Montiel J M M, Tardós J D. ORB-SLAM: a versatile and accurate monocular SLAM system. IEEE Transactions on Robotics, 2015, 31(5): 1147-1163 doi: 10.1109/TRO.2015.2463671 [13] Geiger A. Libviso2: library for visual odometry 2 [Online], available: http://www.cvlibs.net/software/libviso, January 3, 2017 [14] Ramalingam S, Bouaziz S, Sturm P, Brand M. Skyline2gps: localization in urban canyons using omni-skylines. In: Proceedings of the 2010 IEEE/RSJ International Conference on Intelligent Robots and Systems. Taipei, China: IEEE, 2010. 3816-3823 [15] Ramalingam S, Bouaziz S, Sturm P. Pose estimation using both points and lines for geo-localization. In: Proceedings of the 2011 IEEE International Conference on Robotics and Automation. Shanghai, China: IEEE, 2011. 4716-4723 [16] Achar S, Jawahar C V, Krishna K M. Large scale visual localization in urban environments. In: Proceedings of the 2011 IEEE International Conference on Robotics and Automation. Shanghai, China: IEEE, 2011. 5642-5648 [17] Ziegler J, Lategahn H, Schreiber M, Keller C G, Knöppel C, Hipp J, Haueis M, Stiller C. Video based localization for bertha. In: Proceedings of the 2014 IEEE Intelligent Vehicles Symposium. Dearborn, MI, USA: IEEE, 2014. 1231-1238 [18] Geiger A. Monocular road Mosaicing for urban environments. In: Proceedings of the 2009 IEEE Intelligent Vehicles Symposium. Xi'an, China: IEEE, 2009. 140-145 [19] Zhang J, Song D Z. On the error analysis of vertical line pair-based monocular visual odometry in urban area. In: Proceedings of the 2009 IEEE/RSJ International Conference on Intelligent Robots and Systems. St. Louis, MO, USA: IEEE, 2009. 3486-3491 [20] Barinova O, Lempitsky V, Tretiak E, Kohli P. Geometric image parsing in man-made environments. In: Proceedings of the 11th European Conference on Computer Vision. Berlin Heidelberg, Germany: Springer, 2010. 57-70 [21] Tretyak E, Barinova O, Kohli P, Lempitsky V. Geometric image parsing in man-made environments. International Journal of Computer Vision, 2012, 97(3): 305-321 doi: 10.1007/s11263-011-0488-1 [22] von Gioi R G, Jakubowicz J, Morel J M, Randall G. LSD: a line segment detector [Online], available: http://www.ipol.im/pub/art/2012/gjmr-lsd/, January 3, 2017 [23] Geiger A, Ziegler J, Stiller C. Stereoscan: dense 3d reconstruction in real-time. In: Proceedings of the 2011 IEEE Intelligent Vehicles Symposium. Baden-Baden, Germany: IEEE, 2011. 963-968 [24] Geiger A, Lauer M, Wojek C, Stiller C, Urtasun R. 3D traffic scene understanding from movable platforms. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 36(5): 1012-1025 doi: 10.1109/TPAMI.2013.185 [25] Corral-Soto E R, Elder J H. Automatic single-view calibration and rectification from parallel planar curves. In: Proceedings of the 13th European Conference on Computer Vision. Berlin Heidelberg, Germany: Springer, 2014. 813-827 [26] 庄严, 陈东, 王伟, 韩建达, 王越超.移动机器人基于视觉室外自然场景理解的研究与进展.自动化学报, 2010, 36(1): 1-11 http://www.aas.net.cn/CN/abstract/abstract13622.shtmlZhuang Yan, Chen Dong, Wang Wei, Han Jian-Da, Wang Yue-Chao. Status and development of natural scene understanding for vision-based outdoor moblie robot. Acta Automatica Sinica, 2010, 36(1): 1-11 http://www.aas.net.cn/CN/abstract/abstract13622.shtml 期刊类型引用(15)

1. 刘诤轩,王亮,李和平,程健. 融合双目视觉和2D激光雷达的室外定位. 控制与决策. 2023(07): 1861-1868 .  百度学术

百度学术2. 孙沁璇,苑晶,张雪波,高远兮. PLVO:基于平面和直线融合的RGB-D视觉里程计. 自动化学报. 2023(10): 2060-2072 .  本站查看

本站查看3. 滕文鑫,张建辰,邵杰. 集成时空邻近与卷积网络车道级高精度定位算法. 测绘通报. 2022(06): 1-5+61 .  百度学术

百度学术4. 刘涌,查明. 基于视觉感知技术的机场旅客定位系统设计与实现. 信息记录材料. 2021(10): 218-219 .  百度学术

百度学术5. 王婷娴,贾克斌,姚萌. 面向轻轨的高精度实时视觉定位方法. 自动化学报. 2021(09): 2194-2204 .  本站查看

本站查看6. 马芳武,史津竹,葛林鹤,代凯,仲首任,吴量. 无人驾驶车辆单目视觉里程计的研究进展. 吉林大学学报(工学版). 2020(03): 765-775 .  百度学术

百度学术7. 李杰,李响,许元铭,杨绍杰,孙可意. 工业人工智能及应用研究现状及展望. 自动化学报. 2020(10): 2031-2044 .  本站查看

本站查看8. 王文博,黄璞,杨章静. 基于超宽带、里程计、RGB-D融合的室内定位方法. 计算机科学. 2020(S2): 334-338 .  百度学术

百度学术9. 罗刘敏. 物联网下大区域校园智能视觉特征定位技术仿真. 科学技术与工程. 2019(07): 154-160 .  百度学术

百度学术10. 王志,汪步云,胡汉春,郭宇杰,黄玉成,许德章. 移动机器人导航系统中的车道线检测方法及实现. 计算机测量与控制. 2019(09): 42-46 .  百度学术

百度学术11. 张喜凤. 基于Pixy传感器的视觉识别智能车的设计与实现. 电子测量技术. 2018(12): 17-20 .  百度学术

百度学术12. 张喜凤. Pixy机器视觉传感器及其典型应用. 电子测试. 2018(Z1): 53-54+57 .  百度学术

百度学术13. 燕必希,朱立夫,董明利,孙鹏,王君. 卡尔曼滤波单目相机运动目标定位研究. 仪器仪表学报. 2018(08): 220-229 .  百度学术

百度学术14. 程亚军,任小洪,蔡绍堂,郑争光. 基于级联神经网络的单目视觉目标定位. 自动化与仪器仪表. 2018(05): 14-17+23 .  百度学术

百度学术15. 袁旻川,徐友春,李永乐. 基于车道线提取的智能车横向定位技术. 军事交通学院学报. 2018(10): 35-40 .  百度学术

百度学术其他类型引用(23)

-

下载:

下载:

下载:

下载: