Research on TV-L1 Optical Flow Model for Image Registration Based on Fractional-order Differentiation

-

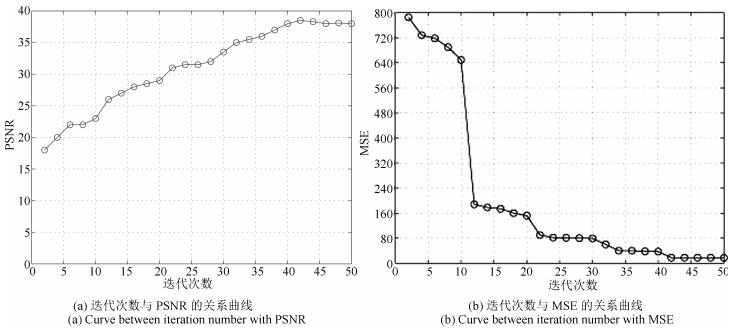

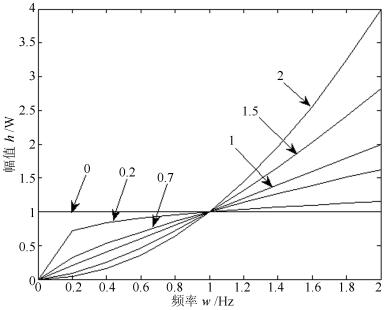

摘要: 图像的非刚性配准在计算机视觉和医学图像分析中有着重要的作用.TV-L1(全变分L1范数、Total variation-L1)光流模型是解决非刚性配准问题的有效方法,但TV-L1光流模型的正则项是一阶导数,会导致纹理特征等具有弱导数性质的信息模糊.针对该问题,将G-L(Grünwald-Letnikov)分数阶引入TV-L1光流模型,提出基于G-L分数阶微分的TV-L1光流模型,并应用原始-对偶算法求解该模型.新的模型用G-L分数阶微分代替正则项中的一阶导数,由于分数阶微分比整数阶微分具有更好的细节描述能力,并能有效地、非线性地保留具有弱导数性质的纹理特征,从而提高图像的配准精度.另外,通过实验给出了配准精度与G-L分数阶模板参数之间的关系,从而为模板最佳参数的选取提供了依据.尽管不同类型的图像其最佳参数是不同的,但是其最佳配准阶次一般在1 ~2之间.理论分析和实验结果均表明,提出的新模型能够有效地提高图像配准的精度,适合于包含较多弱纹理和弱边缘信息的医学图像配准,该模型是TV-L1光流模型的重要延伸和推广.Abstract: In computer vision and medical image analysis, non-rigid image registration is a challenging task. TV-L1 (Total variation-L1) optical flow model has been proved to be an effective method in the field of non-rigid image registration. It can solve the problem of fuzzy edge caused by smooth displacement fields of Horn-Schunck, but its first-order derivative in regularization term leads to fuzzy texture information with weak derivative property. Aiming at the problem, this paper introduces G-L (Grünwald-Letnikov) fractional differentiation to TV-L1 optical flow model, and proposes a new TV-L1 optical flow model based on fractional differentiation, and then finds the solution of the model using primal-dual algorithm. In this paper we use Grünwald-Letnikov fractional order differential instead of the first-order derivative in the regularization term for its better ability of detail description than first-order's. Then we purposefully control to retain or inhibit the texture information with weak derivative nature, thus improving the registration accuracy. Experimental results show that the proposed method has a better registration accuracy in registration of texture information with weak derivative, and that it can be considered an important extension and generalization of TV-L1 optical flow modes.

-

在图像处理和现代科技应用中, 伴随着数字图像处理技术的逐渐进步, 彩色图像灰度化技术越来越受到重视.首先在一些图像处理和模式识别等技术系统的预处理阶段, 例如人脸识别、运动目标跟踪等, 为了减少输入图像的信息量或者是减少后续的运算量, 都需要将彩色图像灰度化, 这样不仅能够增加后续算法的处理速度, 还能够大大提高系统综合应用实效.另外, 因为打印成本的原因, 很多课本报刊及论文等资料仍然将彩色图像转换成灰度图像打印出来.最后灰度图像在艺术美学方面也有广泛应用, 如中国水墨画渲染等.因此, 研究图像灰度化技术具有重要意义.

上述应用需求推动着各种彩色图像灰度化方法的发展.彩色图像的灰度化过程可以看成是一个将彩色图像从三维颜色矢量空间变换到一维灰度标量空间的降维过程.在这种空间转换过程中, 不可避免的会有许多彩色图像的颜色信息因空间转换而丢失.各种算法试图利用有限范围的灰度值呈现输入彩色图像的对比度和颜色顺序等细节.因此, 为得到比较好的彩色图像灰度化效果, 应该考虑在映射彩色图像亮度信息的基础上, 尽量多地向灰度图像映射原彩色图像的颜色对比信息.

若原输入图像是RGB格式, 常用的彩色图像灰度化的方法是以固定权重线性地对RGB通道求和(即Matlab中的rgb2gray函数).然而, 对于一些有不平衡颜色值区域的彩色图像, 仅使用高亮度通道图像不能如实地表示它们的结构和对比度.近几年, 有关认知驱动灰度化的理论和算法取得显著性进展, 从而产生了大量新方法.这些灰度化算法整体上主要分为两大类:局部映射算法和全局映射算法.在局部算法映射中, 多维度色彩到单维度灰度映射的像素值取决于颜色的局部空间分布.局部映射类算法运算量小、计算简单、算法处理速度很快, 基于这些优点, 局部映射类的算法对于大部分的彩色图像都具有比较好的处理效果. Bala等[1]提出了一种将高频色度分量加入亮度分量的空间域方法, 在色度分量进行高通滤波, 并将滤波器输出量与亮度相关的项加权, 将结果加入到亮度分量. Neumann等[2]通过将彩色空间中的色彩和亮度对比度作为梯度对比度从而得到灰度图. Smith等[3]将图像分解成几段频率成分, 并用色度分量调整组合权重.这些局部映射算法具有有效地保护局部色差的特点, 但往往只是将一部分彩色图像信息通过空间映射的方法映射到灰度图像, 并没有比较好地平衡原彩色图像中的亮度值信息和色度值信息, 导致灰度图像只能体现原彩色图像的部分对比信息.

在全局的映射方法中, 输入图像的所有像素采用相同的灰度值化映射, 其主要分为基于变换的降维类和像素点颜色对比的方法.对于变换的降维类的方法, 以主成分分析(Principle component analysis, PCA)变换降维为主要代表.对于像素点颜色对比的方法, 这一类算法的思想是在构造从彩色图像到灰度图像的映射函数时, 综合利用彩色图像像素点的亮度值信息和颜色对比度信息, 并尽量多地向灰度图像映射原彩色图像相邻区域的不同颜色对比信息, 从而增加灰度图像的对比度.对此Gooch等[4]提出一种基于彩色图像相邻像素点间颜色差值的灰度化算法, 首先, 通过求解彩色图像相邻像素点之间的颜色差值和亮度差值; 然后, 通过得到的颜色信息和亮度信息构造灰度级目标函数; 最后, 通过构造和求解优化方程得到灰度图像. Rasche等[5]直接对不同的颜色对集进行约束, 并且通过建立二次多项式求解出灰度图像. Kim等[6]分别从参数化和扩充梯度点集的角度对Gooch的工作进行了扩展.在国内, 上海交通大学的Du等基于显著性引导的图像灰度化算法, 他们使用区域显著性保持作为优化目标并将灰度图像参数化为依赖局部特征和不依赖局部特征两步部分的权重和进行优化求解来实现[7].浙江大学的宋明黎等主要侧重于在图像灰度化过程中对空域中各种视觉效果特征的保持进行建模, 在建立优化模型后采用参数优化的方式进行求解[8-10].全局映射算法缺点是将彩色图像信息映射到灰度图像后, 可能会出现原彩色图像中不同区域相同的颜色信息映射为相同的灰度值的情况, 还可能会出现彩色图像中不同区域不同颜色信息映射为同一灰度值的情况[11-12].

现有的方法普遍存在计算成本高和对原图像对比度小的区域不能很好保持的缺点.为了克服这些缺陷, 研究人员重新考虑简单和传统的rgb2gray模型.具体地讲, 它假定输出的灰度图像是彩色图像中RGB通道的线性组合, 即分别代表RGB颜色通道分量.例如在经典Matlab的rgb2gray函数, 所有图像的权重都是固定的.最近, 一些研究人员通过引入一些度量对离散的候选灰度图像集合进行比较, 自适应地选择通道权重. Lu等提出基于梯度误差最小化的CP (Contrast preserving)[13]及RTCP (Real-time contrast preserving)模型[14]算法, 其中RTCP算法[14]使用66个候选值离散化线性参数模型的解空间, 然后基于能量值选取其中最小梯度误差的候选值作为最优解.用双峰分布函数自动选择合适的符号来保持图像的部分局部对比度信息, 但是这种方法依然会损失很多明显的局部对比度信息[15]. Song等[16]探讨现存方法的鲁棒性, 研究利用联合双边滤波来保持离散候选图像集合中灰度图像的多尺度对比度.为了得到比较好的彩色图像灰度化效果, 须考虑在映射彩色图像亮度信息的基础上, 尽量多地向灰度图像映射原彩色图像的颜色对比信息. Liu等[17]通过深入分析目前最为普遍的以梯度差值拟合作为准则所衍生的算法, 发现彩色图像灰度化效果依赖于图像的梯度模值, 因此提出梯度相关性相似测度模型, 并从线性参数模型中得到离散候选图像, 将求得最大梯度相关值的那个灰度图像作为最后结果.上述方法都向着更少的时间和更好的对比度保留发展, 特别是原彩色图像局部梯度的保留.本文针对目前算法计算成本高和难以保留对比度小的区域信息的特点, 提出可以使得对原图像对比度小的区域也能很好保持的最大加权函数模型.另外, 本文使用参数离散搜索策略求解, 算法计算速度较快.

局部保留投影(Locality preserving projections, LPP)近年来在人脸识别领域应用广泛[18-21]. LPP原理是将原高维的样本特征空间投影到低维特征空间, 并且降维后的特征向量能保持原高维数据空间的局部特性[22-24].本文借鉴这一思想, 将其用在彩色图像灰度化的降维过程, 使灰度化后的图像能最大程度的保留原彩色图像的局部特征及颜色对比度.本文提出了基于最大加权投影求解的彩色图像灰度化模型及算法.在好的彩色图像灰度化算法能最大地保留图像的梯度变化的假设下, 将原始图像梯度权重引入到最大化函数中, 使得原彩色图像中对比度较小的区域也能够在灰度化后图像中得到保持.并且对输入彩色图像的每个彩色通道梯度用高斯加权系数来表示, 使得变换后灰度图像可保留原彩色图像的对比度和颜色顺序.对于计算机视觉领域, 保留灰度化后的图像的对比度比颜色顺序对人眼感知效果上更重要; 另一方面保留颜色顺序在对感知信息细节要求比较高的地方也能增加图像对比度.在图像灰度化模型中, 如何快速地进行求解通道权重参数是一个重要问题.目前一些灰度化算法利用现有的优化技术, 使算法尽可能快地收敛, 并且尽量少地依赖于参数.因此, 本文模型利用参数化离散搜索策略求解, 对线性参数模型产生的候选图像进行离散搜索.该非迭代算法由于只有几步简单的算术运算, 没有参数优化, 使实时运算成为可能.

1. 彩色图像灰度化理论

本节回顾目前常采用梯度信息进行彩色图像灰度化的方法.为了保留彩色图像灰度化转换的特征显著性, 常见策略是最小化输入的彩色图像和灰度图像的像素差.假设输入的彩色图像是RGB格式, ${{\delta }_{x, y}}$ ( $\left| {{\delta}_{x, y}}\right|=\sqrt{\sum\limits_{c=\{r, g, b\}}{{{({{I}_{c, x}}-{{I}_{c, y}})}^{2}}}}$ )为具有符号值的一对彩色像素的色彩对比度, 用 $g$ 表示灰度化后的图像, ${{g}_{x}}-{{g}_{y}}$ 表示像素 ${{g}_{x}}$ 和 ${{g}_{y}}$ 的灰度差值, 比较经典的 $L_2$ 范数能量函数定义如下:

$ \begin{align} \underset{g}{\mathop{\min }}\sum\limits_{{(x, y)\in P}}{{{({{g}_{x}}-{{g}_{y}}-{{\delta }_{x, y}})}^{2}}} \end{align} $

(1) 灰度化后的图像 $g$ 可以是参数形式或者无参数形式, $P$ 表示包含局部和非局部的像素对集.

Lu等[13]提出了由两个高斯函数组成的双模式对比度保留模型, 其目标函数如下:

$ \begin{align} \underset{g}{\mathop{\min }}&-\sum\limits_{{(x, y)\in P}} \ln \{{{\alpha }_{x, y}}{{N}_{\sigma }}({{g}_{x}}-{{g}_{y}}+{{\delta }_{x, y}})+ \notag\\ & (1-{{\alpha }_{x, y}}){{N}_{\sigma }}({{g}_{x}}-{{g}_{y}}-{{\delta }_{x, y}})\} \end{align} $

(2) 其中, ${{N}_{\sigma}}(\cdot)$ 表示高斯分布, 表示弱彩色排序参数.上式通过双高斯模型构建像素对之间的误差能量函数来保持原始图像的对比度信息. Lu等[15]提出由有限多变量多项式函数构成的映射函数 $g$ , 即令 $g=\sum\limits_{{{{m}_{l}}\in Z}}{{{w}_{l}}{{m}_{l}}}$ , 并使用二阶多变量多项式函数集.因得到如下的参数优化模型:

$ \begin{align} & \underset{{{w}_{l}}}{\mathop{\min }}\,-\sum\limits_{\left( x,y \right)\in P}{\ln }\{{{\alpha }_{x,y}}{{N}_{\sigma }}\left( \sum\limits_{{{m}_{l}}\in Z}{{{w}_{l}}\left( {{m}_{lx}}-{{m}_{ly}} \right)+{{\delta }_{x,y}}} \right)+ \\ & \left( 1-{{\alpha }_{x,y}} \right){{N}_{\sigma }}\left( \sum\limits_{{{m}_{l}}\in Z}{{{w}_{l}}\left( {{m}_{lx}}-{{m}_{ly}} \right)-{{\delta }_{x,y}}} \right)\} \\ \end{align} $

(3) 由于映射函数是由权重 $\left\{ {{w}_{l}} \right\}$ 唯一确定, 因此寻找灰度图像函数 $g$ 变成了最小化目标函数(3) 关于未知权重 $\left\{ {{w}_{l}} \right\}$ 的优化问题.式(2) 和(3) 本质上是考虑相邻像素对之间的差异.这种方法虽然能够整体上较好地保持原始图像的全局对比度信息的局部, 但彩色图像灰度化效果依赖于图像的梯度模值, 会导致局部色彩对比度信息损失.

鉴于实时性的考虑, Lu等[4]进一步提出了对权重 $\left\{ {{w}_{l}} \right\}$ 进行离散搜索, 寻找最优解的策略.即

$ \begin{align} \underset{g}{\mathop{\min }} -&\sum\limits_{{(x, y)\in P}}\ln \{ {{N}_{\sigma }}({{g}_{x}}-{{g}_{y}}+{{\delta }_{x, y}})+\notag\\ &{{N}_{\sigma }}({{g}_{x}}-{{g}_{y}}-{{\delta }_{x, y}})\} \end{align} $

(4) 式(4) 是式(2) 的松弛形式, 从式(4) 中可以看出, 算法最后选取梯度误差测量值最小时所对应的灰度图像.由于认识到权重微小的变化不会使灰度图像改变太多, 他们使用离散搜索策略近似求式(4) 的最小解.通过缩减求解空间, 并在由66个候选集组成的离散范围内搜索可能的最优解.该策略很大程度上减少候选值集合并且节约算法的运行时间.

2. 最大加权投影求解算法

2.1 局部保留投影模型(LPP)

He等[25]提出了局部保持投影算法, 算法的主要思想为:通过降维使原始空间中相互离得近的点在低维空间中仍然保持较近的距离, 以此保留原始数据的局部结构. LPP算法是一种能将高维数据投影到低维空间上的非线性降维方法, 能使降维后的数据较好地保持数据原有的流型结构.该算法假设每一个数据点与它的邻近数据点位于流型的一个线性或者近似线性的区域内, 再将高维数据的全局非线性转换为局部线性, 而相互重叠的局部邻域便能提供全局结构信息.其具体算法如下:

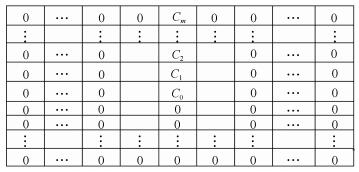

假设高维空间 ${{ R}^{n}}$ 中存在数据点集, 在低维空间中寻找一组对应点, 使得 ${{y}_{i}}$ 在某种意义上可以很好地表示. LPP目的在于通过一个转换矩阵, 把高维空间样本 ${{ R}^{n}}$ 中的样本数据集 $X$ 映射到低维空间中, 以实现对高维彩色图像三个通道数据的降维, 得到一维的灰度图像数据空间.

$ \begin{align} Y={{W}^{\rm T}}X\in {{ R}^{d}} \end{align} $

(5) 高维数据 ${{x}_{i}}$ 经过投影后得到低维空间中对应的点 ${{y}_{i}}$ . LPP中, 相似度权重矩阵 ${{S}_{i, j}}$ 表示两个样本点 ${{x}_{i}}$ 和 ${{x}_{j}}$ 的局部结构相似度, 采用 $K$ 邻近法来定义:

$ \begin{align} {{S}_{ij}}=\left\{\!\!\begin{array}{ll} \exp \left(\dfrac{ {-\left\| x_i-x_j \right\|}^{2}}{t} \right), &\mbox{若}\ x_j\in N_k\left( x_i \right) \\ 0, &\mbox{其他} \\ \end{array} \right. \end{align} $

(6) 其中, ${{x}_{i}}$ 在 ${{x}_{j}}$ 的 $K$ 邻近邻域中, 或者 ${{x}_{j}}$ 在 ${{x}_{i}}$ 的 $K$ 邻近邻域中, 式中 $t$ 是一个大于0的常量, 作为一个经验值.因此, LPP的目标函数为

$ \begin{align} & {{F}_{\text{LPP}}}=\sum\limits_{i=1}^{N}{\sum\limits_{j=1}^{N}{{{\left\| {{y}_{i}}-{{y}_{j}} \right\|}^{2}}{{s}_{ij}}}}=\sum\limits_{i=1}^{N}{\sum\limits_{{{x}_{j}}\in {{N}_{K}}\left( {{x}_{i}} \right)}{}}{{\left\| {{W}^{\text{T}}}{{x}_{i}}-{{W}^{\text{T}}}{{x}_{j}} \right\|}^{2}}{{s}_{ij}}= \\ & {{\sum\limits_{i=1}^{N}{\sum\limits_{{{x}_{j}}\in {{N}_{K}}\left( {{x}_{i}} \right)}{\left\| {{W}^{\text{T}}}{{x}_{i}}-{{W}^{\text{T}}}{{x}_{j}} \right\|}}}^{2}}\exp \left( -\frac{{{\left\| {{x}_{i}}-{{x}_{j}} \right\|}^{2}}}{t} \right) \\ \end{align} $

(7) 其中, ${{x}_{i}}$ 和 ${{x}_{j}}$ 是接近的, 最小化 ${{F}_{LPP}}$ 是为了保证 ${{y}_{i}}$ 和 ${{y}_{j}}$ 也是接近的, 相似度系数矩阵 ${{S}_{i, j}}$ 值的范围是.如果 ${{S}_{i, j}}$ 趋近于1, 则表示 ${{x}_{i}}$ 和 ${{x}_{j}}$ 是接近的; 如果 ${{S}_{i, j}}$ 趋近于0, 则表示 ${{x}_{i}}$ 和 ${{x}_{j}}$ 是相对远离的.

2.2 最大加权投影彩色图像灰度化模型(MWPDe)

本文借鉴局部保留投影算法思想进行彩色图像灰度化, 像素点 $x$ 和 $y$ 的灰度值表示为 ${{g}_{x}}$ 和 ${{g}_{y}}$ , 其由相应的彩色像素点 ${{I}_{x}}, {{I}_{y}}$ 经过转换矩阵 $W$ 后得到转换后灰度图像的像素点 ${{g}_{x}}={{W}^{T}}{{I}_{x}}$ , ${{g}_{y}}={{W}^{T}}{{I}_{y}}$ .灰度图像梯度为.对于彩色图像(RGB格式), 每个通道的梯度图像表示为 $\mathop{\delta_{xy}}_{c=\{r, g, b\}}={I}_{c, x}-{I}_{c, y}$ .受局部保留投影算法思想的启发, 本文计算任意像素点的相似性, 最后彩色图像三个通道总的相似性为

$ \begin{align} {{S}_{x, y}}=\sum\limits_{{c=\{r, g, b\}}}{\exp \left( -\frac{{{\left( \left\| {{I}_{c, x}}-{{I}_{c, y}} \right\| \right)}^{2}}}{t} \right)} \end{align} $

(8) 本文分别对彩色图像三个通道内任意像素求相似系数值, 三个通道的相似系数值之和为.最大加权投影模型计算每个通道的相似度系数而不是一次性计算整个彩色图像的相似度系数, 则最大加权投影模型目标函数如下:

$ \begin{align} & \max \sum\limits_{\left( {{I}_{x}},{{I}_{y}}\in P \right)}{{{\left\| {{g}_{x}}-{{g}_{y}} \right\|}^{2}}{{S}_{x,y}}}=\ \ \\ & \max \sum\limits_{\left( {{I}_{x}},{{I}_{y}}\in P \right)}{{{\left\| {{g}_{x}}-{{g}_{y}} \right\|}^{2}}\sum\limits_{c=\{r,g,b\}}{\exp \left( -\frac{{{\left( \left\| {{I}_{c,x}}-{{I}_{c,y}} \right\| \right)}^{2}}}{t} \right)}} \\ & \ \text{s}\text{.t}\text{.g=}\sum\limits_{\text{c=}\{\text{r},\text{g},\text{b}\}}{{{\text{w}}_{\text{c}}}{{\text{I}}_{\text{c}}}};\sum\limits_{\text{c=}\{\text{r},\text{g},\text{b}\}}{{{\text{w}}_{\text{c}}}}\text{=1} \\ \end{align} $

(9) 其中, ${{g}_{x}}-{{g}_{y}}$ 表示灰度图像中像素值为 ${{g}_{x}}$ 和 ${{g}_{y}}$ 的梯度, $P$ 表示包含局部和非局部候选集的像素对集合. 表示每个彩色通道图像乘以权重系数 ${{w}_{c}}$ 后求和, 得到最后的灰度化图像(此处约束 $\sum\limits_{c=\{r, g, b\}}{{{w}_{c}}}=1$ ).

局部保留投影算法思想和最大投影保持算法思想主要有两点区别.首先, LPP中样本点 ${{x}_{i}}$ 在 ${{x}_{j}}$ 的 $K$ 最近邻域内则有相似度系数矩阵 ${{S}_{ij}}$ , 其为, 而当 ${{x}_{i}}$ 不在 ${{x}_{j}}$ 的 $K$ 最近邻域中时, 相似权重矩阵 ${{S}_{ij}}$ 则为0.而最大投影保持算法中, 在整个通道所有像素对的相似度系数表示为, ${{x}_{i}}$ 则不一定限制在 ${{x}_{j}}$ 的 $K$ 最近邻域范围内.其次, LPP是最小化目标函数来保证降维后的 ${{y}_{i}}$ 与 ${{y}_{j}}$ 相似度最小.然而, 最大投影保持算法则是最大化目标函数, 其目的是使原图像对比度小的区域也能很好保持.本质思想是用每个通道的梯度作为先验引导, 计算原彩色图像的相似度系数矩阵 ${{S}_{ij}}$ , 同时相似度系数矩阵 ${{S}_{ij}}$ 和 $t$ 的取值也有很大相关性.如图 2所示指数变换图, 若 $t$ 固定时, 相似度矩阵 ${{S}_{x, y}}$ 取决于每个通道彩色图像任意两个像素点之间梯度.假如彩色图像中的像素点 ${{I}_{c, x}}$ 和 ${{I}_{c, y}}$ 比较接近, ${{\delta }_{xy}}$ 值小, 则相似度系数 ${{S}_{x, y}}$ 值大, 即当 $t$ 固定时其相似度系数 $ {{S}_{x, y}}$ 趋近于1.由于求解的是目标函数的最大化, 相似度系数 ${{S}_{x, y}}$ 大, 则迫使灰度图像梯度的 $\nabla g={{g}_{x}}-{{g}_{y}}$ 的变化的动力越大, 也就是说灰度图像像素点 ${{g}_{x}}$ 和 ${{g}_{y}}$ 的梯度值 $\nabla g$ 变化程度相对更大.因此, 所提算法引入的加权函数可以使得对原彩色图像对比度小的区域在灰度化后的图像中对比度大或者得到保持.此外, 假如彩色图像中的像素点和 ${{I}_{c, y}}$ 相距比较远时, 则 ${{\delta }_{xy}}$ 值大, 当 $t$ 固定时, 则两者之间的相似度系数 ${{S}_{x, y}}$ 趋近于0, 由于整个目标函数最大化, 迫使 $\nabla g={{g}_{x}}-{{g}_{y}}$ 的值变化的动力相对较小, 结果使得灰度图像像素点 ${{g}_{x}}$ 和 ${{g}_{y}}$ 的梯度值 $\nabla g$ 的变化程度相对较小.可以发现, 灰度化后图像梯度值 $\nabla g$ 变化趋势和原彩色图像梯度值的变化趋势相反, 从而使原来对比度小的像素对区域在整个目标函数中优化的比重更大, 期望达到对其更好体现的目的.

2.3 离散搜索求解

为了使算法具有更好的实时性, 和文献[14]类似, 本文将连续的参数优化问题转化为将用离散的参数空间搜索的方式估计灰度图像.首先, 因为系数的变化对结果的影响不是特别大, 我们将搜索空间缩小, 三个彩色通道的权重系数为 ${{w}_{r}}, {{w}_{g}}, {{w}_{b}}$ , 分别在的空间范围内以0.1的间距分成10等份并且约束三个颜色通道各权重和为1, 将整个空间划分成个搜索状态, 并在66候选集组成的离散范围内搜索可能的最优解.其次, 像素对集合 $P$ 也是影响算法有效性的关键.本质上, $P$ 越大算法实现的性能越好, 但相应的计算时间也增加.考虑到自然图像固有的颜色冗余, Lu等下采样输入的高分辨率图像, 使图像变为 $64\times 64$ 大小.在缩小后的图像中随机的采样 ${{64}^{2}}$ 的像素对, 形成像素对集合 $P$ (本文删除小于0.07像素值).本文采取下采样方案提高算法运算速度.因此本文用有限的候选集和在目标函数最大化下选取权重参数估计模型(9).整个算法求解如下:

最大加权投影算法(MWPDe)

1) 穷举搜索离散66个权重候选集;

2) 当 $j=1$ 到66时, 进行以下循环;

3) 搜索权重 $w$ 计算式(9);

4) 结束.

为了定量衡量灰度化算法的对比度保留效果, 使用彩色对比度增强保持率(Color contrast preserving ratio, CCPR)作为评价指标[15]. CCPR定义如下:

$ \begin{align} {\rm CCPR}=\frac{\#\{(x, y)|(x, y)\in \Omega, \left| {{g}_{x}}-{{g}_{y}} \right|\ge \tau \}}{\left\| \Omega \right\|}\; \end{align} $

(10) 其中, $\Omega $ 是其原始彩色图像梯度 ${{\delta }_{x, y}}\ge \tau $ 的集合. 是集合 $\Omega $ 中像素对的个数. 表示集合中经过灰度化后仍然保留差异的像素对个数.从式(10) 可以看出, CCPR值在0到1之间, 其值越接近1, 说明灰度化效果越好.

3. 实验结果

目前彩色图像灰度化主要有三个测试图像集.第一个为经典的Cadik图像集, 该图像集含有各种不同的图像特征和图案, 包含24幅测试图像.第二个是Du等整理收集复杂场景的CSDD图像集, 由22幅颜色分布较复杂的图像组成.最后一个是Lu等提出的COLOR250测试图像集, 包括从Berkeley图像分割BSDS测试库和显著性SD测试库中选出的200幅自然图像以及在文档打印中经常用到的50幅与曲线图表等有关的图像.这三个图像集涵盖了简单仿真、自然场景等各种复杂图像.我们采用人员参与的主观评价和定量分析的客观评价对本文算法的灰度化效果进行分析.

本节在各种合成的自然图像集中, 对所提出来MWPDe算法与基本的Gooch算法[4]; rgb2gray算法; Lu等提出的二阶对比度保留算法(CP)[13]及实时的对比度保留算法(RTCP)[14]对比. MWPDe中参数 $t$ 设为经验值0.01.

3.1 基于Cadik数据集的对比

Cadik数据集图像相对简单并且包含的颜色信息量少.本节对Cadik数据集用Gooch、rgb2gray、CP、RTCP和MWPD五种算法进行测试, $\tau $ 取值范围均为从1到15.从表 1可以看出MWPDe算法得到的灰度图像CCPR值比rgb2gray、CP、RTCP算法的CCPR值大, 并且随着 $\tau $ 的增大, MWPDe算法得到的灰度图像CCPR值比比较算法的优势越来越明显.从图 3观察可知本文算法不仅能够很好地保留细节特征, 也能使彩色图像的特征在灰度化后的图像中仍能辨别, 仍有很好的颜色排序保留效果. CP和RTCP算法灰度化后的图像颜色对比度相当, 而如图 3(b)和(c)列Gooch算法和rgb2gray算法灰度化后的图像颜色细节特征保留少, 对比度保留差. RTCP算法尽管也是使用离散搜索求解, 但也丢失部分对比度信息.可以对比看到本文MWPDe算法在颜色特征显著的地方, 对比度保留效果较好, 如图 3中第2、7、8行:第2行中能明显地看出天蓝色和绿色的区别; 第7行MWPDe算法相比Gooch、rgb2gray、CP算法能较好地保留青提上同一颜色之间的细节对比度, 而无法区分灰度化后绿色的青提和黄色的梨; 第8行中能保留绿色叶子和红色叶子的对比度.这些示例说明MWPDe算法能较好地保留原彩色图像中对比度小区域的对比度.

表 1 Cadik数据集的CCPR值Table 1 CCPR value of Cadik datasetτ Gooch rgb2gray CP RTCP MWPDe 1 0.96 0.93 0.97 0.96 0.96 2 0.93 0.88 0.94 0.94 0.94 3 0.91 0.84 0.92 0.92 0.92 4 0.89 0.8 0.91 0.9 0.91 5 0.87 0.77 0.89 0.89 0.9 6 0.85 0.75 0.87 0.87 0.88 7 0.83 0.73 0.86 0.86 0.87 8 0.81 0.71 0.84 0.85 0.86 9 0.79 0.69 0.83 0.83 0.85 10 0.77 0.68 0.82 0.82 0.84 11 0.75 0.66 0.8 0.8 0.84 12 0.72 0.65 0.79 0.79 0.83 13 0.7 0.63 0.77 0.77 0.82 14 0.69 0.62 0.76 0.76 0.81 15 0.67 0.61 0.75 0.75 0.81 3.2 基于CSDD数据集的对比

相比于Cadik数据集图像相对简单且包含的颜色信息量少, CSDD数据集图像包含更为丰富的颜色和图案信息.本节, 在CSDD数据集上对Gooch、rgb2gray、CP、RTCP和MWPDe五种算法进行测试, $\tau $ 取值范围均为从1到15.从表 2可以看出 $\tau $ 取值大于5时, MWPDe算法得到的灰度图像的CCPR值比Gooch、rgb2gray、CP、RTCP算法的CCPR值大, 但MWPDe算法相比于RTCP算法等方法的优势没有像在表 1中对于Cadik数据那么大.对大部分测试图, 如第二行红色箭头所指部分MWPDe算法效果的对比度比较明显, 另外四种算法则不能区分该区域的颜色顺序和局部的对比度. MWPDe算法对于第3、4、5行的灰度化效果相比于Gooch、rgb2gray、CP、RTCP算法效果较好, 能将颜色信息映射到对比度更明显灰度值上, 有较好的视觉效果.但也有少部分图像如第一行中红色箭头所指部分, MWPDe算法丢失了局部对比度, 而其他三种算法的视觉效果都相对较好.从图 4可以看出对于CSDD数据集场景下的复杂图像, 图像灰度化的难度更大, 可以在以后的研究中进一步分析改进MWPDe算法.

表 2 CSDD数据集的CCPR值Table 2 CCPR value of CSDD datasetτ Gooch rgb2gray CP RTCP MWPDe 1 0.97 0.96 0.96 0.96 0.95 2 0.93 0.94 0.93 0.93 0.92 3 0.91 0.91 0.91 0.91 0.91 4 0.89 0.89 0.89 0.9 0.89 5 0.87 0.87 0.87 0.88 0.88 6 0.85 0.85 0.85 0.87 0.86 7 0.83 0.83 0.83 0.85 0.85 8 0.81 0.81 0.81 0.84 0.84 9 0.79 0.8 0.79 0.82 0.83 10 0.77 0.78 0.77 0.81 0.82 11 0.76 0.76 0.75 0.8 0.81 12 0.74 0.75 0.74 0.78 0.8 13 0.73 0.73 0.72 0.77 0.79 14 0.71 0.71 0.7 0.76 0.78 15 0.7 0.68 0.7 0.75 0.77 3.3 基于COLOR250数据集的对比

本节使用COLOR250数据集进行实验.这个更大的数据集图像包括突出的检测数据集以及其他场景下的图像.这些图像包含很多的重要结构特征如大规模的边缘、平滑区域和细小的纹理等.在没有噪声的环境下, Gooch、rgb2gray、CP、RTCP和MWPDe五种算法对COLOR250数据集的灰度化结果的CCPR值如表 3所示, 可以看出当 $\tau$ 值大于6时MWPDe算法的CCPR值比其他四种算法高.图 5可以看出rgb2gray算法灰度化效果比较稳定, 缺乏局部和全局的对比度, 如第一行其将同一亮度但不同颜色的红色和绿色映射为接近的灰度值, 使得灰度化后很难区分两种颜色.本文MWPDe算法能较好地保留颜色对比度, 比如红色的花朵和绿色的草地, RTCP和本文MWPDe算法灰度化后的图像对比度比较明显.

表 3 COLOR250数据集的CCPR值Table 3 CCPR value of COLOR250τ Gooch rgb2gray CP RTCP MWPDe 1 0.95 0.96 0.96 0.96 0.95 2 0.92 0.93 0.93 0.93 0.92 3 0.89 0.9 0.9 0.9 0.9 4 0.86 0.87 0.88 0.88 0.88 5 0.83 0.85 0.86 0.86 0.86 6 0.81 0.83 0.84 0.84 0.85 7 0.79 0.81 0.82 0.83 0.83 8 0.76 0.79 0.8 0.81 0.82 9 0.74 0.77 0.79 0.8 0.81 10 0.72 0.75 0.77 0.78 0.8 11 0.7 0.74 0.76 0.77 0.79 12 0.68 0.72 0.74 0.76 0.78 13 0.67 0.7 0.73 0.75 0.77 14 0.65 0.69 0.72 0.74 0.76 15 0.63 0.67 0.7 0.72 0.75 3.4 用户主观对比

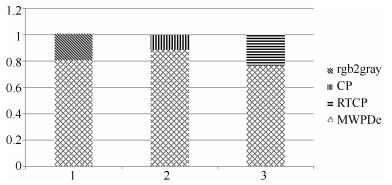

为了验证本文提出的MWPDe算法灰度化效果, 本节进行用户主观对比实验.借鉴文献[26]中的实验模式, 使用Cadik图像集的24幅图像, 进行用户选择性实验和准确性实验, 并且和rgb2gray、CP、RTCP算法对比.我们邀请50位年龄在20到40岁之间的参与者, 他们没有视觉缺陷并且从事不同行业.

用户主观对比实验由两部分组成:选择性实验和准确性实验.首先, 选择性实验按如下流程进行:在没有彩色图像作为参考的情况下, 每位参与者每次从2幅灰度图像中选择他们认为相对较好的(一幅是本文算法得到的灰度图像, 另一幅是随机地从另外三种方法得到的结果图).其次, 准确性实验按如下流程进行:在有彩色图像作为参考的情况下, 观察者每次在rgb2gray、CP、RTCP和MWPDe四种算法得到的灰度图像中选择最能表示原始彩色图像的一幅.一般地, 准确性实验(带参考图像)相对于选择性实验(无参考图像)耗时间比较长.用户主观对比实验统计结果如图 6和图 7所示, 从选择性实验和准确性实验来看, 提出的MWPDe算法效果相对于另外三种方法要好.从选择性实验看, 参与者对本文算法的灰度化效果有较优先的选择, 可以看到本文的算法得到的灰度化效果相对其他三种算法有较好的视觉效果, 反映出所提的算法更接近人眼视觉感知.

3.5 鲁棒性分析

本节对提出算法在有噪声情形下的灰度化效果进行分析.所有的算法中输入带均值为0, 方差为0.03的高斯噪声的图像.采用Cadik图像集进行抗噪性实验分析, 取值从1到15时各算法所得图像的CCPR值如表 4所示.可以看出RTCP和MWPDe算法的灰度化效果更好, 说明这两种方法具有良好的抗噪性能.当 $\tau $ 值从5到15, RTCP和MWPDe算法的抗噪性能相当, 原因可能是二者都采用了离散搜索策略求解.图 8是部分彩色图像经过灰度化后的结果, 可以发现本文算法得到的灰度图像视觉效果更好. CP算法的抗噪性最差, CP算法灰度化后的图像都残留有严重噪声.

表 4 噪声情况下Cadik数据集的CCPR值Table 4 CCPR value of Cadik dataset with noise addedτ rgb2gray CP RTCP MWPDe 1 0.92 0.95 0.94 0.96 2 0.86 0.91 0.91 0.92 3 0.82 0.87 0.88 0.89 4 0.78 0.84 0.85 0.86 5 0.74 0.82 0.84 0.84 6 0.72 0.79 0.82 0.82 7 0.7 0.77 0.81 0.81 8 0.68 0.75 0.8 0.79 9 0.66 0.73 0.78 0.78 10 0.65 0.71 0.77 0.77 11 0.63 0.7 0.76 0.76 12 0.62 0.68 0.75 0.75 13 0.61 0.66 0.74 0.74 14 0.6 0.65 0.73 0.74 15 0.58 0.64 0.72 0.73 除分析噪声对算法的影响, 我们也分析WMPDe算法对低分辨率图像的灰度化效果.我们用Cadik图像集进行低分辨率实验分析, 将Cadik图像集中的测试图像下采样2个因子, 其他的参数设置不变, 对算法进行实验.图 9是部分彩色图像经过降采样变成低分辨率图像后灰度化的结果, 可以发现相比于另外三种对比算法, 本文WMPDe算法也能较好地保持原彩色图像的对比度, 得到的灰度图像视觉效果更好.

由式(9) 可知, WMPDe算法只有一个参数 $t$ . $t$ 值变化引起权重函数 ${{S}_{x, y}}(t)$ 的变化, 本节测试 $t$ 值变化对图像灰度化效果的影响.如图 10(a)为 $t$ 值分别为0.01和0.00001时的相似度权重系数 ${{S}_{x, y}}(t)$ 随 $t$ 的变化, 当 $t$ 值小时, ${{S}_{x, y}}(t)$ 的变化相对比较陡峭. (b)列为输入的彩色图像, (c)列为 $t=0.01$ 时输入彩色图像的灰度化效果; (d)列为 $t=0.00001$ 时输入彩色图像的灰度化效果.对比(c)和(d)列可以得到第一幅蝴蝶在 $t=0.01$ 时边缘处对比度比较明显, 线条处的纹理信息基本丢失, 而 $t=0.00001$ 效果却相反, 边缘处对比度信息丢失, 线条处纹理信息明显, 说明 $t$ 值小时对原彩色图像对比度小的区域能有较好地保留对比度.第二幅轮子在 $t=0.01$ 时灰度化效果基本没有区分度, $t=0.00001$ 时保留了原彩色图像的亮度对比度, 能相对缓解(c)列中的不足.第三幅在 $t=0.01$ 时灰度化效果能较好地将叶子和花瓣颜色区分, 而无法区分花瓣中的颜色对比度, 在 $t=0.00001$ 保留了花瓣的颜色对比度, 但无法区分红色的花瓣和绿色的叶子.由这些现象可以看出当 $t$ 值小时且原彩色图像对比度不明显时, 即颜色有过渡处的相似系数 ${{S}_{x, y}}(t)$ 变化较大, 由于本文求解的目标函数最大化, ${{S}_{x, y}}(t)$ 则会引导灰度化后的图像在相应的区域保留相应的细节对比度, 实现局部对比度保留.

3.6 计算复杂度分析

好的彩色图像灰度化算法不仅要求灰度化后图像仍能保持原图像的对比度, 并且要求计算速度快.目前RTCP算法的计算时间最为实时, 其计算过程包括矩阵的点乘、指数和对数的计算. WMPDe算法求解过程借鉴其思想, 只需要5个矩阵点乘的计算过程, 使得其计算过程比其他的算法甚至RTCP都简洁和实时, 并且灰度化后的图像能保持原彩色图像的颜色对比度.表 5为输入 $390\times 293$ 彩色图像时不同算法的运行时间, 可以看到WMPDe算法计算时间比CP算法, RTCP算法的时间短, Gooch算法的运算时间最长, 原因是该算法需要将彩色图像从RGB颜色空间转换到Lab颜色空间, 这个空间转换的过程会增加算法的处理时间. rgb2gray算法的计算时间最短, 这也是该算法至今相对较流行的原因.总的来看, WMPDe算法的速度接近当前RTCP算法的两倍.

表 5 输入390×293彩色图像时不同算法的运行时间Table 5 Runtime of different algorithms with the input 390×293 color imageMethods Gooch rgb2gray CP RTCP MWPDe Runtime (s) 3.00E+04 0.0048 0.5233 0.0728 0.0343 4. 结论

本文提出基于加权投影最大化的彩色图像灰度化模型及算法.针对目前其他灰度化算法不能较好地保留图像纹理色差及局部对比度的缺点, 借鉴目前模式识别领域中局部保留投影思想, 建立最大化的加权局部保留投影模型.该模型提出最大加权投影的目标优化函数, 并且将原始图像梯度的权重引入到最大化函数中, 使得原彩色图像中对比度比较小的区域在灰度化后也能得到较好地保留.并且对输入彩色图像的每个彩色通道梯度用高斯加权系数表示, 使得变换后灰度图像可保留原彩色图像的对比度和颜色顺序.进一步地, 对所提模型使用参数离散搜索方法求解, 通过对线性参数模型产生的候选图像进行离散搜索, 计算过程只需要几个算术运算, 计算速度较快.从对Cadik、CSDD和COLOR250数据集的定性和定量实验可以看出, WMPDe算法相比于其他算法能较好地保留颜色对比度, 并且具有对噪声鲁棒和计算实时的优势.

-

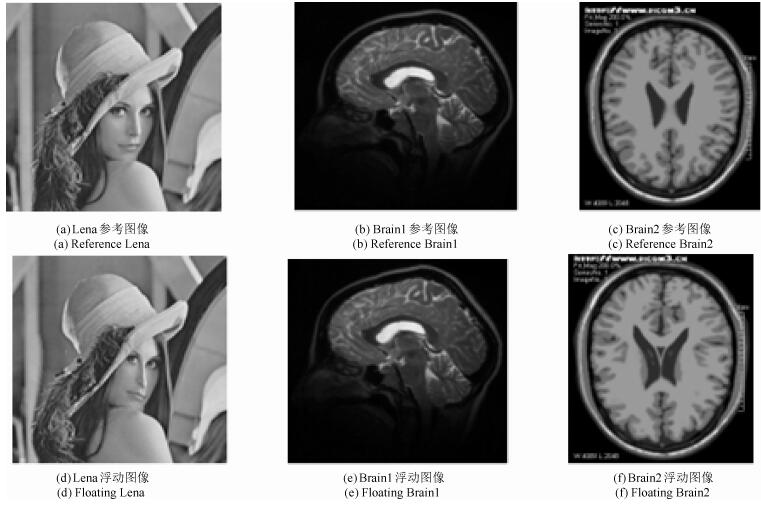

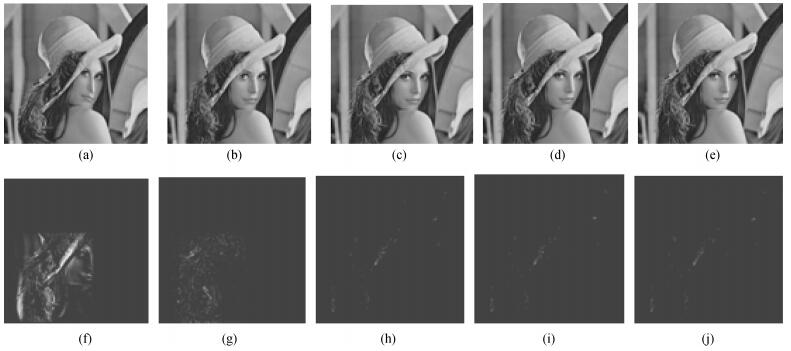

图 5 Lena图像实验(第一行为浮动图像和配准后图像, 第二行为差值图像. (a)为浮动图像, (b) $\sim$ (e)为配准后的图像; (b) TV-L$^{1}$方法; (c)本文方法($\alpha=1.2, k=1$); (d)本文方法($\alpha=1.2, k=2$); (e)本文方法($\alpha=1.2, k=3$); (f) $\sim$ (j)分别为第一行图像与参考图像(图 4(a))的差值图像)

Fig. 5 Lena image (The first line is floating image and registered image, the second line is difference image. (a) Floating image, (b) $\sim$ (e) are registered images, (b) TV-L$^{1}$, (c) Our method ($\alpha=1.2, k=1$), (d) Our method ($\alpha=1.2, k=2$), (e) Our method ($\alpha=1.2, k=3$), (f) $\sim$ (j) are difference images)

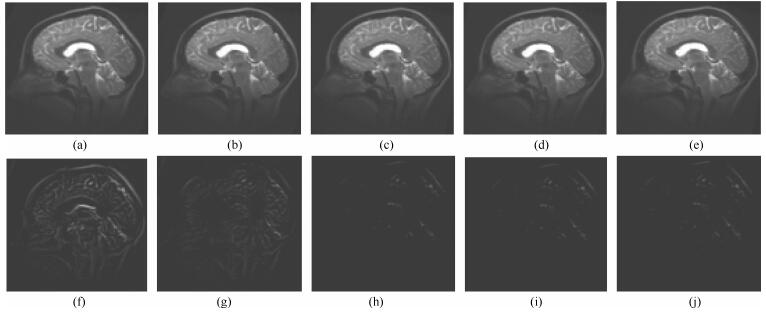

图 7 Brain1图像实验(第一行为浮动图像和配准后图像, 第二行为差值图像. (a)为浮动图像, (b) $\sim$ (e)为配准后的图像; (b) TV-L$^{1}$方法; (c)本文方法($\alpha=1.3, k=1$); (d)本文方法($\alpha=1.3, k=2$); (e)本文方法($\alpha=1.3, k=3$); (f) $\sim$ (j)分别为第一行图像与参考图像(图 4(b))的差值图像)

Fig. 7 Brain1 image (The first line is floating image and registered image, the second line is difference image. (a) Floating image, (b) $\sim$ (e) are registered images, (b) TV-L$^{1}$, (c) Our method ($\alpha=1.3, k=1$), (d) Our method ($\alpha=1.3, k=2$), (e) Our method ($\alpha=1.3, k=3$), (f) $\sim$ (j) are difference images)

图 8 Brain2图像实验(第一行为浮动图像和配准后图像, 第二行为差分图像. (a)为浮动图像, (b) $\sim$ (e)为配准后的图像; (b) TV-L$^{1}$方法; (c)本文方法($\alpha=1.3$, $k=1$); (d)本文方法($\alpha=1.3$, $k=2$); (e)本文方法($\alpha=1.3$, $k=3$); (f) $\sim$ (j)分别为第一行图像与参考图像(图 4(c))的差值图像)

Fig. 8 Brain2 image. The first line is floating image and registered image, the second line is difference image ((a) floating image, (b) $\sim$ (e) are registered images, (b) TV-L$^{1}$, (c) Our method ($\alpha=1.3$, $k=1$), (d) Our method ($\alpha=1.3$, $k=2$), (e) Our method ($\alpha=1.3$, $k=3$), (f) $\sim$ (j) are difference images)

表 1 参考图像和配准图像的均方误差(MSE)

Table 1 Mean square error (MSE) of reference image and registered

输入图片 配准前 TV-L $^{1}$ 本文算法($k$ = 1) 本文算法($k$ = 2) 本文算法($k$ = 3) Lena ($\alpha$ = 1.2) 669.33 14.86 10.36 9.17 11.56 Brain1 ($\alpha$ = 1.3) 295.85 27.51 18.20 15.93 20.22 Brain2 ($\alpha$ = 1.3) 813.77 31.02 11.47 9.95 17.89 表 2 峰值信噪比(PSNR)

Table 2 Peak signal to noise ratio (PSNR)

输入图片 配准前 TV-L $^{1}$ 本文算法($k$ = 1) 本文算法($k$ = 2) 本文算法($k$ = 3) Lena ($\alpha$ = 1.2) 19.32 35.55 38.18 38.88 37.50 Brain1 ($\alpha$ = 1.3) 22.78 33.73 35.34 36.17 34.89 Brain2 ($\alpha$ = 1.3) 19.03 31.21 37.73 38.15 35.60 -

[1] 蒲亦非, 王卫星.数字图像的分数阶微分掩模及其数值运算规则.自动化学报, 2007, 33(11):1128-1135 http://www.aas.net.cn/CN/abstract/abstract13448.shtmlPu Yi-Fei, Wang Wei-Xing. Fractional differential masks of digital image and their numerical implementation algorithms. Acta Automatica Sinica, 2007, 33(11):1128-1135 http://www.aas.net.cn/CN/abstract/abstract13448.shtml [2] 陈青, 刘金平, 唐朝晖, 李建奇, 吴敏.基于分数阶微分的图像边缘细节检测与提取.电子学报, 2013, 41(10):1873-1880 doi: 10.3969/j.issn.0372-2112.2013.10.001Chen Qing, Liu Jin-Ping, Tang Zhao-Hui, Li Jian-Qi, Wu Min. Detection and extraction of image edge curves and detailed features using fractional differentiation. Acta Electronica Sinica, 2013, 41(10):1873-1880 doi: 10.3969/j.issn.0372-2112.2013.10.001 [3] Pu Y F, Siarry P, Zhou J L, Liu Y G, Zhang N, Huang G, Liu Y Z. Fractional partial differential equation denoising models for texture image. Science China Information Sciences, 2014, 57(7):1-19 doi: 10.1007/s11432-014-5112-x [4] Liu J, Chen S C, Tan X Y. Fractional order singular value decomposition representation for face recognition. Pattern Recognition, 2008, 41(1):378-395 doi: 10.1016/j.patcog.2007.03.027 [5] Zhang Y, Pu Y F, Hu J R, Zhou J L. A class of fractional-order variational image inpainting models. Applied Mathematics and Information Sciences, 2012, 6(2):299-306 http://www.researchgate.net/publication/260210952_A_Class_of_Fractional-Order_Variational_Image_Inpainting_Models [6] Ren Z M. Adaptive active contour model driven by fractional order fitting energy. Signal Processing, 2015, 117:138-150 doi: 10.1016/j.sigpro.2015.05.009 [7] 薛鹏, 杨佩, 曹祝楼, 贾大宇, 董恩清.基于平衡系数的Active Demons非刚性配准算法.自动化学报, 2016, 42(9):1389-1400 http://www.aas.net.cn/CN/abstract/abstract18927.shtmlXue Peng, Yang Pei, Cao Zhu-Lou, Jia Da-Yu, Dong En-Qing. Active demons non-rigid registration algorithm based on balance coefficient. Acta Automatica Sinica, 2016, 42(9):1389-1400 http://www.aas.net.cn/CN/abstract/abstract18927.shtml [8] 张桂梅, 曹红洋, 储珺, 曾接贤.基于Nyström低阶近似和谱特征的图像非刚性配准.自动化学报, 2015, 41(2):429-438 http://www.aas.net.cn/CN/abstract/abstract18621.shtmlZhang Gui-Mei, Cao Hong-Yang, Chu Jun, Zeng Jie-Xian. Non-rigid image registration based on low-rank Nyström approximation and spectral feature. Acta Automatica Sinica, 2015, 41(2):429-438 http://www.aas.net.cn/CN/abstract/abstract18621.shtml [9] 闫德勤, 刘彩凤, 刘胜蓝, 刘德山.大形变微分同胚图像配准快速算法.自动化学报, 2015, 41(8):1461-1470 http://www.aas.net.cn/CN/abstract/abstract18720.shtmlYan De-Qin, Liu Cai-Feng, Liu Sheng-Lan, Liu De-Shan. A fast image registration algorithm for diffeomorphic image with large deformation. Acta Automatica Sinica, 2015, 41(8):1461-1470 http://www.aas.net.cn/CN/abstract/abstract18720.shtml [10] Thirion J P. Image matching as a diffusion process:an analogy with Maxwell's demons. Medical Image Analysis, 1998, 2(3):243-260 doi: 10.1016/S1361-8415(98)80022-4 [11] Wang H, Dong L, O'Daniel J, Mohan R, Garden A A, Ang K K, Kuban D A, Bonnen M, Chang J Y, Cheung R. Validation of an accelerated 'demons' algorithm for deformable image registration in radiation therapy. Physics in Medicine and Biology, 2005, 50(12):2887-2905 doi: 10.1088/0031-9155/50/12/011 [12] Palos G, Betrouni N, Coulanges M, Vermandel M, Devlaminck V, Rousseau J. Multimodal matching by maximisation of mutual information and optical flow technique. In:Proceedings of the 26th Annual International Conference of the IEEE Engineering in Medicine and Biology Society (IEMBS). San Francisco, CA, USA:IEEE, 2004. 1679-1682 http://europepmc.org/abstract/MED/17272026 [13] Pock T, Urschler M, Zach C, Beichel R, Bischof H. A duality based algorithm for TV-L1-optical-flow image registration. Medical Image Computing and Computer-Assisted Intervention-MICCAI 2007. Berlin Heidelberg:Springer-Verlag, 2007. 511-518 [14] Pérez J S, Meinhardt-Llopis E, Facciolo G. TV-L1 optical flow estimation. Image Processing on Line, 2013, 3:137-150 doi: 10.5201/ipol [15] Yip S S F, Coroller T P, Sanford N N, Huynh E, Mamon H, Aerts H J W L, Berbeco R I. Use of registration-based contour propagation in texture analysis for esophageal cancer pathologic response prediction. Physics in Medicine and Biology, 2016, 61(2):906-922 doi: 10.1088/0031-9155/61/2/906 [16] Horn B K, Schunck B G. Determining optical flow. In:Technical Symposium East. Washington, D.C., USA:International Society for Optics and Photonics, 1981. 319-331 [17] Rudin L I, Osher S, Fatemi E. Nonlinear total variation based noise removal algorithms. Physica D:Nonlinear Phenomena, 1992, 60(1-4):259-268 doi: 10.1016/0167-2789(92)90242-F [18] Chambolle A, Pock T. A first-order primal-dual algorithm for convex problems with applications to imaging. Journal of Mathematical Imaging and Vision, 2011, 40(1):120-145 doi: 10.1007/s10851-010-0251-1 [19] Cafagna D. Fractional calculus:a mathematical tool from the past for present engineers. IEEE Industrial Electronics Magazine, 2007, 1(2):35-40 doi: 10.1109/MIE.2007.901479 期刊类型引用(13)

1. 余玲. 基于传感器网络的学生心理健康信息自动集成系统. 自动化技术与应用. 2024(11): 191-195 .  百度学术

百度学术2. 马佩勋. 一种基于线性规划松弛的无线位置匹配算法. 导航定位学报. 2022(01): 85-89 .  百度学术

百度学术3. 刘松旭,张大鹏,乌云娜,刘鹏. 基于RSSI模型的无线传感器网络定位算法. 计算机仿真. 2022(01): 427-431 .  百度学术

百度学术4. 简小女. 基于无线传感器网络的目标自动跟踪研究. 微型电脑应用. 2022(08): 137-139+158 .  百度学术

百度学术5. 江世雄,翁孙贤,车艳红,王重卿,龚建新. 基于无线传感器网络的噪声自动监测校准系统设计. 电子设计工程. 2022(17): 95-99 .  百度学术

百度学术6. 张轶,翟盛华,陶海红. 单星多波束天线下基于压缩感知的多目标干扰定位. 电子与信息学报. 2021(07): 1872-1878 .  百度学术

百度学术7. 王琦. 基于压缩感知的无线通信信息处理方法. 中国新通信. 2021(13): 9-10 .  百度学术

百度学术8. 张利军,杨波,苏俊琦,梁宇倩. 针对多目标的分布式多边融合定位. 计算机系统应用. 2021(12): 180-186 .  百度学术

百度学术9. 闫雷兵,王翠钦,牟光臣,尹川. 基于压缩感知的稀疏度自适应无源目标定位算法. 河南工学院学报. 2020(01): 20-27 .  百度学术

百度学术10. 陈烨,盛安冬,李银伢,戚国庆. 一种带波门修正的事件触发机制及其在光电探测网中的应用. 自动化学报. 2020(05): 971-985 .  本站查看

本站查看11. 吉晓香,蒋晔. 基于数据属性的无线网络空间嵌入信息提取. 计算机仿真. 2020(09): 347-351 .  百度学术

百度学术12. 张晶,曾艳,郑宏亮. 无线传感器网络在船舶通信系统中的应用. 舰船科学技术. 2020(18): 133-135 .  百度学术

百度学术13. 黄天灵. 基于视觉传达的网页文字色彩自动匹配系统设计. 现代电子技术. 2020(22): 102-105 .  百度学术

百度学术其他类型引用(12)

-

下载:

下载:

下载:

下载: