-

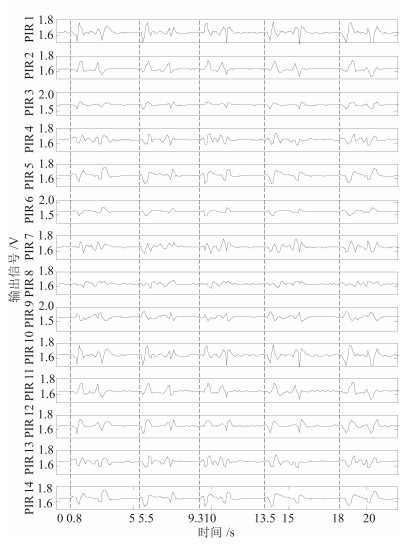

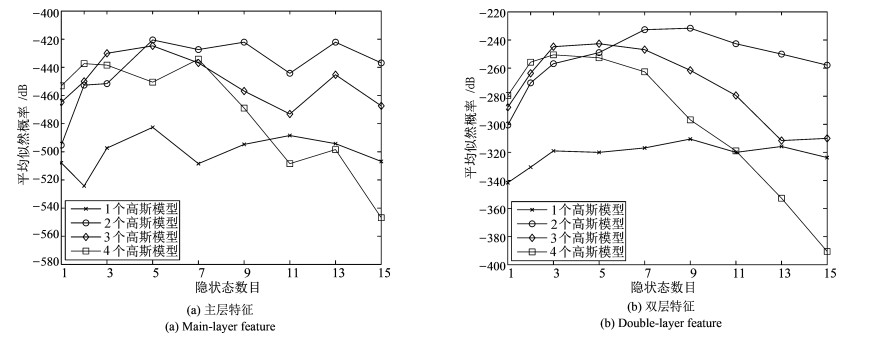

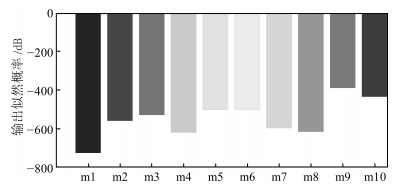

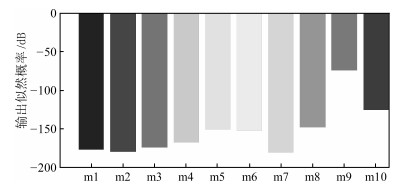

摘要: 人体动作产生的辐射能量变化(Infrared radiation changes,IRC)信号是动作识别的重要线索,本文提出了一种基于隐马尔科夫模型的人体动作压缩红外分类新方法.针对人体动作的自遮挡问题,建立基于正交视角的压缩红外测量系统,获取人体动作在主投影面和辅助投影面的IRC压缩信号;然后,采用隐马尔科夫模型(Hidden Markov model,HMM)双层特征建模算法进行压缩域动作分类.实验结果表明双层特征建模的平均正确分类率高于主层特征建模,平均正确分类率可达95.71%.该方法为环境辅助生活系统提供了人体动作识别的新途径.Abstract: Infrared radiation changes (IRC) induced by human motion can provide important clue for motion classification. This paper presents a hidden Markov model (HMM)-based compressive infrared classification method to recognize human motions. In order to solve the problem of self-occlusion, an orthogonal-view based compressive infrared sensing system is implemented for projecting the IRC to two orthogonal planes in the infrared radiation field. Then, a double-layer feature model using HMM classifier is trained to carry out motion recognition with the compressive measurements. Experimental results show that the mean correct classification rate with double-layer feature is 95.71%, which is better than that with main-layer feature. This method provides a new approach to classification of human motions for ambient assisted system.1) 本文责任编委 王启宁

-

表 1 GMHMMs参数配置

Table 1 The specification of GMHMMs

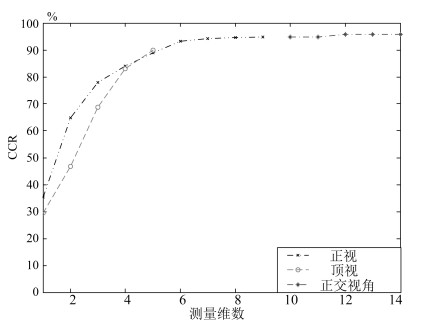

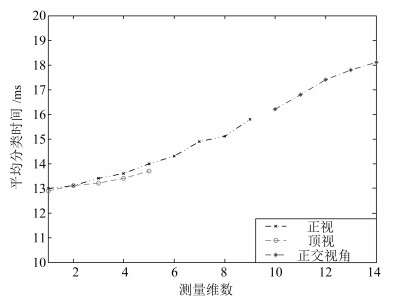

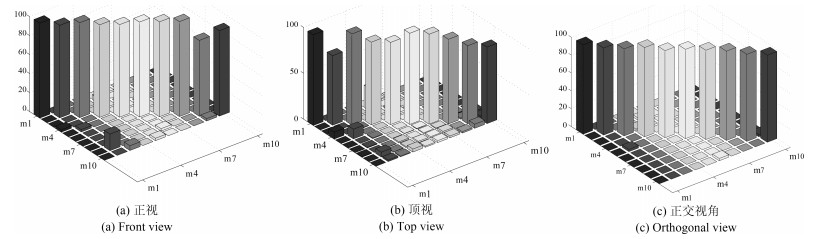

特征层模型 m1 m2 m3 m4 m5 m6 m7 m8 m9 m10 $M_G$ $H$ $M_G$ $H$ $M_G$ $H$ $M_G$ $H$ $M_G$ $H$ $M_G$ $H$ $M_G$ $H$ $M_G$ $H$ $M_G$ $H$ $M_G$ $H$ 主层GMHMM 2 5 2 7 2 9 4 3 2 7 2 6 2 5 2 3 2 5 2 6 双层GMHMM 2 9 2 4 2 5 3 3 2 8 2 5 2 4 2 4 2 3 2 5 表 2 测量视角对CCR的影响

Table 2 Sensing view vs. CCR

测量视角 正视 顶视 正交视角 CCR (%) 94.81 87.23 95.71 -

[1] Wichert R, Eberhardt B. Ambient assisted living. Advanced Technologies & Societal Change. Berlin, Germany: Springer-Verlag Berlin Heidelberg, 2012. 1145-1148 [2] Chen L M, Hoey J, Nugent C D, Cook D J, Yu Z W. Sensor-based activity recognition. IEEE Transactions on Systems, Man, and Cybernetics, Part C (Applications and Reviews), 2012, 42(6): 790-808 doi: 10.1109/TSMCC.2012.2198883 [3] Aggarwal J K, Ryoo M S. Human activity analysis: a review. ACM Computing Surveys, 2011, 43(3): 16 http://www.bibsonomy.org/bibtex/248f6b014794b15388f00a8bad140cb56/flint63 [4] Hu W M, Tan T N, Wang L, Maybank S. A survey on visual surveillance of object motion and behaviors. IEEE Transactions on Systems, Man, and Cybernetics, Part C (Applications and Reviews), 2004, 34(3): 334-352 doi: 10.1109/TSMCC.2004.829274 [5] Moeslund T B, Hilton A, Krüger V. A survey of advances in vision-based human motion capture and analysis. Computer Vision and Image Understanding, 2006, 104(2-3): 90-126 doi: 10.1016/j.cviu.2006.08.002 [6] Turaga P, Chellappa R, Subrahmanian V S, Udrea O. Machine recognition of human activities: a survey. IEEE Transactions on Circuits and Systems for Video Technology, 2008, 18(11): 1473-1488 doi: 10.1109/TCSVT.2008.2005594 [7] Johansson G. Visual perception of biological motion and a model for its analysis. Perception & Psychophysics, 1973, 14(2): 201-211 http://www.worldcat.org/title/visual-perception-of-biological-motion-and-a-model-for-its-analysis/oclc/470021412 [8] Shi G Y, Chan C S, Li W J, Leung K S, Zou Y X, Jin Y F. Mobile human airbag system for fall protection using MEMS sensors and embedded SVM classifier. IEEE Sensors Journal, 2009, 9(5): 495-503 doi: 10.1109/JSEN.2008.2012212 [9] Yang A Y, Jafari R, Sastry S S, Bajcsy R. Distributed recognition of human actions using wearable motion sensor networks. Journal of Ambient Intelligence and Smart Environments, 2009, 1(2): 103-115 [10] Burchett J, Shankar M, Hamza A B, Guenther B D, Pitsianis N, Brady D J. Lightweight biometric detection system for human classification using pyroelectric infrared detectors. Applied Optics, 2006, 45(13): 3031-3037 doi: 10.1364/AO.45.003031 [11] Candés E J, Wakin M B. Wakin. An introduction to compressive sampling. IEEE Signal Processing Magazine, 2008, 25(2): 21-30 doi: 10.1109/MSP.2007.914731 [12] Duarte D F, Eldar Y C. Structured compressed sensing: from theory to applications. IEEE Transactions on Signal Processing, 2011, 59(9): 4053-4085 doi: 10.1109/TSP.2011.2161982 [13] Brady D J, Pitsianis N P, Sun X B. Reference structure tomography. Journal of the Optical Society of America A, 2004, 21(7): 1140-1147 doi: 10.1364/JOSAA.21.001140 [14] Peng M, Xiao Y. A survey of reference structure for sensor systems. IEEE Communications Surveys & Tutorials, 2012, 14(3): 897-910 https://www.researchgate.net/publication/224256688_A_Survey_of_Reference_Structure_for_Sensor_Systems [15] Wimalajeewa T, Chen H, Varshney P K. Performance limits of compressive sensing-based signal classification. IEEE Transactions on Signal Processing, 2012, 60(6): 2758-2770 doi: 10.1109/TSP.2012.2189859 [16] Davenport M A, Boufounos P T, Wakin M B, Baraniuk R G. Signal processing with compressive measurements. IEEE Journal of Selected Topics in Signal Processing, 2010, 4(2): 445-460 doi: 10.1109/JSTSP.2009.2039178 [17] Luo X M, Liu T, Liu J, Guo X M, Wang G L. Design and implementation of a distributed fall detection system based on wireless sensor networks. EURASIP Journal on Wireless Communications and Networking, 2012, 2012(1): 118 doi: 10.1186/1687-1499-2012-118 [18] Sun Q Q, Hu F, Hao Q. Mobile target scenario recognition via low-cost pyroelectric sensing system: Toward a context-enhanced accurate identification. IEEE Transactions on Systems, Man, and Cybernetics: Systems, 2014, 44(3): 375-384 doi: 10.1109/TSMC.2013.2263130 [19] Guan Q J, Li C Y, Guo X M, Wang G L. Compressive classification of human motion using pyroelectric infrared sensors. Pattern Recognition Letters, 2014, 49: 231-237 doi: 10.1016/j.patrec.2014.07.018 [20] Kay S M. Fundamentals of Statistical Signal Processing: Detection Theory. Englewood Cliffs, NJ: Prentice-Hall, 1998. [21] Gales M J F. Maximum likelihood linear transformations for HMM-based speech recognition. Computer Speech & Language, 1998, 12(2): 75-98 http://citeseerx.ist.psu.edu/viewdoc/summary?doi=10.1.1.21.444 [22] Babu R V, Anantharaman B, Ramakrishnan K R, Srinivasan S H. Compressed domain action classification using HMM. Pattern Recognition Letters, 2002, 23(10): 1203-1213 doi: 10.1016/S0167-8655(02)00067-3 [23] Li H, Greenspan M. Model-based segmentation and recognition of dynamic gestures in continuous video streams. Pattern Recognition, 2011, 44(8): 1614-1628 doi: 10.1016/j.patcog.2010.12.014 -

下载:

下载: