-

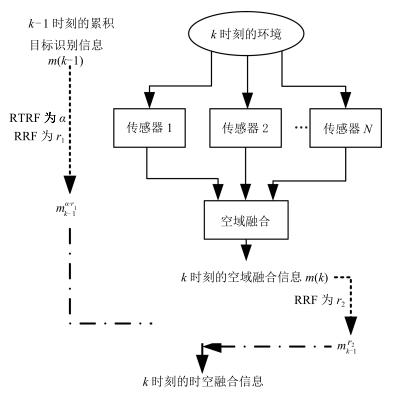

摘要: 证据理论已广泛应用于时空信息融合领域,由于时域信息融合表现出明显的序贯性和动态性,为实现基于证据理论的时域信息融合,有效处理时域冲突信息,结合证据可靠性评估和证据折扣的思想,在直觉模糊框架内提出了一种基于复合可靠度的时域证据组合方法.首先定义一种基于可靠度的直觉模糊数排序方法,在此基础上提出一种基于直觉模糊多属性决策的证据可靠性评估方法;然后,基于此方法对时域信息序列中相邻时间节点的证据可靠性进行评估,得到时域证据的相对可靠性因子;最后,结合由时域证据可靠度衰减模型得到的实时可靠性因子,得到时域证据的复合可靠性因子,再基于证据折扣运算和Dempster证据组合规则提出一种基于复合可靠度的时域证据组合方法.数值算例和仿真表明,该方法具有较强的时间敏感性,充分体现了时域信息融合的动态性特点,可以较好地处理时域证据中的冲突信息,基于该方法构建的融合识别系统具有较强的抗干扰能力.Abstract: Evidence theory has been widely used in spatial and temporal information fusion. The sequential and dynamic characteristics of temporal fusion calls for a new combination rule of temporal evidence sources. In this paper, temporal evidence combination is analyzed in the framework of evidence reliability and evidence discounting. A method of temporal evidence combination is proposed based on the composite reliability factor of temporal evidence. A ranking method for intuitionistic fuzzy values is firstly presented, followed by the presentation of evidence reliability evaluation based on intuitionistic fuzzy multiple criteria decision making. Then the relative reliability factors of evidence sources in neighboring time nodes are evaluated. By combining the relative reliability factor and real-time reliability factor yielded by the credibility decay model, a composite reliability factor is obtained. Finally, according to evidence discounting and Dempster's combination rule, a method of temporal evidence combination based on the composite reliability factor is proposed. Numerical examples and simulation demonstrate that the proposed method is time sensitive, which can reflect the dynamic nature of temporal information fusion. Moreover, it is illustrated that this method can deal with conflict in temporal fusion well. The proposed temporal evidence combination rule can enhance the anti-interference performance of the target identification fusion system.

-

表 1 两种情况下TEC-CRF方法的融合结果

Table 1 The combination results obtained by TEC-CRF for two cases

$m_3$ RTRF ${m_{12}}$折扣后的BPA RRF CRF 最终融合结果 ${m_3}(\{{\theta_1}\})=0.5$ $m_{12}^{{\alpha_1}}(\{{\theta_1}\})=0.2815$ $m_{13}^{{\alpha_1}}(\{{\theta_1}\})=0.4930$ ${m_3}(\{{\theta_2}\})=0.3$ ${\alpha _1}=0.7408$ $m_{12}^{{\alpha_1}}(\{{\theta_2}\})=0.1630$ $r_1=1$ $c_1=0.7408$ $m_{13}^{{\alpha_1}}(\{{\theta_2}\})=0.2491$ ${m_3}(\{{\theta_3}\})=0.2$ ${\alpha _2} = 1$ $m_{12}^{{\alpha_1}}(\{{\theta_3}\})=0.1852$ $r_2=0.8785$ $c_2=0.8785$ $m_{13}^{{\alpha_1}}(\{{\theta_3}\})=0.1853$ ${m_3}(\Theta)=0$ $m_{12}^{{\alpha_1}}(\Theta)=0.4092$ $m_{13}^{{\alpha_1}}(\Theta)=0.0726$ ${m_3}(\{{\theta_1}\})=0.1$ $m_{12}^{{\alpha_1}}(\{{\theta_1}\})=0.2815$ $m_{13}^{{\alpha_1}}(\{{\theta_1}\})=0.2183$ ${m_3}(\{{\theta_2}\})=0.15$ ${\alpha _1}=0.7408$ $m_{12}^{{\alpha_1}}(\{{\theta_2}\})=0.1630$ $r_1=1 $ $c_1=0.7408$ $m_{13}^{{\alpha_1}}(\{{\theta_2}\})=0.3540$ ${m_3}(\{{\theta_3}\})=0.75$ ${\alpha _2} = 1$ $m_{12}^{{\alpha_1}}(\{{\theta_3}\})=0.1630$ $r_2=0.4806$ $c_2=0.4806$ $m_{13}^{{\alpha_1}}(\{{\theta_3}\})=0.1691$ ${m_3}(\Theta)=0$ $m_{12}^{{\alpha_1}}(\Theta)=0.4092$ $m_{13}^{{\alpha_1}}(\Theta)=0.2586$ 表 2 两种情况下Dempster方法的融合结果

Table 2 The combination results obtained by Dempster's rule for two cases

$m_3$ $t_{2}$时刻融合结果 $t_{3}$时刻融合结果 ${m_3}(\{{\theta_1}\})=0.5$ $m_{12}(\{{\theta_1}\})=0$ $m_{13}(\{{\theta_1}\})=0$ ${m_3}(\{{\theta_2}\})=0.3$ $m_{12}(\{{\theta_2}\})=0.57$ $m_{13}(\{{\theta_2}\})=0.67$ ${m_3}(\{{\theta_3}\})=0.2$ $m_{12}(\{{\theta_3}\})=0.43$ $m_{13}(\{{\theta_3}\})=0.33$ ${m_3}(\{{\theta_1}\})=0.1$ $m_{12}(\{{\theta_1}\})=0$ $m_{13}(\{{\theta_1}\})=0$ ${m_3}(\{{\theta_2}\})=0.15$ $m_{12}(\{{\theta_2}\})=0.57$ $m_{13}(\{{\theta_2}\})=0.87$ ${m_3}(\{{\theta_3}\})=0.75$ $m_{12}(\{{\theta_3}\})=0.43$ $m_{13}(\{{\theta_3}\})=0.13$ 表 3 两种情况下TEC-RTRF方法的融合结果

Table 3 The combination results obtained by TEC-RTRF for two cases

$m_3$ $t_{2}$时刻融合结果 $t_{3}$时刻融合结果 ${m_3}(\{{\theta_1}\})=0.5$ $m_{12}(\{{\theta_1}\})=0$ $m_{13}(\{{\theta_1}\})=0.35$ ${m_3}(\{{\theta_2}\})=0.3$ $m_{12}(\{{\theta_2}\})=0.71$ $m_{13}(\{{\theta_2}\})=0.44$ ${m_3}(\{{\theta_3}\})=0.2$ $m_{12}(\{{\theta_3}\})=0.29$ $m_{13}(\{{\theta_3}\})=0.21$ ${m_3}(\{{\theta_1}\})=0.1$ $m_{12}(\{{\theta_1}\})=0$ $m_{13}(\{{\theta_1}\})=0.05$ ${m_3}(\{{\theta_2}\})=0.15$ $m_{12}(\{{\theta_2}\})=0.71$ $m_{13}(\{{\theta_2}\})=0.83$ ${m_3}(\{{\theta_3}\})=0.75$ $m_{12}(\{{\theta_3}\})=0.29$ $m_{13}(\{{\theta_3}\})=0.12$ 表 4 各传感器在不同时间节点的识别结果

Table 4 Recognition results of each sensor at all time nodes

时间节点(s) BPM $S_{1}$ $S_{2}$ $S_{3}$ $S_{4}$ $S_{5}$ $S_{6}$ $m(\{{\theta_1}\})$ 0.250 0.300 0.211 0.333 0.629 0.305 $t_{1}=5$ $m(\{{\theta_2}\})$ 0.299 0.256 0.350 0.273 0.352 0.212 $m(\{{\theta_3}\})$ 0.451 0.444 0.429 0.394 0.019 0.483 $m(\{{\theta_1}\})$ 0.440 0.628 0.435 0.348 0.642 0.530 $t_{2}=8$ $m(\{{\theta_2}\})$ 0.323 0.136 0.325 0.262 0.252 0.118 $m(\{{\theta_3}\})$ 0.237 0.236 0.240 0.390 0.106 0.352 $m(\{{\theta_1}\})$ 0.251 0.454 0.269 0.460 0.623 0.124 $t_{3}=16$ $m(\{{\theta_2}\})$ 0.276 0.236 0.336 0.215 0.142 0.420 $m(\{{\theta_3}\})$ 0.473 0.310 0.395 0.325 0.235 0.456 $m(\{{\theta_1}\})$ 0.337 0.318 0.262 0.246 0.435 0.312 $t_{4}=23$ $m(\{{\theta_2}\})$ 0.303 0.269 0.203 0.262 0.259 0.342 $m(\{{\theta_3}\})$ 0.360 0.413 0.535 0.492 0.306 0.346 $m(\{{\theta_1}\})$ 0.336 0.346 0.241 0.368 0.330 0.303 $t_{5}=26$ $m(\{{\theta_2}\})$ 0.312 0.305 0.258 0.262 0.301 0.391 $m(\{{\theta_3}\})$ 0.352 0.349 0.501 0.370 0.369 0.306 表 5 运用Dempster组合规则获得的空域融合结果

Table 5 Spatial evidence combination results obtained by Dempster's rule

时间节点(s) $m({\theta _1})$ $m({\theta _2})$ $m({\theta _3})$ $t_{1}=5$ 0.5529 0.2850 0.1621 $t_{2}=8$ 0.9489 0.0077 0.0134 $t_{3}=16$ 0.3216 0.0829 0.5955 $t_{4}=23$ 0.1715 0.0703 0.7582 $t_{5}=26$ 0.2365 0.1737 0.5898 表 6 运用EC-CF方法获得的空域融合结果

Table 6 Spatial evidence combination results obtained by EC-CF

时间节点(s) $m({\theta _1})$ $m({\theta _2})$ $m({\theta _3})$ $t_{1}=5$ 0.2322 0.1299 0.6379 $t_{2}=8$ 0.9509 0.0189 0.0302 $t_{3}=16$ 0.4425 0.0993 0.5482 $t_{4}=23$ 0.1951 0.0920 0.7129 $t_{5}=26$ 0.2546 0.1956 0.5498 表 7 运用Dempster组合规则获得的时域累积融合结果

Table 7 Spatial evidence combination results obtained by Dempster's rule

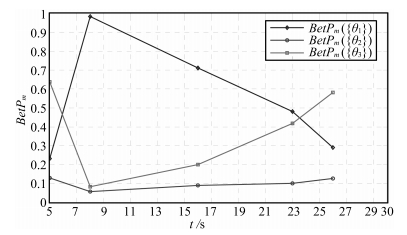

时间节点(s) $m({\theta _1})$ $m({\theta _2})$ $m({\theta _3})$ $t_{1}=5$ 0.2322 0.1299 0.6379 $t_{2}=8$ 0.9105 0.0101 0.0794 $t_{3}=16$ 0.9151 0.0023 0.0827 $t_{4}=23$ 0.7512 0.0009 0.2480 $t_{5}=26$ 0.5835 0.0005 0.4160 表 8 运用TEC-CRF方法获得的时域累积融合结果

Table 8 Temporal evidence accumulation results obtained by TEC-CRF

时间节点(s) $m({\theta _1})$ $m({\theta _2})$ $m({\theta _3})$ $m(\Theta)$ $t_{1}=5$ 0.2322 0.1299 0.6379 0 $t_{2}=8$ 0.9414 0.0168 0.0418 0.1247 $t_{3}=16$ 0.6570 0.0360 0.1466 0.1633 $t_{4}=23$ 0.4241 0.0445 0.3610 0.1704 $t_{5}=26$ 0.2903 0.1275 0.5823 0 表 9 各传感器在$t_{1}$和$t_{2}$时刻的识别结果

Table 9 Recognition results of each sensor at $t_{1}$ and $t_{2}$

时间节点(s) BPM $S_{1}$ $S_{2}$ $S_{3}$ $S_{4}$ $S_{5}$ $S_{6}$ $m(\{{\theta_1}\})$ 0.440 0.628 0.435 0.348 0.642 0.530 $t_{1}=5$ $m(\{{\theta_2}\})$ 0.323 0.136 0.325 0.262 0.252 0.118 $m(\{{\theta_3}\})$ 0.237 0.236 0.240 0.390 0.106 0.352 $m(\{{\theta_1}\})$ 0.250 0.300 0.211 0.333 0.629 0.305 $t_{2}=8$ $m(\{{\theta_2}\})$ 0.299 0.256 0.350 0.273 0.352 0.212 $m(\{{\theta_3}\})$ 0.451 0.444 0.429 0.394 0.019 0.483 表 10 基于Dempster方法的空域融合结果

Table 10 Spatial evidence combination results based on Dempster's rule

时间节点(s) $m({\theta _1})$ $m({\theta _2})$ $m({\theta _3})$ $t_{1}=5$ 0.9789 0.0077 0.0134 $t_{2}=8$ 0.5529 0.2850 0.1621 $t_{3}=16$ 0.3216 0.0829 0.5955 $t_{4}=23$ 0.1715 0.0703 0.7582 $t_{5}=26$ 0.2365 0.1737 0.5898 表 11 基于EC-CF方法的空域融合结果

Table 11 Spatial evidence combination results based on EC-CF

时间节点(s) $m({\theta _1})$ $m({\theta _2})$ $m({\theta _3})$ $t_{1}=5$ 0.9509 0.0189 0.0302 $t_{2}=8$ 0.2322 0.1299 0.6379 $t_{3}=16$ 0.4425 0.0993 0.5482 $t_{4}=23$ 0.1951 0.0920 0.7129 $t_{5}=26$ 0.2546 0.1956 0.5498 表 12 基于Dempster方法的时域累积融合结果

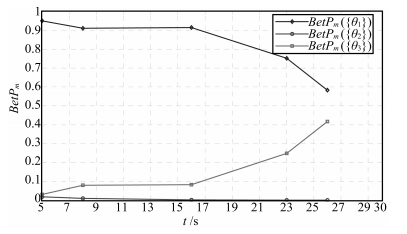

Table 12 Temporal evidence combination results based on Dempster's rule

时间节点(s) $m({\theta _1})$ $m({\theta _2})$ $m({\theta _3})$ $t_{1}=5$ 0.9509 0.0189 0.0302 $t_{2}=8$ 0.9105 0.0101 0.0794 $t_{3}=16$ 0.9151 0.0023 0.0827 $t_{4}=23$ 0.7512 0.0009 0.2480 $t_{5}=26$ 0.5835 0.0005 0.4160 表 13 基于TEC-CRF方法的时域累积融合结果

Table 13 Temporal evidence accumulation results based on TEC-CRF

时间节点(s) $m({\theta _1})$ $m({\theta _2})$ $m({\theta _3})$ $m(\Theta)$ $t_{1}=5$ 0.9509 0.0189 0.0302 0 $t_{2}=8$ 0.5427 0.0751 0.3822 0 $t_{3}=16$ 0.4300 0.0558 0.3441 0.1701 $t_{4}=23$ 0.2854 0.0510 0.4868 0.1768 $t_{5}=26$ 0.2321 0.1158 0.6521 0 -

[1] Dempster A P. Upper and lower probabilities induced by a multivalued mapping. The Annals of Mathematical Statistics, 1967, 38(2): 325-339 doi: 10.1214/aoms/1177698950 [2] Shafer G. A Mathematical Theory of Evidence. Princeton, NJ: Princeton University Press, 1976. [3] 潘泉, 于昕, 程咏梅, 张洪才. 信息融合理论的基本方法与进展. 自动化学报, 2003, 29(4): 599-615 http://www.aas.net.cn/CN/abstract/abstract13929.shtmlPan Quan, Yu Xin, Cheng Yong-Mei, Zhang Hong-Cai. Essential methods and progress of information fusion theory. Acta Automatica Sinica, 2003, 29(4): 599-615 http://www.aas.net.cn/CN/abstract/abstract13929.shtml [4] Zadeh L A. A simple view of the Dempster-Shafer theory of evidence and its implication for the rule of combination. The AI Magazine, 1986, 7(2): 85-90 http://cn.bing.com/academic/profile?id=2292561230&encoded=0&v=paper_preview&mkt=zh-cn [5] 杨艺, 韩德强, 韩崇昭. 基于多准则排序融合的证据组合方法. 自动化学报, 2012, 38(5): 823-831 doi: 10.3724/SP.J.1004.2012.00823Yang Yi, Han De-Qiang, Han Chong-Zhao. Evidence combination based on multi-criteria rank-level fusion. Acta Automatica Sinica, 2012, 38(5): 823-831 doi: 10.3724/SP.J.1004.2012.00823 [6] 周哲, 徐晓滨, 文成林, 吕锋. 冲突证据融合的优化方法. 自动化学报, 2012, 38(6): 976-985 doi: 10.3724/SP.J.1004.2012.00976Zhou Zhe, Xu Xiao-Bin, Wen Cheng-Lin, Lv Feng. An optimal method for combining conflicting evidences. Acta Automatica Sinica, 2012, 38(6): 976-985 doi: 10.3724/SP.J.1004.2012.00976 [7] 邓勇, 施文康. 一种改进的证据推理组合规则. 上海交通大学学报, 2003, 37(8): 1275-1278 http://www.cnki.com.cn/Article/CJFDTOTAL-SHJT200308031.htmDeng Yong, Shi Wen-Kang. A modified combination rule of evidence theory. Journal of Shanghai Jiaotong University, 2003, 37(8): 1275-1278 http://www.cnki.com.cn/Article/CJFDTOTAL-SHJT200308031.htm [8] Murphy C K. Combining belief functions when evidence conflicts. Decision Support Systems, 2000, 29(1): 1-9 doi: 10.1016/S0167-9236(99)00084-6 [9] Deng Y, Shi W K, Zhu Z F, Liu Q. Combining belief functions based on distance of evidence. Decision Support Systems, 2004, 38(3): 489-493 doi: 10.1016/j.dss.2004.04.015 [10] 韩德强, 韩崇昭, 邓勇, 杨艺. 基于证据方差的加权证据组合. 电子学报, 2011, 39(3A): 153-157 http://www.cnki.com.cn/Article/CJFDTOTAL-DZXU2011S1028.htmHan De-Qiang, Han Chong-Zhao, Deng Yong, Yang Yi. Weighted combination of conflicting evidence based on evidence variance. Acta Electronica Sinica, 2011, 39(3A): 153-157 http://www.cnki.com.cn/Article/CJFDTOTAL-DZXU2011S1028.htm [11] Hong L, Lynch A. Recursive temporal-spatial information fusion with applications to target identification. IEEE Transactions on Aerospace and Electronic Systems, 1993, 29(2): 435-445 doi: 10.1109/7.210081 [12] 洪昭艺, 高勋章, 黎湘. 基于DS理论的混合式时空域信息融合模型. 信号处理, 2011, 27(1): 14-19 http://www.cnki.com.cn/Article/CJFDTOTAL-XXCN201101005.htmHong Zhao-Yi, Gao Xun-Zhang, Li Xiang. Research on temporal-spatial information fusion model based on DS theory. Signal Processing, 2011, 27(1): 14-19 http://www.cnki.com.cn/Article/CJFDTOTAL-XXCN201101005.htm [13] 刘永祥, 朱玉鹏, 黎湘, 庄钊文. 导弹防御系统中的目标综合识别模型. 电子与信息学报, 2006, 28(4): 638-642 http://www.cnki.com.cn/Article/CJFDTOTAL-DZYX200604014.htmLiu Yong-Xiang, Zhu Yu-Peng, Li Xiang, Zhuang Zhao-Wen. Integrated target discrimination model in missile defense system. Journal of Electronics and Information Technology, 2006, 28(4): 638-642 http://www.cnki.com.cn/Article/CJFDTOTAL-DZYX200604014.htm [14] 吴俊, 程咏梅, 曲圣杰, 潘泉, 刘准钆. 基于三级信息融合结构的多平台多雷达目标识别算法. 西北工业大学学报, 2012, 30(3): 367-372 http://www.cnki.com.cn/Article/CJFDTOTAL-XBGD201203014.htmWu Jun, Cheng Yong-Mei, Qu Sheng-Jie, Pan Quan, Liu Zhun-Ga. An effective multi-platform multi-radar target identification algorithm based on three level fusion hierarchical structure. Journal of Northwestern Polytechnical University, 2012, 30(3): 367-372 http://www.cnki.com.cn/Article/CJFDTOTAL-XBGD201203014.htm [15] Daniel M. Probabilistic transformations of belief functions. Symbolic and Quantitative Approaches to Reasoning with Uncertainty. Berlin Heidelberg: Springer, 2005. 539-551 [16] Smets P, Kennes R. The transferable belief model. Artificial Intelligence, 1994, 66(2): 191-234 doi: 10.1016/0004-3702(94)90026-4 [17] Zadeh L A. Fuzzy sets. Information and Control, 1965, 8(3): 338-353 doi: 10.1016/S0019-9958(65)90241-X [18] Atanassov K T. Intuitionistic furzy sets. Fuzzy Sets and Systems, 1986, 20(1): 87-96 doi: 10.1016/S0165-0114(86)80034-3 [19] Bustince H, Burillo P. Vague sets are intuitionistic fuzzy sets. Fuzzy Sets and Systems, 1996, 79(3): 403-405 doi: 10.1016/0165-0114(95)00154-9 [20] Hong D H, Kim C. A note on similarity measures between vague sets and between elements. Information Sciences, 1999, 115(1-4): 83-96 doi: 10.1016/S0020-0255(98)10083-X [21] Li J P, Yang Q B, Yang B. Dempster-Shafer theory is a special case of Vague sets theory. In: Proceedings of the 2004 International Conference on Information Acquisition. Hefei, China: IEEE, 2004. 50-53 [22] Dymova L, Sevastjanov P. An interpretation of intuitionistic fuzzy sets in terms of evidence theory: decision making aspect. Knowledge-Based Systems, 2010, 23(8): 772-782 doi: 10.1016/j.knosys.2010.04.014 [23] Dymova L, Sevastjanov P. The operations on intuitionistic fuzzy values in the framework of Dempster-Shafer theory. Knowledge-Based Systems, 2012, 35: 132-143 doi: 10.1016/j.knosys.2012.04.026 [24] Yager R R. An intuitionistic view of the Dempster-Shafer belief structure. Soft Computing, 2014, 18(11): 2091-2099 doi: 10.1007/s00500-014-1320-y [25] 邢清华, 刘付显. 直觉模糊集隶属度与非隶属度函数的确定方法. 控制与决策, 2009, 24(3): 393-397 http://www.cnki.com.cn/Article/CJFDTOTAL-KZYC200903014.htmXing Qing-Hua, Liu Fu-Xian. Method of determining membership and nonmembership function in intuitionistic fuzzy sets. Control and Decision, 2009, 24(3): 393-397 http://www.cnki.com.cn/Article/CJFDTOTAL-KZYC200903014.htm [26] Guo H, Shi W, Deng Y. Evaluating sensor reliability in classification problems based on evidence theory. IEEE Transactions on Systems, Man, and Cybernetics——Part B: Cybernetics, 2006, 36(5): 970-981 doi: 10.1109/TSMCB.2006.872269 [27] Elouedi Z, Mellouli K, Smets P. Assessing sensor reliability for multisensor data fusion within the transferable belief model. IEEE Transactions on Systems, Man, and Cybernetics——Part B: Cybernetics, 2004, 34(1): 782-787 doi: 10.1109/TSMCB.2003.817056 [28] 杨威, 贾宇平, 付耀文. 传感器可靠性相异的信任函数理论融合识别算法研究. 信号处理, 2009, 25(11): 1766-1770 http://www.cnki.com.cn/Article/CJFDTOTAL-XXCN200911020.htmYang Wei, Jia Yu-Ping, Fu Yao-Wen. Research on fusion recognition algorithm for different reliable sensors based on the belief function theory. Signal Processing, 2009, 25(11): 1766-1770 http://www.cnki.com.cn/Article/CJFDTOTAL-XXCN200911020.htm [29] 付耀文, 贾宇平, 杨威, 庄钊文. 传感器动态可靠性评估与证据折扣. 系统工程与电子技术, 2012, 34(1): 212-216 http://www.cnki.com.cn/Article/CJFDTOTAL-XTYD201201038.htmFu Yao-Wen, Jia Yu-Ping, Yang Wei, Zhuang Zhao-Wen. Sensor dynamic reliability evaluation and evidence discount. Systems Engineering and Electronics, 2012, 34(1): 212-216 http://www.cnki.com.cn/Article/CJFDTOTAL-XTYD201201038.htm [30] Nakahara Y. User oriented ranking criteria and its application to fuzzy mathematical programming problems. Fuzzy Sets and Systems, 1998, 94(3): 275-286 doi: 10.1016/S0165-0114(96)00262-X [31] Song Y F, Wang X D, Lei L, Xing Y Q. Credibility decay model in temporal evidence combination. Information Processing Letters, 2015, 115(2): 248-252 doi: 10.1016/j.ipl.2014.09.022 [32] 宋亚飞, 王晓丹, 雷蕾, 薛爱军. 基于信任度和虚假度的证据组合方法. 通信学报, 2015, 36(5): 2015104-1-2015104-6 http://www.cnki.com.cn/Article/CJFDTOTAL-TXXB201505012.htmSong Ya-Fei, Wang Xiao-Dan, Lei Lei, Xue Ai-Jun. Evidence combination based on the degree of credibility and falsity. Journal on Communications, 2015, 36(5): 2015104-1-2015104-6 http://www.cnki.com.cn/Article/CJFDTOTAL-TXXB201505012.htm -

下载:

下载: