-

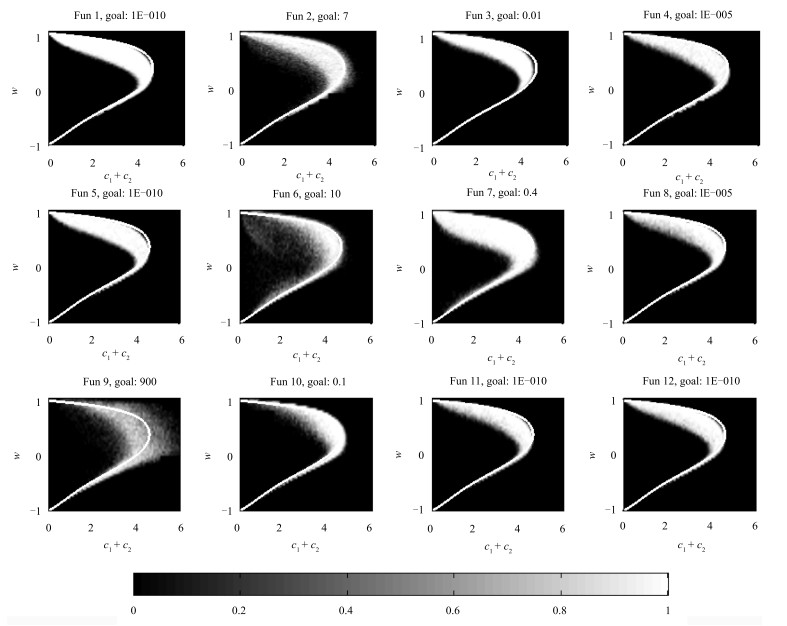

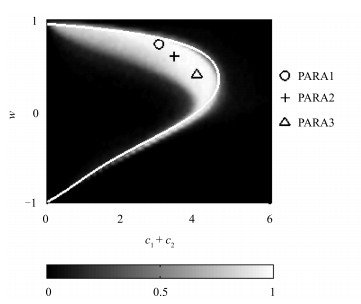

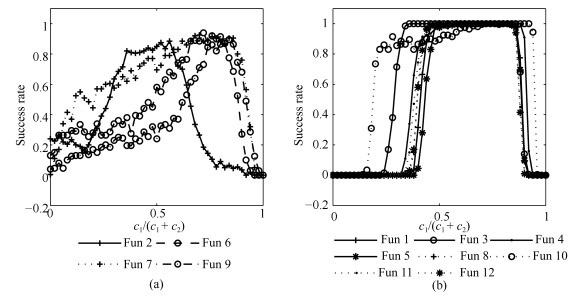

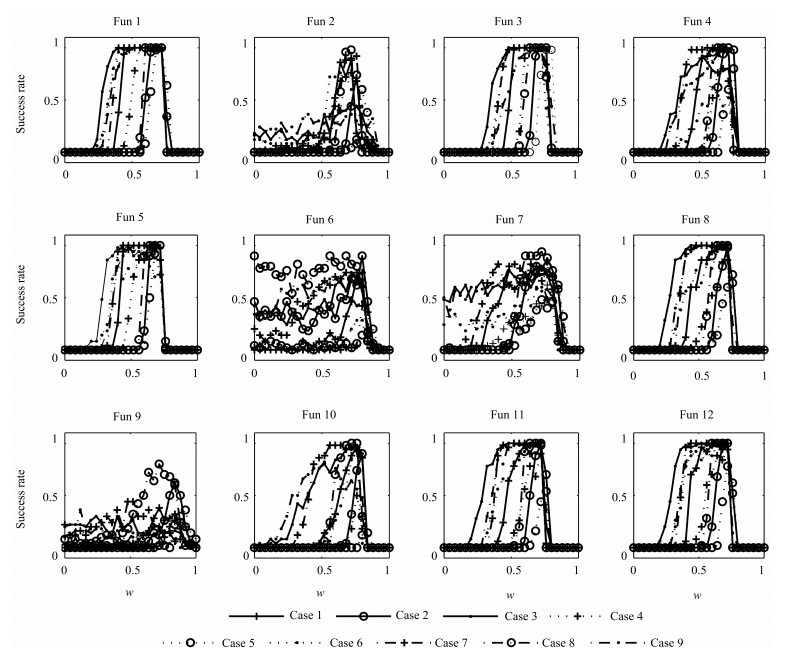

摘要: 惯性权重和加速因子是影响粒子群算法优化性能的重要参数.基于常用的12个测试函数,本文通过实验研究了不同参数组合下粒子的探索能力和算法的优化性能,在此基础上推荐了一组固定的参数组合.通过惯性权重和加速因子的不同变化策略组合对算法性能影响的实验分析,推荐了一种变化的参数设置方法.基于CEC2015发布的15个基准函数进一步验证了本文推荐的参数选取方法的有效性.最后讨论了粒子群优化(Particle swarm optimization,PSO)算法在连续优化和离散优化方面的应用问题.Abstract: Inertia weight and acceleration factors have significant impact on the performance of particle swarm optimization (PSO) algorithm. Through simulation experiments on twelve classical benchmark functions, this paper studies the algorithm's exploitation ability and optimization performance with different parameters. Based on the experimental results, we recommend a setting for fixed parameters. Furthermore, we study the situation where inertia weight remains unchanged and acceleration factors change with iterations. Then a setting for varying parameters is recommended. The recommended parameters setting methods are verified through 15 benchmark functions that were published in CEC2015. At the end of the paper, a discussion of the PSO application issue on continuous optimization problems and discrete optimization problems is given.

-

表 1 5组参数的运行结果对比

Table 1 Comparison of running results on 5 parameters

函数 PARA min max mean±std SR Fun 1 1 1.47E-25 8.64E-22 6.32E-23±1.34E-22 1.00 2 9.05E-36 5.64E-31 1.73E-32±7.16E-32 1.00 3 1.98E-40 2.94E-34 1.31E-35±4.50E-35 1.00 4 1.81E-57 2.84E-33 2.86E-35±2.84E-34 1.00 5 1.63E-27 1.45E-23 2.71E-25±1.46E-24 1.00 Fun 2 1 2.72E-02 7.29E+00 2.40E+00±1.43E+00 0.84 2 3.18E-03 1.20E+02 3.75E+00±1.19E+01 0.76 3 1.20E-03 8.27E+00 3.45E+00±1.96E+00 0.30 4 6.03E-02 8.96E+00 4.30E+00±1.57E+00 0.07 5 2.21E-02 8.45E+00 3.45E+00±1.40E+00 0.31 Fun 3 1 6.55E-10 8.21E-08 1.38E-08±1.58E-08 1.00 2 5.68E-14 1.07E-10 9.80E-12±1.70E-11 1.00 3 2.98E-11 7.36E-09 8.82E-10±1.32E-09 1.00 4 7.06E-12 4.01E-04 6.10E-06±4.09E-05 0.94 5 1.23E-10 1.02E-08 1.63E-09±1.77E-09 1.00 Fun 4 1 1.06E-14 1.00E+01 5.00E-01±2.19E+00 0.95 2 7.73E-20 1.00E+01 1.00E-01±1.00E+00 0.99 3 7.38E-23 7.89E-20 9.10E-21±1.60E-20 1.00 4 8.37E-20 1.00E+01 1.00E-01±1.00E+00 0.98 5 1.64E-15 1.12E-13 1.82E-14±1.87E-14 1.00 Fun 5 1 1.14E-25 1.00E+04 2.00E+02±1.40E+03 0.00 2 6.54E-35 1.82E-29 2.24E-31±1.82E-30 1.00 3 1.74E-39 2.36E-33 1.04E-34±3.60E-34 1.00 4 2.45E-54 6.74E-34 6.74E-36±6.74E-35 1.00 5 1.44E-26 7.31E-24 5.72E-25±9.94E-25 0.32 Fun 6 1 9.91E-13 1.39E+01 5.73E+00±3.06E+00 0.55 2 9.94E-01 1.59E+01 6.61E+00±3.23E+00 0.43 3 0.00E+00 1.39E+01 4.87E+00±2.94E+00 0.68 4 9.94E-01 4.47E+01 9.87E+00±7.05E+00 0.23 5 1.66E-13 7.95E+00 3.29E+00±1.84E+00 0.85 Fun 7 1 1.47E-02 1.64E-01 7.49E-02±3.35E-02 0.83 2 7.39E-03 1.84E-01 7.77E-02±3.52E-02 0.77 3 1.47E-02 2.21E-01 7.94E-02±4.10E-02 0.74 4 1.72E-02 3.05E-01 1.12E-01±5.99E-02 0.53 5 1.11E-15 1.69E-01 6.15E-02±3.39E-02 0.86 Fun 8 1 2.38E-13 1.99E+01 1.99E-01±1.99E+00 0.99 2 3.55E-15 7.10E-15 3.94E-15±1.11E-15 1.00 3 3.55E-15 7.10E-15 3.97E-15±1.16E-15 1.00 4 3.55E-15 1.15E+00 1.15E-02±1.15E-01 0.97 5 1.42E-14 6.18E-13 1.51E-13±1.19E-13 1.00 Fun 9 1 0.00E+00 1.30E+03 6.41E+02±2.28E+02 0.35 2 0.00E+00 1.42E+03 6.83E+02±2.86E+02 0.30 3 1.18E+02 1.54E+03 6.41E+02±3.04E+02 0.44 4 1.18E+00 1.19E+03 6.40E+02±2.51E+02 0.36 5 0.00E+00 9.49E+02 4.48E+02±1.86E+02 0.67 Fun 10 1 3.55E-10 1.57E+00 1.46E-01±4.41E-01 0.86 2 0.00E+00 3.07E+00 1.69E-01±5.28E-01 0.86 3 0.00E+00 1.50E+00 6.00E-02±2.96E-01 0.96 4 1.81E-13 3.00E+00 1.40E-01±4.50E-01 0.46 5 0.00E+00 3.46E-02 3.46E-04±3.46E-03 0.99 Fun 11 1 5.76E-27 5.30E-21 5.90E-23±5.30E-22 1.00 2 4.71E-32 1.90E-31 4.94E-32±1.53E-32 1.00 3 4.71E-32 3.11E-01 1.55E-02±6.81E-02 0.95 4 4.71E-32 3.11E-01 1.24E-02±6.12E-02 0.95 5 5.16E-29 3.55E-24 5.37E-26±2.57E-25 1.00 Fun 12 1 6.86E-27 6.65E-22 2.13E-23±7.32E-23 1.00 2 1.34E-32 4.65E-31 2.13E-32±4.68E-32 1.00 3 1.34E-32 2.72E-26 5.45E-28±3.85E-27 1.00 4 1.34E-32 4.23E-13 4.23E-15±4.26E-14 0.99 5 2.78E-28 1.93E-23 2.82E-25±1.93E-24 1.00 表 2 本文与文献[17]参数设置的优化结果比较

Table 2 Comparison of optimization results between the parameters set in this paper and [17]

函数M Method min max mean±std SR Fun 1 Ours

[17]3.91E-33 1.42E-29 1.20E-30±2.51E-30 1.00 5.01E-33 6.95E-29 3.09E-30±9.83E-30 1.00 Fun 2 Ours

[17]9.79E-02 2.26E+00 1.30E+00±5.31E-01 1.00 1.00E+00 5.72E+00 2.40E+00±7.33E-01 0.84 Fun 3 Ours

[17]5.90E-13 2.27E-10 2.13E-11±3.88E-11 1.00 6.03E-13 2.48E-10 2.99E-11±4.90E-11 1.00 Fun 4 Ours

[17]5.58E-18 7.20E-16 1.60E-16±1.52E-16 1.00 8.12E-18 2.87E-13 6.86E-15±4.09E-14 1.00 Fun 5 Ours

[17]7.24E-32 3.86E-28 1.60E-29±5.49E-29 1.00 2.12E-32 3.44E-28 1.65E-29±5.70E-29 1.00 Fun 6 Ours

[17]9.94E-01 7.95E+00 3.34E+00±1.55E+00 0.92 1.98E+00 1.09E+01 5.49E+00±2.36E+00 0.54 Fun 7 Ours

[17]0.00E+00 1.42E-01 5.20E-02±2.94E-02 0.96 0.00E+00 1.84E-01 7.81E-02±3.58E-02 0.76 Fun 8 Ours

[17]3.55E-15 7.10E-15 4.68E-15±1.67E-15 1.00 3.55E-15 2.13E-14 7.81E-15±3.58E-15 1.00 Fun 9 Ours

[17]1.18E+02 1.04E+03 4.71E+02±1.99E+02 0.64 1.18E+02 1.19E+03 5.48E+02±2.16E+02 0.42 Fun 10 Ours

[17]0.00E+00 1.44E-02 6.04E-04±2.51E-03 0.94 0.00E+00 1.15E-01 3.03E-03±1.64E-02 0.84 Fun 11 Ours

[17]4.71E-32 2.90E-27 9.03E-29±4.35E-28 1.00 4.71E-32 1.34E-28 3.09E-30±1.90E-29 1.00 Fun 12 Ours

[17]1.34E-32 6.16E-29 3.88E-30±9.45E-30 1.00 1.34E-32 1.09E-02 2.19E-04±1.55E-03 0.98 表 3 本文给出的固定参数推荐值在CEC2015基准函数F1~F15上的运行结果

Table 3 Running results on CEC2015 Benchmark functions F1~F15 with fixed parameters

表 4 本文给出的时变参数设置方式在CEC2015基准函数F1~F15上的运行结果

Table 4 Running results on CEC2015 Benchmark functions F1~F15 with time-varying parameters

Method F1 F2 F3 F4 F5 F6 F7 F8 F9 F10 F11 F12 F13 F14 F15 Ours 0.70 0.26 0.30 0.94 1.00 0.64 1.00 0.50 1.00 0.95 1.00 1.00 0.25 0.40 0.96 [17] 0.16 0.14 0.01 0.82 0.85 0.25 1.00 0.22 1.00 0.85 1.00 1.00 0.20 0.40 0.90 -

[1] Kennedy J, Eberhart R. Particle swarm optimization. In:Proceedings of the 1995 IEEE International Conference on Neural Networks. Perth, Australia:IEEE, 1995. 1942-1948 http://www.oalib.com/references/17617167 [2] Shi Y, Eberhart R. A modified particle swarm optimizer. In:Proceedings of the 1998 IEEE International Conference on Evolutionary Computation. Anchorage, AK, USA:IEEE, 1998. 69-73 [3] 张勇, 巩敦卫, 张婉秋.一种基于单纯形法的改进微粒群优化算法及其收敛性分析.自动化学报, 2009, 35(3):289-298 doi: 10.3724/SP.J.1004.2009.00289Zhang Yong, Gong Dun-Wei, Zhang Wan-Qiu. A simplex method based improved particle swarm optimization and analysis on its global convergence. Acta Automatica Sinica, 2009, 35(3):289-298 doi: 10.3724/SP.J.1004.2009.00289 [4] 潘峰, 周倩, 李位星, 高琪.标准粒子群优化算法的马尔科夫链分析.自动化学报, 2013, 39(4):381-389 doi: 10.1016/S1874-1029(13)60037-3Pan Feng, Zhou Qian, Li Wei-Xing, Gao Qi. Analysis of standard particle swarm optimization algorithm based on Markov chain. Acta Automatica Sinica, 2013, 39(4):381-389 doi: 10.1016/S1874-1029(13)60037-3 [5] 刘朝华, 周少武, 刘侃, 章兢.基于双模态自适应小波粒子群的永磁同步电机多参数识别与温度监测方法.自动化学报, 2013, 39(12):2121-2130 http://www.aas.net.cn/CN/article/downloadArticleFile.do?attachType=PDF&id=18241Liu Zhao-Hua, Zhou Shao-Wu, Liu Kan, Zhang Jing. Permanent magnet synchronous motor multiple parameter identification and temperature monitoring based on binary-modal adaptive wavelet particle swarm optimization. Acta Automatica Sinica, 2013, 39(12):2121-2130 http://www.aas.net.cn/CN/article/downloadArticleFile.do?attachType=PDF&id=18241 [6] Eberhart R C, Shi Y. Comparing inertia weights and constriction factors in particle swarm optimization. In:Proceedings of the 2000 Congress on Evolutionary Computation. La Jolla, CA:IEEE, 2000. 84-88 [7] Trelea I C. The particle swarm optimization algorithm:convergence analysis and parameter selection. Information Processing Letters, 2003, 85(6):317-325 doi: 10.1016/S0020-0190(02)00447-7 [8] Samal N R, Konar A, Das S, Abraham A. A closed loop stability analysis and parameter selection of the particle swarm optimization dynamics for faster convergence. In:Proceedings of the 2007 IEEE Congress on Evolutionary Computation. Singapore:IEEE, 2007. 1769-1776 http://www.academia.edu/2724938/A_closed_loop_stability_analysis_and_parameter_selection_of_the_particle_swarm_optimization_dynamics_for_faster_convergence [9] Carlisle A, Dozier G. An off-the-shelf PSO. In:Proceedings of the 2001 Workshop on Particle Swarm Optimization. Indianapolis, USA, 2001. 1-6 [10] 胡建秀, 曾建潮.微粒群算法中惯性权重的调整策略.计算机工程, 2007, 33(11):193-195 http://www.cnki.com.cn/Article/CJFDTOTAL-JSJC200711069.htmHu Jian-Xiu, Zeng Jian-Chao. Selection on inertia weight of particle swarm optimization. Computer Engineering, 2007, 33(11):193-195 http://www.cnki.com.cn/Article/CJFDTOTAL-JSJC200711069.htm [11] 延丽平, 曾建潮.具有自适应随机惯性权重的PSO算法.计算机工程与设计, 2006, 27(24):4677-4679, 4706 http://www.cnki.com.cn/Article/CJFDTOTAL-SJSJ200624020.htmYan Li-Ping, Zeng Jian-Chao. Particle swarm optimization with self-adaptive stochastic inertia weight. Computer Engineering and Design, 2006, 27(24):4677-4679, 4706 http://www.cnki.com.cn/Article/CJFDTOTAL-SJSJ200624020.htm [12] Chalermchaiarbha S, Ongsakul W. Stochastic weight trade-off particle swarm optimization for nonconvex economic dispatch. Energy Conversion and Management, 2013, 70:66-75 doi: 10.1016/j.enconman.2013.02.009 [13] 敖永才, 师奕兵, 张伟, 李焱骏.自适应惯性权重的改进粒子群算法.电子科技大学学报, 2014, 43(6):874-880 http://www.cnki.com.cn/Article/CJFDTOTAL-DKDX201406014.htmAo Yong-Cai, Shi Yi-Bing, Zhang Wei, Li Yan-Jun. Improved particle swarm optimization with adaptive inertia weight. Journal of University of Electronic Science and Technology of China, 2014, 43(6):874-880 http://www.cnki.com.cn/Article/CJFDTOTAL-DKDX201406014.htm [14] Zhan Z H, Zhang J, Li Y, Chung H S H. Adaptive particle swarm optimization. IEEE Transactions on Systems, Man, and Cybernetics, Part B (Cybernetics), 2009, 39(6):1362-1381 doi: 10.1109/TSMCB.2009.2015956 [15] Alfi A. PSO with adaptive mutation and inertia weight and its application in parameter estimation of dynamic systems. Acta Automatica Sinica, 2011, 37(5):541-549 doi: 10.1016/S1874-1029(11)60205-X [16] Suganthan P N. Particle swarm optimiser with neighbourhood operator. In:Proceedings of the 1999 Congress on Evolutionary Computation. Washington DC, USA:IEEE, 1999. 1958-1962 [17] Ratnaweera A, Halgamuge S K, Watson H C. Self-organizing hierarchical particle swarm optimizer with time-varying acceleration coefficients. IEEE Transactions on Evolutionary Computation, 2004, 8(3):240-255 doi: 10.1109/TEVC.2004.826071 [18] Yamaguchi T, Yasuda K. Adaptive particle swarm optimization:self-coordinating mechanism with updating information. In:Proceedings of the 2006 IEEE International Conference on Systems, Man, and Cybernetics. Taipei, China:IEEE, 2006. 2303-2308 [19] Liang J J, Qu B Y, Suganthan P N, Chen Q. Problem Definitions and Evaluation Criteria for the CEC 2015 Competition on Learning-based Real-parameter Single Objective Optimization. Technical Report 201411A, Computational Intelligence Laboratory, Zhengzhou University, Zhengzhou China, and Technical Report, Nanyang Technological University, Singapore, 2014. http://web.mysites.ntu.edu.sg/epnsugan/PublicSite/Shared%20Documents/CEC-2015/Learning-Based%20Single%20Objective%20Optimization/CEC%202015%20Learning_based.pdf [20] 崔志华, 曾建潮.微粒群优化算法.北京:科学出版社, 2011.Cui Zhi-Hua, Zeng Jian-Chao. Particle Swarm Optimization. Beijing:Science Press, 2011. [21] 王凌, 刘波.微粒群优化与调度算法.北京:清华大学出版社, 2008.Wang Ling, Liu Bo. Particle Swarm Optimization and Scheduling Algorithms. Beijing:Tsinghua University Press, 2008. [22] 郭文忠, 陈国龙.离散粒子群优化算法及其应用.北京:清华大学出版社, 2012.Guo Wen-Zhong, Chen Guo-Long. Discrete Particle Swarm Optimization Algorithm and Its Application. Beijing:Tsinghua University Press, 2012. -

下载:

下载: